【算法优化必学】:深度学习与传统机器学习性能提升的对比分析

发布时间: 2024-09-02 07:21:45 阅读量: 270 订阅数: 83

# 1. 深度学习与传统机器学习基础对比

深度学习和传统机器学习是当前数据科学领域最为活跃的研究方向。在本章中,我们将探讨两者的根本区别、应用场景以及各自的优势和局限性。

## 1.1 机器学习的发展与分类

机器学习是人工智能的一个分支,它使计算机能够从数据中学习并做出决策或预测。机器学习算法可以大致分为两类:传统机器学习和深度学习。

传统机器学习算法在处理小规模数据集时效果显著,它依赖于人工选择的特征提取方法。常见的传统算法包括线性回归、逻辑回归、支持向量机(SVM)、决策树和集成学习方法如随机森林和梯度提升树等。

相比之下,深度学习是通过构建具有多个隐藏层的人工神经网络来自动学习数据的高级特征,它在处理大规模和高维数据时展现出强大的能力。典型的深度学习模型包括前馈神经网络、卷积神经网络(CNN)和递归神经网络(RNN)等。

## 1.2 深度学习与传统机器学习的关键区别

从概念上讲,深度学习和传统机器学习的主要区别在于模型的复杂性和对数据的处理方式。深度学习能够自动提取数据的层次性特征,而传统机器学习则需要通过领域知识和统计方法来手动设计特征。这使得深度学习在处理复杂任务,例如图像识别、自然语言处理和语音识别方面,表现出更高的灵活性和准确性。

此外,深度学习模型通常需要大量数据和计算资源,而传统机器学习算法则更加轻量级。尽管如此,传统机器学习在某些情况下,如数据量有限或解释性要求较高的场合,仍然具有不可替代的优势。

在下一章中,我们将深入探讨深度学习的理论基础和优化技术,以及如何在实际应用中提升其性能。

# 2. 深度学习的理论基础与优化

### 2.1 深度学习的核心算法原理

#### 2.1.1 前馈神经网络与反向传播

前馈神经网络(Feedforward Neural Network, FFNN)是最简单的神经网络结构,其中的数据流是单向的,没有反馈(或循环)。它通常被用来进行分类和回归任务。

反向传播算法(Backpropagation)是用于训练人工神经网络中的一种算法。通过计算损失函数关于模型参数的梯度,反向传播算法能够有效地计算梯度,并用梯度下降算法来优化模型参数。

```python

import numpy as np

# 激活函数

def sigmoid(x):

return 1 / (1 + np.exp(-x))

# 激活函数的导数

def sigmoid_derivative(x):

return x * (1 - x)

# 输入数据

inputs = np.array([[0,0],

[0,1],

[1,0],

[1,1]])

# 实际输出

expected_output = np.array([[0],

[1],

[1],

[0]])

# 初始化权重

input_layer_size = 2

hidden_layer_size = 2

output_layer_size = 1

W1 = np.random.uniform(size=(input_layer_size, hidden_layer_size))

W2 = np.random.uniform(size=(hidden_layer_size, output_layer_size))

# 训练网络

for i in range(10000):

# 正向传播

input_layer = inputs

hidden_layer = sigmoid(np.dot(input_layer, W1))

output_layer = sigmoid(np.dot(hidden_layer, W2))

# 计算误差

output_error = expected_output - output_layer

# 反向传播

d_output_layer = output_error * sigmoid_derivative(output_layer)

hidden_error = d_output_layer.dot(W2.T)

d_hidden_layer = hidden_error * sigmoid_derivative(hidden_layer)

# 更新权重

W2 += hidden_layer.T.dot(d_output_layer)

W1 += input_layer.T.dot(d_hidden_layer)

```

在上述代码中,我们创建了一个简单的前馈神经网络,并执行了反向传播算法。每一层的权重通过梯度下降进行更新,逐步减小输出误差。

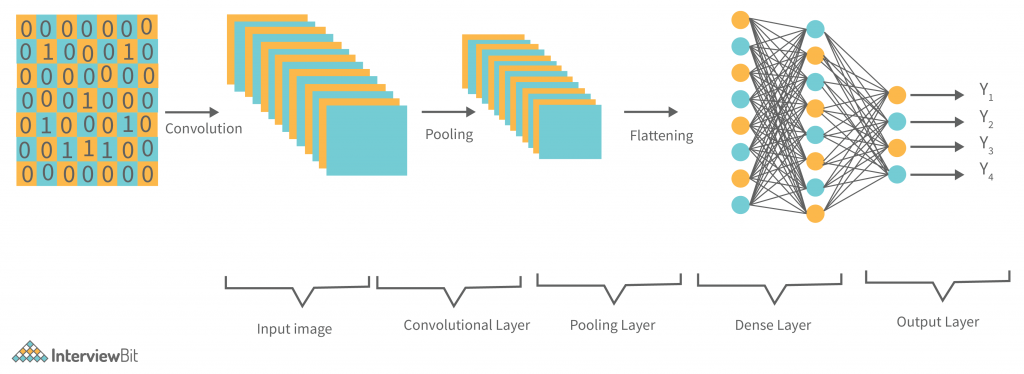

#### 2.1.2 卷积神经网络与图像处理

卷积神经网络(Convolutional Neural Networks, CNNs)特别适合图像处理任务,因为它们能够保留图像的空间层次结构。CNNs由卷积层、池化层和全连接层组成,能够自动地学习图像的特征。

```python

from keras.datasets import cifar10

from keras.utils import to_categorical

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

from keras.optimizers import Adam

# 加载数据集

(X_train, y_train), (X_test, y_test) = cifar10.load_data()

# 数据预处理

X_train = X_train.astype('float32')

X_test = X_test.astype('float32')

X_train = X_train / 255.0

X_test = X_test / 255.0

y_train = to_categorical(y_train, 10)

y_test = to_categorical(y_test, 10)

# 构建CNN模型

model = Sequential()

model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)))

model.add(MaxPooling2D((2, 2)))

model.add(Flatten())

model.add(Dense(64, activation='relu'))

model.add(Dense(10, activation='softmax'))

# 编译模型

***pile(optimizer=Adam(), loss='categorical_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(X_train, y_train, epochs=10, batch_size=64, validation_data=(X_test, y_test))

```

在这个代码示例中,我们用Keras框架构建了一个简单的CNN模型,并在CIFAR-10数据集上训练了它。模型由一个卷积层、一个池化层和两个全连接层组成。训练完成后,模型能够在测试数据上评估其准确率。

### 2.2 深度学习的性能优化技术

#### 2.2.1 激活函数的选择与优化

激活函数是神经网络中引入非线性的关键。选择合适的激活函数能够显著影响模型的性能。常见的激活函数包括Sigmoid、Tanh、ReLU及其变体。

```python

# 激活函数的对比

import matplotlib.pyplot as plt

x = np.linspace(-5, 5, 1000)

y1 = sigmoid(x)

y2 = np.tanh(x)

y3 = np.maximum(0, x) # ReLU

y4 = np.log1p(np.exp(x)) - np.log1p(np.exp(-x)) # Softplus

plt.figure(figsize=(12, 8))

plt.plot(x, y1, label='Sigmoid')

plt.plot(x, y2, label='Tanh')

plt.plot(x, y3, label='ReLU')

plt.plot(x, y4, label='Softplus')

plt.legend()

plt.show()

```

通过比较不同激活函数的图像,我们可以看出它们各自的特点。Sigmoid和Tanh函数在两端会饱和,可能会导致梯度消失问题。ReLU函数在正数区域线性,在负数区域则输出零,它计算快且避免了梯度消失问题,但它容易导致“死神经元”问题。

#### 2.2.2 权重初始化方法的影响

权重初始化是设置神经网络权重初始值的过程。权重初始化方法对模型训练的收敛速度和最终性能有很大影响。

```python

import tensorflow as tf

from tensorflow.keras import layers

# 权重初始化示例

model = tf.keras.Sequential([

layers.Dense(10, input_shape=(784,), activation='relu',

kernel_initializer='he_uniform'),

layers.Dense(10, activation='softmax')

])

# 编译和训练模型

***pile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 假设已有训练数据 train_images, train_labels

# model.fit(train_images, train_labels, epochs=5, batch_size=32)

```

在这个例子中,我们使用了He均匀初始化(`he_uniform`),它是一种针对ReLU激活函数优化的权重初始化方法。He初始化能够帮助保持激活值的方差,从而加速训练。

#### 2.2.3 正则化与防止过拟合

过拟合是机器学习中常见的问题,正则化是一种减少模型复杂度,防止过拟合的技术。

```python

# 使用L2正则化和Dropout防止过拟合

from keras.layers import Dropout

model = Sequential([

layers.Dense(128, activation='relu',

kernel_regularizer=tf.keras.regularizers.l2(0.001),

input_shape=(input_shape,),

name='DenseLayer'),

Dropout(0.5),

```

0

0