【文本分类实战对比】:深度学习与传统机器学习的PK分析

发布时间: 2024-09-02 07:53:34 阅读量: 196 订阅数: 78

# 1. 文本分类的概念与重要性

## 1.1 文本分类的定义

文本分类是将文本数据根据其内容分配到一个或多个类别中的过程。它通过分析文本的特征,如词语、短语和句子结构等,将这些特征映射到预定义的类别体系中。文本分类在搜索引擎、垃圾邮件过滤、新闻聚合以及情感分析等领域起着至关重要的作用。

## 1.2 文本分类的重要性

文本分类的重要性不仅体现在提升信息检索的效率上,还在于其强大的数据组织能力。它能够帮助人们更快速地从海量文本中提取有用信息,是自然语言处理(NLP)、机器学习以及人工智能应用中不可或缺的一部分。

## 1.3 应用前景与挑战

文本分类技术的应用前景十分广阔,但同时也面临许多挑战,如非结构化数据的处理、不同语言和领域下的适应性问题以及大规模数据集的计算效率等。解决这些问题需要不断的技术创新和算法优化,同时也推动着人工智能技术的不断进步。

以上章节为文章的开篇,为读者构建起对文本分类的基本了解框架,并激发读者对后续章节的好奇心与求知欲。

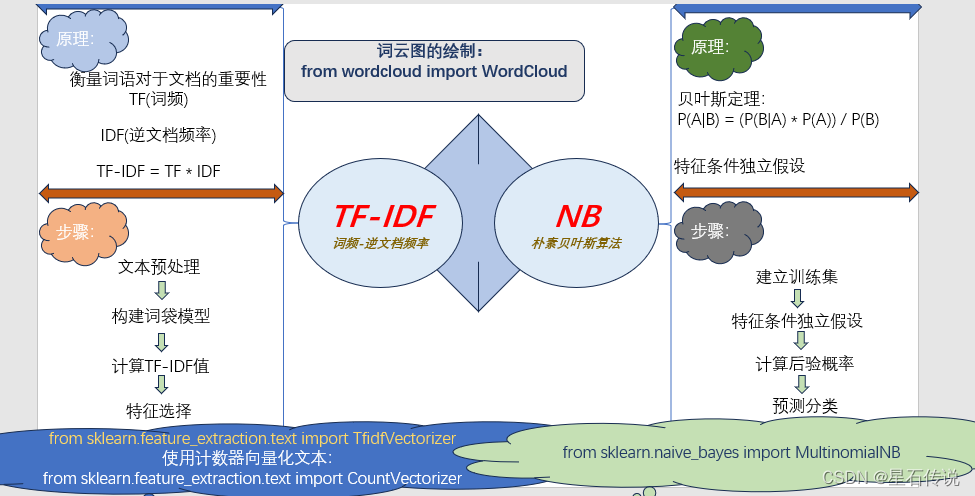

# 2. 传统机器学习在文本分类中的应用

## 2.1 传统机器学习模型概述

### 2.1.1 基于规则的分类方法

基于规则的分类方法依赖于预定义的规则集或关键词,来判断文本所属的类别。这种方法在面对结构化良好且规则明确的文本时,效果较好。然而,在实际应用中,由于自然语言的多样性和复杂性,手工制定的规则很难覆盖所有情况,从而限制了其适用范围和准确性。

### 2.1.2 基于统计的分类方法

基于统计的分类方法,如朴素贝叶斯(Naive Bayes)和支持向量机(SVM),利用统计理论从数据中自动学习分类规则。这些方法能够处理大量的数据,并从中发现潜在的模式,从而提高分类的准确性。

## 2.2 特征提取技术

### 2.2.1 词袋模型

词袋模型(Bag of Words, BoW)是文本分类中最基本的特征提取方法之一。它通过计算单词在文档中出现的频率来忽略单词之间的顺序信息,将文本转化为数值特征向量。尽管简单,但BoW常常是许多复杂文本处理技术的基石。

```python

from sklearn.feature_extraction.text import CountVectorizer

# 示例数据

documents = [

"This is a sample document.",

"Another document with sample text."

]

# 实例化词袋模型

vectorizer = CountVectorizer()

X = vectorizer.fit_transform(documents)

# 输出特征名称和相应的向量表示

print(vectorizer.get_feature_names())

print(X.toarray())

```

### 2.2.2 TF-IDF算法

TF-IDF算法(Term Frequency-Inverse Document Frequency)是一种用于信息检索与文本挖掘的常用加权技术。它能够反映一个词语在文档集合中的重要程度。通过降低常见词的权重并提升罕见词的权重,TF-IDF能够提升文本分类的准确性。

```python

from sklearn.feature_extraction.text import TfidfVectorizer

# 使用TF-IDF向量化

tfidf_vectorizer = TfidfVectorizer()

X_tfidf = tfidf_vectorizer.fit_transform(documents)

# 输出TF-IDF特征名称和相应的向量表示

print(tfidf_vectorizer.get_feature_names())

print(X_tfidf.toarray())

```

## 2.3 模型训练与评估

### 2.3.1 训练集与测试集的划分

为了评估模型的性能,在训练之前需要将数据集划分为训练集和测试集。训练集用于训练模型,而测试集则用于评估模型的泛化能力。常见的划分方法包括随机划分、时间序列划分等。

```python

from sklearn.model_selection import train_test_split

# 假设我们有一个文本数据集和对应标签

texts = ["text data sample", ...] # 文本数据集

labels = [0, 1, ...] # 对应标签

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(texts, labels, test_size=0.2, random_state=42)

```

### 2.3.2 交叉验证与模型选择

交叉验证是一种统计方法,用来评估并选择机器学习模型。在交叉验证过程中,数据集被分成k个子集,每次使用k-1个子集作为训练数据,剩余的一个子集作为验证数据。这有助于减少模型对训练集的依赖性,并有效提高模型的泛化能力。

```python

from sklearn.model_selection import cross_val_score

# 使用交叉验证评估模型

scores = cross_val_score(svm, X_train, y_train, cv=5)

# 输出不同折的分数

print(scores)

```

## 2.4 实践案例分析

### 2.4.1 实际数据集的应用

在实践中,数据集的来源和预处理是至关重要的步骤。文本数据往往需要经过清洗、分词、去除停用词等预处理步骤后,才能被用来训练模型。

### 2.4.2 模型性能对比

通过使用真实数据集进行模型训练和评估,可以对比不同模型的性能。通常,通过准确率、精确率、召回率等指标来衡量模型的分类效果。

```python

from sklearn.metrics import classification_report

# 假设我们有了预测结果和真实标签

y_pred = [0, 1, ...] # 预测结果

y_true = [0, 1, ...] # 真实标签

# 输出模型性能报告

print(classification_report(y_true, y_pred))

```

请注意,上述代码块仅作为示例,实际应用中需要结合真实数据和具体模型进行调整。在上述分析中,我们不仅深入探讨了传统机器学习在文本分类中的应用,还通过实践案例分析验证了模型的性能,并通过代码和实例对理论进行了进一步的解释。通过这些方法,可以更好地理解传统机器学习技术在文本分类中的实际运用,并为实际开发和研究工作提供参考。

# 3. 深度学习在文本分类中的应用

## 3.1 深度学习基础与优势

### 3.1.1 神经网络的基本概念

深度学习是机器学习的一个子领域,它通过构建具有多个处理层的神经网络来学习数据表示。这些层次结构让神经网络能够学习更加复杂的特征表示,从而在多个领域,特别是文本分类领域取得了显著的成效。神经网络的层次包括输入层、隐藏层和输出层。隐藏层可以有多个,每层包含多个神经元,这些神经元相互之间通过权重连接。训练过程中,通过反向传播算法和梯度下降法不断调整权重,使得模型预测结果与实际结果之间的误差最小化。

与传统机器学习相比,深度学习模型能够自动提取和学习特征,无需人工干预。而传统机器学习方法通常需要手动设计特征提取器,这不仅耗时耗力,而且在面对大量数据时效果往往不佳。

### 3.1.2 深度学习在文本分类中的优势

深度学习在文本分类中的优势主要表现在其能力上。首先,深度学习模型能够处理高维数据,并从中学习到更丰富的特征表示。其次,深度学习模型具有更好的泛化能力,这使得它们在未见过的数据上表现出更好的性能。此外,深度学习模型具有强大的非线性建模能力,可以捕捉数据中的非线性关系,这对于复杂文本的分类来说是至关重要的。

深度学习模型还能利用大规模数据集进行训练,从而获得更好的性能。它们在大数据场景下表现出的优越性,使其成为解决当前文本分类问题的首选方法。

## 3.2 深度学习模型架构

### 3.2.1 卷积神经网络(CNN)在文本分类中的应用

卷积神经网络(CNN)最初用于图像处理领域,因其强大的特征提取能力,也被广泛用于文本分类任务。在文本分类中,C

0

0