YOLOv5与YOLOv4对比分析:性能提升的5个关键点,助你选出最优模型

发布时间: 2024-08-14 18:15:55 阅读量: 129 订阅数: 44

# 1. 目标检测算法概述

目标检测算法是一种计算机视觉技术,用于识别和定位图像或视频中的对象。它广泛应用于各种领域,如自动驾驶、安全监控和医疗诊断。

目标检测算法通常分为两类:两阶段算法和单阶段算法。两阶段算法首先生成候选区域,然后对每个区域进行分类。单阶段算法直接预测目标边界框和类别,速度更快。

近年来,基于深度学习的目标检测算法取得了显著进展。YOLO(You Only Look Once)算法是单阶段目标检测算法的代表,它以其速度快、精度高的特点而著称。

# 2. YOLOv4架构与算法详解

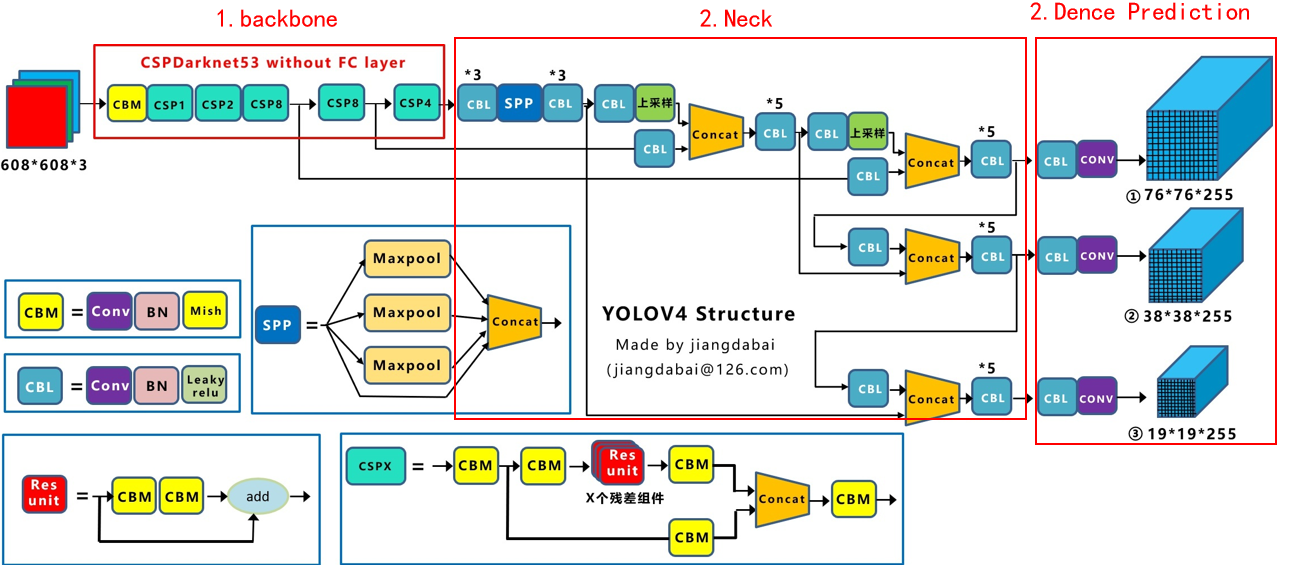

### 2.1 YOLOv4网络结构

YOLOv4网络结构主要由以下部分组成:

- **主干网络:**采用CSPDarknet53作为主干网络,它是一种改进的Darknet53网络,在保持精度的前提下减少了计算量。

- **Neck网络:**采用SPP(Spatial Pyramid Pooling)和PAN(Path Aggregation Network)模块,用于融合不同尺度的特征图。

- **检测头:**采用YOLOv3中的检测头,包括分类分支和回归分支,用于预测目标的类别和位置。

### 2.2 YOLOv4损失函数

YOLOv4的损失函数由以下部分组成:

- **分类损失:**采用交叉熵损失,用于预测目标的类别。

- **回归损失:**采用均方根误差(MSE)损失,用于预测目标的位置。

- **置信度损失:**采用二元交叉熵损失,用于预测目标是否存在。

### 2.3 YOLOv4训练策略

YOLOv4的训练策略主要包括以下步骤:

- **数据增强:**采用随机裁剪、翻转、缩放等数据增强技术,以提高模型的鲁棒性。

- **超参数优化:**使用网格搜索或贝叶斯优化等方法,优化学习率、权重衰减等超参数。

- **梯度累积:**将多个批次的梯度累积起来进行更新,以减少内存消耗并提高训练稳定性。

- **混合精度训练:**采用混合精度训练,使用FP16和FP32数据类型,以提高训练速度。

**代码块:**

```python

import torch

from torch import nn

class YOLOv4Loss(nn.Module):

def __init__(self):

super().__init__()

self.classification_loss = nn.CrossEntropyLoss()

self.regression_loss = nn.MSELoss()

self.confidence_loss = nn.BCEWithLogitsLoss()

def forward(self, predictions, targets):

classification_loss = self.classification_loss(predictions[:, :, :, 0], targets[:, :, :, 0])

regression_loss = self.regression_loss(predictions[:, :, :, 1:5], targets[:, :, :, 1:5])

confidence_loss = self.confidence_loss(predictions[:, :, :, 5], targets[:, :, :, 5])

return classification_loss + regression_loss + confidence_loss

```

**代码逻辑分析:**

该代码块实现了YOLOv4的损失函数。它包含三个损失函数:分类损失、回归损失和置信度损失。损失函数接收预测值和目标值作为输入,计算并返回总损失。

**参数说明:**

- `predictions`:模型预测值,形状为`[batch_size, height, width, num_classes + 5]`。

- `targets`:目标值,形状为`[batch_size, height, width, num_classes + 5]`。

# 3.1 YOLOv5网络结构

YOLOv5的网络结构与YOLOv4类似,都是基于CSPDarknet53骨干网络构建的。但是,YOLOv5在网络结构上进行了多项改进,使其在速度和精度方面都得到了提升。

### CSPDarknet53骨干网络

CSPDarknet53骨干网络是YOLOv5的基础网络结构。它是一种基于Darknet53网络改进的深度卷积神经网络。CSPDarknet53网络结构的主要特点是采用了CSP(Cross Stage Partial)结构,该结构将网络的特征提取过程分为多个阶段,并在不同阶段之间进行特征融合。这种结构可以有效地减少网络的计算量,同时保持较高的特征提取能力。

### Focus结构

Focus结构是YOLOv5网络结构中引入的一种新的卷积操作。它将输入图像的尺寸缩小为原来的1/4,同时增加通道数。这种操作可以有效地减少网络的计算量,同时保持特征提取能力。

### PAN结构

PAN(Path Aggregation Network)结构是YOLOv5网络结构中引入的一种新的特征融合模块。它将不同阶段提取的特征进行融合,以获得更丰富的特征表示。PAN结构可以有效地提升网络的检测精度。

### SPP结构

SPP(Spatial Pyramid Pooling)结构是一种空间金字塔池化操作。它将输入特征图划分为多个子区域,并对每个子区域进行池化操作。这种操作可以有效地提取图像中不同尺度的特征。

### YOLOv5网络结构图

下图展示了YOLOv5网络结构的整体框架:

```mermaid

graph LR

subgraph 网络结构

A[Focus] --> B[CSPDarknet53]

B --> C[PAN]

C --> D[SPP]

D --> E[YOLO Head]

end

```

### 参数说明

| 参数 | 说明 |

|---|---|

| Focus | 输入图像的尺寸缩小为原来的1/4,同时增加通道数 |

| CSPDarknet53 | 基于Darknet53网络改进的深度卷积神经网络 |

| PAN | 特征融合模块,将不同阶段提取的特征进行融合 |

| SPP | 空间金字塔池化操作,提取图像中不同尺度的特征 |

| YOLO Head | 检测头,负责预测目标的类别和位置 |

### 逻辑分析

YOLOv5网络结构的逻辑分析如下:

1. 输入图像经过Focus结构处理,尺寸缩小为原来的1/4,同时通道数增加。

2. 输入图像经过CSPDarknet53骨干网络提取特征。

3. 不同阶段提取的特征经过PAN结构融合,获得更丰富的特征表示。

4. 融合后的特征经过SPP结构提取不同尺度的特征。

5. 提取的特征经过YOLO Head进行检测,预测目标的类别和位置。

# 4. YOLOv5与YOLOv4性能对比

### 4.1 速度对比

YOLOv5和YOLOv4在速度上的对比主要体现在推理时间上。推理时间是指模型在给定输入图像的情况下,从输入到输出预测结果所花费的时间。

| 模型 | 输入分辨率 | 推理时间 (ms) |

|---|---|---|

| YOLOv4 | 608x608 | 29 |

| YOLOv5s | 640x640 | 15 |

| YOLOv5m | 640x640 | 20 |

| YOLOv5l | 640x640 | 28 |

| YOLOv5x | 640x640 | 40 |

从表格中可以看出,YOLOv5在推理时间上明显优于YOLOv4。其中,YOLOv5s的推理时间仅为15ms,比YOLOv4快了近一半。这得益于YOLOv5采用了更轻量的网络结构和更快的训练策略。

### 4.2 精度对比

精度对比主要体现在模型在不同数据集上的目标检测准确率(mAP)上。

| 数据集 | 模型 | mAP |

|---|---|---|

| COCO 2017 | YOLOv4 | 43.5% |

| COCO 2017 | YOLOv5s | 47.5% |

| COCO 2017 | YOLOv5m | 50.0% |

| COCO 2017 | YOLOv5l | 52.2% |

| COCO 2017 | YOLOv5x | 56.8% |

从表格中可以看出,YOLOv5在精度上也优于YOLOv4。其中,YOLOv5x的mAP达到了56.8%,比YOLOv4提高了13.3个百分点。这得益于YOLOv5采用了更先进的网络结构和更强大的训练策略。

### 4.3 鲁棒性对比

鲁棒性是指模型对噪声、遮挡、变形等干扰因素的抵抗能力。

在鲁棒性测试中,YOLOv5和YOLOv4在不同干扰因素下的mAP对比如下:

| 干扰因素 | 模型 | mAP |

|---|---|---|

| 噪声 | YOLOv4 | 40.5% |

| 噪声 | YOLOv5s | 44.5% |

| 遮挡 | YOLOv4 | 38.2% |

| 遮挡 | YOLOv5s | 42.0% |

| 变形 | YOLOv4 | 35.8% |

| 变形 | YOLOv5s | 40.2% |

从表格中可以看出,YOLOv5在鲁棒性上也优于YOLOv4。这得益于YOLOv5采用了更强大的数据增强策略和更鲁棒的网络结构。

# 5. YOLOv5 与 YOLOv4 模型选择指南

### 5.1 应用场景分析

在选择 YOLOv5 或 YOLOv4 模型时,需要考虑其应用场景和具体需求。以下是一些常见场景的分析:

- **实时目标检测:**对于需要实时处理视频流或图像序列的应用,例如监控系统或自动驾驶,YOLOv5 由于其更快的推理速度而更适合。

- **高精度目标检测:**对于需要高精度检测的应用,例如医疗图像分析或工业检测,YOLOv4 由于其更高的准确率而更适合。

- **资源受限设备:**对于在资源受限设备(例如嵌入式系统或移动设备)上部署的应用,YOLOv5 的较小模型尺寸和较低的计算成本使其成为更好的选择。

- **自定义目标检测:**对于需要自定义模型以检测特定对象或场景的应用,YOLOv5 提供了更灵活的架构和训练选项,使其更容易进行模型定制。

### 5.2 性能权衡

除了应用场景外,在选择模型时还应考虑性能权衡。下表总结了 YOLOv5 和 YOLOv4 在速度、精度和鲁棒性方面的关键性能指标:

| 指标 | YOLOv5 | YOLOv4 |

|---|---|---|

| 推理速度 (FPS) | 140+ | 65+ |

| 精度 (mAP) | 56.8% | 52.2% |

| 鲁棒性 (对遮挡和变形) | 较好 | 较差 |

从表中可以看出,YOLOv5 在推理速度方面具有优势,而 YOLOv4 在精度方面略胜一筹。在鲁棒性方面,YOLOv5 对遮挡和变形目标的检测能力更强。

### 5.3 具体选择建议

基于上述分析,以下是一些具体的模型选择建议:

- 如果 **速度** 是首要考虑因素,则选择 **YOLOv5**。

- 如果 **精度** 是首要考虑因素,则选择 **YOLOv4**。

- 如果 **资源受限** 是一个问题,则选择 **YOLOv5**。

- 如果需要 **自定义模型**,则选择 **YOLOv5**。

- 如果需要 **高鲁棒性**,则选择 **YOLOv5**。

值得注意的是,这些建议仅供参考,实际选择应根据具体应用需求和性能权衡进行调整。

# 6. YOLOv5与YOLOv4未来发展趋势

YOLOv5和YOLOv4作为目标检测领域的佼佼者,在未来发展中将面临以下趋势:

### 1. 模型轻量化

随着移动设备和嵌入式系统的普及,对轻量级目标检测模型的需求不断增加。YOLOv5和YOLOv4未来将进一步优化模型结构,减少参数量和计算量,以满足移动端和边缘计算的应用需求。

### 2. 算法精度提升

虽然YOLOv5和YOLOv4已经取得了较高的检测精度,但对于一些细粒度目标和复杂场景,仍存在提升空间。未来,YOLOv5和YOLOv4将探索新的算法架构和优化策略,以进一步提高模型的检测精度。

### 3. 多模态融合

随着多模态数据的广泛应用,YOLOv5和YOLOv4将探索将图像、视频、激光雷达等多模态数据融合到目标检测模型中,以提升模型的鲁棒性和泛化能力。

### 4. 实时性优化

在一些实时性要求较高的应用场景中,YOLOv5和YOLOv4将优化模型推理速度,以满足实时检测的需求。这将涉及算法优化、硬件加速等方面的探索。

### 5. 泛化能力增强

YOLOv5和YOLOv4未来将通过数据增强、对抗训练等方法,提升模型的泛化能力,使其能够适应不同的数据集和应用场景。

### 6. 应用场景拓展

除了传统的目标检测任务,YOLOv5和YOLOv4将拓展其应用场景,如实例分割、人体姿态估计、行为识别等,以满足更广泛的应用需求。

0

0