【CNN视觉应用全解析】:Python构建的卷积神经网络案例

发布时间: 2024-08-31 23:14:23 阅读量: 249 订阅数: 81

# 1. 卷积神经网络(CNN)基础

卷积神经网络(CNN)是一种深度学习的算法,它是图像识别和处理任务中的核心技术,对人工智能发展起到了革命性的作用。CNN以其独特的方式处理输入数据,能够自动地、有效地从原始数据中提取特征。本章节将初步探讨CNN的架构,为后文的深入研究奠定基础。

## 1.1 CNN的构成基础

CNN由不同类型的层次组成,包括卷积层、池化层、全连接层等。其中,卷积层用于特征提取,池化层用来减少数据维度和防止过拟合,全连接层则完成最终的分类任务。每一个层次的叠加与配合,构成了CNN强大的特征学习能力。

## 1.2 从简单模型到深度学习

最初的神经网络模型比较简单,通常只包含一个隐藏层,但随着研究的深入,研究人员发现增加网络的深度能够提高模型的表达能力。因此,CNN逐渐发展为具有多层结构的深度神经网络,它能够在图像、语音识别等复杂任务中达到前所未有的精确度。

## 1.3 CNN的应用领域

CNN不仅在图像识别领域取得了显著成果,它还被广泛应用于自然语言处理、语音识别、生物信息学等领域。例如,在图像识别任务中,CNN能够准确识别不同种类的物体,甚至在医学影像分析中辅助诊断。通过这些应用,我们可以看到CNN的广泛适用性和强大的潜力。

# 2. CNN的理论基础和数学原理

## 2.1 神经网络的概念和结构

### 2.1.1 神经网络的层次结构

神经网络由不同类型的层组成,每层包含若干个神经元,它们通过加权连接相互作用。最基本的神经网络结构包含输入层、隐藏层和输出层。输入层接收外部数据,隐藏层负责特征提取,而输出层则产生最终的预测结果。

- **输入层**:是神经网络与外界信息交互的接口,其神经元数量与输入数据的特征数量一致。

- **隐藏层**:位于输入层和输出层之间,可以有一层或多层。隐藏层越多,模型越复杂,提取的特征也就越抽象。

- **输出层**:表示最终的预测结果,其结构取决于任务类型,例如分类问题输出层通常包含与类别数目相同的神经元。

层次结构的设计是深度学习模型性能的关键,合理的层次设计有助于提高模型的泛化能力和学习效率。

### 2.1.2 激活函数的作用和类型

激活函数是神经网络中的非线性函数,它们被应用在隐藏层神经元的输出上,将加权输入映射到某个范围,通常是非线性范围。激活函数的选择和应用对于网络的学习能力至关重要。

- **Sigmoid函数**:输出范围为(0,1),早期常用于二分类问题。缺点是存在梯度消失问题,不适用于深层网络。

- **ReLU函数**:输出为0或正数,由于其计算简单,梯度不消失,在现代神经网络中非常流行。缺点是存在死亡ReLU问题,即部分神经元可能永远不被激活。

- **Tanh函数**:输出范围为(-1,1),解决了Sigmoid函数的输出范围限制问题,但仍存在梯度消失问题。

- **Leaky ReLU**:为ReLU的变体,允许微小的负梯度,以缓解ReLU的缺点。

激活函数的选择直接影响到模型的性能,因此需要根据具体任务和数据特性来谨慎选择。

## 2.2 卷积操作的原理

### 2.2.1 卷积层的工作机制

卷积层是CNN的核心组成部分,通过卷积操作可以提取输入数据的空间特征。卷积操作涉及三个主要部分:输入数据、卷积核(滤波器)和输出特征图。

卷积核在输入数据上滑动,对应位置进行元素乘法求和,得到输出特征图的一个像素值。卷积核的不同可以提取不同的特征,例如边缘检测、颜色等。

- **滑动步长**:定义了卷积核在输入数据上每次移动的像素数,常见值为1或2。

- **填充**:在输入数据的边缘进行添加0或特定值的操作,以控制输出特征图的大小。

卷积操作使得网络能够聚焦局部特征,同时通过权值共享减少参数数量,提高模型效率。

### 2.2.2 池化层及其作用

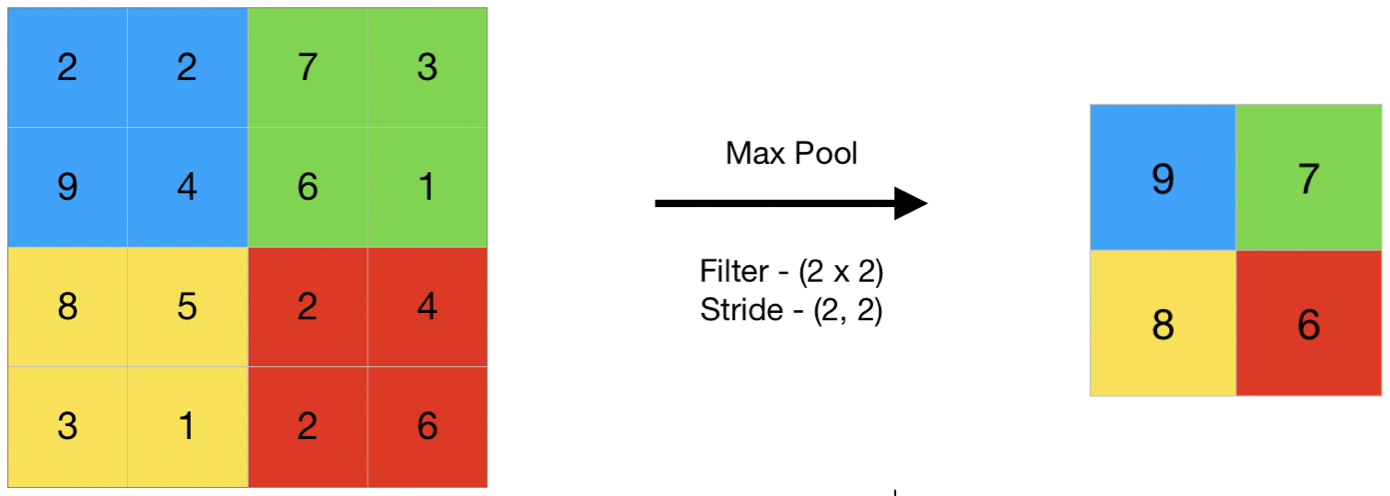

池化层通常紧跟卷积层,主要作用是降低特征图的空间维度,增强特征的空间不变性。常见的池化操作包括最大池化(Max Pooling)和平均池化(Average Pooling)。

- **最大池化**:选取池化区域中的最大值作为输出。

- **平均池化**:计算池化区域的平均值作为输出。

池化操作通过减少数据的空间尺寸来减少计算量,并使特征表示在位置上更加鲁棒,有助于缓解过拟合问题,提高模型泛化能力。

## 2.3 CNN中的优化算法和正则化

### 2.3.1 常见的优化方法

优化算法是深度学习中用来调整模型参数,以最小化损失函数值的方法。常见的优化算法包括梯度下降(GD)、随机梯度下降(SGD)、动量梯度下降(Momentum)、RMSprop和Adam。

- **梯度下降**:是所有优化算法的基础,根据损失函数关于参数的梯度更新参数,迭代直至收敛。

- **随机梯度下降(SGD)**:在梯度下降基础上引入随机性,每次迭代仅使用一小批数据(称为mini-batch)计算梯度。

- **动量梯度下降**:在SGD基础上加入动量项,可以加速学习过程并帮助克服梯度消失问题。

- **RMSprop**:调整学习率,使得学习过程更加稳定。

- **Adam**:结合了动量和RMSprop的优点,是一种自适应学习率的优化算法,广泛应用于各种深度学习任务。

选择合适的优化算法是提高模型训练效率和模型性能的重要步骤。

### 2.3.2 防止过拟合的技术

过拟合是指模型对训练数据学习得太好,导致在未知数据上泛化能力差。防止过拟合的技术包括正则化、数据增强和提前停止。

- **正则化**:L1和L2正则化通过在损失函数中添加与权重大小相关的项,鼓励模型学习更加平滑的函数,从而减少复杂度。

- **数据增强**:通过改变输入数据的方式(如旋转、翻转、裁剪等)人为地增加数据多样性,提高模型泛化能力。

- **提前停止(Early Stopping)**:在验证集上的性能不再提升时停止训练,防止模型过度拟合训练数据。

通过这些技术,可以提高CNN在实际应用中的稳健性和性能。

# 3. Python中的CNN构建工具

## 3.1 使用TensorFlow构建CNN

TensorFlow 是一个开源的软件库,用于数据流图的数值计算。它特别适合用于大规模的机器学习和深度学习任务。在构建卷积神经网络(CNN)时,TensorFlow 提供了强大的底层支持和高层 API,使得研究人员和开发者可以高效地实现各种复杂的模型。

### 3.1.1 TensorFlow的基本概念

TensorFlow 的核心是基于数据流图的计算模型,其中的节点代表数学运算,而图中的边表示在这些节点间传递的多维数据数组,即张量(tensors)。TensorFlow 中的数据流图可以跨多种设备(CPU、GPU)进行分布式执行。

数据流图在 TensorFlow 中被称为计算图。每个节点执行的操作可以是矩阵乘法、加法或任何其他数学运算。计算图被编译后,TensorFlow 会优化图中的计算,减少冗余和并行计算,以便在给定的计算资源下以最高效的方式执行。

TensorFlow 有两种运行模式:即时执行(Eager Execution)和图执行(Graph Execution)。即时执行模式类似于 Python 的常规执行方式,即代码在写完后立即执行,易于调试。而图执行模式则是构建一个计算图,然后提交给 TensorFlow 的执行引擎去运行。

### 3.1.2 TensorFlow中的CNN模型实现

在 TensorFlow 中实现 CNN 需要定义数据输入、卷积层、激活函数、池化层、全连接层以及输出层。通过使用 TensorFlow 的高级接口 `tf.keras`,我们可以很方便地构建一个 CNN 模型。

以下是一个简单的 CNN 模型实现示例:

```python

import tensorflow as tf

# 定义一个简单的CNN模型

model = tf.keras.models.Sequential([

# 卷积层,32个3x3的卷积核,激活函数使用ReLU

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)),

# 池化层,2x2大小池化窗口

tf.keras.layers.MaxPooling2D(2, 2),

# 第二个卷积层

tf.keras.layers.Conv2D(64, (3, 3), activation='relu'),

# 第二个池化层

tf.keras.layers.MaxPooling2D(2, 2),

# 展平层,将三维输出展开为一维

tf.keras.layers.Flatten(),

# 全连接层,128个节点

tf.keras.layers.Dense(128, activation='relu'),

# Dropout层,防止过拟合

tf.keras.layers.Dropout(0.5),

# 输出层,10个节点对应10个类别

tf.keras.layers.Dense(10, activation='softmax')

])

# 编译模型,指定损失函数、优化器和评估指标

***pile(

loss='sparse_categorical_crossentropy',

optimizer='adam',

metrics=['accuracy']

)

# 打印模型概况

model.summary()

```

在这个例子中,我们构建了一个简单的 CNN 模型,包含了两个卷积层和两个池化层,之后是一个全连接层和一个输出层。模型在编译时指定了损失函数为 `sparse_categorical_crossentropy`,优化器为 `adam`,评估指标为 `accuracy`。

模型构建完毕后,我们需要提供数据来训练这个模型。这通常包括加载数据集、划分训练集和验证集、以及开始训练过程。

```python

# 假设train_images和train_labels是已经准备好的训练数据和标签

# 训练模型

model.fit(train_images, train_labels, epochs=5, validation_split=0.2)

```

通过上述步骤,我们就可以在 TensorFlow 中实现一个简单的 CNN 模型。随着对 TensorFlow 和深度学习的进一步了解,我们还可以探索更多高级特性,比如自定义层、自定义激活函数、回调函数(callbacks)以及模型保存与加载等。

## 3.2 使用Keras构建CNN

Keras 是一个开源的神经网络库,它被设计为简单易用,但同时又足够强大以支持复杂的网络结构。Keras 最大的特点是用户友好,高度模块化,易于扩展。它支持快速实验,使得用户能够以最小的延迟把想法转换为结果。

### 3.2.1 Keras简介及优势

Keras 由 Francois Chollet 开发,目的是为了支持快速的实验。它提供了与 TensorFlow、Theano 和 CNTK 后端的无缝集成。Keras 设计时就考虑了易用性、模块化和灵活性。Keras 的 API 设计遵循“约定优于配置”的理念,意味着大多数的默认配置都能满足用户的需要。

Keras 的优势包括:

- 易于上手:Keras 的 API 设计得简洁明了,新手很容易学会如何使用。

- 快速实验:Keras 支持快速原型设计,使得在不同的网络结构和参数之间切换变得非常快速。

- 模块化和可组合:Keras 的组件可以独立使用,并且可以轻松组合成复杂的模型。

- 跨平台:支持 CPU 和 GPU,可以在不同的操作系统上运行。

### 3.2.2 Keras中的CNN模型构建案例

在 Keras 中构建 CNN 的步骤和 TensorFlow 类似,但是 Keras 提供了更多高层的抽象,使得编写代码更为简洁。以下是一个使用 Keras 构建的 CNN 模型的示例:

```python

from tensorflow import keras

from tensorflow.keras import layers

# 创建一个Sequential模型

model = keras.Sequential([

# 卷积层,32个3x3的卷积核,激活函数使用ReLU

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)),

# 池化层,2x2大小池化窗口

layers.MaxPooling2D(2, 2),

# 第二个卷积层

layers.Conv2D(64, (3, 3), activation='relu'),

# 第二个池化层

layers.MaxPooling2D(2, 2),

# 展平层,将三维输出展开为一维

layers.Flatten(),

# 全连接层,128个节点

layers.Dense(128, activation='relu'),

# Dropout层,防止过拟合

layers.Dropout(0.5),

# 输出层,10个节点对应10个类别

layers.Dense(10, activation='softmax')

])

# 编译模型

***pile(

optimizer='adam',

loss='sparse_cat

```

0

0