Transformer模型在机器翻译中的挑战与机遇:探索未来发展方向

发布时间: 2024-08-20 08:21:00 阅读量: 38 订阅数: 21

python的基于transformer模型实现机器翻译任务源码+文档说明.zip

# 1. Transformer模型在机器翻译中的理论基础

Transformer模型是一种神经网络架构,它在机器翻译领域取得了显著的进步。该模型基于注意力机制,允许其处理长序列数据并捕获文本中的全局依赖关系。

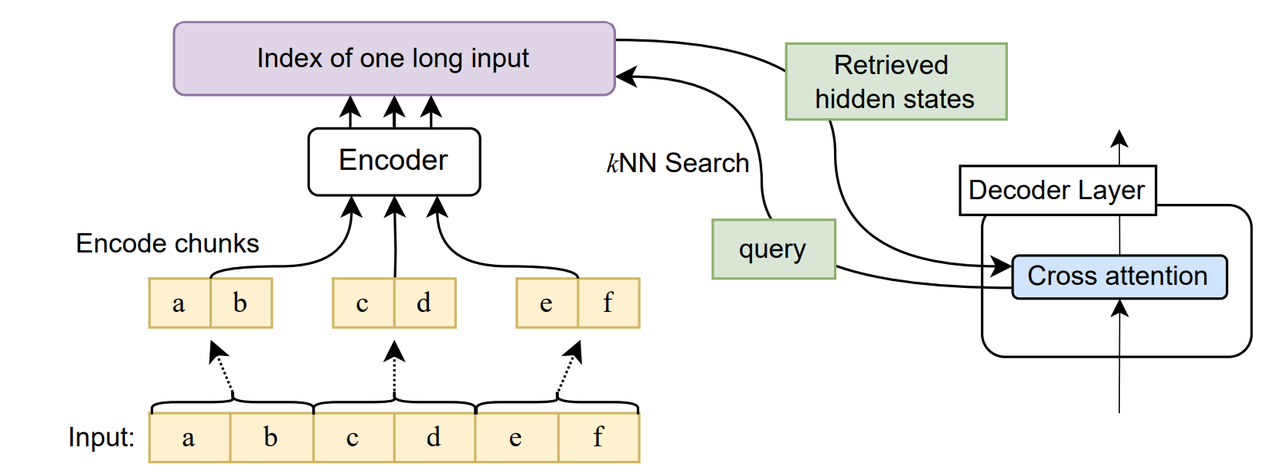

Transformer模型由编码器和解码器组成。编码器将输入序列转换为一组向量,其中每个向量表示输入序列中一个单词或子词的语义表示。解码器使用这些向量生成目标语言中的输出序列,一次生成一个单词。

Transformer模型的注意力机制允许它关注输入序列中的相关部分,从而提高翻译质量。此外,Transformer模型的并行架构使其能够有效地训练和处理大规模数据集。

# 2. Transformer模型在机器翻译中的实践应用

### 2.1 Transformer模型的翻译流程和原理

Transformer模型在机器翻译中的翻译流程主要分为编码和解码两个阶段:

**编码阶段:**

1. 将源语言句子中的每个单词转换为一个嵌入向量,形成一个单词嵌入序列。

2. 使用位置编码对单词嵌入序列进行增强,以捕获单词在句子中的相对位置信息。

3. 通过多头自注意力机制对单词嵌入序列进行处理,获取单词之间的相互依赖关系。

4. 通过前馈神经网络对自注意力输出进行进一步处理,增强单词的语义表示。

5. 重复步骤3和4,堆叠多个编码器层,逐层提取更高级别的语义特征。

**解码阶段:**

1. 将目标语言句子中的第一个单词转换为一个嵌入向量,作为解码器的初始状态。

2. 使用位置编码对解码器初始状态进行增强。

3. 通过自注意力机制对解码器初始状态进行处理,获取目标语言单词之间的相互依赖关系。

4. 通过编码器-解码器注意力机制,将编码器输出与解码器初始状态进行交互,获取源语言和目标语言之间的语义对应关系。

5. 通过前馈神经网络对自注意力输出进行进一步处理,生成目标语言单词的概率分布。

6. 重复步骤3-5,逐个生成目标语言句子中的单词。

### 2.2 Transformer模型的训练和调优方法

**训练过程:**

1. **数据预处理:**对源语言和目标语言句子进行分词、标记化和嵌入。

2. **模型初始化:**初始化Transformer模型的参数,包括嵌入矩阵、注意力权重和前馈神经网络权重。

3. **前向传播:**将源语言和目标语言句子输入模型,进行编码和解码。

4. **计算损失:**计算模型预测的目标语言句子与真实目标语言句子之间的损失函数值,如交叉熵损失或序列到序列损失。

5. **反向传播:**根据损失函数值计算模型参数的梯度。

6. **参数更新:**使用优化算法(如Adam)更新模型参数,减小损失函数值。

**调优方法:**

1. **超参数优化:**调整学习率、批大小、编码器和解码器层数等超参数,以获得最佳模型性能。

2. **正则化:**使用dropout、层归一化等正则化技术防止模型过拟合。

3. **数据增强:**使用回译、反向翻译等数据增强技术扩充训练数据集,提高模型鲁棒性。

4. **多任务学习:**将机器翻译任务与其他相关任务(如文本摘要、语言建模)结合起来进行训练,提升模型泛化能力。

### 2.3 Transformer模型的评估和指标

**评估指标:**

1. **BLEU(双语评估工具):**衡量机器翻译输出与参考译文的相似性。

2. **ROUGE(重叠式单元评估):**衡量机器翻译输出与参考译文中重叠的n元组数量。

3. **METEOR(机器翻译评估器):**综合考虑翻译准确性、流畅性和语义一致性。

4. **TER(翻译错误率):**计算机器翻译输出与参考译文之间的单词错误率。

**评估方法:**

1. **人工评估:**由人类评估员对机器翻译输出进行

0

0