Transformer模型解决翻译偏差和偏见的策略:打造公平公正的机器翻译

发布时间: 2024-08-20 07:57:29 阅读量: 49 订阅数: 21

python的基于transformer模型实现机器翻译任务源码+文档说明.zip

# 1. 翻译偏差和偏见的概念**

翻译偏差和偏见是指机器翻译系统在翻译过程中引入的不公平或不准确的信息。偏差可以表现为对特定性别、种族或社会群体的不公平描述,而偏见则反映了训练数据或模型本身中存在的固有偏见。

这些偏差和偏见会对机器翻译的质量和公平性产生负面影响。它们可能导致翻译中出现冒犯性或不准确的语言,从而损害用户体验和对系统的信任。此外,偏差和偏见还会限制机器翻译在敏感领域(如医疗保健或法律)中的应用。

# 2. Transformer模型的理论基础

Transformer模型是谷歌在2017年提出的神经网络架构,它在自然语言处理领域取得了突破性的进展,特别是机器翻译任务。Transformer模型通过引入自注意力机制,克服了传统序列到序列模型在处理长序列数据时的局限性,极大地提高了翻译质量。

### 2.1 自注意力机制

自注意力机制是Transformer模型的核心,它允许模型关注序列中不同位置的元素之间的关系。与卷积神经网络和循环神经网络不同,自注意力机制不需要显式的卷积或递归操作,而是直接计算序列中每个元素与其他所有元素之间的相关性。

自注意力机制的数学公式如下:

```

Attention(Q, K, V) = softmax(QK^T / sqrt(d_k))V

```

其中:

* Q、K、V是查询、键和值矩阵,分别由输入序列的嵌入表示计算得到

* d_k是键矩阵的维度

自注意力机制通过计算查询向量与键向量之间的点积,然后对结果进行softmax归一化,得到注意力权重。注意力权重表示每个查询元素与其他所有元素之间的相关性。最后,将注意力权重与值矩阵相乘,得到加权和,即自注意力输出。

### 2.2 Transformer架构

Transformer模型由编码器和解码器组成,编码器将输入序列转换为一组固定长度的向量,解码器再将这些向量转换为输出序列。

**编码器**

编码器由多个编码器层堆叠而成,每个编码器层包含两个子层:自注意力层和前馈神经网络层。自注意力层计算输入序列中元素之间的关系,前馈神经网络层对自注意力层的输出进行非线性变换。

**解码器**

解码器也由多个解码器层堆叠而成,每个解码器层包含三个子层:掩码自注意力层、编码器-解码器注意力层和前馈神经网络层。掩码自注意力层计算解码器序列中元素之间的关系,编码器-解码器注意力层计算解码器序列与编码器输出之间的关系,前馈神经网络层对编码器-解码器注意力层的输出进行非线性变换。

Transformer模型通过堆叠多个编码器和解码器层,可以捕捉序列中长距离的依赖关系,从而提高翻译质量。

# 3.1 数据预处理和增强

#### 数据预处理

数据预处理是机器翻译中至关重要的一步,它可以提高模型的训练效率和翻译质量。对于Transformer模型,数据预处理包括以下几个步骤:

- **分词和词干化:**将句子分解成单词,并去除词缀,以获得单词的词干。这有助于模型学习单词的语义含义,并减少词汇量。

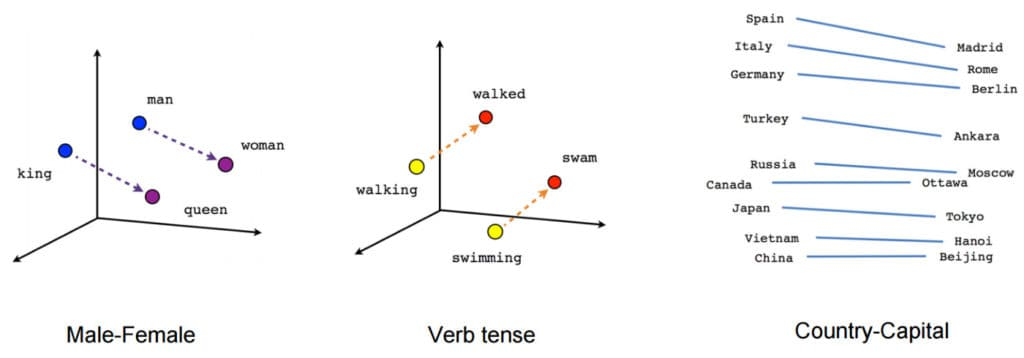

- **词嵌入:**将单词转换为向量表示,以捕获它们的语义和语法信息。词嵌入可以预先训练或在模型训练过程中学习。

- **句子对齐:**将源语言句子与目标语言句子对齐,以创建训练数据。句子对齐可以自动或手动完成。

#### 数据增强

数据增强技术可以帮助解决数据稀缺和偏差问题,从而提高模型的泛化能力。对于Transformer模型,常用的数据增强技术包括:

- **反向翻译:**将目标语言句子翻译回源语言,然后将其作为额外的训练数据。这有助于模型学习源语言和目标语言之间的关系。

- **随机采样:**从训练数据中随机采样句子,以创建新的训练集。这有助于模型避免过拟合特定句子。

- **合成数据:**使用语言模型或其他技术生成合成数据,以补充训练数据

0

0