防止SVM过拟合:模型选择与交叉验证的最佳实践

发布时间: 2024-11-20 11:44:35 阅读量: 47 订阅数: 47

svm.rar_SVM 交叉_svm_交叉验证_交叉验证SVM_十倍交叉验证

# 1. 支持向量机(SVM)基础

支持向量机(SVM)是机器学习中的一种强大的监督学习模型,广泛应用于分类和回归问题。SVM的核心思想是找到一个最优的超平面,它能够最大化地将数据集中的两类数据分隔开。这个超平面称为“最大间隔超平面”,而支持向量则是靠近该超平面的数据点。尽管SVM以其强大的泛化能力著称,但在数据量较少或特征维度较高时,也可能会出现过拟合的情况。因此,在实际应用中,理解和优化SVM模型的泛化能力,避免过拟合是非常重要的。

## SVM基础概念

- **超平面**: 在n维空间中,将数据集分为两类的n-1维的决策边界。

- **支持向量**: 数据集中最靠近超平面的那些点,它们在确定超平面时起到决定性作用。

- **间隔**: 支持向量到超平面的最小距离,SVM的目标是最大化这个间隔。

## SVM的数学原理

SVM的训练过程可以通过解决一个凸二次规划问题来找到最优的超平面。其目标函数是最小化一个包含间隔和惩罚参数C的表达式,而约束条件则确保所有的数据点都正确分类,并且距离超平面的间隔满足预定条件。数学表达式如下:

```plaintext

minimize: 1/2 ||w||^2 + C ∑ max(0, 1 - yi(w·xi + b))

```

其中,`w`是超平面的法向量,`b`是偏置项,`C`是惩罚参数,`xi`和`yi`分别是样本特征向量和对应的类别标签,`||w||^2`是L2范数,用来控制间隔的大小,即模型的复杂度。

## SVM的应用场景

SVM因其在面对高维数据和小样本情况下有优秀的分类性能,被广泛应用于生物信息学、图像识别、文本分类和手写识别等领域。在使用SVM时,往往需要对数据进行预处理,包括特征选择和数据标准化,以便模型能够更加有效地学习数据中的模式。

# 2. 理解过拟合及其对SVM的影响

### 过拟合的定义与后果

#### 过拟合在机器学习中的表现

过拟合是指在机器学习模型训练过程中,模型过于复杂,以至对训练数据集中的噪声和异常值也进行了学习,从而失去了泛化能力。这导致模型在训练集上的表现非常好,但在新的、未见过的数据上性能急剧下降。

在支持向量机(SVM)模型中,过拟合通常表现为决策边界过于复杂,紧密贴合训练数据集的特征。例如,对于一个简单的二分类问题,一个健康的SVM模型可能产生一个清晰、简洁的决策边界。但过拟合的SVM模型可能会形成一个锯齿状或复杂的决策边界,围绕着数据点形成,这将无法很好地适应新的样本。

#### SVM过拟合的具体案例分析

考虑一个手写数字识别的任务,使用SVM进行分类。在训练过程中,如果模型参数设置不当,可能导致对训练数据的学习过度,使得模型记住了数字的笔画特征,而没有学习到识别数字的根本模式。当模型在新的手写样本上进行预测时,由于这些样本的笔画可能略有不同,模型的表现就会大幅下降。

这种情况下的过拟合可以通过可视化决策边界来识别。通过观察决策边界是否过于复杂,可以初步判断模型是否存在过拟合现象。

### SVM过拟合的原因探讨

#### 核函数选择不当的影响

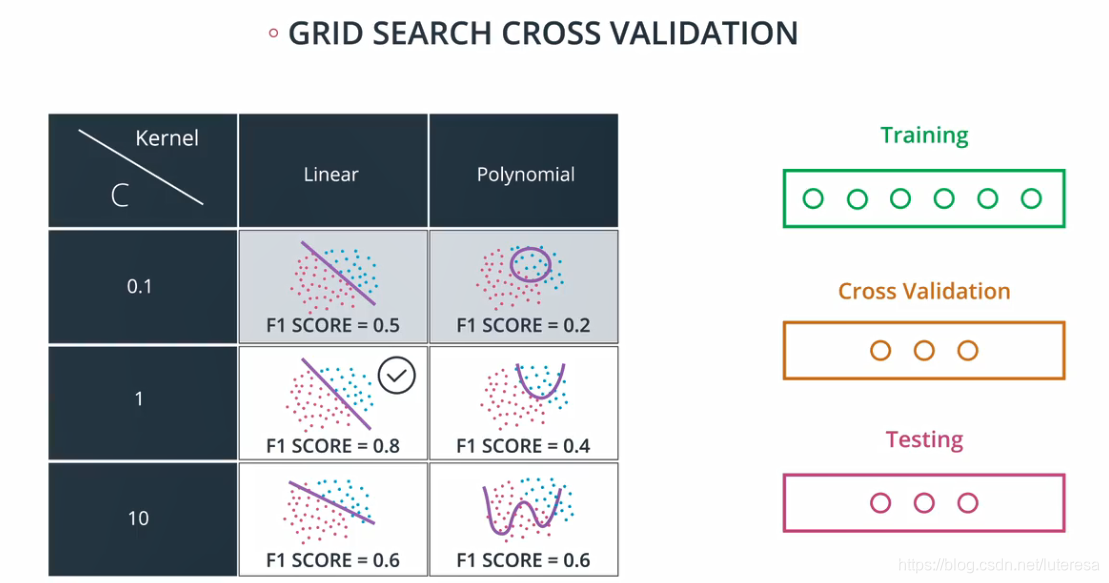

核函数在SVM中扮演着重要的角色,它能够将数据从原始特征空间映射到一个更高维的空间,使得数据线性可分。然而,不同的核函数会对模型的复杂度和泛化能力产生显著影响。如果选择了一个过于复杂的核函数,如多项式核,可能会导致模型过度拟合训练数据,因为它具有很高的自由度来适应复杂的数据分布。

选择合适的核函数是防止SVM过拟合的关键。通常需要根据具体问题选择合适的核函数,并通过交叉验证等方法来调整核函数的参数,以达到最佳的泛化效果。

#### 训练数据的限制和问题

训练数据的质量和数量直接影响到SVM模型的泛化能力。如果训练数据存在质量问题,如样本不平衡、含有噪声、存在异常值或样本量不足,均会导致模型无法有效地学习到数据中的真实分布,从而造成过拟合。

为了应对这些问题,数据预处理变得至关重要。有效的数据清洗、异常值处理和重采样技术可以帮助提高数据质量,使SVM模型能更好地学习到数据的真正特征。

#### 模型复杂度与数据量的关系

模型的复杂度与数据量之间需要保持平衡。SVM模型的复杂度主要通过参数C(正则化参数)和核函数的参数来控制。C值越大,模型越倾向于对训练数据进行拟合;数据量越小,模型对数据的拟合程度越高,更容易产生过拟合。

为了避免过拟合,一方面需要仔细选择SVM的参数,另一方面也要确保有足够的训练数据来支持模型的学习。当数据量较少时,可以通过引入先验知识或使用正则化技术来约束模型的复杂度。

# 3. SVM模型选择的策略

## 3.1 模型选择的重要性

### 3.1.1 正确模型选择的长期益处

选择正确的支持向量机(SVM)模型并对其进行适当的配置,是确保机器学习系统性能的关键因素。正确的模型选择不仅能够提高当前任务的准确率和效率,而且还能为未来可能的扩展和维护提供坚实的基础。

从长期来看,正确的模型选择可以带来以下益处:

1. **可扩展性**:良好的模型选择确保了模型可以扩展到更大的数据集上,而不牺牲性能。

2. **鲁棒性**:选择一个能够很好地处理噪声和异常值的模型,可提升系统的稳定性。

3. **维护性**:一个结构清晰、参数设置合理的模型更易于理解和维护。

4. **成本效益**:减少不必要的模型复杂度,可以节省计算资源,提高成本效益。

5. **灵活性**:选择支持各种核函数的SVM模型,能够灵活应对不同类型的数据。

### 3.1.2 模型选择与性能评估

在选择SVM模型时,必须考虑的性能评估指标包括:

- **准确性**:模型输出结果的正确率。

- **召回率**:模型正确识别的正例占所有正例总数的比例。

- **精确率**:模型输出的正例中正确结果的比例。

- **F1分数**:精确率和召回率的调和平均值,用于综合评价模型。

- **ROC曲线与AUC值**:通过绘制接受者操作特征曲线(ROC)并计算曲线下面积(AUC)来评估模型性能。

## 3.2 SVM参数优化技巧

### 3.2.1 参数选择的一般规则

在SVM模型中,参数选择对最终性能的影响至关重要。一些基本的参数选择规则包括:

- **C参数**:控制模型复杂度和对错误分类的惩罚力度。C值越大,对错误分

0

0