SVM鲁棒性分析:异常值处理与影响评估的策略

发布时间: 2024-11-20 12:32:01 阅读量: 35 订阅数: 21

项目实战:SPSS Modeler数据挖掘项目实战培训-第22课:SVM思想与解释补充 共4页.pptx

# 1. 支持向量机(SVM)基础

## 1.1 SVM的概念及其原理

支持向量机(Support Vector Machine, SVM)是一种广泛应用于分类和回归分析的监督学习算法。SVM通过在特征空间中找到最优的决策边界来区分不同类别。这个决策边界被称为超平面,其目的是最大化不同类别数据点之间的间隔。在SVM中,这些距离超平面最近的数据点被称为支持向量,它们在确定超平面位置时起着关键作用。

## 1.2 SVM的数学基础

SVM的数学基础主要基于统计学习理论中的结构风险最小化原则。该理论认为,一个好的模型应该具有良好的泛化能力,即在未知数据上的表现尽可能接近在已知数据上的表现。在优化问题中,SVM试图解决的是一个凸二次规划问题,确保找到的超平面是全局最优的。SVM的求解通常会涉及到拉格朗日乘子法和核函数技巧,这为处理线性不可分的数据提供了可能。

## 1.3 SVM的应用场景和优势

SVM在图像识别、生物信息学、文本分类等领域都有广泛的应用。其优势在于处理小样本数据时表现出的高准确率和在多维空间中的高效性能。此外,SVM对于非线性问题的处理能力强,通过引入不同的核函数,可以将数据映射到高维空间解决原本在原始空间中线性不可分的问题。不过,SVM的计算成本和参数选择较为复杂,需要适当的方法来调整以达到最佳性能。

# 2. 异常值在SVM中的影响

异常值是数据分析中普遍存在的问题,它们可能会对模型的性能产生负面影响。在这一章节中,我们将深入探讨异常值的定义、类型、它们对支持向量机(SVM)的影响,以及如何使用统计方法来检测异常值,并介绍一些传统的异常值处理策略。

## 2.1 异常值的定义和类型

### 2.1.1 数据集中的异常值

异常值是指在数据集中与其他数据点明显不同的观测值。它们可能源自于测量误差、数据录入错误,或者它们就是数据生成过程中真实的变化。异常值可以是单个的数据点,也可以是一组数据点。它们的出现可能会对数据分析的准确性、模型的建立以及最终的决策制定产生干扰。

异常值的识别是一个复杂的过程,因为它们可能是数据中的“金块”,即意外发现的有价值的信息源,也可能仅仅是噪声。这要求在处理异常值之前进行彻底的分析。

### 2.1.2 异常值对SVM的影响

异常值对SVM的影响是显著的,因为SVM是一种对数据的分布敏感的分类器。SVM通过最大化不同类别之间的边界来构建决策边界,而异常值可能会导致这个边界偏离正常数据的分布,进而降低模型的泛化能力。

在实际应用中,异常值会扭曲SVM的优化目标,导致模型在训练数据上表现良好,但在新的、未见过的数据上表现不佳。这是由于异常值的存在会误导模型过分关注少数的数据点,而不是整体数据的结构。

## 2.2 异常值检测的统计方法

### 2.2.1 描述性统计检测

描述性统计检测是异常值检测中最早和最常用的方法之一。它依赖于数据集的统计特性,如均值、标准差和四分位数等。异常值通常定义为那些与均值偏差超过3个标准差的数据点,或者位于第一四分位数以下1.5倍的四分位距(IQR)之外,以及位于第三四分位数以上1.5倍的IQR之外的值。

```python

import numpy as np

# 示例数据集

data = np.array([102, 101, 100, 99, 98, 103, 1000])

# 计算均值和标准差

mean = np.mean(data)

std_dev = np.std(data)

# 计算3个标准差范围

lower_bound = mean - 3 * std_dev

upper_bound = mean + 3 * std_dev

# 检测异常值

outliers = [x for x in data if x < lower_bound or x > upper_bound]

print("异常值: ", outliers)

```

### 2.2.2 基于距离的异常值检测

基于距离的方法检测异常值,依赖于数据点与最近邻点的距离。如果一个数据点距离它的邻居很远,那么这个点可能就是一个异常值。最常用的距离度量方法是k-最近邻(k-NN)。

```python

from sklearn.neighbors import NearestNeighbors

import numpy as np

# 示例数据集

data = np.array([[1, 2], [2, 3], [99, 99], [4, 5], [5, 6]])

# 创建k-NN模型

knn = NearestNeighbors(n_neighbors=2)

knn.fit(data)

# 计算所有点到其最近邻的距离

distances, _ = knn.kneighbors(data)

# 假设最大距离的3倍作为阈值

threshold = np.max(distances) * 3

outliers = np.where(distances > threshold)

# 检测到的异常值索引

print("异常值索引: ", outliers)

```

### 2.2.3 基于密度的异常值检测

基于密度的方法将异常值定义为那些位于低密度区域的数据点。这些区域的数据点数量少,与其他数据点的距离较远。DBSCAN(Density-Based Spatial Clustering of Applications with Noise)算法是一种常用的基于密度的异常值检测方法。

```python

from sklearn.cluster import DBSCAN

import numpy as np

# 示例数据集

data = np.array([[1, 2], [2, 2], [2, 3], [8, 7], [8, 8], [25, 80]])

# 使用DBSCAN检测异常值

db = DBSCAN(eps=3, min_samples=2).fit(data)

labels = db.labels_

# 标记异常值

outliers = [index for index, label in enumerate(labels) if label == -1]

print("异常值索引: ", outliers)

```

## 2.3 异常值处理的传统策略

### 2.3.1 删除异常值

删除异常值是一种简单直接的处理方法,可以通过上述统计方法检测到的异常值索引来进行。删除异常值虽然简单,但可能会损失有用的信息,特别是当异常值本身包含有价值信息的情况下。

### 2.3.2 数据变换和正则化

数据变换可以用来减少异常值对模型的影响。一种常见的方法是对数据进行对数变换、平方根变换或者Box-Cox变换,这些变换可以减少数据的偏斜度,从而使得异常值的影响变小。

正则化是另一种减少异常值影响的方法。例如,在SVM模型中,使用L1或L2正则化项可以对模型施加一定的约束,使得模型对异常值不那么敏感。

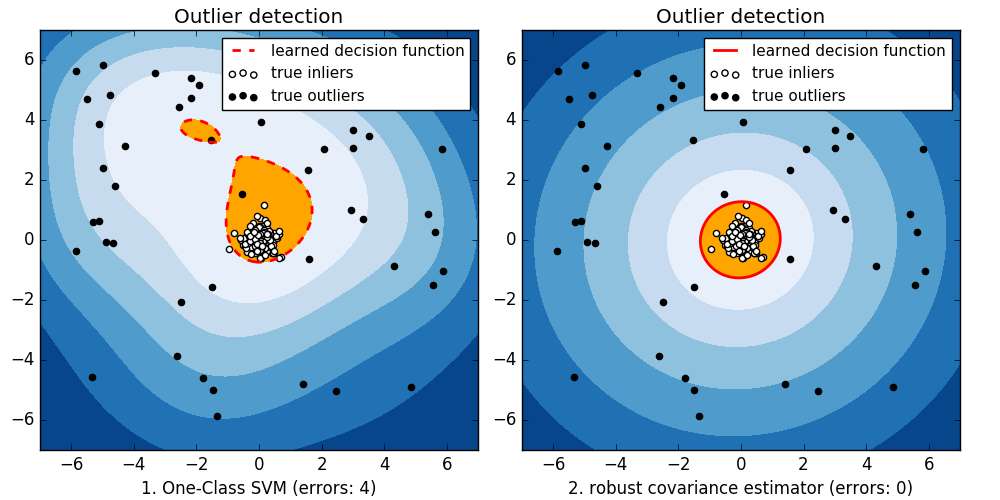

### 2.3.3 使用鲁棒估计器

鲁棒估计器是一种设计用来抵抗异常值影响的统计估计方法。例如,中位数作为位置的估计比平均值更具有鲁棒性,因为它不受极端值的影响。在机器学习中,使用鲁棒损失函数(如Huber损失)的算法能更有效地处理异常值。

在这一章节中,我们从异常值的基本概念出发,逐步介绍了统计学和机器学习中用于检测和处理异常值的传统方法。这些方法为后续章节中介绍的SVM特定策略提供了基础。在下一章节中,我们将深入探讨如何结合SVM的特点,设计出更适用于处理异常值的策略和方法。

# 3. 异常值处理的SVM特定策略

## 3.1 SVM鲁棒性改进算法

### 3.1.1 核技巧与鲁棒核函数

支持向量机(S

0

0