支持向量回归(SVR)入门:预测连续变量的高超技巧

发布时间: 2024-11-20 11:52:11 阅读量: 42 订阅数: 47

svrexample.rar_SVR_回归预测_支持向量回归_支持向量机

# 1. 支持向量回归(SVR)的基础概念

支持向量回归(Support Vector Regression, SVR)是一种基于统计学习理论的回归分析方法,它在处理高维数据以及小样本问题上显示出其特有的优势。SVR的基础思想可以追溯到支持向量机(Support Vector Machine, SVM),但SVR专注于寻找一个超平面来解决回归问题,而不是分类问题。其核心在于寻找最能代表数据分布的超平面,同时允许一定范围内的预测误差。

SVR的基本任务是给定一系列数据点,建立一个模型来预测连续值的输出。它通过最小化结构风险来保证模型的泛化能力,这包括损失函数的选择和正则化参数的应用,这些参数确保模型不会过分复杂,同时能够适应数据的结构。SVR模型的关键在于数据点与预测值之间允许存在一定的误差范围,这个范围被称为ε-不敏感损失。

理解SVR的基础概念对于深入探索其工作原理和应用实践至关重要。在接下来的章节中,我们将详细探讨SVR的工作原理和数学模型,并介绍如何在实际应用中运用SVR解决回归问题。

# 2. 理解支持向量回归的工作原理

## 2.1 支持向量机与回归问题

### 2.1.1 SVM的基本概念和数学原理

支持向量机(SVM)是一种监督学习方法,主要用于分类问题。然而,通过引入“间隔”和“核技巧”的概念,SVM可以扩展到回归分析,形成支持向量回归(SVR)。SVM的目标是找到一个超平面,使得不同类别的数据之间的间隔最大化。在二维空间中,这个超平面是一条线,而在高维空间中,它是一个超平面或超曲面。

数学上,SVM通过解决以下优化问题来找到最佳的分类超平面:

\[

\begin{align*}

\text{minimize} \quad & \frac{1}{2}\|w\|^2 + C\sum_{i=1}^{n}\xi_i \\

\text{subject to} \quad & y_i(w\cdot x_i + b) \geq 1 - \xi_i \\

& \xi_i \geq 0, \quad i = 1, \ldots, n

\end{align*}

\]

其中,\(w\) 是超平面的法向量,\(b\) 是偏置项,\(y_i\) 是类别标签,\(x_i\) 是数据点,\(\xi_i\) 是松弛变量,而 \(C\) 是一个正则化参数,用于平衡模型复杂度和分类间隔。

为了将SVM转化为SVR,核心思想是允许一部分数据点违反间隔限制,即允许一定的误差存在。引入了两个新的松弛变量,\(\epsilon\)-insensitive loss函数被用来测量预测值与实际值之间的偏差,允许预测值在\(\epsilon\)范围内与实际值有偏差而不受惩罚。

### 2.1.2 SVM到SVR的转换

通过修改SVM的优化目标和约束条件,SVM就可以被转换为SVR。对回归问题,SVR的目标变为最小化模型复杂度和预测误差之和。SVR的数学模型可以表示为:

\[

\begin{align*}

\text{minimize} \quad & \frac{1}{2}\|w\|^2 + C\sum_{i=1}^{n}L_{\epsilon}(y_i, f(x_i)) \\

\text{subject to} \quad & f(x_i) = w\cdot \phi(x_i) + b \\

& L_{\epsilon}(y_i, f(x_i)) = \max(|y_i - f(x_i)| - \epsilon, 0)

\end{align*}

\]

在这里,\(L_{\epsilon}\)是\(\epsilon\)-insensitive loss函数,\(\phi\)是核函数映射,用于将数据从输入空间映射到更高维的空间。在这个新的框架下,SVM通过引入误差的\(\epsilon\)-带宽,转变为能够处理连续变量的回归算法。

## 2.2 SVR的数学模型

### 2.2.1 损失函数和核函数的作用

损失函数在SVR模型中起着关键作用,它负责量化预测值与真实值之间的偏差。对于SVR来说,使用的是\(\epsilon\)-insensitive loss函数,该函数定义为:

\[

L_{\epsilon}(y_i, f(x_i)) =

\begin{cases}

0 & \text{if } |y_i - f(x_i)| \leq \epsilon \\

|y_i - f(x_i)| - \epsilon & \text{otherwise}

\end{cases}

\]

这个损失函数的目的是允许在\(\epsilon\)范围内有噪声或异常值的存在而不计算损失,只有当误差超过这个范围时才会计算损失。这种方式使得模型对噪声和异常值具有一定的鲁棒性。

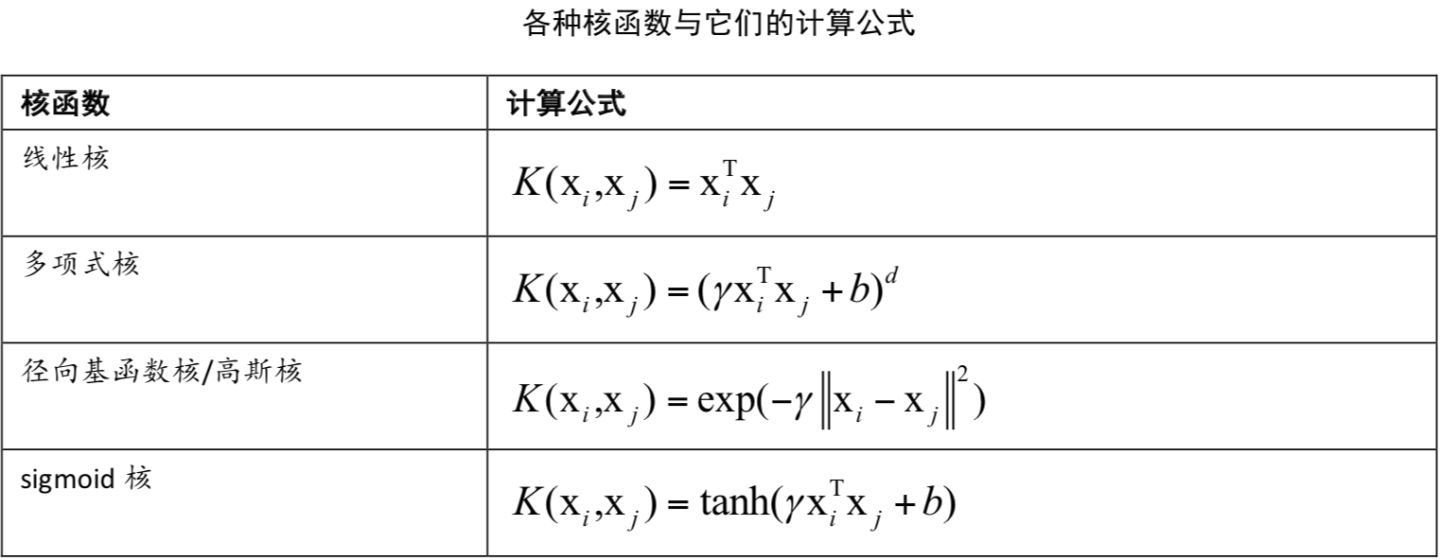

核函数的作用在于将数据映射到高维特征空间,这个空间的维度可能高到直接计算是不现实的。核函数允许在高维空间中计算点积而不需要显式地计算出映射后的数据点。最常用的核函数包括线性核、多项式核、径向基函数(RBF)核和sigmoid核。

### 2.2.2 正则化参数对模型的影响

在支持向量回归中,正则化参数\(C\)是另一个重要的参数,它控制着模型对数据的拟合程度。当\(C\)较大时,模型试图对所有的训练数据都得到尽可能小的误差,这可能会导致过拟合。相反,当\(C\)较小的时候,模型对训练数据的拟合程度会降低,但会提高模型的泛化能力,防止过拟合。

正则化参数\(C\)实际上起到了权衡模型复杂度与训练误差之间关系的作用。选择适当的\(C\)值能够确保模型不会对训练数据中的噪声过分敏感,同时还能保持较好的预测能力。

## 2.3 SVR的优化算法

### 2.3.1 拉格朗日乘数法和对偶问题

在优化支持向量回归的过程中,拉格朗日乘数法被用来将原始问题转换为对偶问题。通过拉格朗日乘数法,原始的优化问题被转换为寻找一组拉格朗日乘数\(\alpha_i\),使得拉格朗日函数最大化。

对于SVR,可以构造拉格朗日函数如下:

\[

L(w, b, \alpha, \xi, \hat{\alpha}) = \frac{1}{2}\|w\|^2 + C\sum_{i=1}^{n}\xi_i - \sum_{i=1}^{n}\alpha_i[y_i(w\cdot x_i + b) - 1 + \xi_i] - \sum_{i=1}^{n}\hat{\alpha}_i\xi_i

\]

其中,\(\alpha_i \geq 0\) 和 \(\hat{\alpha}_i \geq 0\) 是拉格朗日乘数。

通过求解该拉格朗日函数的极值,可以将原始问题转化为对偶问题,这不仅简化了问题,还引入了核函数,允许在高维空间中进行优化。

### 2.3.2 序列最小优化(SMO)算法简介

序列最小优化(SMO)算法是一种用于解决支持向量机和回归问题的有效算法。其基本思想是每次选取两个拉格朗日乘数进行优化,这样每次优化都是一个二次规划问题,可以有效地解决。SMO将大问题分解成小问题的集合,通过优化这些小问题来近似整个问题的最优解。

SMO算法的执行过程包括以下几个步骤:

1. 选择一对需要优化的拉格朗日乘数。

2. 在保证其他拉格朗日乘数不变的情况下,对选定的两个拉格朗日乘数进行优化。

3. 优化这两个拉格朗日乘数,使其满足KKT条件(Karush-Kuhn-Tucker条件)。

4. 重复以上步骤,直到找到满足条件的拉格朗日乘数集合。

SMO算法因其简单、效率高而被广泛应用于支持向量机和回归问题的求解中,它避免了复杂的全局优化问题,并且能够在每次迭代中保证问题的凸性,从而确保找到全局最优解。

# 3. SVR在Python中的实现和实践

## 3.1 使用scikit-learn库进行SVR建模

### 3.1.1 scikit-learn库的安装和基础

scikit-learn是一个开源的Python机器学习库,提供了一系列简单易用的机器学习算法。SVR作为scikit-learn的一部分,使得在Python环境下实现支持向量回归变得非常容易。在开始使用scikit-learn之前,确保已经安装了该库。可以通过pip安装:

```bash

pip install -U scikit-learn

```

安装完成后,可以导入所需的模块来初始化和训练SVR模型。scikit-learn的API设计非常直观,通常分为几个步骤:数据预处理、模型选择、参数设置、模型训练和模型评估。

### 3.1.2 SVR模型的初始化和训练

在scikit-learn中,可以利用 `SVR` 类来创建支持向量回归模型。下面是一个简单SVR模型初始化和训练的例子:

```python

from sklearn.svm import SVR

from sklearn.datasets import make_regression

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

# 创建模拟数据

X, y = make_regression(n_samples=100, n_features=10, noise=0.1, random_state=0)

# 数据标准化处理

scaler = StandardScaler()

X_scaled = scaler.fit_tra

```

0

0