【效率升级】:简化语言模型复杂度,加速语音识别过程

发布时间: 2024-09-07 03:07:52 阅读量: 133 订阅数: 72

基于大规模弱监督的鲁棒语音识别

# 1. 语言模型与语音识别基础

在我们深入探讨语言模型和语音识别技术的优化方法之前,让我们先了解这些技术的基础知识。语言模型是人工智能领域中的一项核心技术,它们可以预测一系列单词或字符出现的概率。这种模型广泛应用于语音识别、机器翻译以及文本生成等多个场景。

## 1.1 语言模型的基本概念

### 1.1.1 语言模型的定义与作用

语言模型的基本作用是赋予一串文字序列一定的概率,该概率体现了给定前文中该序列出现的合理性。在语音识别中,语言模型帮助系统确定一个发音序列最可能对应的文本内容。例如,当语音识别系统听到“今天天气如何”这串语音时,语言模型会预测“如何”后面跟“好”、“差”等词的概率。

### 1.1.2 语言模型的分类和比较

语言模型大致可以分为n-gram模型、隐马尔可夫模型(HMM)和神经网络模型三类。n-gram模型基于统计理论,计算简单,但无法捕捉长距离依赖;HMM模型在早期应用广泛,具有较好的时序处理能力;而神经网络模型,特别是深度学习模型,因其强大的表达能力和上下文信息的提取,近年来已成为主流。

通过这一章节的学习,您将对语言模型和语音识别技术有一个基本的认识,并为后续章节中对这些技术的深入分析和优化打下坚实的基础。在接下来的章节中,我们将探讨语言模型复杂度的影响因素,以及如何通过理论和实践简化这些复杂度,进一步提升语音识别的性能。

# 2. 理解语言模型复杂度

## 2.1 语言模型的基本概念

### 2.1.1 语言模型的定义与作用

语言模型是语音识别和自然语言处理领域的一个基础组件。它的基本任务是给定前文预测下一个词的概率。通过这种方式,语言模型能够辅助计算机理解语言的统计特性,从而提高机器对于自然语言的理解和处理能力。在语音识别中,语言模型用来评估不同词序列的合理性,为识别系统提供一个依据来选择最有可能的句子。

语言模型的作用不仅限于语音识别,还包括文本生成、机器翻译、拼写校正等多个方面。它的核心价值在于为处理语言的歧义性和上下文相关性提供支持。对于语音识别来说,一个高质量的语言模型可以显著提高识别的准确性和流畅性。

### 2.1.2 语言模型的分类和比较

语言模型根据其工作原理可以分为两大类:统计语言模型和神经网络语言模型。

统计语言模型,如 n-gram 模型,通过统计词序列出现的频率来预测下一个词。这类模型的计算简单、速度快,但受限于训练语料库的大小,且无法有效处理长距离依赖问题。

神经网络语言模型,则是通过训练神经网络来捕捉语言的统计特性。神经网络模型能够更好地处理长距离依赖问题,并且随着训练数据规模的增加,其性能通常会不断提高。代表性的模型有循环神经网络(RNN)、长短时记忆网络(LSTM)和变换器(Transformer)。

为了比较这两种类型的模型,我们可以设置一系列基准测试,包括测试集上的困惑度(Perplexity)、实际应用中的准确率和响应时间等指标。

## 2.2 语言模型复杂度的影响因素

### 2.2.1 训练数据的规模与质量

数据是语言模型的基础。模型的性能在很大程度上取决于训练数据的规模和质量。大规模、高质量的语料库可以提供更准确的语言统计特性,有助于构建出更加健壮的模型。

然而,大规模数据的收集、清洗和预处理是一项复杂且耗时的工作。此外,数据集的质量和多样性也直接影响模型的泛化能力。例如,数据中存在的偏见可能导致模型产生不准确的预测。

### 2.2.2 模型架构的设计考量

模型架构的选择对语言模型复杂度有重要影响。一个复杂的模型架构(如Transformer)可能带来更好的性能,但同样会带来更多的参数和更高的计算需求。

在设计模型架构时,需要考虑的因素包括:

- **层数**:增加层数可以增加模型的深度,但也会增加计算成本和过拟合的风险。

- **隐藏单元数**:增加隐藏单元数可以提高模型的容量,但同样会增加训练难度和内存消耗。

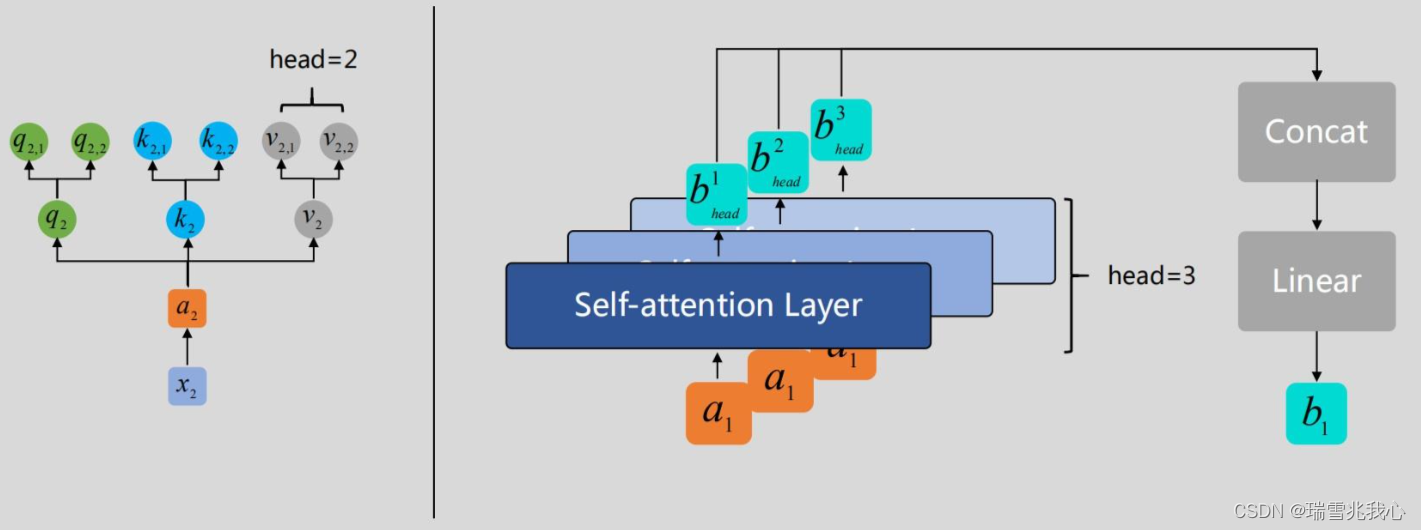

- **注意力机制**:有效的注意力机制可以捕捉长距离依赖,但也显著增加计算负担。

根据具体的应用场景和计算资源,需要在这两者之间做出平衡和权衡。

## 2.3 复杂度对语音识别性能的影响

### 2.3.1 计算资源消耗分析

复杂模型需要更多的计算资源,包括CPU/GPU计算能力、内存以及存储空间等。这些资源的消耗直接影响语音识别系统的部署和运行成本。

为了评估语言模型的计算资源消耗,我们可以进行以下分析:

- **模型参数数量**:参数越多,模型复杂度越高,计算资源需求越大。

- **推理时间**:模型的推理时间直接关系到系统的响应速度,对于实时语音识别尤为重要。

- **能效比**:衡量模型处理单位数据的资源消耗,能效比越高,模型在有限资源下的表现越优秀。

### 2.3.2 识别准确率与速度的权衡

在语音识别系统中,准确率和速度之间存在着一个典型的权衡关系。高准确率通常需要更复杂的模型和更多的计算资源,而高效率的识别又往往要求更快的处理速度。

为了达到这种权衡,我们可以:

- **调整模型结构**:例如,使用轻量级模型或者蒸馏技术。

- **优化算法**:采用高效的算法和数据结构来减少推理时间。

- **资源分配**:在硬件上合理分配资源,例如使用专用的硬件加速器。

不同的应用场景和用户需求会导致权衡结果的差异,因此需要根据实际情况灵活调整。

在这一章节中,我们讨论了语言模型的基本概念,复杂度的影响因素以及复杂度对于语音识别性能的具体影响。从语言模型的定义到架构设计,再到在语音识别中的应用,我们深入分析了计算资源的消耗和性能指标之间的关系,为后续章节的深入探讨打下了坚实的基础。

# 3. 简化语言模型复杂度的理论基础

在构建高效能的语音识别系统时,语言模型复杂度的简化至关重要。通过降低模型的复杂度,可以减少计算资源的需求,加速推理过程,并提升系统的可部署性。本章将深入探讨简化语言模型复杂度的理论基础,包括知识蒸馏与模型压缩技术、轻量级模型结构的研究进展,以及算法优化与计算效率提升的策略。

## 3.1 知识蒸馏与模型压缩技术

### 3.1.1 知识蒸馏的原理与方法

知识蒸馏是一种模型压缩技术,它涉及到将一个大型、复杂的神经网络(教师模型)的知识迁移到一个小型、轻量级的神经网络(学生模型)中。这种方法的目的是通过保持学生模型的性能接近于教师模型,同时显著降低模型复杂度来实现模型压缩。

知识蒸馏的核心在于软化教师模型的输出,也就是让其输出更加平滑。这通常通过在教师模型的软标签(即预测的概率分布)和学生模型的硬标签(即one-hot编码标签)之间建立联系来实现。训练过程中,学生模型不仅学习如何模仿教师模型的预测,还学习如何学习从数据本身学习。

### 3.1.2 模型压缩的策略和效果

模型压缩可以采用多种策略,除了知识蒸馏外,还包括权重量化、剪枝、低秩分解等。每种策略都有其适用场景和压缩效果。

- **权重量化**将模型中的浮点数权重转换成定点数或二进制形式,减少模型大小。

- **剪枝**移除神经网络中不重要的连接或神经元,降低模型复杂度。

- **低秩分解**通过矩阵分解技术降低模型中参数矩阵的秩,减少参数数量。

模型压缩的效果取决于压缩程度与性能损失之间的权衡。在实际应用中,通常需要根据具体需求进行调整,以达到最佳平衡点。

## 3.2 轻量级模型结构的研究

0

0