【多语言挑战】:扩展语音识别语言模型的多语言环境应用

发布时间: 2024-09-07 03:27:09 阅读量: 122 订阅数: 50

# 1. 多语言语音识别的背景与需求

## 1.1 语音识别的发展简史

语音识别技术起源于20世纪50年代,最初依赖于严格规则的模式匹配。随着计算能力的提升和算法的进步,特别是深度学习的突破,它已经取得了显著的发展。如今,语音识别技术已经成为智能助手、自动翻译系统、可穿戴设备等多个领域不可或缺的一部分。

## 1.2 多语言语音识别的必要性

全球化的推进和互联网的普及使得人们迫切需要跨越语言障碍进行交流。多语言语音识别技术能够支持不同语种的实时转换,为不同语言用户带来便利,它对于促进全球交流、商业合作和文化交流具有深远的影响。

## 1.3 技术需求与应用场景

在技术需求层面,多语言语音识别需要高准确性、低延迟,并具备对多变口音和方言的适应能力。应用场景多样,从旅游辅助、医疗沟通到智能客服系统等,都需要该技术来提升服务质量,实现精准的信息传递。

# 2.1 语音信号处理

语音信号处理是语音识别技术的基石,涉及将人类的语音转换为机器可以处理的数字形式。具体而言,处理过程包括语音信号的数字化、特征提取与降维等关键步骤。

### 2.1.1 语音信号的数字化

在现代语音识别系统中,语音信号首先需要被数字化。这涉及到模数转换(A/D),即使用麦克风捕捉声波,并将其转换为电子信号,然后再对这些连续的模拟信号进行采样,量化,并编码成数字形式。这个过程通常包含以下几个关键步骤:

1. **采样**:根据奈奎斯特定理,采样频率应至少为信号最高频率的两倍,以避免混叠现象。在语音识别中,常见的采样频率为8kHz或16kHz。

2. **量化**:量化是将连续幅值的信号离散化的过程。量化级数越多,表示信号的数字表示越精确,但也会导致数字存储的需求更大。

3. **编码**:编码是将量化后的信号转换为计算机可以处理的二进制形式。

```python

import soundfile as sf

import numpy as np

# 读取音频文件

audio_data, samplerate = sf.read('example.wav')

# 采样率转换

new_samplerate = 16000

audio_data_resampled = np.interp(np.arange(0, len(audio_data), 1) * (new_samplerate / samplerate),

np.arange(0, len(audio_data)), audio_data)

# 保存新的采样率音频文件

sf.write('resampled_example.wav', audio_data_resampled, samplerate)

```

在这个简单的示例代码中,首先使用soundfile库读取一个音频文件,然后对数据进行采样率转换,并保存为新的采样率音频文件。这个步骤是将音频数字化处理流程中的一个环节,用于确保在后续处理中,语音信号能够被清晰地转换为机器可处理的数据。

### 2.1.2 特征提取与降维

数字化后的语音信号包含大量的数据,而并非所有这些数据都是对识别任务有用的。特征提取的目的是提取出反映语音本质的、对识别任务有帮助的关键信息。常用的语音特征包括:

- **梅尔频率倒谱系数 (MFCC)**:模仿人类听觉系统的特性,对频率进行非线性映射,并采用离散余弦变换进行降维。

- **线性预测编码 (LPC)**:用于描述声道传输函数的系数。

- **梅尔频谱能量 (MFB)**:基于梅尔滤波器组的能量分布。

降维技术,如主成分分析(PCA)或线性判别分析(LDA),可以进一步减少数据的维度,从而降低计算复杂度并去除冗余信息。

```python

from python_speech_features import mfcc

from sklearn.decomposition import PCA

# 提取MFCC特征

mfcc_features = mfcc(audio_data_resampled, samplerate)

# 应用PCA进行降维

pca = PCA(n_components=13)

mfcc_reduced = pca.fit_transform(mfcc_features)

```

在这段Python代码中,使用了`python_speech_features`库提取了MFCC特征,并利用`sklearn`库中的PCA方法对特征进行降维处理。降维后,数据的处理变得更为高效,同时保留了大部分有助于识别的关键信息。

语音信号处理的每个步骤都是至关重要的,确保后续的语音识别任务能够准确地进行。处理过程的优化同样关系到语音识别系统的整体性能和应用范围。

# 3. 多语言语音识别的实践挑战

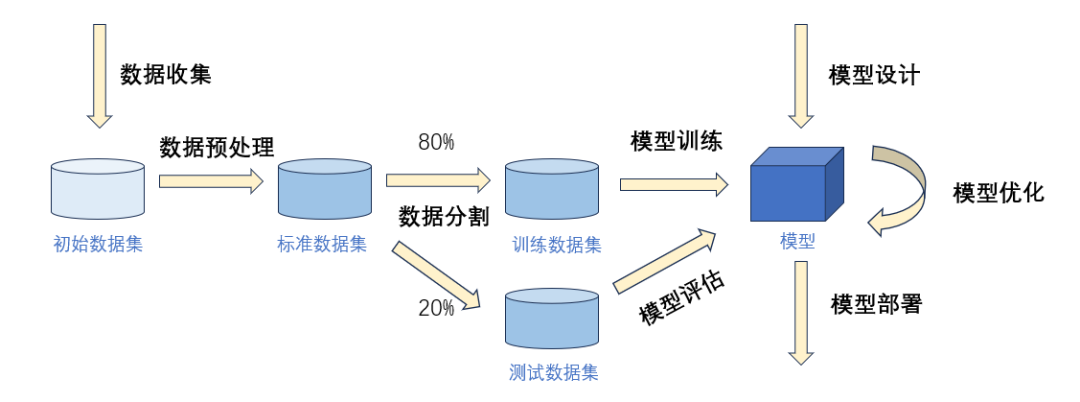

多语言语音识别的实践是一个充满挑战的过程,涉及到数据的收集、模型的训练、系统的优化以及部署和应用。每个步骤都面临特定的问题和技术难点。本章将深入探讨这些实践挑战,并提出应对策略。

## 3.1 多语言数据集的处理

数据是机器学习模型的基石,特别是对于语音识别这种数据驱动型技术。多语言环境下,数据集的处理尤为复杂。

### 3.1.1 数据集的收集与清洗

收集一个全面覆盖所有目标语言的语音数据集是一项艰巨任务。由于各语言使用的广泛程度和数据可获得性的不同,数据集可能存在巨大的不平衡性。为此,必须仔细策划数据收集策略,确保每个语言的样本数量合理,且覆盖不同的口音、方言和语境。

清洗是准备数据集的必要步骤。在多语言数据集的清洗中,需要处理不同的问题,比如删除低质量录音、去除背景噪声、分割过长的语音样本以及标注语音对应的文本。这一阶段,自动化工具和人工审核并用可以大幅提升数据集质量。

### 3.1.2 语言间的差异处理

不同语言在音素、语法和发音习惯上都有很大差异。在多语言语音识别系统中,这些差异会直接影响识别准确度。例如,有些语言可能包含大量的音素,而有些则少得多;有些语言可能有许多无声母或韵母,这都要求识别模型具有高度的灵活性和适应性。

为了解决这些问题,开发人员可能需要采取特定的预处理措施。例如,为不同语言设计不同的特征提取算法或对某些语言采用特定的数据增强技术。此外,创建多语言模型时,采用如多任务学习等策略,可以在一定程度上缓解语言间的差异问题。

## 3.2 模型训练与优化

训练模型是语音识别系统开发中最为关键的步骤之一,而多语言环境给模型训练带来了额外的挑战。

### 3.2.1 多任务学习与迁移学习的应用

多任务学习(MTL)和迁移学习是两种有效的策略,它们允许模型从相关任务中学习知识,以改善性能。在多语言语音识别中,可以将模型训练为同时处理多种语言的任务,从而让模型获得跨语言的特征表示。

迁移学习则可以在已有的单一语言模型基础上进行微调,以适应新的语言环境。例如,使用大量的英文语音数据预训练一个模型,然后在目标语言的较小数据集上进行微调,可以使模型迅速适应新语言。

### 3.2.2 模型优化策略和评估指标

模型优化不仅涉及到算法的选择和参数调整,还包括对模型性能的持续评估。在多语言环境中,需要选取适当的评估指标,这些指标可以准确反映模型在不同语言上的性能。

常用的评估指标包括字错率(WER)和词错率(CER)。值得注意的是,在一些资源较少的语言上,可采用更宽松的评估标准,比如用语义相似度来衡量识别的准确性。

## 3.3 部署与应用扩展

部署是将模型变为可用产品或服务的过程,而应用扩展则是指针对特定需求进行模型的定制化调整。

### 3.3.1 语音识别系统的部署方式

语音识别系统可以通过本地部署或云服务方式提供。本地部署通常需要较高的硬件要求,但可保证数据隐私。而云服务部署则需要较少的本地计算资源,但需要考虑数据传输的安全性和隐私保护。

在部署过程中,开发者需要考虑系统的可扩展性、稳定性和维护成本。容器化和微服务架构是近年来的流行趋势,它们可以简化部署过程,提高系统的灵活性和可维护性。

### 3.3.2 针对不同语言环境的定制化调整

为了满足不同语言环境下的使用需求,开发者需要为每个环境定制化调整模型。这包括对不同语种的词汇库、发音规则和语境进行优化。针对特定环境进行调整,比如嘈杂的背景或者具有独特口音的说话者,能够显著提高系统的识别率。

定制化调整通常需要频繁的迭代和现场测试。利用A/B测试等方法,可以比较不同调整方案的性能,并选择最优方案。

综上所述,多语言语音识别在实践过程中的确存在许多挑战,但是通过合理的数据处理、模型训练优化以及精确的部署与应用,这些挑战是可以被有效克服的。随着技术的不断进步,未来的多语言语音识别系统将变得更加智能和通用,为全球用户提供更为精准和便捷的语音服务。

# 4. 多语言语音识别的案例分析

### 4.1 商业领域的应用实例

在商业领域,多语言语音识别技术的应用已经深入到客服系统和会议记录等多个方面,极大地提高了企业运营效率和国际竞争力。

#### 4.1.1 客服系统中的多语言支持

随着全球化的发展,企业面对的客户群体越来越多元化,这要求客服系统必须具备多语言支持能力。例如,一家跨国公司可能需要为其客户提供英语、汉语、西班牙语等多种语言的服务。传统的客服系统依赖于人工翻译或预录好的语音回答,但这些方式在处理大量且多样化的客户咨询时显得力不从心。多语言语音识别技术的引入,使得客服系统能够实时地将客户的语音咨询转换成文本,并通过机器翻译将回答同样转换成客户所使用的语言,从而实现了高效、准确的自动应答。

实现这一功能,通常涉及以下几个关键步骤:

1. 语音信号的捕捉与数字化,将客户的语音咨询通过麦克风接收并转换成数字信号。

2. 利用自动语音识别(ASR)技术将数字信号转换成文本。

3. 应用自然语言处理(NLP)技术理解文本的语义,并查询相应的FAQ或知识库。

4. 将回答的文本通过机器翻译转换成目标语言。

5. 最后,再通过语音合成技术(TTS)将文本回答转换成语音反馈给客户。

这里是一个简化的伪代码示例,展示如何实现多语言客服系统的一个关键部分:

```python

import speech_recognition as sr

from googletrans import Translator

from gtts import gTTS

# 初始化语音识别器和翻译器

recognizer = sr.Recognizer()

translator = Translator()

# 识别英语语音输入并转换为文本

def english_to_text(english_audio_file):

with sr.AudioFile(english_audio_file) as source:

audio_data = recognizer.record(source)

try:

text = recognizer.recognize_google(audio_data, language='en-US')

return text

except sr.UnknownValueError:

return "无法理解音频"

except sr.RequestError:

return "语音服务请求失败"

# 示例:将英语文本翻译成西班牙语并朗读

def translate_and_speak(text, dest_language='es'):

translation = translator.translate(text, dest=dest_language)

tts = gTTS(text=translation.text, lang=dest_language)

tts.save("translated_audio.mp3")

return "已保存翻译后的语音文件"

# 假设有一个英文语音文件

english_audio_file = 'customer_audio_en.wav'

text_from_audio = english_to_text(english_audio_file)

spoken_translation = translate_and_speak(text_from_audio)

print("原文本:", text_from_audio)

print("朗读翻译:", spoken_translation)

```

在这个示例中,我们使用了`speech_recognition`库来识别语音信号并转为文本,使用`googletrans`库进行文本翻译,最后使用`gtts`库将翻译后的文本转化为语音文件。这个过程展示了多语言客服系统中处理语音和文本的核心步骤。

#### 4.1.2 多语言会议记录系统

会议记录系统对于捕捉会议要点并提供可搜索的记录至关重要。多语言会议记录系统通过实时语音识别技术,将会议发言实时转录为文字记录,并且能够识别不同发言者的语音,区分记录发言内容。

一个会议记录系统需要考虑的要点包括:

- 实时语音识别(实时转写)

- 多人语音分离(区分不同发言者)

- 语音与文本的时间同步(便于后续回溯)

- 搜索功能(通过关键词快速找到记录内容)

这里是一个处理多语言会议记录系统的伪代码示例:

```python

# 这个示例用Python代码模拟一个简化版的会议记录系统

import speech_recognition as sr

class MultiLanguageMeetingRecorder:

def __init__(self, languages):

self.recognizer = sr.Recognizer()

self.languages = languages

self.transcribed_text = {}

def start_recording(self, audio_so

```

0

0