【深度学习革命】:探索深度学习在语音识别语言模型中的最新应用

发布时间: 2024-09-07 03:04:25 阅读量: 132 订阅数: 72

# 1. 深度学习与语音识别语言模型简介

## 深度学习的发展简史

深度学习作为机器学习的一个分支,近年来在语音识别领域取得了突破性的进展。它的核心是通过构建多层的神经网络,以模拟人脑处理信息的方式。自从2006年Hinton等人提出“深度学习”这一术语以来,该领域经历了从初期的理论探索到如今的广泛应用,特别是在语音识别和自然语言处理(NLP)方面。

## 语音识别语言模型的重要性

语音识别语言模型是理解人类语音并转换为可读文本的关键技术。这不仅涉及到声音信号的捕获、分析和解码,还包含了对语言的深入理解。语音识别技术的进步极大地推动了智能设备、虚拟助手和自动化服务的发展,为用户提供更加自然和直观的人机交互方式。

## 深度学习与传统方法的对比

传统的语音识别系统依赖于手工设计的特征和复杂的规则系统,但这种方法限制了系统的灵活性和适应性。而深度学习技术引入了端到端的学习模式,能够自动从数据中学习到复杂的特征表示,显著提高了识别准确率和系统的鲁棒性。因此,在当今的语音识别应用中,深度学习已经成为一种主流技术。

# 2. 深度学习的基础理论

## 2.1 神经网络基础

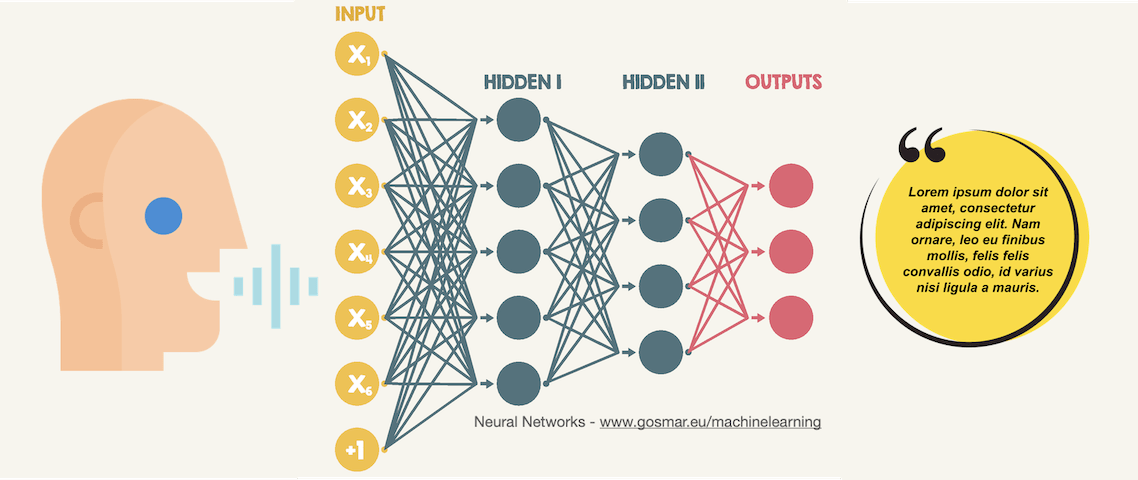

### 2.1.1 神经元和激活函数

神经网络是由许多简单计算单元(神经元)构成的大规模并行处理系统,通过学习数据特征和模式来实现复杂的任务。在深度学习的语境中,神经元是模型的基础构件,它接收输入,执行加权求和操作,并通过一个激活函数来产生输出。激活函数的目的是引入非线性因素,使得神经网络可以模拟非线性复杂关系。

在众多激活函数中,ReLU(Rectified Linear Unit)是深度网络中最为常用的,其函数表达式为 `f(x) = max(0, x)`。这种函数的非线性特性使得网络能够学习和执行复杂的任务,而其计算效率较高,是深度学习得以快速发展的关键因素之一。

```python

def relu(x):

return np.maximum(0, x)

```

该Python函数定义了一个简单的ReLU激活函数,通过`numpy`库提供的`maximum`函数实现非负值的选择。激活函数对于输入的处理方式,直接影响了神经网络的学习能力和效率,是构建高效网络模型的重要组成部分。

### 2.1.2 前馈神经网络和反向传播算法

前馈神经网络(Feedforward Neural Network, FNN)是最基本的神经网络类型,其信息流向单一,从输入层经过隐藏层,最终到达输出层。在前馈神经网络中,每个神经元的输出仅与下一层的神经元相连,形成一个无环的有向图。

为了训练这些网络,我们需要一个有效的算法来更新网络权重,这就是反向传播算法(Backpropagation)。反向传播算法通过计算输出误差关于网络参数的梯度,然后沿着梯度反向更新参数,从而最小化网络的损失函数。

```python

# 伪代码示例:反向传播算法的一个环节

# 假设activations为神经元激活值,deltas为误差项,weights为权重

for i in range(len(weights)):

weights[i] -= learning_rate * activations[i] * deltas[i]

```

在代码中,`learning_rate`是一个超参数,控制着梯度下降步长的大小。通过迭代地调整权重,网络可以学习到如何根据输入数据产生正确的输出。

## 2.2 深度学习高级模型

### 2.2.1 卷积神经网络(CNN)

卷积神经网络(Convolutional Neural Networks, CNNs)是深度学习领域一个非常重要的进展,特别是对于图像识别和处理领域。CNN的核心是卷积层,它利用卷积核(filter)对输入数据进行特征提取,能够有效利用空间层级结构。

卷积层通过卷积操作捕捉局部特征,然后通过池化层(Pooling Layer)减少数据维度并提取最重要的特征,进一步通过全连接层(Fully Connected Layer)进行分类或回归分析。CNN在视觉任务中的成功,也促使研究者尝试将其应用到序列数据处理上,例如语音识别。

### 2.2.2 循环神经网络(RNN)

循环神经网络(Recurrent Neural Networks, RNNs)是深度学习中处理序列数据的关键技术。与传统的FNN不同,RNN能够处理可变长度的输入数据,并且拥有记忆能力,可以维持和利用历史信息。

RNN通过隐藏状态来传递信息,使得网络能够捕捉序列中的时间依赖性。由于梯度消失或梯度爆炸的问题,传统RNN在长序列上的表现受限,但通过长短期记忆网络(LSTM)和门控循环单元(GRU)等变种,RNN在语音识别等任务中得到了有效的应用。

### 2.2.3 长短时记忆网络(LSTM)

长短时记忆网络(Long Short-Term Memory Networks, LSTMs)是RNN的一个重要变种,它通过引入记忆单元和门控机制有效缓解了传统RNN在长期依赖关系建模上的不足。LSTM包含三个门:遗忘门(forget gate)、输入门(input gate)、输出门(output gate),它们共同决定信息的存储和输出。

LSTM通过这些门控机制解决了长期依赖问题,因此在处理语音识别等需要记忆和长序列数据的场景中表现优异。如下是一个简化的LSTM单元的伪代码:

```python

def lstm_cell(input, state):

forgetgate = sigmoid(Wf @ input + Uf @ state + bf)

inputgate = sigmoid(Wi @ input + Ui @ state + bi)

cellgate = tanh(Wc @ input + Uc @ state + bc)

outputgate = sigmoid(Wo @ input + Uo @ state + bo)

# 计算细胞状态和隐藏状态

cell_state = forgetgate * state + inputgate * cellgate

hidden_state = outputgate * tanh(cell_state)

return hidden_state, cell_state

```

在这段代码中,`sigmoid` 和 `tanh` 是激活函数,`@` 表示矩阵乘法。LSTM的核心是细胞状态的更新,这个状态可以随时间传递信息。LSTM在语音识别语言模型中占据了重要的地位,尤其是在需要理解上下文的复杂语音任务中。

## 2.3 损失函数与优化算法

### 2.3.1 损失函数的选择和应用

损失函数(Loss Function),也称为代价函数,是衡量模型预测值与真实值之间差异的一个指标。在语音识别领域,损失函数的选择至关重要,因为这直接关系到模型能否准确地理解和处理语音信号。

交叉熵损失函数(Cross-Entropy Loss)是深度学习中最常用的损失函数之一,特别是在多类分类问题中。交叉熵损失函数可以提供一个较小的梯度,使得模型的学习效率更高,收敛速度更快。

```python

def cross_entropy_loss(y_true, y_pred):

return -np.sum(y_true * np.log(y_pred))

```

该函数计算了两个概率分布之间的交叉熵,其中`y_true`是真实标签的概率分布,`y_pred`是模型预测的概率分布。为了优化这个损失函数,我们通常使用梯度下降算法或其变体,如随机梯度下降(SGD)。

### 2.3.2 优化算法详解

优化算法是深度学习中另一个核心组成部分,它负责更新模型参数以最小化损失函数。优化算法通过选择适当的参数更新规则,来指导模型学习数据中的复杂模式。

在深度学习中,常用的优化算法包括SGD、动量优化(Momentum)、自适应学习率优化算法如Adam和RMSprop。其中,Adam算法因其对学习率的自适应调整和动量项的引入,被广泛认为是一个鲁棒的优化器。

```python

def adam_optimizer(params, grads, exp_avg, exp_sq_avg, t, lr=0.001, beta1=0.9, beta2=0.999, epsilon=1e-8):

exp_avg *= beta1

exp_avg += (1 - beta1) * grads

exp_sq_avg *= beta2

exp_sq_avg += (1 - beta2) * grads**2

bias_correction1 = 1 - beta1**t

bias_correction2 = 1 - beta2**t

step = lr * exp_avg / (np.sqrt(exp_sq_avg) / bias_correction2 + epsilon)

params -= step

return params, exp_avg, exp_sq_avg

```

该函数展示了Adam算法的基本思想,其中`t`是迭代次数,`params`和`grads`分别是模型参数和参数的梯度。Adam算法通过维护两个移动平均估计梯度的一阶矩估计和二阶矩估计(即动量项和修正项),来实现参数的更新。

在选择适当的优化算法时,我们必须考虑模型的规模、数据集的大小以及问题的性质。优化算法的性能不仅影响模型训练的速度,还可能影响到模型的最

0

0