【领域迁移】:应用语音识别语言模型于不同领域的策略

发布时间: 2024-09-07 03:33:29 阅读量: 102 订阅数: 72

语音识别:原理与应用-课件pdf_202101.rar

# 1. 语音识别语言模型概述

在当今快速发展的IT行业,语音识别技术已经成为了人机交互的重要桥梁。语音识别语言模型,作为这一技术的核心,致力于提升识别的准确性和效率。本章将从语言模型的基础理论讲起,细致地解析其作用与工作原理,并探讨如何在实际应用中进行优化。

## 1.1 语言模型的定义和重要性

语言模型是语音识别系统的关键组成部分,其主要任务是对给定的词序列进行概率估计。简单来说,它预测了某个词序列在真实语言中出现的可能性,这直接决定了语音识别的准确度。

## 1.2 应用场景与技术要求

语言模型广泛应用于智能助手、自动翻译、语音搜索等领域,其性能要求通常与应用场景密切相关。例如,在医疗语音识别中,就需要能够准确识别专业术语的模型。

## 1.3 技术挑战与发展趋势

语音识别语言模型面临的挑战包括数据的多变性、噪声干扰、用户方言等问题。未来,随着深度学习技术的不断进步,语音识别模型将更加精确,更贴近自然语言处理的语境理解。

通过以下章节的深入探讨,我们可以进一步理解如何应对这些挑战,并在实践中不断优化语音识别系统。

# 2. ```

# 第二章:领域迁移的理论基础

## 2.1 领域迁移的定义和重要性

### 2.1.1 领域迁移的概念解析

领域迁移(Domain Adaptation)是机器学习领域中的一个关键概念,其核心目标是解决当模型在某一特定领域上训练得到后,如何有效地应用到另一个相关但不完全相同的领域上的问题。领域迁移的重要性在于,现实世界中的数据往往分布不均,单一领域的数据集可能无法满足实际应用需求,或无法覆盖所有潜在的使用场景。通过领域迁移,可以使得在特定任务上训练有素的模型能够适应新的环境,减少对大量标注数据的依赖,从而降低开发成本和提高模型的泛化能力。

### 2.1.2 领域迁移在语音识别中的作用

在语音识别领域,模型的泛化能力尤其重要。由于每个人的发音、语速、口音存在差异,加之不同的应用场景(如呼叫中心、智能家居、车载系统等)有着不同的背景噪声和词汇范围,使得模型在面临多样化的语音数据时往往需要进行调整。领域迁移技术允许模型将在一个领域学到的知识迁移到另一个领域,以应对这些挑战。在现实应用中,领域迁移可以显著提高模型在不同领域中的准确度和鲁棒性,例如,一个在标准语音数据集上训练的模型,通过领域迁移可以提高在嘈杂环境或者特定口音环境下的识别率。

## 2.2 领域适应理论

### 2.2.1 适应性学习的基本原理

适应性学习(Adaptive Learning)通常依赖于无监督或半监督学习的框架,旨在处理源领域和目标领域分布不一致时的问题。这种不一致可能是由于领域特定的属性、噪声、标注错误等因素造成的。适应性学习的基本原理包括学习一个领域不变的表示,使得源领域和目标领域的数据共享相似的特征空间,并在此基础上进行分类或回归等任务。通过减少领域间的分布差异,使得模型能够更好地适应新的领域。

### 2.2.2 领域适应的技术方法

领域适应技术方法涉及多种策略,从简单的实例重权(instance re-weighting)到复杂的特征转换(feature transformation),再到使用生成模型(generative models)来模拟数据分布。一个常见的方法是领域对抗训练(Domain Adversarial Training),通过引入一个领域判别器(domain discriminator),使得模型在学习任务的同时,难以区分数据是来自源领域还是目标领域。这样迫使模型学习到更加领域不变的特征表示。另一个值得注意的技术是迁移成分分析(Transfer Component Analysis,TCA),它通过核方法和统计分析减少源域和目标域之间的分布差异。

## 2.3 语言模型的预训练与微调

### 2.3.1 预训练语言模型的原理

预训练语言模型,如BERT、GPT等,已经成为自然语言处理任务中的主流技术。这些模型通常在一个大规模、多领域的语料库上进行预训练,学习到丰富的语言知识和通用表示。预训练的目的在于捕捉语言的深层语义和句法信息,为后续的特定任务提供强大的基础。通过在预训练模型的基础上进行微调,可以在目标任务上达到更好的性能,而无需从头开始训练一个模型。在微调过程中,模型的大部分参数将根据目标任务的特定需求进行调整,从而使得模型能够适应新的领域。

### 2.3.2 微调策略及其效果评估

微调策略需要精心设计,以确保模型能够在保持泛化能力的同时,适应新任务的需求。一个常见的微调策略是结合不同比例的源领域和目标领域的数据,这样可以帮助模型在保持已学到的知识的同时,逐渐适应新领域。评估微调的效果时,通常使用目标领域的数据集,并关注以下几个指标:准确度、召回率、F1分数等。此外,通过比较微调前后模型在目标任务上的表现,可以直观地看到微调带来的性能提升。不同的微调方法和策略,如全网络微调、参数冻结和学习率调整等,将在实践中对模型效果产生显著影响。

```

# 3. 实践中的领域迁移应用

实践是检验真理的唯一标准,领域迁移技术的实践应用对于语音识别领域尤为重要。本章将深入探讨基于迁移学习的模型调整、多领域数据融合技术以及模型评估与优化的方法。

## 3.1 基于迁移学习的模型调整

迁移学习是机器学习中的一种方法,它允许模型将在一个任务上学到的知识应用到另一个相关任务上。在语音识别领域,这通常意味着将从大量通用语言数据上训练好的模型,调整为适用于特定领域的模型。

### 3.1.1 调整模型的参数选择

在迁移学习中,模型参数的选择对于模型的适应性和性能至关重要。通常情况下,我们不需要从头开始训练模型,而是可以通过调整模型部分或全部的权重来适应新的任务。

**关键参数调整:**

- **学习率**:调整学习率可以控制参数更新的速度。在迁移学习中,通常使用较小的学习率以避免破坏已经学习到的知识。

- **权重衰减**:通过权重衰减,可以抑制模型学习过程中的过拟合现象。

- **Dropout比率**:在训练过程中随机丢弃一部分神经元,可以提高模型的泛化能力。

**代码示例与逻辑分析:**

```python

import torch

from transformers import BertForSequenceClassification, BertTokenizer

# 加载预训练模型和分词器

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

# 假设我们要将模型从文本分类任务迁移到语音识别任务

# 冻结模型中的所有参数,防止训练过程中的更新

for param in model.parameters():

param.requires_grad = False

# 仅修改分类层的参数

model.classifier.weight.requires_grad = True

model.classifier.bias.requires_grad = True

# 定义训练器

optimizer = torch.optim.AdamW(model.classifier.parameters(), lr=1e-5)

# 评估和优化模型的代码省略,参见实际训练代码部分...

```

**参数说明与逻辑分析:**

- `BertForSequenceClassification`是基于BERT模型进行序列分类的预训练模型。

- `BertTokenizer`是用来处理文本数据的分词器。

- 我们通过`requires_grad`来控制哪些参数在训练时可以更新。通常情况下,我们会冻结基础模型的参数,只对最后的分类层进行微调。

- 学习率被设置为`1e-5`,这是一个较小的学习率,以适应预训练模型参数微调的需求。

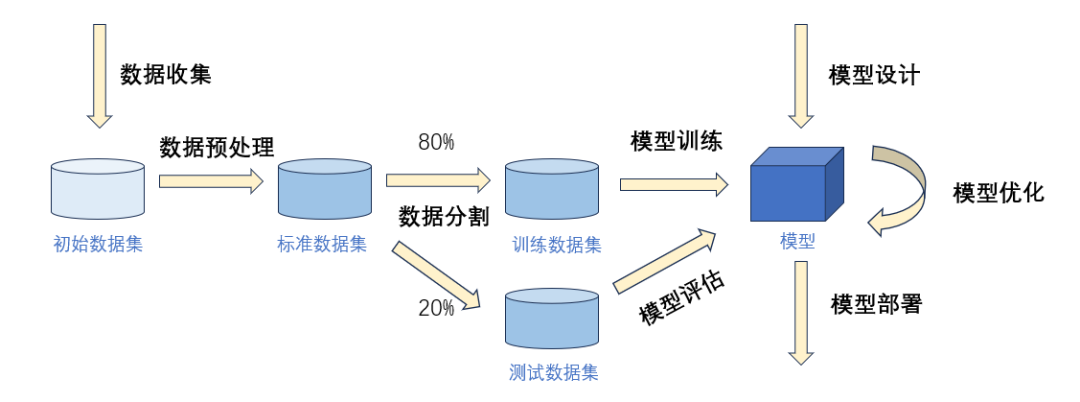

### 3.1.2 实例:从通用领域到特定领域的迁移

在实际应用中,领域迁移技术通常涉及到从一个领域的通用数据集(如新闻报道)迁移到一个特定的数据集(如医疗或法律领域的语音数据)。

**操作步骤:**

1. **数据准备**:准备通用领域和特定领域的数据集。

2. **预处理**:对两个领域的数据集进行相同的预处理步骤,以便后续可以进行迁移学习。

3. **模型选择**:选择一个适合通用领域任务的预训练模型。

4. **模型微调**:在特定领域数据上微调模型,通常只更新部分层。

5. **评估**:使用验证集评估模型的性能,确保模型具有良好的泛化能力。

**案例分析:**

假设我们有一个医疗领域的语音数据集,目标是从医生的临床咨询中识别特

0

0