【可扩展哈希表构建】:编程实战,构建一个适应未来需求的哈希表

发布时间: 2024-09-13 22:58:45 阅读量: 67 订阅数: 35

# 1. 可扩展哈希表的基本概念和原理

在信息存储与检索领域,哈希表是最基本且广泛应用的数据结构之一。它通过哈希函数将键映射到表中的位置,以实现快速的数据访问。本章将概述可扩展哈希表的核心概念,包括其基本原理和如何高效地实现快速键值对的映射。

## 1.1 哈希表的定义及其优势

哈希表是一种通过哈希函数进行数据存储的数据结构,它能够实现平均情况下常数时间复杂度(O(1))的查找、插入和删除操作。这种高效性能使得哈希表成为处理大量数据的首选数据结构。

## 1.2 哈希函数的作用与设计考量

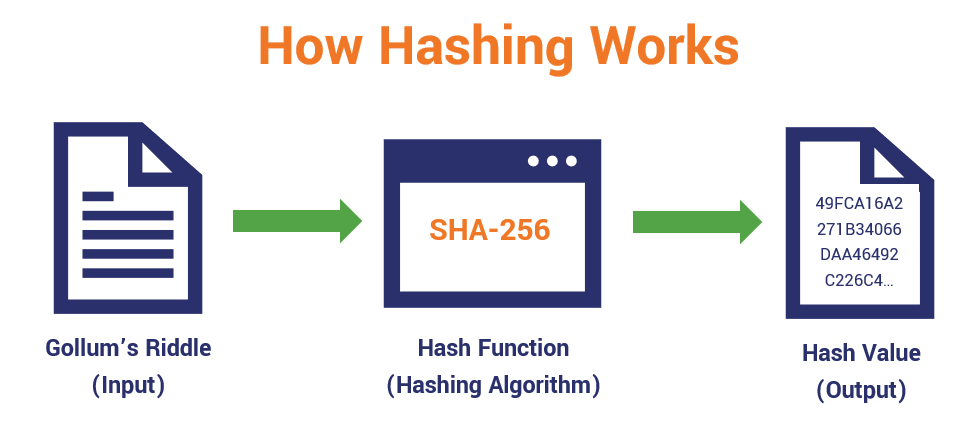

哈希函数是哈希表的核心组成部分,负责将输入的键转换成表内的索引位置。设计一个好的哈希函数需要考虑到均匀分布性和计算效率,以减少键的冲突和提升访问速度。

## 1.3 可扩展性的必要性

随着数据量的不断增加,哈希表需要扩展其容量以保持性能。可扩展哈希表通过动态调整表大小和重新分配数据来适应负载变化,这是实现高效数据处理的关键。

```mermaid

graph TD

A[开始] --> B[定义哈希表]

B --> C[讨论哈希函数]

C --> D[探讨可扩展性]

D --> E[总结基本概念和原理]

```

通过上述内容,我们确立了哈希表在数据处理中的基础地位,了解了哈希函数设计的重要性,以及可扩展性对于维持哈希表性能的必要性。接下来的章节将深入探讨哈希表设计的各个方面,为构建高效的哈希表打下坚实的基础。

# 2. 哈希表数据结构的设计与实现

## 2.1 哈希函数的选择与设计

### 2.1.1 哈希函数的理论基础

哈希函数是哈希表设计中的核心组件,其主要职责是将输入(通常是键)转换为一个整数,这个整数会作为数组的索引。理想的哈希函数应该满足以下条件:

- **一致性**:相同的输入值必须映射到相同的索引。

- **高效性**:计算速度快,时间复杂度低。

- **均匀分布**:尽量使输出索引在整个数组中均匀分布,以减少冲突。

设计哈希函数时,常见的理论基础包括模运算、乘法取余以及特定的哈希算法,如MurmurHash、CityHash等。模运算和乘法取余是最基础的哈希方法,但它们很容易受到输入数据特征的影响。高级哈希算法则通过更复杂的计算来提高分布的随机性和均匀性。

### 2.1.2 不同哈希函数的性能对比

不同哈希函数在性能上存在差异,主要表现在速度、均匀性以及对特定输入的鲁棒性上。下面是一个比较不同哈希函数的示例:

- **线性探查法(Linear Probing)**:简单快速,但在高负载下性能下降严重。

- **双哈希法(Double Hashing)**:提供了比线性探查法更好的均匀性,但实现复杂度较高。

- **一致性哈希法(Consistent Hashing)**:特别适合分布式系统,能够有效减少节点变更带来的数据迁移。

```mermaid

graph TD

A[开始] --> B[选择哈希函数]

B --> C[线性探查法]

B --> D[双哈希法]

B --> E[一致性哈希法]

C --> F[速度快,均匀性一般]

D --> G[速度较慢,均匀性好]

E --> H[特别适合分布式系统]

```

在性能对比中,需要通过实际数据进行测试,例如,可以通过构建一个含有大量随机键的哈希表,并插入元素来观察不同哈希函数的冲突率和性能表现。代码块提供了使用不同哈希函数的示例:

```python

def linear_probing_hash(key, table_size):

return key % table_size

def double_hashing_hash(key, table_size, hash2):

return (key * hash2) % table_size

def consistent_hashing(key, num_slots):

return hash(key) % num_slots

# 测试

keys = [random_key() for _ in range(10000)]

table_size = 1024

# 使用线性探查法插入数据

for key in keys:

index = linear_probing_hash(key, table_size)

# ...插入逻辑...

# 使用双哈希法插入数据

hash2 = 17

for key in keys:

index = double_hashing_hash(key, table_size, hash2)

# ...插入逻辑...

# 使用一致性哈希法插入数据

num_slots = 100

for key in keys:

index = consistent_hashing(key, num_slots)

# ...插入逻辑...

```

上述代码示例中,通过定义不同的哈希函数并测试它们插入键值的过程,可以观察到不同的性能表现。

## 2.2 哈希表的冲突解决机制

### 2.2.1 开放寻址法与链地址法的优劣分析

哈希表中冲突的解决机制主要有开放寻址法(Open Addressing)和链地址法(Chaining)两种。每种方法都有其优缺点:

- **开放寻址法**通过在表中寻找下一个空闲位置来解决冲突,包括线性探查、二次探查和双散列等。这种方法的优点在于实现简单,且访问速度快,因为所有的数据都存储在数组内。缺点是当表中数据量增大时,冲突的概率会上升,导致性能下降。

- **链地址法**则是在数组的每个位置上存放一个链表,所有的冲突数据都插入到链表中。这种方法的优点在于不会随着表中元素的增加而导致性能急剧下降,因为链表总是可以不断扩展。缺点是需要额外的空间来存储指针,从而增加了空间复杂度。

在实际应用中,选择哪种冲突解决机制,需要根据应用场景的需求来决定。例如,如果内存资源有限,可能更倾向于使用开放寻址法;如果对性能有较高要求,尤其是高并发环境下,链地址法可能更合适。

### 2.2.2 高级冲突解决策略

随着技术的发展,研究人员提出了多种高级的冲突解决策略,以改善传统方法的缺陷,或者结合两种方法的优点。例如:

- **Cuckoo Hashing**:允许两个键共享一个槽位,如果键不在其槽位上,则通过“踢出”机制来解决冲突。这种方法有着较高的存储效率和良好的平均性能。

- **Hopscotch Hashing**:提供了一个折衷方案,它允许在一定的“跳跃”范围内处理冲突,减少了数据迁移。

- **Robin Hood Hashing**:通过调整插入元素的位置,保证所有键的平均查找距离尽可能短。

以下是使用Robin Hood Hashing的代码示例:

```python

class RobinHoodHash:

def __init__(self, capacity):

self.capacity = capacity

self.size = 0

self.keys = [None] * capacity

self.probes = [0] * capacity

def insert(self, key):

index = hash(key) % self.capacity

while self.keys[index] is not None:

if self.probes[index] < self.probes[self.keys[index]]:

# 将已存在的键向后移动,为新键腾出空间

swap_index = index

index = self.keys[index]

self.keys[index] = swap_index

self.probes[swap_index], self.probes[index] = self.probes[index] + 1, self.probes[swap_index] + 1

else:

# 如果现有键的查找距离更短,插入失败

return False

if index == hash(key) % self.capacity:

# 如果回到了初始位置,则表已满

return False

self.keys[index] = key

self.probes[index] = 0

self.size += 1

return True

def get(self, key):

index = hash(key) % self.capacity

for i in range(self.capacity):

if self.keys[index] is None or self.keys[index] == key:

return self.keys[index]

index = (index + 1) % self.capacity

return None

# 示例

rh = RobinHoodHash(100)

rh.insert('key1')

rh.insert('key2')

```

代码中定义了一个简单的Robin Hood Hashing实现,包括插入和获取键的操作。它通过比较和调整已有的键来保持查找距离的平衡。

## 2.3 动态扩容机制的实现

### 2.3.1 扩容策略与时机的确定

随着数据量的增加,哈希表的负载因子(通常定义为元素数量与表大小的比值)会上升,导致冲突的概率增加,进而影响性能。动态扩容是解决这一问题的重要机制。扩容的策略主要包括以下几点:

- **动态扩容的时机**:当负载因子超过某个阈值时,例如0.75或1时,触发扩容。过早扩容可能会浪费内存,过晚则可能影响性能。

- **扩容的步长**:扩容时,表大小的增加步长也有讲究。有的哈希表实现选择增长到原来的2倍,有的选择增长到原来的1.5倍。步长的选择会影响到扩容过程中的性能和负载因子的调整。

### 2.3.2 扩容过程中的数据迁移策略

在扩容过程中,需要将旧数组中的数据迁移到新的、更大的数组中。这一过程应尽量高效,并避免长时间锁定哈希表导致的访问延迟。常见的数据迁移策略有:

- **顺序迁移**:逐个将旧数组中的元素迁移到新数组中。这种方法简单直接,但在元素数量较多时效率较低。

- **并行迁移**:利用现代多核CPU的并行处理能力,将数据迁移到新数组中。这种方法可以显著缩短迁移时间,但需要处理好并发带来的同步问题。

下面是一个简单的顺序迁移代码示例:

```python

def resize_table(self):

old_keys = self.keys

old_size = len(old_keys)

new_size = old_size * 2

self.keys = [None] * new_size

self.size = 0

f

```

0

0