【大数据挑战应对】:哈希表在海量数据处理中的应用策略

发布时间: 2024-09-13 22:17:56 阅读量: 109 订阅数: 38

大数据技术在储层改造中的应用.pdf

# 1. 大数据背景与哈希表简介

## 1.1 大数据时代的崛起

随着信息技术的飞速发展,数据的产生和积累速度前所未有。大数据不只是海量的数据集合,它更代表着处理速度、多样性和价值密度等多维挑战。这一切都为哈希表这类快速查找技术的发展提供了广阔的舞台。

## 1.2 哈希表的定义与功能

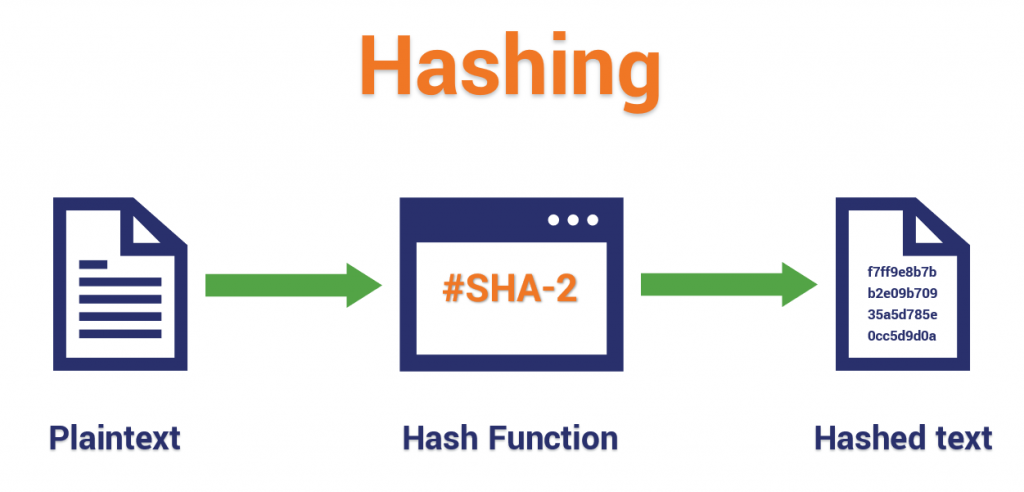

哈希表是一种数据结构,它通过一个哈希函数将键(key)映射到一个位置来存储数据,从而实现快速的查找。哈希表的关键在于通过哈希函数将大数据集中的元素映射到有限大小的表中。

## 1.3 哈希表的必要性

在大数据的背景下,哈希表提供的高速数据访问能力,对于实现高效的搜索、存储和管理任务至关重要。随着应用场景的多样化,如何优化哈希表以适应不断增长的数据量和访问频率,已成为业界关注的重点。

```mermaid

graph LR

A[大数据时代] --> B[海量数据处理]

B --> C[哈希表需求增长]

C --> D[哈希表优化与应用]

```

通过本章,我们将了解哈希表的基本概念及其在大数据背景下的重要性,并为接下来的章节奠定基础。

# 2. 哈希表基础与数据结构

## 2.1 哈希表的基本原理

### 2.1.1 哈希函数与映射机制

哈希表是一种广泛应用于计算机科学中的数据结构,它通过哈希函数将键(Key)映射到存储位置,以此实现对数据的快速存取。哈希函数的设计核心在于如何将任意的输入数据转换为固定范围内的输出值,而这个输出值就决定了数据在哈希表中的存储位置。

一个好的哈希函数应当具有以下特性:

1. **一致性**:相同的键应当总是产生相同的哈希值。

2. **高效性**:计算速度快,对输入数据变化敏感。

3. **均匀性**:不同的键应当尽可能均匀地分布在整个哈希表中,以减少碰撞。

实现哈希函数有多种方法,包括直接地址法、除留余数法、数字分析法等。例如,除留余数法就是通过取键值对某个质数取模来获得哈希值。这样做的目的是将原始的键映射到较小的索引集合中。

哈希映射机制的关键在于保持查找、插入和删除操作的高效性。由于哈希表的平均查找时间复杂度接近O(1),所以它在处理大量数据时的性能优势极为明显。

### 2.1.2 碰撞解决策略

尽管哈希函数设计得再优秀,也无法完全避免“碰撞”——即不同的键被映射到相同的哈希值的情况。解决碰撞的策略主要有以下几种:

1. **开放寻址法**:如果发生碰撞,按照某种规则顺序寻找下一个空闲位置进行存储。

2. **链表法**:在每个哈希表的位置使用链表存储具有相同哈希值的元素。

3. **双重哈希法**:使用多个哈希函数,在发生碰撞时依次尝试。

每种方法都有其优缺点,例如开放寻址法简单高效,但可能导致“聚集”问题;链表法则在哈希表的每个位置维护一个链表,需要额外的存储空间但易于实现。

### 2.2 哈希表的内部实现

#### 2.2.1 数组与链表的结合应用

哈希表通常使用数组来存储数据,而链表则被用来解决碰撞问题。在Java中,一个简单的哈希表实现可以使用`HashMap`,其内部就是以数组形式存储键值对,并在数组的每个位置使用链表来存储具有相同哈希值的元素。

```java

// Java HashMap内部结构简化版

public class MyHashMap<K, V> {

private Entry<K,V>[] table;

private static class Entry<K,V> {

final K key;

V value;

Entry<K,V> next;

Entry(K key, V value, Entry<K,V> next) {

this.key = key;

this.value = value;

this.next = next;

}

}

}

```

#### 2.2.2 动态扩容与性能优化

为了保持哈希表的性能,当哈希表中的数据量增长到一定程度时,需要进行动态扩容。扩容通常涉及创建一个更大的数组,并将旧数组中的元素重新哈希到新数组中。Java中的`HashMap`默认情况下在元素数量达到数组容量的75%时就会进行扩容。

```java

// 简化版的HashMap扩容操作

public void resize() {

int newCapacity = table.length * 2;

Entry<K,V>[] newTable = new Entry[newCapacity];

for (Entry<K,V> e : table) {

while (e != null) {

Entry<K,V> next = e.next;

int index = (e.key.hashCode() & 0x7FFFFFFF) % newCapacity;

e.next = newTable[index];

newTable[index] = e;

e = next;

}

}

table = newTable;

}

```

## 2.3 哈希表的时间复杂度分析

### 2.3.1 平均情况与最坏情况分析

在理想情况下,哈希表的所有操作平均时间复杂度为O(1),这是因为哈希函数可以将键平均分布到哈希表中,从而实现平均访问时间的最小化。

然而,在最坏的情况下,如果所有的键都映射到了同一个位置,哈希表的时间复杂度会退化到O(n),其中n是哈希表中的元素数量。这种情况下,每次操作实际上需要遍历整个链表。

为了避免最坏情况的发生,可以采取以下措施:

1. **使用高质量的哈希函数**,减少键冲突。

2. **动态扩容**,保持适当的负载因子。

3. **设计合理的哈希表容量**,避免由于容量过小导致频繁扩容。

### 2.3.2 理论与实践的差距探讨

在实际应用中,理论上的时间复杂度分析并不总能准确地反映程序的性能。例如,哈希表的性能不仅仅取决于哈希函数的质量,还受到系统内存结构、缓存行为、并发访问等多种因素的影响。

为了准确地评估哈希表的性能,除了理论分析外,还需要通过实际的性能测试来测量在不同的负载和操作模式下的性能表现。在测试中,应关注平均情况和极端情况下的表现,并针对性地进行优化。

在本章节中,我们详细探讨了哈希表的基础原理和内部实现细节,还涉及了时间复杂度的理

0

0