神经网络模型压缩中的数据精度问题:5大解决方案助你突破

发布时间: 2024-09-06 07:32:25 阅读量: 129 订阅数: 59

一种基于可解释神经网络模型的压缩机功率软测量方法.pdf

# 1. 神经网络模型压缩概述

在现代AI领域,神经网络的规模和复杂性不断增长,导致了对计算资源和内存的巨大需求。为了使这些先进的模型能够部署在边缘设备上,例如智能手机和IoT设备,或者为了优化云平台上的资源使用,模型压缩技术应运而生。模型压缩旨在减少模型的大小和计算需求,同时尽量保持其性能不受影响。

本章将简要介绍模型压缩的基本概念,并探讨为何要对神经网络模型进行压缩。我们将提供一个对压缩方法的高层次概述,这些方法包括权重剪枝、量化和参数共享等。本章还将为读者搭建一个基础框架,帮助理解模型压缩对数据精度可能产生的影响,以及后续章节中将讨论的保持精度的技术方案。通过本章,读者将获得一个对模型压缩领域的初步理解,并为深入探讨数据精度问题打下坚实的基础。

# 2. 数据精度问题的根本原因

数据精度问题在深度学习模型的训练和部署中至关重要,其对模型性能有着直接的影响。在神经网络模型压缩的过程中,如何保持数据精度,是实现高效模型部署的关键所在。本章将深入探讨数据精度问题的根本原因,并分析数据类型、权重剪枝、量化技术等因素对精度的影响。

### 2.1 理解数据精度与模型性能的关系

数据精度是指在计算机系统中数据表示的精确程度,它直接关联到模型的计算和预测能力。在神经网络模型中,数据精度尤其重要,因为它与模型权重的精确度以及最终的预测精度紧密相连。

#### 2.1.1 数据类型及其对精度的影响

在深度学习中,常见的数据类型包括整型(如 int8, int16, int32),浮点型(如 float16, float32, float64)以及二进制型等。每种数据类型都有其特定的精度和范围。

- **整型**:通常用于表示离散的数值。其精度取决于位数,如 int8 表示-128 到 127 的范围。由于整数型不包含小数部分,使用整型能够大幅减少模型对计算资源的需求,但同时也牺牲了精度,尤其是对于需要小数部分进行计算的场景。

- **浮点型**:能表示实数,具有较高的精度,适用于复杂的数学运算。float32 是目前深度学习中常用的数据类型,具有足够的精度且能保持较好的性能平衡。

- **二进制型**:通过二进制编码表示数据,如二进制权重。某些压缩技术,如二值化(Binary Neural Networks),可以将权重和激活函数的值限制为-1或1,从而大幅提升计算效率,但这种极端的表示方式可能导致精度的显著下降。

#### 2.1.2 精度下降对模型性能的具体影响

精度下降会导致模型的表示能力和泛化能力降低,这主要表现在以下几个方面:

- **数值稳定性**:低精度可能会使得模型训练过程中出现数值不稳定,导致梯度消失或爆炸等问题。

- **训练收敛性**:精度不足可能会导致模型难以达到良好的收敛状态,从而影响最终的性能。

- **预测准确性**:在最终的预测阶段,数据精度不足会直接导致预测结果的准确性下降。

### 2.2 模型压缩技术中的精度挑战

在模型压缩中,无论是权重剪枝、量化还是参数共享等技术,都会对模型精度带来挑战。本节将具体分析这些技术如何影响精度以及它们带来的权衡问题。

#### 2.2.1 权重剪枝对精度的影响

权重剪枝是一种减少模型参数数量的技术,通过去除部分权重较小的连接来实现模型压缩。

- **精度损失原因**:剪枝本质上移除了模型的一些信息,这些被移除的信息可能对于保持模型的预测精度至关重要。

- **剪枝策略**:为了最小化精度损失,通常采用迭代剪枝策略,即先对模型进行初步剪枝,然后重新训练和微调模型,再进行下一轮剪枝,以此迭代。

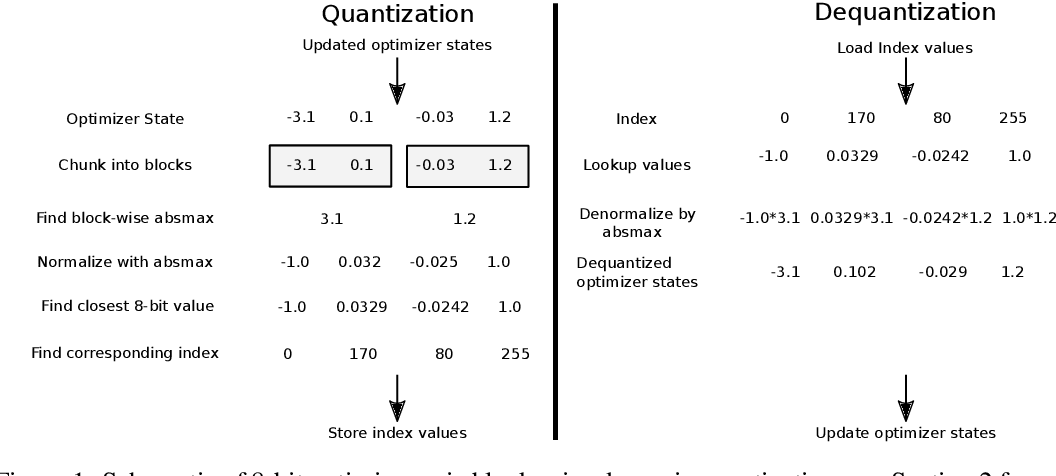

#### 2.2.2 量化技术的精度损失

量化技术是将模型中原本浮点型的权重和激活转换为低比特位的整型表示。

- **精度损失**:由于量化涉及舍入操作和信息截断,这会引入量化噪声并损失精度。量化后的模型在表示能力和范围上受到限制,因而影响精度。

- **量化方法**:量化通常分为无损量化和有损量化。无损量化尽可能减少精度损失,而有损量化则在精度和资源使用之间寻找平衡。

#### 2.2.3 参数共享与精度权衡

参数共享是通过让多个网络部分使用相同的权重来减少模型大小的一种方式。

- **权衡问题**:参数共享能够大幅降低模型大小,但这种全局共享可能导致某些特征无法被模型捕捉,从而影响精度。

- **实现方式**:在实现参数共享时,可以通过设计合理的网络结构来减少这种精度损失,如使用分组卷积等技术。

在下一节中,我们将讨论如何通过技术方案保持精度,确保模型压缩后仍然保持良好的性能。

# 3. 精度保持的技术方案

## 量化技术的优化策略

### 动态量化与静态量化的对比

在神经网络模型压缩中,量化技术将模型中的浮点参数转换为低比特精度的数据表示。动态量化与静态量化是两种主要的量化方法。

动态量化在模型的推理阶段进行量化的计算,通常在运行时计算量化参数,这样可以针对不同的输入数据适应性地调整量化的范围和精度。静态量化则是在模型训练后,根据训练好的模型参数一次性确定量化方案。静态量化通常需要更复杂的算法来预测最佳量化参数。

静态量化虽然简化了推理过程,可能会在某些场景下引入更大的精度损失。而动态量化在保持精度方面相对有优势,因为它可以实时调整,但可能会增加推理的复杂性和时间。

```python

import torch

import torch.nn as nn

# 动态量化示例

class DynamicQuantizedModel(nn.Module):

def __init__(self):

super(DynamicQuantizedModel, self).__init__()

# 定义一个全连接层作为示例

self.fc = nn.Linear(10, 10)

def forward(self, x):

x = self.fc(x)

return x

# 创建模型实例并动态量化

model = DynamicQuantizedModel()

quantized_model = torch.quantization.quantize_dynamic(

model, # the original model

{nn.Linear}, # a set of layers to dynamically quantize

dtype=torch.qint8 # the target dtype for quantized weights

)

# 执行推理

quantized_model(torch.randn(1, 10))

```

在上述代码中,我们创建了一个动态量化的模型示例。动态量化在PyTorch中通过`quantize_

0

0