自适应方法在神经网络模型压缩中的应用:技术创新与案例

发布时间: 2024-09-06 07:51:30 阅读量: 294 订阅数: 59

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. 神经网络模型压缩概述

## 神经网络模型压缩的背景与意义

随着深度学习技术在各种应用领域的快速发展和普及,神经网络模型变得越来越复杂和庞大。这不仅导致了模型的存储和计算资源需求增加,还引发了能源消耗和部署成本的显著上升。为了使这些模型能够在资源受限的环境下运行,例如移动设备、嵌入式系统和边缘计算设备,需要对神经网络模型进行压缩。模型压缩不仅提高了计算效率,降低了能耗,还大大减少了部署成本,从而实现了深度学习模型的轻量化和便携化。

## 模型压缩的定义与发展

模型压缩是通过特定算法和技术,减少深度学习模型中参数数量、降低模型复杂度的一系列方法。近年来,随着自适应方法的提出和优化,模型压缩技术在保持模型精度的同时,极大地提升了模型的效率和适用性。自适应方法通过分析模型训练过程中的行为,动态地调整模型结构,以实现更优的压缩率和性能。这种方法相比于传统的静态压缩技术,更具有针对性和灵活性,因此在实际应用中表现出色。

# 2. 自适应方法理论基础

## 2.1 神经网络压缩的必要性

### 2.1.1 模型大小与计算效率

随着深度学习技术的快速发展,神经网络模型的规模也在不断膨胀,这导致了模型大小的显著增加。大型模型通常具有数百万甚至数十亿的参数,这给存储和计算效率带来了巨大挑战。尤其是在资源受限的设备上,如移动设备、嵌入式系统和边缘设备,大型模型难以直接部署和运行。

举个例子,一个具有1亿参数的深度神经网络,其模型文件可能超过300MB大小。仅文件传输就需要消耗大量的时间和带宽资源。此外,计算效率也是一个关键因素。大模型的训练和推理过程需要更多的计算资源,这通常意味着需要更多的GPU或TPU时间,进而导致高昂的成本。

在实际应用中,优化模型大小和提升计算效率是降低成本和提高用户体验的关键。通过神经网络压缩,可以有效减小模型大小,降低计算资源的需求,提高推理速度,使得复杂的深度学习模型能够在资源受限的设备上运行。

### 2.1.2 能耗和部署成本问题

神经网络模型的能耗问题随着模型规模的增加而变得更加显著。以智能手机为例,较大的模型消耗更多的电池电量,缩短了设备的续航时间,影响用户体验。此外,在云计算环境下,能耗的增加直接转化为更高的电力成本,这对于数据中心的运营是一个重要考量。

部署大型深度学习模型到生产环境也需要额外的硬件资源和配置工作。对于小型企业或研究团队来说,高昂的部署成本可能限制了深度学习技术的应用和推广。因此,为了降低能耗和部署成本,对神经网络进行压缩成为了迫切的需求。

自适应方法在压缩神经网络方面具有独特的优势。相比传统的静态压缩方法,自适应方法能够根据模型的实时性能需求动态调整压缩策略,既保证了模型性能,又降低了能耗和成本。这种方法尤其适用于需要在各种设备上运行模型的场景,如实时语音识别、图像处理等。

## 2.2 自适应方法的基本原理

### 2.2.1 自适应压缩与静态压缩对比

自适应压缩方法与静态压缩方法在处理神经网络模型时有不同的工作方式。静态压缩方法往往在模型训练完成后,采用一种固定的压缩策略,如剪枝、量化或知识蒸馏等,来减小模型的大小。这种方法虽然能够有效减少模型的参数数量,但可能会影响模型的性能,尤其是当压缩率过高时。

相比之下,自适应压缩方法更加灵活和动态。它可以根据模型运行时的具体需求,自动调整压缩策略。例如,自适应方法可以在模型推理过程中根据当前的计算资源和精度要求,动态地进行参数剪枝或调整量化级别。这种方法的一个关键优势是能够在保持模型性能的同时,达到压缩模型的目的。

自适应方法的一个典型例子是条件化剪枝(conditional pruning),其中剪枝的决策依赖于输入数据的特性。如果输入数据表明模型可以容忍一定程度的精度下降,自适应方法则会执行更多的剪枝操作。反之,则保持模型的完整性。这种方法的灵活性允许模型在不同的工作负载和性能要求之间进行权衡,从而实现更为高效和经济的模型部署。

### 2.2.2 自适应方法的数学模型

自适应方法的数学模型通常涉及到优化理论,目标是最小化一个由性能损失和压缩成本组成的代价函数。在这个框架下,压缩策略的选择可以被建模为一个优化问题。例如,目标可以是寻找一个剪枝掩码,使得在保证模型性能的前提下,剪枝掉的参数数量最大化。

数学模型可能会用到的优化技术包括梯度下降、随机梯度下降(SGD)等。这些优化技术可以帮助我们找到代价函数的局部最小值。在实际应用中,优化过程可能需要考虑诸如剪枝后参数的稀疏性、计算量、内存占用等多种因素。因此,自适应方法的数学模型通常需要一个复杂的约束条件集合来满足实际应用的需要。

除了传统的优化算法,深度学习领域还开发了专门用于处理神经网络结构优化的算法,例如神经架构搜索(NAS)。通过NAS,我们可以在一个大的搜索空间内,找到最优的网络结构,同时满足特定的压缩和性能要求。这种方法通常涉及到强化学习或进化算法,以有效地探索可能的网络结构,并寻找到最优解。

## 2.3 自适应方法的分类

### 2.3.1 参数剪枝

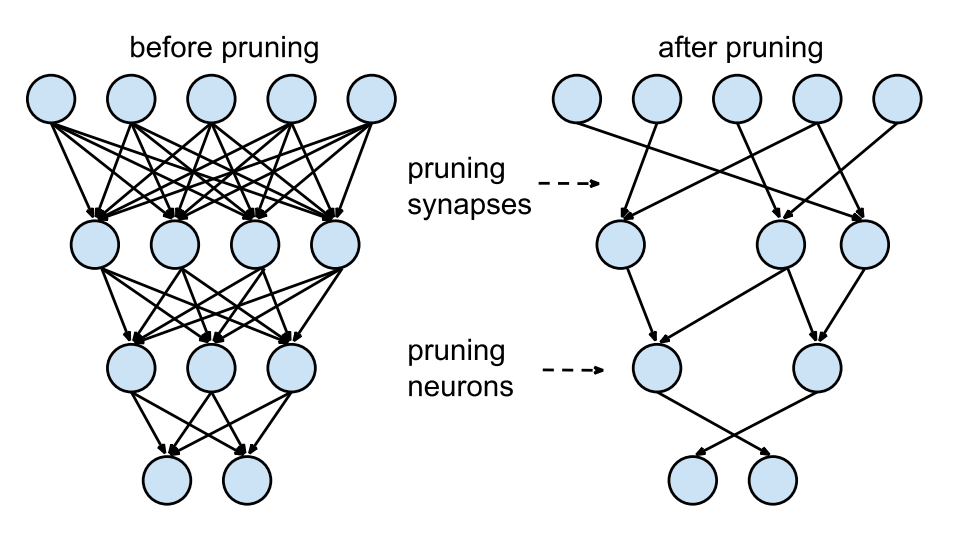

参数剪枝是指从神经网络中删除一部分权重,以达到减少模型大小和提高计算效率的目的。这一过程通常涉及到确定哪些权重对模型的输出影响最小,并将这些权重设为零或去除。参数剪枝可以是预先设定的(静态剪枝),也可以是根据运行时的数据动态进行的(动态剪枝)。

在执行参数剪枝时,通常会根据权重的重要性来选择剪枝的策略。一种常用的方法是计算权重的L1范数或L2范数,并根据这些范数的大小来确定哪些权重可以被剪枝。权重的重要性评分越高,其对模型的影响越大,因此保留的可能性也越大。

尽管参数剪枝可以有效减少模型参数,但过量的剪枝可能会损害模型的性能。因此,合理的剪枝比例和剪枝策略的选择至关重要。为了平衡模型性能和压缩率,研究人员设计了多种复杂的剪枝方法,如结构化剪枝和非结构化剪枝。结构化剪枝将权重以固定模式(如通道、层、过滤器)的方式去除,而非常规的非结构化剪枝则可以去除任何权重,但这通常会导致稀疏性,对硬件的要求较高。

### 2.3.2 知识蒸馏

知识蒸馏(Knowledge Distillation)是一种将大型复杂模型的知识转移到小型模型中的技术。通过这种方法,大型模型(教师模型)和小型模型(学生模型)在相同的输入数据上进行训练,但小型模型试图模仿大型模型的输出,包括其预测概率分布。这种方法的核心思想是,大型模型不仅存储了数据的特征,还蕴含了关于数据的丰富知识,这些知识可以通过蒸馏转移到小型模型中。

知识蒸馏的关键步骤包括定义损失函数,使得学生模型能够学习到教师模型的软标签(soft labels)。软标签指的是模型输出概率分布,与简单的一对一目标标签不同,它包含了更多的信息,比如模型对于特定类别的置信度。蒸馏损失函数通常是教师模型和学生模型输出的交叉熵的加权和。

知识蒸馏过程可以分为两个阶段:预训练阶段和蒸馏阶段。在预训练阶段,学生模型被训练以学习和教师模型类似的特征表示。随后,在蒸馏阶段,学生模型通过蒸馏损失进行微调,学习如何模拟教师模型的软标签。这种方法的一个显著优点是,学生模型可以在保持或甚至提升性能的同时,大幅降低模型大小和计算复杂度。

### 2.3.3 量化技术

量化技术是另一种流行的神经网络压缩方法,它通过降低权重和激活函数的精度来减少模型大小和加快推理速度。在量化过程中,32位浮点数(FP32)通常被转换成较低精度的数据类型,如16位浮点数(FP16)或8位整数(INT8)。这种转换可以大幅度减少模型存储所需的位数,从而压缩模型大小。

量化技术的一个关键挑战是如何在减少位数的同时,最小化精度损失。低精度可能导致模型在推理时产生较大的量化误差,影响最终的输出准确性。为了解决这个问题,研究人员提出了多种量化策略,包括线性量化和对称量化。线性量化通过缩放因子将浮点数值映射到整数,而对称量化则对正值和负值使用相同的缩放因子,简化了实现过程。

另一个重要的考量是量化感知训练(Quantization-Aware Training, QAT)。在QAT过程中,网络在训练阶段模拟量化过程,这有助于模型适应量化带来的精度损失。通过这种训练方式,模型在推理时的量化误差可以被大大减少,从而在保持高精度的同时实现有效的模型压缩。

量化技术不仅可以应用于权重,还可以应用于激活函数,尤其是在深层网络中。通过减少激活函数值的表示精度,可以进一步提升计算效率和减少模型大小。当激活函数值被量化到低精度时,通常需要对网络的其他部分进行微调,以适应激活函数的量化。

在实际应用中,量化技术的选择通常取决于模型的部署目标和硬件限制。例如,在移动设备上,由于内存带宽和处理能力的限制,低精度量化是理想的选择。而在GPU等高性能硬件上,可能无需过度量化,以保持模型的高性能。因此,在选择量化策略时,需要综合考虑模型的性能、精度要求和部署环境。

在下文中,我们将进一步探讨自适应压缩方法的实现细节,以及它们在不同类型的应用场景中的应用和优化方法。这将包括参数剪枝、知识蒸馏和量化技术的具体实现,以及如何将这些方法应用于图像识别、自然语言处理和边缘计算等领域的案例研究。

# 3. 自适应压缩方法的实现

## 3.1 参数剪枝技术实践

### 3.1.1 重要性评分与剪枝策略

参数剪枝技术是自适应压缩方法中最早被提出和广泛研究的方法之一。剪枝过程的核心在于确定哪些参数对于模型输出影响较小,从而可以被剪除。实现这一目标的关键在于参数的重要性评分机制。常见的评分方法有基于泰勒展开的近似方法、基于Hessian矩阵的方法、和基于梯度的方法等。

在进行参数剪枝时,我们首先需要定义一个“重要性评分”函数来评估每个参数的重要性。这个评分可以是基于损失函数对于该参数的敏感度,也可以是基于参数对网络输出影响的度量。评分的高低直接影响着参数是否被保留。

例如,基于泰勒展开的近似方法通过计算损失函数对参数的二阶导数,来评估参数对于网络性能的影响程度。参数的二阶导数越大,表明参数越重要,删除后的影响也就越大。

```python

# Python伪代码示例:参数重要性评分计算

import torch

import torch.nn as nn

def compute_importance_scores(model, criterion, dataloader):

"""

计算每个参数的重要性评分

:param model: PyTorch模型

:param criterion: 损失函数

:param dataloader: 数据加载器

:return: 参数评分字典

"""

# 关闭模型的梯度计算

for param in model.parameters():

param.requires_grad = False

# 对于每个参数,计算其对损失的影响

scores = {}

for name, param in model.named_parameters():

# 创建参数副本

param_copy = torch.clone(param)

# 计算评分

for i in range(len(param_copy)):

param_copy[i] += 1e-4 # 添加扰动

loss_perturbed = criterion(m

```

0

0