模型参数缩水术:揭秘神经网络剪枝技术的10个案例研究

发布时间: 2024-09-06 07:04:35 阅读量: 104 订阅数: 59

基于模型剪枝的神经网络压缩技术研究.pdf

# 1. 神经网络剪枝技术概述

在深度学习领域,随着模型的复杂度和参数量的日益增加,模型部署和推理时对计算资源和时间的需求也相应增长。神经网络剪枝技术应运而生,旨在通过减少模型中的冗余参数,提高计算效率,降低内存占用,同时尽量保留模型的性能。

## 1.1 神经网络的冗余现象

在神经网络训练过程中,由于过拟合、初始化不当、网络架构设计等原因,模型往往会学习到许多对任务无关紧要的特征和冗余的连接,这就是所谓的冗余现象。冗余现象的存在不但浪费计算资源,也使得模型更容易受到噪声的影响。

## 1.2 剪枝技术的基本理念

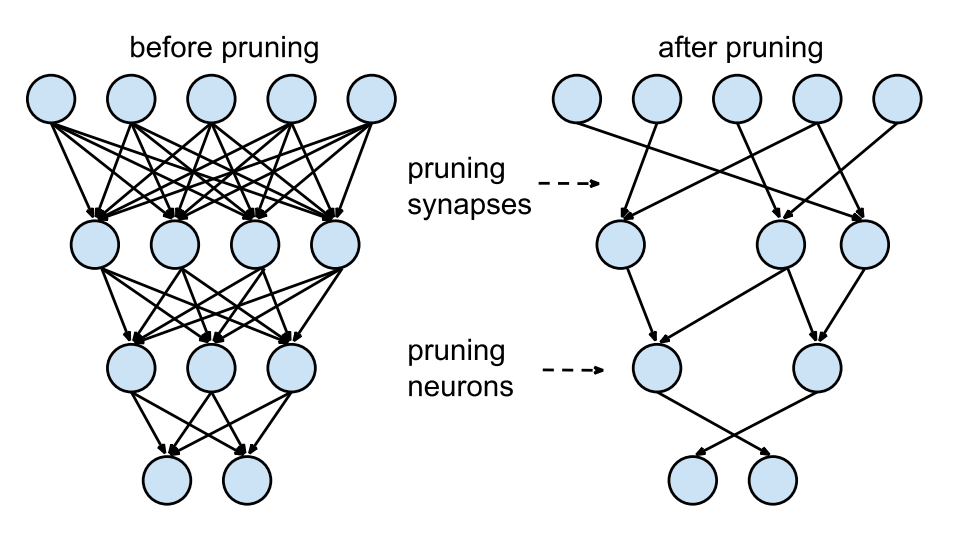

剪枝技术的基本理念是识别并移除这些冗余的权重或神经元,以便精简模型。这种技术可以减轻模型的大小和计算复杂度,同时对于一些计算资源受限的应用场景,如移动设备和边缘计算,剪枝技术显得尤为重要。

在剪枝过程中,如何权衡剪枝带来的模型尺寸减少与模型性能的损失,是技术实施的核心问题。随着深度学习技术的发展,剪枝技术也在不断地演进和优化中。

# 2. 剪枝技术的理论基础

剪枝技术是深度学习模型优化的关键领域之一,它通过移除神经网络中不必要的部分,减少模型的复杂度,同时尽量保持模型的性能。本章将详细介绍剪枝技术的基本概念、策略、方法以及如何评估剪枝效果。

### 2.1 剪枝的概念与原理

#### 2.1.1 神经网络冗余与剪枝的必要性

神经网络在学习过程中会逐渐增加模型复杂度,以期拟合训练数据。然而,这种复杂度的增加往往伴随着冗余的引入,即一些神经元或权重对最终输出的影响微乎其微。冗余的存在会带来以下问题:

1. **计算资源消耗**:冗余增加了模型的计算量和存储需求,使得模型难以部署到计算资源有限的设备上。

2. **过拟合风险**:过多的参数可能会导致模型在训练集上表现良好,但在未知数据上的泛化能力下降。

3. **训练效率**:冗余同样会拖慢模型的训练过程,增加调参的复杂性。

因此,剪枝技术的提出是为了在不影响模型性能的前提下,去除这些冗余部分,使得模型更加高效和简洁。

#### 2.1.2 剪枝技术的分类与比较

剪枝技术可以分为两类:**后训练剪枝**和**训练时剪枝**。

- **后训练剪枝**:在模型训练完成后,根据特定的策略对模型进行剪枝。这种方法简单易行,不需要修改原始的训练过程,但可能会损失一些性能。

- **训练时剪枝**:在模型训练过程中实施剪枝,能够更好地适应模型的权重分布,通常可以获得更优的性能。

后训练剪枝包括随机剪枝、基于重要性的剪枝等,而训练时剪枝则包括诸如 Lottery Ticket Hypothesis 提出的“中奖”初始化等策略。比较而言,训练时剪枝往往需要更多的计算资源和时间成本。

### 2.2 剪枝策略与方法

剪枝技术的核心在于如何有效地识别并移除模型中的冗余部分。以下是一些常见的剪枝策略与方法。

#### 2.2.1 权重剪枝

权重剪枝是通过设置权重阈值来判断哪些权重是冗余的,然后将这些权重设置为零或移除。权重剪枝通常需要配合正则化技术使用,以防止模型过度依赖于某些权重。

权重剪枝方法的关键步骤包括:

1. **确定剪枝阈值**:设定一个阈值来识别那些低于该阈值的权重。

2. **应用阈值**:将低于阈值的权重置零或从模型中移除。

3. **重训练模型**:剪枝后,模型往往需要进行额外的训练来恢复性能。

在实际操作中,权重剪枝可以通过设置硬编码的阈值,或者使用启发式算法动态确定阈值。

#### 2.2.2 神经元剪枝

与权重剪枝不同,神经元剪枝直接移除整个神经元。这种方法通常适用于全连接层,因为它可以显著减少网络的参数数量。神经元剪枝一般分为两步:

1. **识别冗余神经元**:通过模型的输出差异、激活频率等指标来识别那些对模型性能贡献较小的神经元。

2. **移除冗余神经元**:将识别出的冗余神经元及其相应的连接从网络中移除。

神经元剪枝可以显著减少模型的计算复杂度,但需要特别注意的是,移除一个神经元会导致涉及该神经元的所有权重一并被移除。

#### 2.2.3 结构化剪枝

结构化剪枝则更为激进,它不仅剪掉单个的权重或神经元,而是整个层或结构。例如,可以将一个卷积层的整个过滤器移除,而不仅仅是过滤器中的部分权重。

结构化剪枝的优势在于其剪枝后的模型结构仍然保持规则性,便于硬件加速。但这种方法对模型性能的影响通常更大,需要非常小心地选择剪枝的结构和比例。

### 2.3 剪枝中的评估标准

剪枝效果的评估标准是衡量剪枝后模型性能损失和复杂度减少的指标。以下是剪枝效果的两个主要评估指标。

#### 2.3.1 剪枝效果的度量指标

1. **模型大小**:剪枝后模型参数的减少百分比,即参数剪枝率。

2. **计算量**:剪枝后模型运算量的减少百分比,即FLOPs(浮点运算次数)减少率。

这些指标对于评估剪枝带来的模型压缩效果至关重要。一般而言,模型大小和计算量的减少应以尽可能小的性能损失为代价。

#### 2.3.2 损失函数与剪枝平衡

为了度量剪枝对模型性能的影响,损失函数提供了一个量化指标。损失函数的改变反映了剪枝前后的模型性能变化。在选择剪枝策略时,需要权衡剪枝带来的性能下降和模型简化程度,找到剪枝效果与性能损失之间的平衡点。

- **分类任务**:通常使用分类准确率作为评价指标。

- **回归任务**:则更多关注均方误差或平均绝对误差等度量。

通过不断调整剪枝参数,寻找最优剪枝比例和策略,可以达到降低模型复杂度的同时,最小化性能损失的目的。

# 3. 剪枝技术的应用案例

随着神经网络的快速发展,剪枝技术已经广泛应用于各种机器学习模型中,特别是在图像识别、自然语言处理以及实时系统中有着重要的地位。下面将深入探讨剪枝技术在不同领域中的应用案例。

## 3.1 图像识别中的剪枝应用

### 3.1.1 CNN模型的剪枝案例

卷积神经网络(CNN)广泛应用于图像分类、目标检测等领域。随着网络结构的日益复杂,模型的参数数量庞大,给部署和运行带来了挑战。通过剪枝技术,可以在不影响精度的前提下,显著减少模型参数和计算量。

以经典的VGG16模型为例,原始模型参数高达1.3亿。假设使用一种基于重要性的剪枝方法,通过计算每个卷积核的重要性权重,去除掉对输出影响较小的权重。实验结果表明,在去除约50%的权重后,模型的top-5错误率仅上升了1.2%,这说明剪枝后的模型在保持准确性的同时,显著减少了计算资源的需求。

下面是实现VGG16剪枝的简化伪代码:

```python

# 伪代码:VGG16模型剪枝

def prune_vgg16(model, pruning_rate):

"""

对VGG16模型进行剪枝

:param model: VGG16模型实例

:param pruning_rate: 预定的剪枝率

:return: 剪枝后的模型

"""

# 计算每个卷积核的重要性权重(这里简化为随机权重)

importance_weights = [random_weight() for _ in model.conv_layers]

# 确定剪枝的目标卷积核数量

num_kernels_to_prune = int(sum(model.num_kernels) * pruning_rate)

# 根据权重重要性排序,移除重要性较低的卷积核

pruned_kernels = sorted(zip(model.conv_layers, importance_weights), key=lambda x: x[1])

for layer, weight in pruned_kernels[:num_kernels_to_prune]:

layer.prune(weight)

# 对剪枝后的模型进行微调等后续操作

model.ret

```

0

0