多线程_异步IO结合使用:提升BeautifulSoup项目效率

发布时间: 2024-09-30 23:17:22 阅读量: 21 订阅数: 25

# 1. 多线程与异步IO的基础概念

## 1.1 什么是多线程?

多线程是现代操作系统提供的核心功能之一,允许计算机同时执行多个任务。在程序设计中,多线程是利用计算机多核处理器资源的一种有效方式。它能增加程序的并发性,即同时进行多个任务,改善用户体验和系统响应能力。然而,多线程编程较为复杂,存在线程同步、资源竞争、死锁等问题。

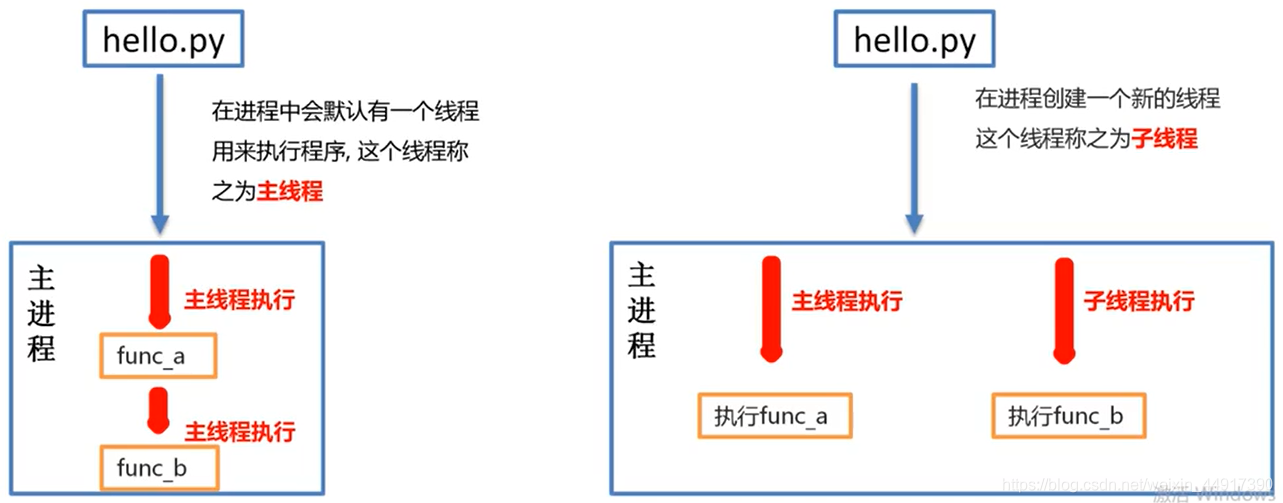

## 1.2 多线程与单线程的对比

单线程程序按照顺序执行操作,它易于编写和调试,但无法利用多核处理器的优势,因此在执行多个耗时操作时可能效率较低。多线程程序可以在多个处理器核心上并行运行,这样就能显著提升执行效率和响应速度。但是,它们需要开发者处理额外的线程安全和同步问题。

## 1.3 什么是异步IO?

异步IO是一种允许程序在等待输入输出操作完成时继续执行的编程范式。与同步IO不同,异步IO不会阻塞程序执行,当有I/O操作发生时,程序会继续执行其他任务,直到I/O操作完成,再进行回调处理。这样能够提高程序在执行I/O密集型任务时的效率,尤其适合于网络服务器这类应用场景。

## 1.4 多线程与异步IO的关系

多线程和异步IO都是提高程序并发性的技术手段,但它们的工作方式和适用场景有所不同。多线程通过创建多个线程直接利用了操作系统的并发性,适合于CPU密集型任务;异步IO则通过非阻塞I/O操作来提高程序效率,更适合I/O密集型任务。在某些复杂的场景中,将两者结合使用,可达到更高效的性能表现。

# 2. 深入理解多线程在Python中的实现

Python的多线程编程是提升程序性能的一种常见手段,尤其是在涉及到I/O密集型操作时。Python标准库中的`threading`模块提供了丰富的接口以支持多线程编程。然而,由于全局解释器锁(GIL)的存在,Python中的多线程对于CPU密集型任务的性能提升有限。尽管如此,合理利用多线程机制,在某些情况下依然可以大幅提高程序效率。

## 2.1 Python多线程基础

### 2.1.1 线程的创建和启动

Python中的线程是通过`threading`模块创建的。每个线程实例对应一个函数执行。线程创建和启动的步骤通常包括:

- 导入`threading`模块。

- 定义一个继承自`Thread`类的子类,并重写`run()`方法,在这个方法中编写线程将要执行的代码。

- 创建该子类的实例。

- 调用实例的`start()`方法启动线程。

以下是一个简单的多线程程序示例,创建两个线程,分别打印不同的内容:

```python

import threading

import time

class HelloThread(threading.Thread):

def run(self):

print("Hello, World! I am a thread")

def main():

# 创建线程实例

thread1 = HelloThread()

thread2 = HelloThread()

# 启动线程

thread1.start()

thread2.start()

# 等待线程完成

thread1.join()

thread2.join()

if __name__ == "__main__":

main()

```

以上代码的输出顺序是不确定的,因为线程的执行是并发的。

### 2.1.2 线程同步机制与锁

在多线程编程中,线程间同步是一个关键问题。因为多个线程可以同时访问共享资源,所以可能会导致数据不一致或竞态条件。Python提供了多种机制来同步线程,包括锁(Locks)、信号量(Semaphores)、事件(Events)等。其中,锁是最基础的同步机制。

锁是一种防止多个线程同时访问共享资源的机制。它有两个基本操作:`acquire()`和`release()`。当一个线程调用`acquire()`时,如果锁已经被其他线程获取,则当前线程会被阻塞,直到锁被释放。`release()`用于释放锁,使得其他线程可以获取该锁。

以下是一个使用锁的示例:

```python

import threading

counter = 0

counter_lock = threading.Lock()

def increment():

global counter

for _ in range(10000):

counter_lock.acquire()

counter += 1

counter_lock.release()

def main():

threads = []

for i in range(10):

thread = threading.Thread(target=increment)

thread.start()

threads.append(thread)

for thread in threads:

thread.join()

print(f"Counter value: {counter}")

if __name__ == "__main__":

main()

```

在上述代码中,`counter_lock`确保了`counter`变量的递增操作是线程安全的。如果不使用锁,则很可能由于线程间的交叉执行导致最终的`counter`值小于预期。

## 2.2 多线程的高级应用

### 2.2.1 线程池的使用

随着多线程应用复杂性的增加,直接创建和管理线程会引入额外的开销和复杂性。Python中的线程池可以简化线程管理,提高程序效率。线程池由一定数量的线程组成,这些线程可以预先创建好并等待执行任务。当有任务提交时,线程池会根据当前可用线程的数量,从队列中取出任务分配给线程执行,从而避免了频繁创建和销毁线程的开销。

Python标准库中的`concurrent.futures`模块提供了`ThreadPoolExecutor`类,可以用来创建线程池。下面是一个简单的例子:

```python

from concurrent.futures import ThreadPoolExecutor

def task(n):

print(f"Processing {n}")

def main():

with ThreadPoolExecutor(max_workers=5) as executor:

for i in range(10):

executor.submit(task, i)

if __name__ == "__main__":

main()

```

### 2.2.2 线程间通信和资源共享

在多线程编程中,线程间的通信和资源共享是必须要妥善处理的问题。线程间通信可以使用`threading`模块提供的`Event`、`Condition`或`Semaphore`等同步原语来实现。在资源共享方面,通常使用锁来保证数据的一致性。

共享资源的访问模式通常遵循以下步骤:

1. 线程请求锁。

2. 锁被分配给请求的线程。

3. 线程执行对共享资源的操作。

4. 线程释放锁。

以下是一个使用`threading.Condition`实现生产者消费者问题的例子:

```python

import threading

class Queue:

def __init__(self):

self.data = []

self.lock = threading.Lock()

self.condition = threading.Condition(self.lock)

def put(self, item):

with self.condition:

self.data.append(item)

self.condition.notify()

def get(self):

with self.condition:

while not self.data:

self.condition.wait()

item = self.data.pop(0)

return item

def producer(queue):

for i in range(10):

queue.put(i)

print(f"Produced {i}")

def consumer(queue):

while True:

item = queue.get()

print(f"Consumed {item}")

def main():

queue = Queue()

t_producer = threading.Thread(target=producer, args=(queue,))

t_consumer = threading.Thread(target=consumer, args=(queue,))

t_producer.start()

t_consumer.start()

t_producer.join()

t_consumer.join()

if __name__ == "__main__":

main()

```

## 2.3 多线程的性能分析

### 2.3.1 多线程与GIL的关系

全局解释器锁(GIL)是Python语言中的一个机制,用于保证在任一时刻,只有一个线程可以执行Python字节码。这就意味着,尽管可以创建多个线程,但是这些线程并不是真正意义上的并行执行。对于I/O密集型任务,Python的多线程依然有效,因为多线程可以提高I/O操作的效率,而GIL在进行I/O等待时会释放,允许其他线程执行。

### 2.3.2 多线程性能优化策略

在Python中使用多线程时,性能优化的策略主要包括:

- 减少锁的竞争,尽量避免使用全局锁,可以使用局部锁或递归锁(`threading.RLock`)来降低锁的竞争。

- 使用线程池来管理线程,减少线程的创建和销毁开销。

- 对于CPU密集型任务,可以考虑使用多进程来绕过GIL的限制,如使用`multiprocessing`模块。

- 对共享资源的访问进行合理设计,减少不必要的锁的使用,比如采用局部变量减少全局变量的使用。

通过这些策略的应用,可以最大限度地提升Python程序在多线程环境下的性能表现。

在下一章节中,我们将继续探讨Python中的异步IO编程模型,以及它与多线程如何在实践中相互补充和提高程序的性能和效率。

# 3. 异步IO在Python中的实践

## 3.1 异步IO基础与asyncio库

### 3.1.1 异步编程模型介绍

异步编程是一种编程范式,它允许一段代码在等待另一个长时间运行的操作(如I/O操作)完成时,继续执行其他任务。传统上,同步编程模型中代码按顺序执行,一条语句完成后才能执行下一条,这会导致在等待I/O操作时CPU空闲,效率低下。相比之下,异步编程模型可以让CPU在I/O操作完成期间去处理其他任务,从而提高整体程序的执行效率。

异步编程模型的关键概念包括协程(coroutine),它是比线程更轻量级的执行单元。协程可以暂停执行以等待某个事件,然后在事件发生时从上次暂停的位置恢复执行。这种模型非常适合于I/O密集型应用,如网络服务器、数据库接口等。

### 3.1.2 asyncio库的核心概念

Python中的asyncio库是实现异步I/O操作的标准库。通过使用asyncio,开发者可以编写单线程的并发代码,利用Python的协程来处理异步任务。asyncio库为

0

0