融合卷积神经网络和BP神经网络的模型优化

发布时间: 2024-04-14 18:56:38 阅读量: 112 订阅数: 50

# 1. 引言

#### 1.1 研究背景

在深度学习领域,卷积神经网络(CNN)和反向传播神经网络(BP神经网络)作为两大经典模型被广泛应用于图像识别、自然语言处理等领域。然而,单独应用其中一个模型可能会受限于其特性,故结合两者优势进行融合的研究备受关注。

#### 1.2 研究意义

本文旨在探讨如何将CNN的特征提取能力和BP神经网络的优化能力相结合,构建一个更加强大高效的深度学习模型。通过融合两种神经网络的优势,提高模型在图像识别等任务上的性能表现,推动深度学习技术的发展。同时,本研究还将探讨不同参数设置、数据集选择对模型性能的影响,为深度学习领域的研究和实践提供参考。

# 2. 卷积神经网络(CNN)的基本原理

#### 2.1 卷积层

卷积层是卷积神经网络的核心组件之一,负责提取输入数据中的特征。在卷积层中,主要包括卷积操作和激活函数两部分内容,下面将分别介绍。

##### 2.1.1 卷积操作

卷积操作是指卷积核与输入数据进行卷积运算,通过滑动窗口的方式从输入数据中提取特征。卷积操作可以有效减少模型参数数量,提高特征提取效率。

```python

# 示例代码:卷积操作

import torch

import torch.nn as nn

# 定义一个卷积层

conv_layer = nn.Conv2d(in_channels=3, out_channels=16, kernel_size=3, stride=1, padding=1)

# 输入数据

input_data = torch.randn(1, 3, 32, 32)

# 进行卷积操作

output_data = conv_layer(input_data)

print("输出数据形状:", output_data.shape)

```

##### 2.1.2 激活函数

激活函数在卷积神经网络中扮演着非常重要的角色,它能够引入非线性因素,帮助网络更好地学习复杂的模式和特征。常用的激活函数包括ReLU、Sigmoid和Tanh等。

#### 2.2 池化层

在卷积神经网络中,池化层用于降采样特征图,减小数据维度,从而减少模型计算量,并且能够提高模型的鲁棒性。主要的池化方式有最大池化和平均池化两种。

##### 2.2.1 最大池化

最大池化是在每个池化窗口中选择最大的值作为输出。最大池化能够保留主要特征并抑制噪声。

##### 2.2.2 平均池化

平均池化则是在每个池化窗口中取平均值作为输出,能够平均特征,降低过拟合风险。

```python

# 示例代码:最大池化

import torch

import torch.nn as nn

# 定义一个最大池化层

pool_layer = nn.MaxPool2d(kernel_size=2, stride=2)

# 输入数据

input_data = torch.randn(1, 3, 32, 32)

# 进行最大池化操作

output_data = pool_layer(input_data)

print("输出数据形状:", output_data.shape)

```

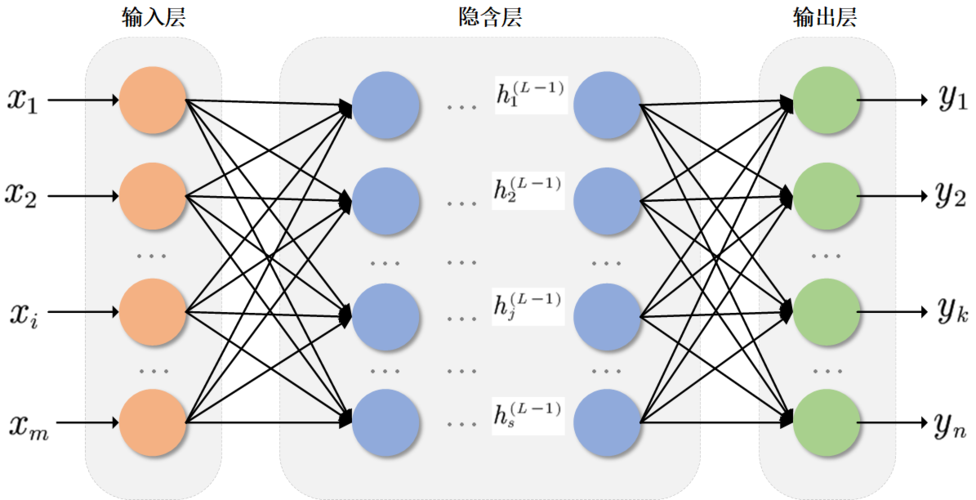

# 3. 反向传播神经网络(BP神经网络)的原理与优化

#### 3.1 前向传播

在神经网络中,前向传播是指输入数据通过网

0

0