超参数调优并行计算:加速模型训练的5大策略

发布时间: 2024-09-03 00:21:29 阅读量: 127 订阅数: 46

# 1. 超参数调优的理论基础与重要性

## 1.1 机器学习模型的超参数定义

在机器学习中,超参数是在模型训练之前设置的参数,它们不能直接从训练数据中学习得到。超参数决定了学习算法的结构和训练过程,例如学习率、正则化系数、模型的复杂度等。正确调整超参数对提升模型性能至关重要。

## 1.2 超参数调优的重要性

超参数调优能够显著影响模型的预测能力和泛化性能。良好的超参数设置可以使模型在验证集和测试集上都有良好的表现。反之,不恰当的超参数可能会导致模型过拟合或欠拟合,降低模型的实用价值。

## 1.3 超参数调优的方法论

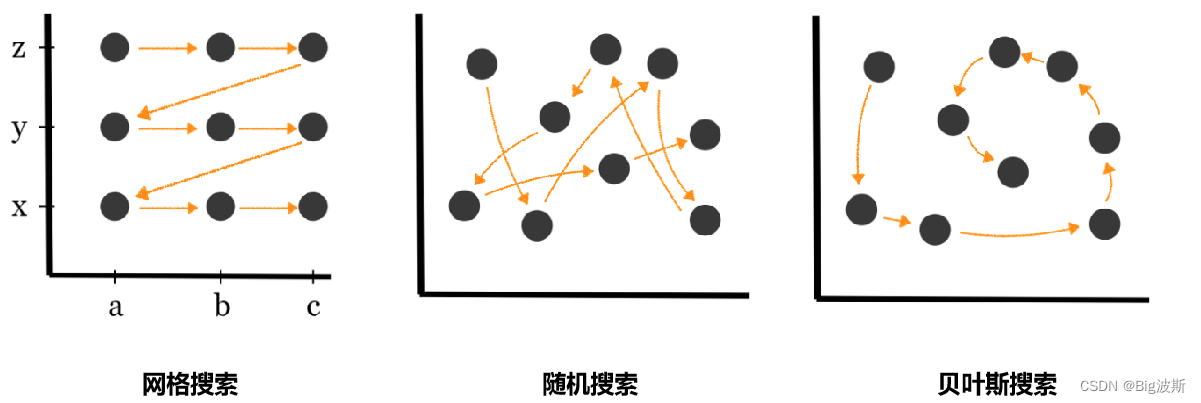

超参数调优的方法可以分为手动调优、网格搜索、随机搜索、贝叶斯优化和进化算法等。每种方法都有其优缺点和适用场景。选择合适的调优方法,有助于在有限的资源下获得最优的超参数组合,提升模型性能。

接下来的章节将围绕并行计算的原理以及如何加速模型训练进行深入讨论,探索超参数调优在实际应用中的技术与工具。

# 2. 并行计算的原理和模型训练加速

## 2.1 并行计算的基本概念

### 2.1.1 并行计算与串行计算的区别

并行计算是计算机科学中的一个分支,它涉及到使用两个或更多的处理器(或计算机)同时解决计算问题。并行计算的关键区别于串行计算,在于它能够同时处理多个计算任务,而串行计算一次只能处理一个任务。并行计算的主要优势在于它能够显著提高计算速度,并处理更大规模的数据集和更复杂的计算问题。

并行计算系统通常由多个处理单元组成,这些处理单元可以是单独的处理器或计算机。它们协同工作,通过数据交换和任务协调来完成计算任务。并行计算的挑战之一是如何有效地将问题分解为可并行处理的子问题,并最小化处理单元之间的通信开销。

### 2.1.2 并行计算的硬件架构

并行计算硬件架构通常包括以下几种类型:

- **共享内存架构**:所有处理单元共享同一块内存,可以轻松地进行数据交换。这种架构包括多核CPU和共享内存多处理器系统。

- **分布式内存架构**:每个处理单元拥有自己的本地内存,处理单元之间的通信必须通过网络进行。常见的分布式内存系统包括多节点计算机集群。

- **混合架构**:结合了共享内存和分布式内存的特点,例如具有多个CPU核心和多个节点的系统。

在选择合适的硬件架构时,需要考虑计算任务的特性和并行度要求。对于某些算法,如果需要频繁的数据交换,共享内存架构可能会更合适。然而,对于需要大规模并行处理的问题,分布式内存架构可能提供更好的可扩展性。

## 2.2 并行计算在模型训练中的应用

### 2.2.1 模型训练中的并行策略

在机器学习和深度学习中,并行计算已经被广泛应用于模型训练过程,以加快模型的训练速度。模型训练的并行策略主要有以下两种:

- **数据并行(Data Parallelism)**:在数据并行中,数据集被分为多个批次,并且每个批次被分配给不同的处理器进行训练。各个处理器可以并行处理不同的批次,但是使用相同的模型参数。

- **模型并行(Model Parallelism)**:模型并行涉及到在多个处理器之间分割模型本身,不同的处理器负责模型的不同部分。这通常用于模型非常庞大,无法在单个处理器的内存中完全加载的情况。

### 2.2.2 数据并行和模型并行的区别和适用场景

数据并行和模型并行各有优缺点,它们的适用场景也不同:

- **数据并行**适用于大多数机器学习算法,尤其是深度学习模型。它的主要优点在于易于实现和较高的并行效率,因为模型的大部分或全部都可以保持在每个处理单元上。然而,它要求每个处理单元都能够存储整个模型参数,这在模型非常庞大时可能不可行。

- **模型并行**则适合于超大型的模型,比如那些有数十亿参数的模型,或者当网络层的输出需要传递给下一个节点的输出时。模型并行的主要缺点在于可能需要复杂的通信和同步机制来确保不同部分的模型能够协同工作。

### 2.3 并行计算环境下的超参数调优挑战

#### 2.3.1 超参数空间的扩展性问题

在并行计算环境下,超参数空间可能迅速扩大,特别是在使用贝叶斯优化等高级搜索技术时。这会导致搜索空间呈指数级增长,给超参数调优带来巨大的挑战。

为了应对这一挑战,研究人员和工程师通常会采用启发式搜索、多臂老虎机算法或元学习方法来减少需要评估的超参数组合数量。此外,通过引入问题相关的先验知识和约束条件,也可以有效减少搜索空间。

#### 2.3.2 资源调度与并行效率的优化

资源调度是并行计算环境中的一个核心问题,特别是在处理多任务或多用户负载时。好的资源调度策略可以最大化资源利用率,同时减少任务完成时间。

并行效率是指完成一个任务所需的资源(时间和内存)与在串行环境中完成同样的任务相比的效率。为了优化并行效率,需要考虑任务分解的粒度、负载平衡以及处理器之间的通信开销。通常这需要一个综合的调度策略,它可以根据实时的工作负载和系统的可用资源动态调整任务分配。

在资源调度与并行效率优化方面,任务自动调度系统如Kubernetes或Slurm已经得到广泛应用,并提供了灵活的调度策略来应对复杂的并行计算需求。

# 3. 超参数调优的实践技术与工具

超参数调优是机器学习和深度学习模型训练过程中的关键环节,涉及选择和调整模型参数以达到最优性能。这一章节将深入探讨实际中常用的超参数搜索技术,并介绍几种高效的超参数调优工具。

## 3.1 自动化超参数搜索技术

在机器学习模型的训练过程中,选择合适的超参数至关重要。人工调整超参数既耗时又容易出错,因此自动化搜索技术成为了提高效率的关键手段。

### 3.1.1 网格搜索与随机搜索

网格搜索(Grid Search)是一种穷举式的参数搜索方法,通过遍历预定义的参数值组合,找到最优参数组合。然而,这种方法在参数空间较大时效率低下。随机搜索(Random Search)则在固定的参数范围内随机选取参数组合进行尝试,其效率和性能往往优于网格搜索。

```python

from sklearn.model_selection import GridSearchCV

from sklearn.ensemble import RandomForestClassifier

# 定义参数网格

param_grid = {

'n_estimators': [10, 50, 100],

'max_depth': [None, 5, 10, 20],

'min_samples_split': [2, 5, 10]

}

# 使用网格搜索进行超参数优化

grid_search = GridSearchCV(RandomForestClassifier(), param_grid, cv=5)

grid_search.fit(X_train, y_train)

# 输出最佳参数组合

print("Best parameters found: ", grid_search.best_params_)

```

网格搜索的代码示例中,我们定义了一个包含不同参数的网格,并使用`GridSearchCV`来找到最优的参数组合。需要注意的是,网格搜索适用于参数组合数量较小的情况。

### 3.1.2 贝叶斯优化和进化算法

贝叶斯优化是一种更加高效和智能的参数搜索方法。它构建一个概率模型来预测特定参数组合下的性能,并据此来选择下一步的参数组合,逐渐逼近最优解。

```python

from skopt import BayesSearchCV

from sklearn.ensemble import RandomForestClassifier

# 定义搜索空间

space = {

'n_estimators': (10, 200),

'max_depth': (None, 20),

'min_samples_split': (2, 20)

}

# 使用贝叶斯搜索进行超参数优化

bayes_search = BayesSearchCV(RandomForestClassifier(), space, n_iter=50, random_state=0)

bayes_search.fit(X_train, y_train)

# 输出最佳参数组合

print("Best parameters found: ", bayes_search.best_params_)

```

在上面的代码中,我们使用`BayesSearchCV`来进行贝叶斯优化,其中`n_iter`参数表示搜索的迭代次数。贝叶斯优化相比网格搜索更加高效,尤其是在参数空间较大时。

进化算法(如遗传算法)也是超参数优化的有力工具。它模拟自然选择和遗传机制,迭代地改进一组参数候选解,直至找到最优解。

## 3.2 超参数调优工具实战

除了基础的搜索方法,一些专门设计的工具可以进一步提高超参数调优的效率和效果。

### 3.2.1 工具介绍:Hyperopt、Op

0

0