【Python强化学习进阶手册】:4大实战技巧,深度调优你的算法

发布时间: 2024-08-31 18:19:51 阅读量: 211 订阅数: 48

# 1. 强化学习基础知识回顾

强化学习是一种让机器通过与环境交互来学习决策策略的方法。它使得智能体能够根据当前状态选择最优行为,以最大化未来的奖励。本章将带您回顾强化学习的核心概念。

## 1.1 强化学习的定义和组成

强化学习关注的是如何在一个不确定的环境中进行决策。智能体通过观察环境状态,并根据奖励信号选择动作,通过这种方式学习到一系列策略,以求在未来获得更多的奖励。

```mermaid

flowchart LR

A[环境状态] -->|观察| B[智能体]

B -->|动作| C[执行动作并获得奖励]

C --> A

```

## 1.2 奖励函数的作用

奖励函数是强化学习中的核心,它衡量智能体做出特定动作后得到的即时反馈。设计合理的奖励函数对于引导智能体学习到正确的策略至关重要。

## 1.3 强化学习与其他机器学习的比较

相比监督学习和无监督学习,强化学习的独特之处在于其学习过程是试错式的,智能体必须在环境中通过尝试来获取知识。这使得它非常适合需要决策策略的任务,比如游戏、自动驾驶车辆控制等。

# 2. 强化学习算法的理论与实践

## 2.1 Markov决策过程(MDP)

### 2.1.1 MDP模型的理论基础

Markov决策过程(MDP)是强化学习中的核心模型,它提供了一种数学框架,用于描述一个智能体(agent)在随机环境中的决策问题。MDP模型包含几个关键元素:状态空间(S)、动作空间(A)、转移概率(P)、奖励函数(R)以及折扣因子(γ)。

- 状态空间(S):智能体在任何时间点可能处于的所有可能环境状态的集合。

- 动作空间(A):智能体在每个状态下可以执行的所有可能动作的集合。

- 转移概率(P):描述了在给定当前状态和执行动作的条件下,环境状态转移的概率分布。

- 奖励函数(R):确定智能体在每个状态转移后所获得的即时奖励。

- 折扣因子(γ):衡量未来奖励与即时奖励的相对重要性,其取值范围在0到1之间。

MDP模型假设智能体在每个时间步骤中,根据当前状态和转移概率选择一个动作,然后环境会反馈一个即时奖励,并转移到下一个状态。智能体的目标是最大化其从开始到结束所获得的总奖励的期望值。为了实现这一目标,通常会使用策略评估和策略改进的方法来找到最优策略。

### 2.1.2 实现MDP的算法和代码解析

实现MDP模型的一个常见方法是使用值迭代(Value Iteration)算法。该算法通过不断迭代更新状态值来逼近最优策略。以下是值迭代算法的伪代码:

```

初始化价值函数 V(s) 为任意值

设定阈值 ε

重复直到 V 的改变小于 ε:

对于每个状态 s ∈ S:

V'(s) ← max_a Σ P(s'|s,a) [R(s,a,s') + γ V(s')]

V ← V'

```

上述伪代码中,`V(s)` 表示状态`s`的价值,`V'(s)` 表示更新后的状态`s`的价值,`P(s'|s,a)` 是智能体在状态`s`下执行动作`a`后转移到状态`s'`的概率,`R(s,a,s')` 是智能体从状态`s`执行动作`a`并转移到状态`s'`时获得的即时奖励,`γ` 是折扣因子。

代码实现MDP时,通常需要定义状态空间和动作空间,以及相应的转移概率和奖励函数。例如,如果我们要在Python中实现值迭代算法,可以使用以下代码:

```python

import numpy as np

# 定义状态空间和动作空间的大小

n_states = 5

n_actions = 2

# 定义转移概率矩阵 P(s'|s,a) 和奖励函数 R(s,a,s')

# 这里使用随机生成的数据作为示例

P = np.random.rand(n_states, n_actions, n_states)

R = np.random.rand(n_states, n_actions, n_states)

# 定义折扣因子

gamma = 0.9

# 初始化价值函数

V = np.zeros(n_states)

# 设定阈值

epsilon = 0.01

# 值迭代

while True:

delta = 0

for s in range(n_states):

v = V[s]

V[s] = np.max(np.sum(P[s, :, :] * (R[s, :, :] + gamma * V), axis=1))

delta = max(delta, abs(v - V[s]))

if delta < epsilon:

break

print("Optimal value function: ", V)

```

该代码通过不断迭代来更新状态价值函数,直到状态价值的变化小于给定的阈值ε,此时可以认为已经收敛到最优价值函数。随后,可以根据价值函数推断出最优策略。在实际应用中,我们需要根据具体问题设计相应的P和R,而代码逻辑保持不变。

## 2.2 Q-Learning算法深入

### 2.2.1 Q-Learning的理论框架

Q-Learning是一种无模型的强化学习算法,它不需要对环境的动态进行建模,而是直接学习一个动作-价值函数(也称为Q函数)。Q函数给出了在特定状态下执行特定动作的期望回报,即在状态s下执行动作a的期望总奖励。Q-Learning的目标是找到最优的Q函数,该函数对应于最优策略。

Q-Learning算法的基本思想是通过在每个时间步选择动作时加入一定程度的探索(exploration),并且通过学习经验来增加对Q函数的估计值。算法中的一个关键更新规则是:

Q(s, a) ← Q(s, a) + α[R(s, a, s') + γ max Q(s', a') - Q(s, a)]

其中:

- Q(s, a) 表示在状态s下执行动作a的当前Q值估计。

- α 是学习率,控制着新旧信息的融合程度。

- R(s, a, s') 是智能体在状态s下执行动作a并转移到状态s'时获得的即时奖励。

- γ 是折扣因子。

- max Q(s', a') 表示在状态s'下所有可能动作的Q值的最大值。

### 2.2.2 从代码实现到案例分析

接下来,我们将通过一个简单的Python代码示例来实现Q-Learning算法,并对其学习过程进行分析。假设我们要解决一个简单的网格世界问题,智能体需要从起点移动到终点,并且需要避免陷阱。

```python

import numpy as np

# 网格世界的状态和动作

states = ['start', 'trap', 'goal']

actions = ['up', 'down', 'left', 'right']

# 初始化Q表,所有值设为0

Q = {s: {a: 0 for a in actions} for s in states}

# 定义学习率、折扣因子和探索概率

alpha = 0.5

gamma = 0.9

epsilon = 0.1

# 环境的转移规则和奖励

P = {'start': {'up': 'trap', 'right': 'goal', 'left': 'start', 'down': 'start'},

'trap': {'up': 'trap', 'down': 'trap', 'left': 'trap', 'right': 'trap'},

'goal': {'up': 'goal', 'down': 'goal', 'left': 'goal', 'right': 'goal'}}

R = {'start': {'up': -1, 'right': 1, 'left': 0, 'down': 0},

'trap': {'up': -1, 'down': -1, 'left': -1, 'right': -1},

'goal': {'up': 0, 'down': 0, 'left': 0, 'right': 0}}

def q_learning(env, Q, alpha, gamma, epsilon, n_episodes):

for episode in range(n_episodes):

s = 'start' # 初始状态

done = False

while not done:

a = np.random.choice(actions) if np.random.rand() < epsilon else max(Q[s], key=Q[s].get)

r = env[s][a]

s_next = env[s][a]

Q[s][a] += alpha * (r + gamma * max(Q[s_next].values()) - Q[s][a])

s = s_next

if s == 'goal':

done = True

n_episodes = 5000

q_learning(env, Q, alpha, gamma, epsilon, n_episodes)

```

在上述代码中,我们定义了一个简单的网格世界,并为智能体提供了一个环境描述,包括状态转移和奖励。在每次迭代中,智能体根据当前的Q表选择动作,同时通过一个epsilon-greedy策略在探索和利用之间进行权衡。代码中没有直接使用Q-learning更新规则,而是通过实现整体算法逻辑来间接执行了该更新规则。

为了评估学习效果,我们可以绘制Q表的变化或者展示智能体的策略变化。由于篇幅限制,此处不展示具体绘制代码,但可以使用Matplotlib等工具进行可视化,从而观察智能体的行为和学习过程。

## 2.3 策略梯度方法

### 2.3.1 策略梯度理论简介

策略梯度方法是一类直接优化策略参数的强化学习算法。与Q-Learning等值函数方法不同,策略梯度方法直接通过梯度上升来最大化预期回报。策略梯度的核心思想是计算策略参数的梯度,并沿着这个梯度方向更新策略参数,使得预期回报最大化。

假设策略π由参数θ完全决定,我们的目标是找到最优参数θ*,使得预期回报最大:

θ* = argmaxθ Eπ[Σt=0^∞ γ^t Rt]

其中,Rt是在时间步t获得的即时奖励。策略梯度方法通过估计预期回报相对于策略参数θ的梯度来优化策略:

∇θ Eπ[Σt=0^∞ γ^t Rt] = Eπ[Σt=0^∞ ∇θ log πθ(at|st) Qπ(st, at)]

其中,πθ(at|st)是给定策略参数θ下,在状态st下执行动作at的概率,Qπ(st, at)是在策略π下,在状态st执行动作at并遵循策略π后获得的回报。

### 2.3.2 策略梯度方法的实现和应用

策略梯度方法的实现通常涉及到策略网络的构建和参数更新。以Actor-Critic方法为例,该方法结合了策略梯度方法和值函数方法的优点,其中Actor负责生成动作,而Critic负责评估动作的优劣。

我们在这里简要说明Actor-Critic的伪代码逻辑,其Python实现将在后续章节详细展开:

```

初始化策略网络Actor πθ和价值网络Critic Vφ

while 迭代次数未达到上限:

与环境交互以收集经验: s, a, r, s'

根据当前策略网络从状态s采样动作a

使用Critic网络估计价值V(s)

计算策略梯度

更新策略网络Actor πθ

更新价值网络Critic Vφ

```

实现策略梯度算法时,网络的设计和参数的更新是关键。例如,在Python中,我们可能会使用TensorFlow或PyTorch等深度学习框架来构建和训练神经网络。重点是理解策略梯度的计算和参数更新的细节,这些将在后续的代码示例中进行详细介绍。

## 2.4 强化学习中的探索与利用

### 2.4.1 探索与利用的平衡策略

在强化学习中,探索(exploration)是指智能体尝试新的或未知的动作以获取有关环境的信息,而利用(exploitation)是指智能体使用已知信息来最大化奖励。在实际应用中,找到探索和利用之间的平衡是至关重要的,因为过度探索可能导致智能体无法利用其已有的知识,而过度利用可能导致智能体陷入局部最优解。

探索与利用的平衡策略可以采用不同的启发式方法,例如ε-greedy、Softmax选择或上置信界限(UCB)策略。这些方法提供了不同的方式来权衡探索和利用。

### 2.4.2 实践案例:如何设计有效的探索机制

为了设计有效的探索机制,我们需要考虑环境的特性和智能体的学习过程。以ε-greedy策略为例,该策略以概率ε进行探索,以概率1-ε进行利用。在不同的学习阶段,智能体可能需要调整ε的值来适应学习进度。

以下是一个简单的ε-greedy策略的代码示例:

```python

import numpy as np

def epsilon_greedy(Q, epsilon):

if np.random.random() < epsilon:

return np.random.choice(list(Q.keys()))

else:

return max(Q, key=Q.get)

# 假设Q是一个字典,键为状态,值为在该状态下的动作价值字典

# ε是探索概率,例如0.1

action = epsilon_greedy(Q, 0.1)

```

在实践中,探索概率ε可能会随着学习的进行而变化,即ε-衰减策略。初期,较高的ε值鼓励智能体探索,随着学习的深入,ε逐渐减小以促进利用。

另一种探索方法是使用贝叶斯优化或汤普森采样(Thompson Sampling)来调整智能体的选择概率。这些方法通常更复杂,但能够更智能地平衡探索与利用。这些高级技术的应用将在后续章节中详细讨论,包括它们的原理、实现和在不同强化学习任务中的表现。

# 3. 强化学习中的深度学习技术

深度学习与强化学习的结合,推动了智能决策领域的发展,使其能够处理更高维和更复杂的问题。深度Q网络(DQN)和深度确定性策略梯度(DDPG)等方法,已经成为现代强化学习框架中不可或缺的部分。本章将深入探讨这些深度强化学习技术的原理与应用。

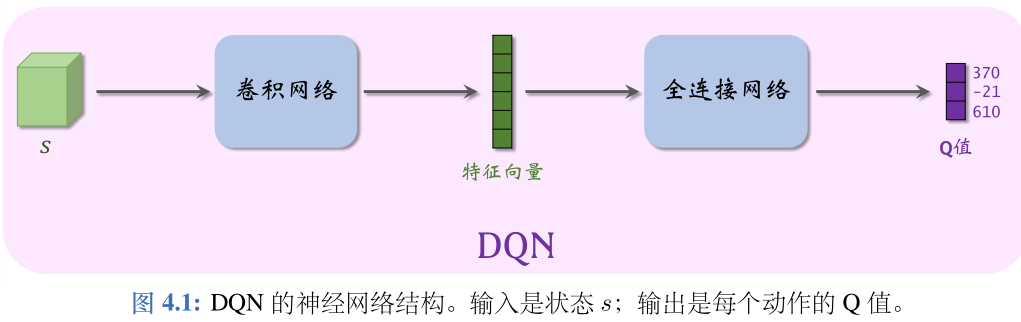

## 3.1 深度Q网络(DQN)的原理与应用

DQN技术通过结合深度神经网络和Q-Learning算法,成功处理了传统Q-Learning无法解决的高维状态空间问题。它使得智能体能够学习如何在给定状态和动作的环境中进行决策。

### 3.1.1 DQN算法的理论基础

DQN的关键思想在于使用深度神经网络来近似Q值函数。由于神经网络的参数众多,它能够学习和表示复杂的函数关系,从而能够处理大量的输入数据并进行准确的预测。DQN利用了经验回放(Experience Replay)和目标网络(Target Network)技术,提高了学习的稳定性和收敛速度。

### 3.1.2 实践DQN:代码实现和调优技巧

以DQN对Atari游戏进行控制为例,下面展示如何实现DQN的基本框架,并提供一些优化技巧。

```python

import numpy as np

import random

from collections import deque

class DQN:

def __init__(self, state_size, action_size):

self.state_size = state_size

self.action_size = action_size

self.memory = deque(maxlen=2000)

self.gamma = 0.95 # discount rate

self.epsilon = 1.0 # exploration rate

self.epsilon_min = 0.01

self.epsilon_decay = 0.995

# ... (其他初始化代码)

def remember(self, state, action, reward, next_state, done):

self.memory.append((state, action, reward, next_state, done))

def act(self, state):

if np.random.rand() <= self.epsilon:

return random.randrange(self.action_size)

act_values = self.model.predict(state)

return np.argmax(act_values[0]) # returns action

# ... (其他方法如fit等)

model = DQN(state_size, action_size)

def train_dqn(model):

# ... (训练代码)

for episode in range(total_episodes):

# ... (获取初始状态等)

while not game_over:

action = model.act(state)

# ... (采取动作、观察新的状态和奖励等)

model.remember(state, action, reward, next_state, done)

# ... (执行动作、更新状态等)

# ... (更新epsilon和经验回放等)

# ... (训练神经网络模型等)

```

在实现DQN时,需要注意以下几点:

- 经验回放:通过随机抽样之前的经验,DQN打破了时间连续性,这有助于稳定训练过程。

- 目标网络:通过设置一个固定的时间间隔来更新目标网络的参数,可以防止学习过程中的不稳定。

- 探索与利用:通过调整epsilon值,智能体在训练初期会更多地探索,而随着训练的深入,逐渐转向利用已有的知识。

通过适当的调优和参数设置,DQN模型可以在复杂的环境中表现出色,例如在Atari游戏的测试中达到了与人类专家相媲美的水平。

## 3.2 深度确定性策略梯度(DDPG)

DDPG算法将策略梯度方法和深度学习结合起来,特别适合于连续动作空间的问题。DDPG通过在策略网络的基础上增加一个Q网络来评估动作,实现端到端的学习。

### 3.2.1 DDPG算法的理论解释

DDPG的核心在于维持一个策略网络(actor),它输出连续动作,同时维持一个评价网络(critic),它输出一个值函数估计。DDPG利用经验回放和目标网络技术,确保了学习过程的稳定性。

### 3.2.2 DDPG的实战部署和性能分析

以一个简单的模拟环境为例,下面展示如何部署DDPG模型,并分析其性能。

```python

from ddpg_agent import DDPGAgent

import numpy as np

# 初始化DDPG agent

agent = DDPGAgent(state_size=state_size, action_size=action_size, random_seed=2)

# 训练过程

for i_episode in range(num_episodes):

env_info = env.reset(train_mode=True)[brain_name] # 重置环境

state = env_info.vector_observations[0]

agent.reset()

for t in range(max_timesteps):

action = agent.act(state)

env_info = env.step(action)[brain_name]

next_state = env_info.vector_observations[0]

reward = env_info.rewards[0]

done = env_info.local_done[0]

agent.step(state, action, reward, next_state, done)

state = next_state

if done:

break

# ... (打印输出训练日志等)

# ... (测试过程)

```

在部署DDPG模型时,需要关注以下几点:

- 保证足够的探索,特别是在训练初期,避免早期收敛到次优解。

- 使用适当的奖励函数,确保代理学习到的是正确的行为。

- 网络结构的选择和超参数的调整,对模型性能有着直接的影响。

DDPG在许多连续控制任务中展示了优异的性能,如机器人手臂控制等。

## 3.3 异策学习与多智能体系统

异策学习(Heterogeneous Learning)和多智能体系统(Multi-Agent Systems)是深度强化学习中的新趋势。这些技术能够在多个智能体之间进行协调学习,以实现更复杂的目标。

### 3.3.1 异策学习的基本概念

异策学习是指在学习过程中,智能体采用不同的策略进行学习。这种方式能够提高学习的多样性,防止所有智能体采取相同的策略导致的协同失败。

### 3.3.2 多智能体强化学习的应用实例

多智能体强化学习的一个典型应用场景是机器人足球比赛。在这个场景中,每个机器人智能体需要学会与其他智能体协作,共同赢得比赛。

下面是一个简化的多智能体强化学习框架示例:

```python

class MultiAgentEnv:

def __init__(self, n_agents):

self.n_agents = n_agents

# ... (初始化环境等)

def reset(self):

# ... (重置环境状态等)

return states

def step(self, actions):

# ... (执行动作,更新环境状态等)

return states, rewards, dones, infos

env = MultiAgentEnv(n_agents=5)

agents = [Agent() for _ in range(5)] # 假设每个智能体由独立的策略网络控制

for episode in range(num_episodes):

states = env.reset()

while not done:

actions = [agent.act(state) for agent, state in zip(agents, states)]

states, rewards, dones, infos = env.step(actions)

for agent, action, reward, done in zip(agents, actions, rewards, dones):

agent.step(state, action, reward, new_state, done)

```

在多智能体系统中,智能体之间的通信和协作变得至关重要,可能会用到一些专门设计的通信机制。

## 小结

在本章中,我们深入探讨了深度强化学习技术,包括DQN和DDPG的基本原理与实现,以及异策学习和多智能体系统在实际应用中的案例。这些技术极大地扩展了强化学习的能力,使其在处理高维状态空间问题和连续动作空间问题时更加高效。通过精心设计的实验和实践,深度强化学习正在不断推动人工智能领域的发展。

# 4. 强化学习的优化与调优策略

## 4.1 算法稳定性和性能优化

### 稳定性问题和常见解决方案

在强化学习的发展过程中,算法稳定性一直是一个备受关注的问题。算法稳定性差往往意味着策略在训练过程中表现不一致,甚至可能出现性能大幅波动。解决稳定性问题通常从两方面入手:算法层面和实施层面。

从算法层面来看,可以通过引入一定的正则化项,或者采用经验回放(Experience Replay)机制来缓解样本之间的相关性问题,减少策略更新的方差。此外,目标网络(Target Network)的引入也是提高稳定性的一种有效手段,它通过固定一段时间内的目标函数,来稳定学习过程。

在实施层面,数据预处理、状态空间的合理定义、奖励函数的设计都对算法的稳定性有直接影响。例如,对状态空间进行归一化处理,可以减少不同特征值之间的差异性,从而让学习过程更加稳定。

### 性能优化方法和实践案例

性能优化主要集中在提高学习效率和最终策略的性能。一种常见的方法是利用预训练模型或者启发式方法进行引导,从而加速学习过程。例如,在DQN中使用预训练的卷积神经网络来提取状态特征,或者在策略梯度方法中使用已有的策略作为基准来指导学习。

除了算法改进,硬件加速也是提升性能的重要手段。通过使用GPU或者TPU等专用硬件设备,可以大幅度提升模型训练的速度。在策略迁移方面,将模拟环境中获得的策略应用到真实世界时,需要考虑环境的泛化性和鲁棒性。

具体到实践案例,以AlphaGo为例,它采用了蒙特卡洛树搜索(MCTS)与深度学习相结合的技术路线,在围棋领域取得了突破性的成绩。另一个案例是自动驾驶领域,通过模拟环境进行强化学习训练,在实际驾驶中不断优化控制策略。

## 4.2 强化学习在模拟环境中的应用

### 选择合适的模拟环境

模拟环境在强化学习中的作用至关重要,一个良好的模拟环境可以提供无尽的试错机会,并且可以在安全的环境下探索极端情况。因此,在强化学习项目中选择合适的模拟环境是第一步,也是关键一步。

选择模拟环境时,需要考虑以下因素:模拟环境的真实程度、环境动态的多样性、环境的交互复杂性以及反馈的及时性。例如,在进行自动驾驶的研究时,可以使用像CARLA这样的开源自动驾驶模拟器,因为它提供了丰富的城市环境和实时的动态变化。

### 从模拟到现实:策略迁移的挑战

模拟环境虽然有诸多优点,但是如何将学习到的策略应用到现实世界中仍然是一大挑战。这通常被称为策略迁移(Policy Transfer)问题。策略迁移的难点在于模拟环境和现实环境之间存在不可避免的差异,比如物理规律的不同、传感器噪声以及动态对象的行为模式等。

解决策略迁移问题的一个策略是域随机化(Domain Randomization),在模拟环境中引入各种随机因素,使得学习到的策略对环境的变动具有一定的鲁棒性。另一个策略是域自适应(Domain Adaptation),它通过调整模拟环境的参数,使得模拟环境更加接近现实环境。

## 4.3 强化学习的调优工具与框架

### 开源工具和框架介绍

为了方便研究者和开发者实现强化学习算法,市场上已经涌现出一系列优秀的开源工具和框架。这些工具和框架提供了丰富的算法库、工具库和数据结构,大大降低了实现强化学习算法的门槛。

一些主流的强化学习框架包括TensorFlow的TF-Agents、PyTorch的Stable Baselines以及OpenAI的Gym等。它们都支持多种强化学习算法,并提供了从入门到高级的应用示例。开发者可以根据项目需求选择合适的框架进行开发。

### 实战演练:工具框架的使用和比较

在实际应用中,不同的框架会带来不同的开发体验和运行效率。使用这些工具时,我们需要关注它们的易用性、文档齐全程度、社区支持情况以及性能指标。

为了比较这些工具框架,我们可以设计一个简单的强化学习问题,比如解决CartPole平衡问题。然后在不同的框架中用相同或类似的算法实现,比如使用DQN算法。通过比较每个框架在实现过程中的代码量、执行效率、训练稳定性等指标,可以更客观地评价和选择合适的框架。

代码示例和比较结果可以提供给读者,以帮助他们选择和使用这些工具。同时,这些比较也可以指导框架开发者改进自己的产品,使之更适合行业需求。

```python

# 示例代码块:使用Stable Baselines实现CartPole DQN

from stable_baselines import DQN

model = DQN('MlpPolicy', 'CartPole-v1', verbose=1)

model.learn(total_timesteps=10000)

model.save("dqn_cartpole")

```

上述代码展示了一个简单的使用Stable Baselines框架实现DQN算法来解决CartPole问题的过程。通过调用DQN模型,设置环境和参数,最后保存模型,开发者可以快速搭建一个强化学习实验环境。

在性能优化方面,我们还需要分析学习曲线、参数调优以及算法细节的改进,来进一步提高性能。例如,在DQN算法中,可以尝试不同的网络结构,不同的奖励函数设计,以及不同经验回放的策略,来寻找最佳的训练效果。

此外,通过比较不同框架下相同问题的性能,可以为开发者选择合适的工具提供实际参考。以下是使用不同强化学习框架解决问题时可能遇到的优缺点。

| 框架 | 优点 | 缺点 |

| --- | --- | --- |

| TF-Agents | 与TensorFlow集成度高,支持多GPU训练 | 初学者学习曲线较陡 |

| Stable Baselines | 易于上手,文档齐全 | 功能可能不如其他框架全面 |

| OpenAI Gym | 简洁明了,社区活跃 | 功能相对单一,缺乏深度学习支持 |

通过上述的分析和代码示例,我们可以看到,选择合适的工具和框架对于强化学习项目的成功至关重要。不同的工具和框架有着各自的优势和局限,通过实际的比较和分析,可以更好地指导开发者在项目中做出正确的选择。

# 5. 未来趋势与深入研究

随着机器学习和人工智能的快速发展,强化学习作为其中的一个重要分支,也在不断地扩展其应用领域,并探索新的研究方向。本章节将深入探讨强化学习的前沿动态、交叉研究领域以及持续学习与在线学习的最新研究进展。

## 5.1 强化学习的前沿动态

强化学习的前沿动态聚焦于其在多个领域的最新研究成果,以及这些成果对未来行业应用的潜在影响。

### 5.1.1 最新研究成果与论文解读

在最新的研究成果中,一些研究团队专注于提升算法效率和稳定性,而另一些则探索算法在特定领域的应用,如机器人控制、游戏AI、自动驾驶等。这些研究往往发表在顶尖的AI会议上,如NeurIPS、ICML以及AAAI。

近年来,一系列论文提出了新的算法改进,例如利用元学习(meta-learning)的快速适应能力,以及通过多智能体学习(multi-agent learning)来解决复杂环境中的协调问题。这些研究为强化学习领域带来了新的活力,同时也为其他研究提供了丰富的参考资料和灵感来源。

### 5.1.2 行业应用和未来展望

在实际的行业应用中,强化学习已经开始逐渐显示出其独特的价值。例如,在游戏领域,Google DeepMind开发的AlphaGo和AlphaZero使用了强化学习技术,展示了其在复杂决策环境中的巨大潜力。在工业自动化、智能推荐系统和金融市场分析等其他行业,强化学习也正在逐渐被采用。

未来,随着计算能力的增强和算法的进一步优化,我们可以期待强化学习能够在更广泛的场景中发挥作用,如智能城市管理、个性化医疗和可持续能源管理等。此外,结合云计算和边缘计算等新兴技术,强化学习将在实时决策和大规模优化问题上展现其独特优势。

## 5.2 强化学习的交叉研究领域

强化学习与其他机器学习领域的交叉研究,如深度学习、自然语言处理等,为解决更复杂的问题提供了新的视角和方法。

### 5.2.1 结合其他机器学习领域的发展

强化学习与深度学习的结合产生了深度强化学习(deep reinforcement learning, DRL),极大地增强了学习算法的泛化能力。DRL在处理高维输入数据,如图像和声音时,表现出色,能够在没有明确特征工程的情况下自动提取有用的特征。

同时,自然语言处理(NLP)与强化学习的结合为对话系统、机器翻译和文本生成等领域带来了新的突破。例如,序列到序列(seq2seq)模型的强化学习版本可以在翻译和文本摘要任务上实现更优的性能。

### 5.2.2 探索强化学习的多学科交叉应用

多学科交叉应用是未来强化学习发展的一个重要方向。在认知科学领域,研究人员利用强化学习模型来模拟和解释人类的学习和决策过程。在经济学领域,强化学习被用于预测市场动态和制定投资策略。此外,强化学习在环境科学、社会科学和教育等领域也有广泛的应用前景。

这种跨学科的研究不仅能够推动强化学习技术的发展,还能为其他学科带来新的研究工具和方法,促进学科间的知识融合和技术革新。

## 5.3 持续学习与在线学习

持续学习和在线学习是强化学习领域中用于处理持续变化环境的关键技术,它们使智能体能够在长期运行过程中不断优化自己的策略。

### 5.3.1 持续学习机制的实现

持续学习(continual learning)或生命长期学习(lifelong learning)关注于如何让智能体在面对不断变化的任务或环境时,能够保留过去的经验并快速适应新的学习任务。实现持续学习机制的一个挑战是避免“灾难性遗忘”(catastrophic forgetting),即智能体在学习新知识时忘记之前学到的知识。

研究人员提出了一些策略来缓解这一问题,如使用经验回放(experience replay)来周期性地复习旧任务数据,以及通过正则化技术来保持知识的稳定性。这些策略为构建更为健壮的持续学习系统提供了可能。

### 5.3.2 在线学习环境下的算法挑战

在线学习(online learning)是指智能体在实时交互的环境中连续地进行学习和决策。在线学习环境下的算法面临着诸多挑战,包括样本效率、延迟反馈以及非平稳环境等问题。

为了应对这些挑战,研究者们开发了各种在线强化学习算法,例如使用增量学习(incremental learning)技术逐步更新策略,以及利用元学习方法快速适应新任务。这些算法正在逐渐改善智能体在复杂和动态环境中的表现能力。

在这一节中,我们讨论了强化学习未来的发展趋势和前沿研究方向。随着技术的进步和应用领域的扩展,强化学习将在构建更加智能化的系统中扮演更加重要的角色。在下一节中,我们将探讨如何将这些研究转化为实际应用,以及如何准备迎接未来的挑战。

0

0