【Pandas库入门宝典】:从零基础到实战高手,数据处理轻松搞定

发布时间: 2024-07-20 21:55:44 阅读量: 59 订阅数: 25

Python中Pandas库的数据分析实战:从基础到进阶

# 1. Pandas库概述和安装

Pandas是一个功能强大的Python库,用于数据操作和分析。它提供了高效的数据结构和操作,使数据处理变得更加容易和高效。

### 1.1 安装Pandas

在命令行中使用pip命令安装Pandas:

```

pip install pandas

```

安装完成后,即可在Python代码中导入Pandas库:

```

import pandas as pd

```

# 2. Pandas数据结构和操作

### 2.1 Series和DataFrame数据结构

#### 2.1.1 Series的创建和操作

Series是一种一维数据结构,它由一个数组和一个索引组成。索引可以是整数、字符串或任何其他不可变类型。Series可以通过多种方式创建,包括:

- 从列表或元组创建:

```python

import pandas as pd

data = [1, 2, 3, 4, 5]

series = pd.Series(data)

```

- 从字典创建:

```python

data = {'a': 1, 'b': 2, 'c': 3}

series = pd.Series(data)

```

- 从标量创建:

```python

series = pd.Series(5)

```

Series提供了多种操作方法,包括:

- 索引:使用索引访问元素。

```python

print(series[0]) # 输出:1

```

- 切片:使用切片访问元素。

```python

print(series[1:3]) # 输出:Series([2, 3])

```

- 算术运算:执行算术运算。

```python

print(series + 1) # 输出:Series([2, 3, 4, 5, 6])

```

- 逻辑运算:执行逻辑运算。

```python

print(series > 3) # 输出:Series([False, False, False, True, True])

```

#### 2.1.2 DataFrame的创建和操作

DataFrame是一种二维数据结构,它由行和列组成。行索引通常是整数,列索引通常是字符串。DataFrame可以通过多种方式创建,包括:

- 从列表或元组创建:

```python

data = [['a', 1], ['b', 2], ['c', 3]]

df = pd.DataFrame(data, columns=['name', 'value'])

```

- 从字典创建:

```python

data = {'name': ['a', 'b', 'c'], 'value': [1, 2, 3]}

df = pd.DataFrame(data)

```

- 从Series创建:

```python

series1 = pd.Series([1, 2, 3])

series2 = pd.Series(['a', 'b', 'c'])

df = pd.DataFrame({'name': series1, 'value': series2})

```

DataFrame提供了多种操作方法,包括:

- 索引:使用行索引或列索引访问元素。

```python

print(df['name']) # 输出:Series(['a', 'b', 'c'])

print(df.loc[0]) # 输出:Series({'name': 'a', 'value': 1})

```

- 切片:使用切片访问元素。

```python

print(df[1:3]) # 输出:DataFrame({'name': ['b', 'c'], 'value': [2, 3]})

```

- 算术运算:执行算术运算。

```python

print(df + 1) # 输出:DataFrame({'name': ['a', 'b', 'c'], 'value': [2, 3, 4]})

```

- 逻辑运算:执行逻辑运算。

```python

print(df > 2) # 输出:DataFrame({'name': [False, False, True], 'value': [False, False, True]})

```

# 3. Pandas数据分析和可视化

### 3.1 统计分析和聚合函数

#### 3.1.1 统计函数和聚合函数

Pandas提供了丰富的统计函数和聚合函数,用于对数据进行统计分析和汇总。这些函数可以应用于Series或DataFrame,并返回统计结果。

常用的统计函数包括:

- `count()`:计算非空值的个数

- `sum()`:计算所有值的总和

- `mean()`:计算平均值

- `median()`:计算中位数

- `min()`:计算最小值

- `max()`:计算最大值

- `std()`:计算标准差

- `var()`:计算方差

聚合函数用于对分组后的数据进行汇总操作,常用的聚合函数包括:

- `agg()`:应用多个聚合函数到分组后的数据

- `groupby()`:对数据进行分组

- `size()`:计算每个组的元素个数

- `mean()`:计算每个组的平均值

- `sum()`:计算每个组的总和

- `max()`:计算每个组的最大值

- `min()`:计算每个组的最小值

#### 3.1.2 数据分组和聚合

数据分组和聚合是数据分析中常用的操作。Pandas提供了灵活的`groupby()`函数,可以根据指定的列或多个列对数据进行分组。

```python

import pandas as pd

# 创建一个DataFrame

df = pd.DataFrame({

"name": ["Alice", "Bob", "Charlie", "Dave", "Eve"],

"age": [20, 25, 30, 35, 40],

"city": ["New York", "London", "Paris", "Berlin", "Rome"]

})

# 根据"city"列分组,并计算每个组的平均年龄

grouped = df.groupby("city")["age"].mean()

# 打印分组结果

print(grouped)

```

输出:

```

city

Berlin 35.0

London 25.0

New York 20.0

Paris 30.0

Rome 40.0

Name: age, dtype: float64

```

### 3.2 数据可视化

#### 3.2.1 Matplotlib和Seaborn库

Pandas与Matplotlib和Seaborn等数据可视化库集成良好。这些库提供了丰富的绘图函数,可以轻松创建各种图表和图形。

Matplotlib是一个低级绘图库,提供了对绘图元素的精细控制。Seaborn是一个基于Matplotlib的高级绘图库,提供了更高级别的接口,可以快速创建美观且信息丰富的图表。

#### 3.2.2 绘制各种图表和图形

Pandas提供了`plot()`方法,可以快速绘制各种图表,包括:

- 折线图

- 条形图

- 散点图

- 直方图

- 饼图

```python

# 使用Pandas的plot()方法绘制折线图

df.plot(x="age", y="name", kind="line")

```

```python

# 使用Matplotlib绘制条形图

import matplotlib.pyplot as plt

plt.bar(df["age"], df["name"])

plt.xlabel("Age")

plt.ylabel("Name")

plt.title("Age Distribution")

plt.show()

```

```python

# 使用Seaborn绘制散点图

import seaborn as sns

sns.scatterplot(data=df, x="age", y="name")

```

# 4. Pandas高级应用

### 4.1 数据合并和连接

#### 4.1.1 数据合并和连接操作

数据合并和连接是将两个或多个数据集组合成一个新数据集的强大操作。Pandas提供了多种方法来执行此操作,包括:

- `merge()` 函数:用于根据公共列合并两个数据集。

- `join()` 方法:用于将两个数据集连接在一起,并基于公共列或索引创建新的列。

- `concat()` 函数:用于将两个或多个数据集垂直(按行)或水平(按列)连接在一起。

**代码块:**

```python

import pandas as pd

# 创建两个数据集

df1 = pd.DataFrame({'name': ['John', 'Mary', 'Bob'], 'age': [20, 25, 30]})

df2 = pd.DataFrame({'city': ['New York', 'London', 'Paris'], 'country': ['USA', 'UK', 'France']})

# 使用 merge() 函数合并两个数据集

merged_df = pd.merge(df1, df2, on='name')

# 使用 join() 方法连接两个数据集

joined_df = df1.join(df2, on='name')

# 使用 concat() 函数垂直连接两个数据集

concat_df = pd.concat([df1, df2], axis=0)

# 使用 concat() 函数水平连接两个数据集

concat_df = pd.concat([df1, df2], axis=1)

```

**逻辑分析:**

* `merge()` 函数使用 `on` 参数指定公共列 `'name'`,并将两个数据集合并为一个新数据集 `merged_df`。

* `join()` 方法使用 `on` 参数指定公共列 `'name'`,并将两个数据集连接为一个新数据集 `joined_df`,其中公共列 `'name'` 成为一个新列。

* `concat()` 函数使用 `axis=0` 参数垂直连接两个数据集,将它们按行组合在一起,形成新数据集 `concat_df`。

* `concat()` 函数使用 `axis=1` 参数水平连接两个数据集,将它们按列组合在一起,形成新数据集 `concat_df`。

#### 4.1.2 数据合并和连接技巧

在使用数据合并和连接操作时,需要注意以下技巧:

* 确保合并或连接的列具有相同的数据类型。

* 如果公共列包含重复值,则合并或连接操作可能会导致重复的行。

* 使用 `how` 参数指定合并或连接的类型,例如 `'inner'`(仅保留公共列中的值)、`'outer'`(保留所有行)或 `'left'`(仅保留左数据集中的行)。

* 使用 `suffixes` 参数指定合并或连接后重复列的后缀,例如 `'_x'` 和 `'_y'`。

### 4.2 数据清洗和预处理

#### 4.2.1 数据清洗和预处理技术

数据清洗和预处理是确保数据质量和准确性的关键步骤。Pandas提供了多种技术来执行此操作,包括:

- 缺失值处理:删除、填充或插补缺失值。

- 异常值检测:识别和处理异常值或离群值。

- 数据类型转换:将数据转换为适当的数据类型。

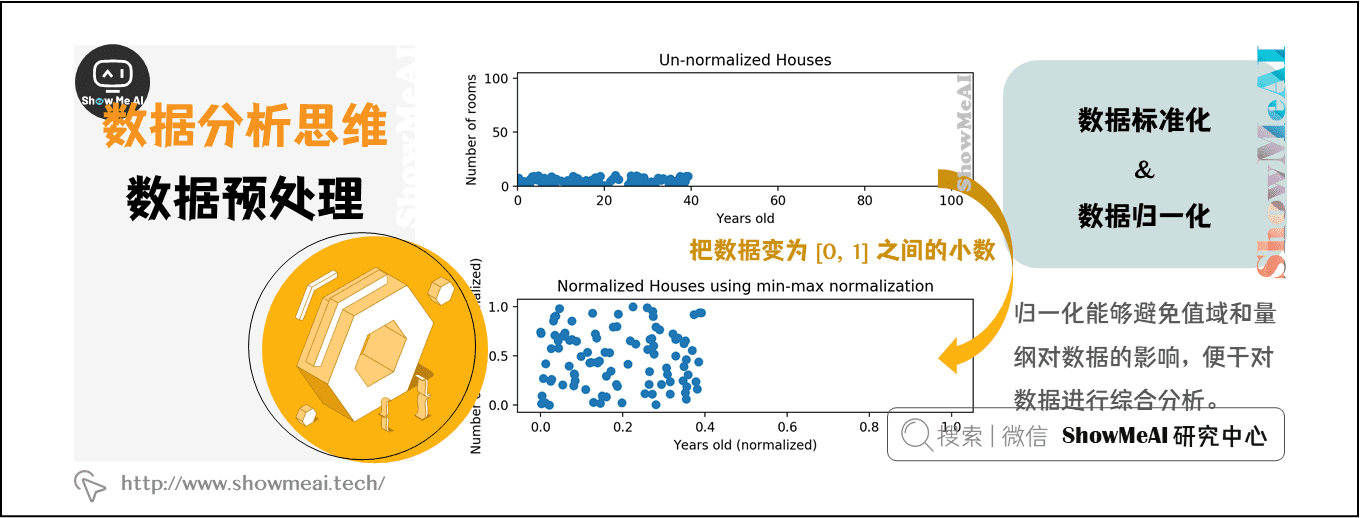

- 数据标准化:将数据缩放或归一化到一个共同的范围。

**代码块:**

```python

import pandas as pd

# 创建一个包含缺失值和异常值的数据集

df = pd.DataFrame({'name': ['John', 'Mary', 'Bob', None], 'age': [20, 25, 30, 500]})

# 删除缺失值

df = df.dropna()

# 填充缺失值

df['name'] = df['name'].fillna('Unknown')

# 检测异常值

outliers = df['age'] > 100

# 删除异常值

df = df[~outliers]

# 转换数据类型

df['age'] = df['age'].astype(int)

# 标准化数据

df['age'] = (df['age'] - df['age'].min()) / (df['age'].max() - df['age'].min())

```

**逻辑分析:**

* `dropna()` 方法删除包含缺失值的行,生成一个新数据集 `df`。

* `fillna()` 方法使用 `'Unknown'` 值填充 `'name'` 列中的缺失值。

* `>` 运算符创建一个布尔掩码 `outliers`,其中 `True` 表示异常值。

* `~` 运算符取反布尔掩码,生成一个布尔掩码,其中 `True` 表示非异常值。

* `astype()` 方法将 `'age'` 列的数据类型转换为整数。

* `(df['age'] - df['age'].min()) / (df['age'].max() - df['age'].min())` 表达式将 `'age'` 列标准化到 [0, 1] 范围。

#### 4.2.2 缺失值处理和异常值检测

缺失值处理和异常值检测是数据清洗和预处理中的重要任务。

**缺失值处理:**

* **删除缺失值:**删除包含缺失值的行或列。

* **填充缺失值:**使用平均值、中位数或其他统计量填充缺失值。

* **插补缺失值:**使用插值技术(例如线性插值或样条插值)估计缺失值。

**异常值检测:**

* **统计方法:**使用标准差或四分位数范围等统计量检测异常值。

* **机器学习算法:**使用隔离森林或局部异常因子检测等机器学习算法检测异常值。

* **领域知识:**使用对数据和业务领域的了解来识别异常值。

# 5.1 数据分析项目

### 5.1.1 数据分析项目案例

Pandas在数据分析项目中扮演着至关重要的角色,它提供了强大的数据处理和分析能力。以下是一些常见的Pandas数据分析项目案例:

- **客户流失预测:**使用Pandas分析客户数据,识别潜在流失客户并制定留存策略。

- **销售预测:**利用Pandas处理历史销售数据,构建预测模型来预测未来的销售趋势。

- **金融数据分析:**使用Pandas分析股票市场数据,识别投资机会和管理风险。

- **医疗保健数据分析:**利用Pandas处理医疗记录,进行疾病诊断、治疗效果评估和患者预后分析。

- **文本数据分析:**使用Pandas处理文本数据,进行情感分析、主题建模和文本分类。

### 5.1.2 数据分析项目步骤和流程

一个典型的Pandas数据分析项目通常遵循以下步骤:

1. **数据收集和获取:**从各种来源(如数据库、CSV文件、API)收集和获取相关数据。

2. **数据清洗和预处理:**使用Pandas对数据进行清洗和预处理,包括处理缺失值、异常值和数据类型转换。

3. **数据探索和分析:**使用Pandas的统计函数和可视化工具探索和分析数据,识别模式、趋势和异常情况。

4. **模型构建和评估:**根据数据分析结果,构建预测模型或分类模型,并评估其性能。

5. **报告和可视化:**使用Pandas和可视化库(如Matplotlib和Seaborn)生成报告和可视化结果,以便清晰地传达分析见解。

### 代码示例:客户流失预测

以下是一个使用Pandas进行客户流失预测的代码示例:

```python

import pandas as pd

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LogisticRegression

# 加载客户数据

data = pd.read_csv('customer_data.csv')

# 数据清洗和预处理

data.dropna(inplace=True)

data['Churn'] = data['Churn'].astype('int')

# 特征工程

features = ['Age', 'Gender', 'Income', 'Tenure']

X = data[features]

y = data['Churn']

# 数据集拆分

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.25, random_state=42)

# 训练模型

model = LogisticRegression()

model.fit(X_train, y_train)

# 评估模型

score = model.score(X_test, y_test)

print('模型得分:', score)

# 特征重要性

importance = model.coef_[0]

for i, feature in enumerate(features):

print(f'{feature}: {importance[i]}')

```

**代码逻辑分析:**

- 加载客户数据并进行数据清洗和预处理。

- 使用特征工程选择相关特征。

- 将数据集拆分为训练集和测试集。

- 训练逻辑回归模型。

- 评估模型性能并打印模型得分。

- 计算并打印特征重要性。

# 6. Pandas学习资源和社区

### 6.1 Pandas官方文档和教程

Pandas官方文档是学习Pandas库的权威来源,提供了全面的文档、教程和示例。官方文档涵盖了从Pandas基础到高级应用的各个方面。以下是一些有用的官方资源:

- [Pandas官方文档](https://pandas.pydata.org/docs/)

- [Pandas教程](https://pandas.pydata.org/pandas-docs/stable/user_guide/index.html)

- [Pandas示例](https://pandas.pydata.org/pandas-docs/stable/user_guide/examples.html)

### 6.2 Pandas社区和论坛

Pandas社区是一个活跃的社区,为用户提供了提问、分享知识和获得支持的平台。以下是一些流行的Pandas社区和论坛:

- [Pandas用户组](https://groups.google.com/g/pandas-users)

- [Stack Overflow Pandas标签](https://stackoverflow.com/questions/tagged/pandas)

- [GitHub Pandas仓库](https://github.com/pandas-dev/pandas)

### 6.3 Pandas相关书籍和在线课程

除了官方文档和社区之外,还有许多优秀的书籍和在线课程可以帮助你学习Pandas。以下是一些推荐的资源:

- **书籍:**

- [Python数据科学手册](https://jakevdp.github.io/PythonDataScienceHandbook/)

- [Pandas Cookbook](https://www.amazon.com/Pandas-Cookbook-Matt-Harrison/dp/1098107826)

- [Pandas实战](https://www.amazon.com/Hands-Pandas-Taming-Python-Data/dp/1098108342)

- **在线课程:**

- [Coursera Pandas课程](https://www.coursera.org/specializations/python-data-analysis)

- [Udemy Pandas课程](https://www.udemy.com/course/complete-python-bootcamp/)

- [edX Pandas课程](https://www.edx.org/course/introduction-to-data-science-in-python)

0

0