揭秘Pandas数据清洗秘籍:让脏数据无处遁形,分析更精准

发布时间: 2024-07-20 21:57:33 阅读量: 35 订阅数: 43

# 1. Pandas数据清洗概述**

数据清洗是数据分析和机器学习中的关键步骤,它涉及识别、纠正和处理数据中的错误和不一致。Pandas是Python中用于数据操作和分析的流行库,它提供了广泛的数据清洗功能。

在本章中,我们将介绍Pandas数据清洗的基础知识,包括:

* 数据清洗的重要性及其在数据分析中的作用

* Pandas库中可用的数据清洗功能

* 数据清洗的常见步骤和技术

# 2. 数据清洗基础

### 2.1 数据类型检测和转换

**数据类型检测**

Pandas提供了`dtypes`属性来检测数据框中每列的数据类型:

```python

import pandas as pd

df = pd.DataFrame({'name': ['John', 'Mary', 'Bob'], 'age': [20, 25, 30]})

print(df.dtypes)

```

输出:

```

name object

age int64

dtype: object

```

**数据类型转换**

Pandas提供了`astype()`方法来转换数据类型:

```python

df['age'] = df['age'].astype(float)

print(df.dtypes)

```

输出:

```

name object

age float64

dtype: object

```

### 2.2 缺失值处理

**检测缺失值**

Pandas提供了`isnull()`和`notnull()`方法来检测缺失值:

```python

print(df.isnull())

print(df.notnull())

```

输出:

```

name age

0 False False

1 False False

2 False False

name age

0 True True

1 True True

2 True True

```

**处理缺失值**

* **删除缺失值:**`dropna()`方法可以删除包含缺失值的整个行或列。

* **填充缺失值:**`fillna()`方法可以填充缺失值,可以使用指定值、平均值或中位数等。

```python

# 删除缺失值

df.dropna(inplace=True)

# 填充缺失值

df['age'].fillna(df['age'].mean(), inplace=True)

```

### 2.3 重复数据处理

**检测重复数据**

Pandas提供了`duplicated()`方法来检测重复数据:

```python

print(df.duplicated())

```

输出:

```

False False False

dtype: bool

```

**删除重复数据**

Pandas提供了`drop_duplicates()`方法来删除重复数据:

```python

df.drop_duplicates(inplace=True)

```

# 3. 高级数据清洗技术

### 3.1 正则表达式清洗

正则表达式(Regex)是一种强大的模式匹配语言,广泛用于数据清洗中。它允许您使用模式来搜索和替换字符串中的文本。

#### 正则表达式语法

正则表达式语法包括以下元素:

- **字符类:**匹配特定字符集,如 `[abc]`、`[0-9]`

- **元字符:**具有特殊含义的字符,如 `.`(匹配任何字符)、`*`(匹配零次或多次)

- **量词:**指定匹配次数,如 `{3}`(匹配 3 次)、`+`(匹配一次或多次)

- **分组:**使用圆括号将模式分组,以便以后引用

#### 正则表达式清洗示例

以下示例演示如何使用正则表达式清洗数据:

```python

import pandas as pd

# 创建 DataFrame

df = pd.DataFrame({'name': ['John Doe', 'Jane Doe', 'John Smith', 'Jane Smith'],

'email': ['john.doe@example.com', 'jane.doe@example.com', 'john.smith@example.com', 'jane.smith@example.com']})

# 提取姓氏

df['last_name'] = df['name'].str.extract(r'(\w+)\s+(\w+)')

# 替换电子邮件中的点

df['email'] = df['email'].str.replace(r'\.', '_')

```

**代码逻辑分析:**

- `df['name'].str.extract(r'(\w+)\s+(\w+)')`:使用正则表达式模式 `(\w+)\s+(\w+)` 提取姓氏。`(\w+)` 匹配一个或多个单词字符,`\s+` 匹配一个或多个空格字符。

- `df['email'].str.replace(r'\.', '_')`:使用正则表达式模式 `\.` 替换电子邮件中的点为下划线。

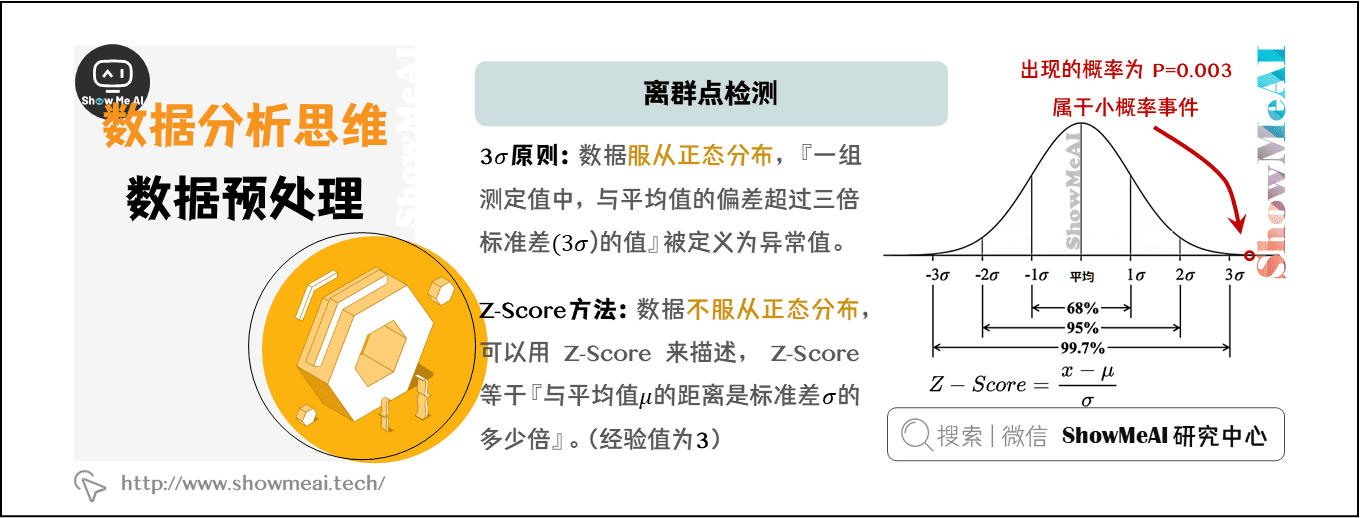

### 3.2 异常值检测和处理

异常值是与数据集中的其他数据点明显不同的数据点。它们可能由数据输入错误、测量错误或其他原因引起。检测和处理异常值对于确保数据的准确性和可靠性至关重要。

#### 异常值检测方法

常见的异常值检测方法包括:

- **统计方法:**使用标准差或四分位数范围等统计指标识别异常值

- **机器学习算法:**使用孤立森林或局部异常因子检测算法检测异常值

#### 异常值处理技术

异常值处理技术包括:

- **删除:**从数据集中删除异常值

- **替换:**用中位数或平均值等统计指标替换异常值

- **转换:**将异常值转换为更接近正常范围的值

#### 异常值检测和处理示例

以下示例演示如何检测和处理异常值:

```python

import pandas as pd

import numpy as np

# 创建 DataFrame

df = pd.DataFrame({'age': [20, 25, 30, 35, 40, 50, 100]})

# 检测异常值(年龄超过 60)

outliers = df[df['age'] > 60]

# 替换异常值

df['age'] = df['age'].replace(outliers['age'], np.nan)

```

**代码逻辑分析:**

- `df[df['age'] > 60]`:使用布尔索引检测年龄超过 60 的异常值。

- `df['age'].replace(outliers['age'], np.nan)`:用 `np.nan` 替换异常值。

### 3.3 数据标准化和归一化

数据标准化和归一化是将数据转换为具有更一致范围和分布的技术。这对于机器学习和数据分析至关重要,因为它可以提高模型的性能和结果的可比性。

#### 数据标准化

数据标准化通过减去均值并除以标准差将数据转换为均值为 0、标准差为 1 的分布。

#### 数据归一化

数据归一化通过将数据转换为 0 到 1 之间的范围,使数据具有相同的范围。

#### 标准化和归一化示例

以下示例演示如何对数据进行标准化和归一化:

```python

import pandas as pd

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# 创建 DataFrame

df = pd.DataFrame({'age': [20, 25, 30, 35, 40, 50],

'height': [1.70, 1.75, 1.80, 1.85, 1.90, 1.95]})

# 标准化年龄

scaler = StandardScaler()

df['age_std'] = scaler.fit_transform(df['age'].values.reshape(-1, 1))

# 归一化身高

scaler = MinMaxScaler()

df['height_norm'] = scaler.fit_transform(df['height'].values.reshape(-1, 1))

```

**代码逻辑分析:**

- `scaler.fit_transform(df['age'].values.reshape(-1, 1))`:使用 `StandardScaler` 对年龄进行标准化。`reshape(-1, 1)` 将数据转换为一维数组。

- `scaler.fit_transform(df['height'].values.reshape(-1, 1))`:使用 `MinMaxScaler` 对身高进行归一化。

# 4. Pandas数据清洗实践

### 4.1 数据导入和预处理

**数据导入**

Pandas提供多种数据导入方法,包括:

- `read_csv()`: 从CSV文件导入数据

- `read_excel()`: 从Excel文件导入数据

- `read_json()`: 从JSON文件导入数据

- `read_sql()`: 从SQL数据库导入数据

**代码块:**

```python

import pandas as pd

# 从CSV文件导入数据

df = pd.read_csv('data.csv')

# 从Excel文件导入数据

df = pd.read_excel('data.xlsx')

# 从JSON文件导入数据

df = pd.read_json('data.json')

# 从SQL数据库导入数据

df = pd.read_sql('SELECT * FROM table', 'sqlite:///data.db')

```

**参数说明:**

- `filepath`: 数据文件路径

- `index_col`: 指定索引列

- `header`: 指定表头行数

- `dtype`: 指定数据类型

**逻辑分析:**

Pandas根据文件类型自动检测数据类型,但也可以通过`dtype`参数手动指定。指定索引列可以提高数据访问效率。

**数据预处理**

数据预处理包括以下步骤:

- **数据类型转换:**将数据类型转换为适当的格式,例如将字符串转换为数字。

- **缺失值处理:**处理缺失值,例如用均值或中位数填充。

- **重复数据处理:**删除或保留重复数据。

**代码块:**

```python

# 数据类型转换

df['age'] = df['age'].astype(int)

# 缺失值处理

df['salary'].fillna(df['salary'].mean(), inplace=True)

# 重复数据处理

df.drop_duplicates(inplace=True)

```

**参数说明:**

- `astype()`: 指定目标数据类型

- `fillna()`: 指定填充值

- `inplace`: 直接修改数据框

**逻辑分析:**

数据类型转换确保数据的一致性。缺失值处理防止数据分析中的错误。重复数据处理避免冗余和数据偏差。

### 4.2 数据清洗案例分析

**案例:客户数据清洗**

**任务:**清洗客户数据,包括:

- 删除无效的电子邮件地址

- 标准化姓名格式

- 处理缺失的电话号码

**代码块:**

```python

# 删除无效的电子邮件地址

df = df[df['email'].str.contains('@')]

# 标准化姓名格式

df['name'] = df['name'].str.title()

# 处理缺失的电话号码

df['phone'].fillna('N/A', inplace=True)

```

**参数说明:**

- `str.contains()`: 检查字符串是否包含指定子字符串

- `str.title()`: 将字符串转换为首字母大写格式

**逻辑分析:**

通过正则表达式删除无效的电子邮件地址。使用`str.title()`标准化姓名格式,确保一致性。用`N/A`填充缺失的电话号码,表示不可用。

### 4.3 数据清洗自动化

**自动化脚本**

Pandas提供自动化数据清洗功能,例如:

- **`apply()`方法:**对数据框中的每一行或列应用函数。

- **`pipe()`方法:**将数据框作为管道传递给一组函数。

**代码块:**

```python

# 使用apply()方法标准化姓名格式

df['name'] = df['name'].apply(lambda x: x.title())

# 使用pipe()方法自动化数据清洗

df.pipe(lambda df: df.dropna()).pipe(lambda df: df.drop_duplicates())

```

**参数说明:**

- `apply()`: 应用指定函数

- `pipe()`: 将数据框传递给函数管道

**逻辑分析:**

`apply()`方法允许对数据框中的每个元素执行自定义操作。`pipe()`方法提供了一种简便的方法来链接多个数据清洗操作。

# 5.1 数据清洗流程优化

数据清洗流程优化旨在提高数据清洗效率和准确性。以下是一些优化策略:

- **自动化数据清洗:**使用Pandas内置函数或第三方库自动化重复性任务,例如缺失值处理、数据类型转换和重复数据删除。

- **并行处理:**利用多核处理器并行执行数据清洗任务,以缩短处理时间。

- **数据验证:**在数据清洗过程中进行数据验证,以确保清洗后的数据满足预期要求。

- **单元测试:**编写单元测试来验证数据清洗函数的正确性,确保数据清洗流程的稳定性。

- **性能优化:**通过优化数据结构、使用索引和避免不必要的计算来提高数据清洗性能。

## 5.2 数据清洗工具选择

选择合适的工具对于高效的数据清洗至关重要。以下是一些考虑因素:

- **功能性:**评估工具是否提供所需的数据清洗功能,例如缺失值处理、重复数据删除和数据标准化。

- **易用性:**选择易于使用和理解的工具,以减少学习曲线和提高生产率。

- **可扩展性:**考虑工具的可扩展性,以处理大型数据集和复杂的数据清洗任务。

- **集成性:**评估工具是否与其他数据处理工具和平台集成,以实现无缝的工作流。

- **成本:**考虑工具的成本,包括许可证费用、支持费用和维护成本。

## 5.3 数据清洗质量评估

数据清洗质量评估对于确保清洗后的数据满足预期要求至关重要。以下是一些评估方法:

- **数据完整性:**验证清洗后的数据是否完整,没有缺失值或重复值。

- **数据准确性:**检查清洗后的数据是否准确,没有错误或异常值。

- **数据一致性:**确保清洗后的数据与其他相关数据集一致,没有矛盾或冲突。

- **数据格式:**验证清洗后的数据是否符合预期的格式和数据类型。

- **数据可视化:**使用数据可视化工具,例如直方图和散点图,检查清洗后的数据分布和模式,以识别潜在问题。

0

0