深入理解Python线性表:性能优化的5大实战技巧

发布时间: 2024-09-12 08:30:26 阅读量: 39 订阅数: 23

# 1. Python线性表的基础概念和特性

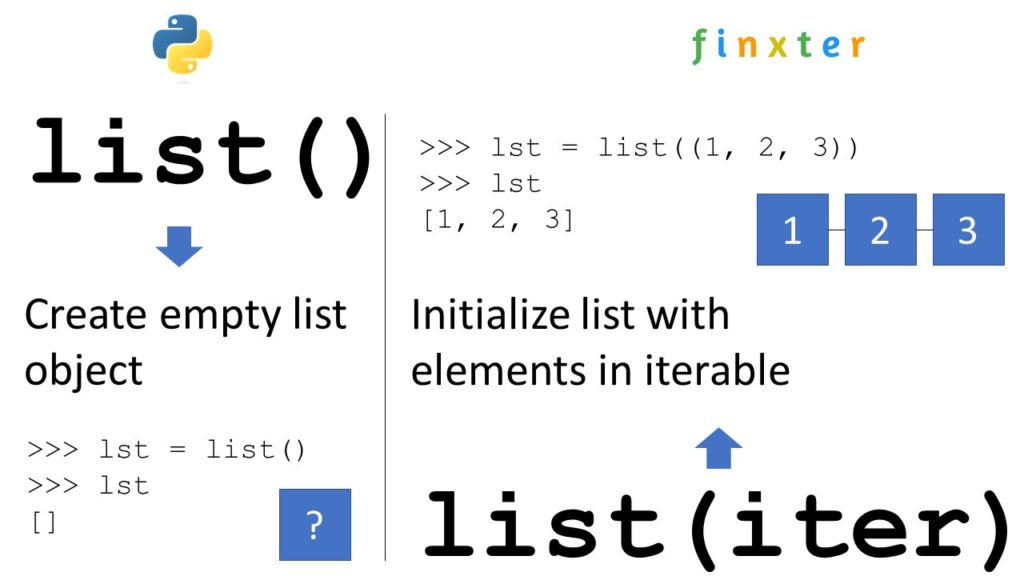

线性表是计算机科学中应用极为广泛的一种数据结构,特别是在Python这样高级的编程语言中,线性表可以以多种方式实现,包括列表(List)和元组(Tuple)等。这些结构在内存中的表现形式不同,也影响了其在运行时的性能。

## 1.1 线性表的定义和分类

在计算机科学中,线性表是一种顺序存储的线性结构,每个元素都有一个前驱和一个后继,除了第一个元素和最后一个元素。线性表可以是静态的,也可以是动态的,这取决于它们是否允许在执行期间改变其大小。在Python中,列表是动态的线性表,而元组是静态的。

## 1.2 线性表的基本操作

线性表的基本操作包括插入、删除和查找等,这些操作在列表和元组中实现方式不同。列表提供动态数组的特性,允许在任何位置插入和删除元素,而元组的不可变性意味着一旦创建了元组,就不能更改其内容,只能进行读取操作。

接下来的章节中,我们将深入探讨线性表的性能分析与优化理论,以及如何在实际开发中应用这些理论知识。

# 2. 线性表的性能分析与优化理论

在深入探讨线性表的性能分析与优化之前,需要了解线性表的定义和它在Python中的基本实现。线性表是一种常见的数据结构,它具有零个或多个数据元素的有限序列。在Python中,列表(List)和元组(Tuple)是线性表的两种主要实现形式。为了深入理解线性表的性能特点,本章将首先介绍线性表的基本性能指标,然后分别探讨Python内置线性表的性能特点,以及在大数据量下操作线性表时可能遇到的性能瓶颈。

## 2.1 线性表的基本性能指标

### 2.1.1 时间复杂度分析

在数据结构和算法的研究中,时间复杂度是用来衡量一个操作或算法运行时间的增长率。它是性能分析中的关键指标之一,通常用大O符号表示。对于线性表而言,常见的操作如插入、删除和查找的时间复杂度如下:

- 插入操作:列表和元组在尾部插入的时间复杂度为O(1),在头部或其他位置插入的时间复杂度为O(n)。

- 删除操作:列表在尾部删除的时间复杂度为O(1),在头部删除的时间复杂度为O(1),在其他位置删除的时间复杂度为O(n)。

- 查找操作:查找特定元素的时间复杂度为O(n),无论是在列表还是元组中。

### 2.1.2 空间复杂度分析

空间复杂度是指执行算法所需的存储空间与输入数据大小之间的关系。对于线性表,其空间复杂度通常为O(n),其中n是表中的元素个数。然而,空间使用上的差异主要在于列表和元组的动态扩容机制以及内存占用的不同。

## 2.2 Python内置线性表性能探讨

### 2.2.1 列表(List)的性能特点

Python中的列表是一个可变序列类型,它在内存中以连续的方式存储数据。这使得列表具有以下特点:

- 索引访问:列表支持通过索引进行快速访问,时间复杂度为O(1)。

- 动态扩容:当列表元素数量增加时,Python会动态调整列表所占用的内存大小,这会带来额外的开销。

- 插入和删除操作:在列表中间插入或删除元素需要移动元素,导致较高的时间复杂度。

### 2.2.2 元组(Tuple)的性能特点

元组与列表类似,也是一个线性表,但是它是不可变的。元组在性能上的特点包括:

- 索引访问:与列表相同,元组的索引访问时间复杂度为O(1)。

- 不可变性:元组一旦创建,其内容就不能修改,这意味着它可以被缓存并重用,从而优化性能。

- 内存占用:元组通常比列表占用更少的内存,因为它不需要额外的内存空间用于存储指针。

## 2.3 线性表操作的性能瓶颈

### 2.3.1 大数据量下的性能表现

随着线性表中元素数量的增加,性能问题变得越来越明显。例如,在大数据量下进行迭代、排序或查找操作时,时间复杂度较高的操作可能会导致程序运行缓慢。在实际应用中,大数据量可能意味着成千上万甚至更多的元素。

为了分析和解决性能问题,可以采取以下措施:

- 分析:使用性能分析工具,如Python的`timeit`模块或`cProfile`来确定程序运行中的瓶颈。

- 优化:改进算法或数据结构的选择,比如使用更适合大数据量的排序算法。

- 并行化:利用多线程或多进程来分散计算任务,减少单个线程或进程的负担。

### 2.3.2 特殊操作对性能的影响

某些特殊的线性表操作可能对性能产生负面影响,特别是那些需要频繁修改线性表的操作。例如,频繁地在列表头部插入元素会导致大量元素移动,增加时间复杂度。

针对这类问题,可以考虑以下优化策略:

- 避免频繁的操作:尽可能地减少不必要的插入或删除操作。

- 使用适当的数据结构:根据应用场景选择最合适的数据结构,例如在需要频繁插入和删除操作的场景中使用`collections.deque`。

- 缓存优化:通过缓存中间结果来避免重复的计算。

在下一章中,我们将更进一步地探讨线性表的性能优化实践,包括如何通过数据结构选择、算法层面和循环迭代的优化来提升性能。

# 3. Python线性表的性能优化实践

### 3.1 数据结构选择的优化

在Python中,线性表常见的数据结构包括列表(List)和元组(Tuple)。选择合适的数据结构是性能优化的第一步。不同的数据结构有不同的特点和应用场景。

#### 3.1.1 选择合适的数据类型

在列表和元组的选择上,需要考虑以下因素:

- **不可变性**:元组是不可变的数据结构,而列表是可变的。如果你的数据项不会改变,使用元组可能会更加高效。

- **内存占用**:列表可能比元组占用更多内存,因为列表在添加新元素时可能会触发内存重新分配。

- **访问速度**:尽管元组在某些情况下访问速度较快,但列表提供了更丰富的操作,如append(), insert(), remove()等,适合需要频繁变动的场合。

为了说明这一点,我们可以通过实验对比列表和元组在不同操作下的性能。

```python

import timeit

import random

# 测试列表和元组在随机访问下的性能

def list_random_access():

data_list = [random.randint(0, 10000) for _ in range(10000)]

for _ in range(1000):

data_list[random.randint(0, 9999)]

def tuple_random_access():

data_tuple = tuple(random.randint(0, 10000) for _ in range(10000))

for _ in range(1000):

data_tuple[random.randint(0, 9999)]

print(timeit.timeit('list_random_access()', setup='from __main__ import list_random_access', number=100))

print(timeit.timeit('tuple_random_access()', setup='from __main__ import tuple_random_access', number=100))

```

在上述代码中,我们测试了随机访问列表和元组1000次的执行时间。在一般情况下,由于内存局部性原理,列表和元组在随机访问上的性能差异不会特别明显。但是,当你需要频繁地对元素进行修改时,列表可能会消耗更多的时间进行内存重新分配,从而影响性能。

#### 3.1.2 数据结构的预分配技巧

预分配内存空间可以减少Python在数据结构动态增长过程中频繁的内存分配和复制操作,特别是在处理大数据量时,这一步骤可以显著提升性能。

以列表为例,当知道最终列表的大小时,可以预先分配空间:

```python

initial_size = 10000

data = [None] * initial_size # 预分配空间

for i in range(initial_size):

data[i] = i # 在预先分配的空间内填充数据

```

这种方式相比于在循环中不断使用append()方法添加元素要高效得多,因为它避免了因动态扩容引起的多次内存复制。

### 3.2 算法层面的性能提升

#### 3.2.1 常见算法优化技巧

算法的效率直接影响程序的性能。在处理线性表时,我们可以采用一些常见的算法优化技巧来提高效率。

- **减少不必要的操作**:比如,在进行线性表排序前,先判断是否已经有序,避免重复排序。

- **分而治之**:对于大规模的数据,采用分治策略,例如通过递归使用快速排序,减少排序时间复杂度。

- **使用高效的算法**:比如使用哈希表替代二分搜索树以提高查找效率。

例如,在Python中,可以使用内置的排序方法,也可以通过`bisect`模块使用二分查找算法:

```python

from bisect import bisect_left

def binary_search(data_list, value):

index = bisect_left(data_list, value)

if index != len(data_list) and data_list[index] == value:

return index

return -1

```

#### 3.2.2 利用高级数据结构改善性能

除了列表和元组之外,Python还提供了诸如字典(dict)和集合(set)等高级数据结构。这些数据结构内部通常使用哈希表实现,可以提供更快的查找和插入操作。

例如,当你需要频繁查找操作时,使用字典而不是列表可能更为合适:

```python

data_dict = {'a': 1, 'b': 2, 'c': 3}

print(data_dict['a']) # O(1)时间复杂度

```

### 3.3 循环和迭代的性能优化

#### 3.3.1 循环体的优化策略

在进行循环操作时,代码的简洁性和效率至关重要。以下是一些常见的优化策略:

- **减少函数调用**:函数调用在Python中有较大的开销,应该尽量减少。

- **向量化操作**:如果可能,尽量使用NumPy等库的向量化操作替代Python的循环。

- **局部变量**:使用局部变量代替全局变量,因为Python会先在局部作用域查找变量,再查全局作用域。

举个例子,对于列表中所有元素进行操作时,避免使用全局变量:

```python

def operate_elements(data_list):

result = [] # 使用局部变量

for item in data_list:

result.append(item * 2) # 操作

return result

```

#### 3.3.2 迭代器的性能考量

迭代器是Python中一种高效的遍历数据结构的方式。使用迭代器可以按需生成数据项,避免一次性加载大数据量到内存中。

下面是一个使用迭代器处理大量数据的例子:

```python

def process_large_data(iterable):

for item in iterable:

# 进行数据处理

pass

large_data_iterator = iter(large_data)

process_large_data(large_data_iterator)

```

迭代器在处理大规模数据时,可以节省内存,因为它按需产生数据项,而不是一次性生成全部数据。这对于性能优化是一个重要的考量点。

# 4. 线性表性能优化的高级技巧

## 4.1 多线程和并行处理

### 多线程在数据处理中的应用

在处理复杂数据和需要大量计算的场景中,单线程可能会成为性能的瓶颈,多线程可以有效解决这一问题。Python虽然全局解释器锁(GIL)限制了CPU密集型任务的并行执行,但Python通过多线程依然可以在I/O密集型任务中提高性能。I/O操作(如读写文件、网络请求等)往往涉及到等待外部响应,这种等待时间可以被其他线程利用起来,从而提高程序的整体效率。

利用`threading`模块可以实现多线程。下面是一个简单的多线程示例:

```python

import threading

def task(num):

print(f"Processing number {num}")

threads = []

for i in range(10):

thread = threading.Thread(target=task, args=(i,))

threads.append(thread)

thread.start()

for thread in threads:

thread.join()

```

这个程序创建了10个线程,每个线程执行相同的任务。`threading.Thread`用于创建线程,`target`参数指定了线程执行的目标函数,`args`参数指定了目标函数的参数。`start()`方法启动线程,`join()`方法等待线程完成。

### 并行处理提高数据处理速度

并行处理意味着同时使用多个处理器资源来执行计算任务,这在多核处理器上特别有用。在Python中,`multiprocessing`模块可以用来实现并行处理。不同于`threading`,`multiprocessing`创建的多个进程之间没有GIL限制,因此更适合CPU密集型任务。

下面是一个使用`multiprocessing`模块的并行处理示例:

```python

import multiprocessing

def cpu_bound_task(num):

print(f"Processing number {num}")

if __name__ == "__main__":

processes = []

for i in range(10):

process = multiprocessing.Process(target=cpu_bound_task, args=(i,))

processes.append(process)

process.start()

for process in processes:

process.join()

```

在这个示例中,我们同样创建了10个进程来并行执行任务。`multiprocessing.Process`用于创建进程,其他用法与`threading.Thread`类似。

## 4.2 利用C扩展提升性能

### 通过Cython结合C优化

Python虽然方便易用,但在性能上往往无法与编译型语言相比。Cython是一个允许你编写C扩展的Python超集,它将Cython代码编译成C代码,再编译成Python扩展模块,从而提高性能。Cython不仅可以提供静态类型声明,还可以调用C语言的库和函数,使得Python代码运行速度接近C语言的水平。

下面是一个使用Cython定义一个C风格函数的简单例子:

```cython

# example.pyx

def add(int a, int b):

return a + b

```

编译Cython代码的命令:

```shell

cythonize example.pyx -o example.c

gcc -shared -o example.so example.c -lpython3.x

```

在Python代码中使用Cython模块:

```python

import example

print(example.add(1, 2))

```

### 使用ctypes和cffi调用C库

ctypes是Python的C类型兼容库,它允许在Python代码中调用C语言编写的动态链接库。使用ctypes可以避免编写C扩展代码,直接调用现有的C库,这对于那些已经优化好的C库非常有用。

示例代码,调用C库中的`cos`函数:

```python

import ctypes

# 加载C库

libc = ctypes.CDLL('libc.so.6')

# 调用C库中的cos函数

result = libc.cos(1.5)

print(result)

```

cffi是另一个用于调用C语言库的Python库,它与ctypes相似,但提供了一种更加Pythonic的方式来调用C代码,并且通常更容易使用。

示例代码,使用cffi调用`cos`函数:

```python

from cffi import FFI

ffi = FFI()

ffi.cdef("double cos(double);")

# 加载C库

libc = ffi.dlopen('libc.so.6')

# 调用C库中的cos函数

result = libc.cos(1.5)

print(result)

```

## 4.3 缓存机制的应用

### 缓存策略的理论基础

缓存是系统性能优化中非常重要的一部分。缓存策略的核心思想是将计算结果保存在快速访问的位置,以便在下一次需要相同结果时可以直接使用而无需重新计算。这可以极大地提高性能,尤其是在需要大量重复计算相同数据的场景下。

缓存策略包括几种不同的实现方式,例如:

- **LRU(最近最少使用)缓存**:当缓存空间不足时,淘汰最长时间未被使用的数据项。

- **FIFO(先进先出)缓存**:按照数据项进入缓存的顺序淘汰旧数据。

- **LFU(最不经常使用)缓存**:根据数据项被访问的频率进行淘汰。

### 实现局部性原理提高性能

局部性原理分为时间局部性和空间局部性:

- **时间局部性**:如果一个数据项被访问,那么它在未来短期内很可能再次被访问。

- **空间局部性**:如果一个数据项被访问,那么与它地址相近的数据项很快也将被访问。

根据局部性原理,我们可以通过缓存策略来实现性能优化。例如,可以使用Python内置的`functools.lru_cache`装饰器来实现LRU缓存机制:

```python

from functools import lru_cache

@lru_cache(maxsize=128)

def fibonacci(n):

if n < 2:

return n

return fibonacci(n-1) + fibonacci(n-2)

print(fibonacci(10))

```

在这个例子中,我们使用了`lru_cache`装饰器来缓存`fibonacci`函数的结果。当计算一个数的斐波那契数列值时,结果会被存储在缓存中,如果再次调用同一个函数,就会直接从缓存中获取结果。

通过这些高级技巧的应用,开发者可以进一步提升线性表操作的性能,特别是在处理复杂数据结构和大量数据时。在实际应用中,这些优化手段可以大幅提高程序的运行效率和响应速度。

# 5. 线性表性能优化的案例分析

在大规模数据处理和实时数据流分析的现代应用中,对线性表的性能优化是至关重要的。本章节将深入探讨在大数据场景下线性表应用的实际案例,并分析在实际项目中如何通过优化提高性能。

## 5.1 大数据场景下的线性表应用

在大数据场景中,线性表经常被用来存储和处理大量的数据。这不仅考验着数据结构的效率,还要求算法和程序设计具有高度的优化。

### 5.1.1 大数据量线性表操作案例

假设我们有一个需要处理数亿条记录的场景,每条记录包含若干字段。使用标准的Python线性表结构,如列表(list),来存储这些数据。

```python

# 示例:大数据量的线性表操作

data = [f'record_{i}' for i in range(***)]

```

在大数据量下,即使是简单的遍历操作也可能变得缓慢。当添加更多的复杂操作,如数据过滤、映射或归约时,性能瓶颈变得更加明显。

### 5.1.2 性能瓶颈分析与解决方案

在上述案例中,性能瓶颈主要集中在以下几点:

- 内存消耗:大数据量存储在列表中,会消耗大量内存资源。

- 计算效率:简单的循环操作在数据量大时变得低效。

一个解决方案是使用生成器表达式代替列表存储数据,这样可以节省内存并利用Python的惰性求值机制。

```python

# 使用生成器表达式优化内存使用

data_generator = (f'record_{i}' for i in range(***))

```

另一个解决方案是使用Python内置的高效率数据处理库,如Pandas,该库内部优化了对大型数据集的操作。

```python

# 使用Pandas进行数据处理

import pandas as pd

data_frame = pd.DataFrame({'records': [f'record_{i}' for i in range(***)]})

```

## 5.2 实际项目中的性能优化经验

在具体项目中,根据性能测试和分析得到的数据,采用不同的优化策略来满足性能需求。

### 5.2.1 项目需求下的性能优化实践

针对不同的项目需求,性能优化实践可能会有所不同。例如:

- 对于需要快速访问特定元素的场景,可以采用哈希表来优化访问时间。

- 对于需要频繁排序的场景,可以使用归并排序等更高效的排序算法。

### 5.2.2 性能优化后的效果对比分析

在实施优化措施后,需要对比优化前后的性能数据来进行效果评估。常见的评估指标包括:

- 执行时间:优化前后操作的执行时间对比。

- 资源消耗:优化前后内存和CPU的使用情况对比。

```python

import time

# 记录优化前的操作耗时

start_time = time.time()

# 执行大数据量操作

# ...

end_time = time.time()

print(f'Before Optimization: {end_time - start_time} seconds')

# 记录优化后的操作耗时

start_time = time.time()

# 执行大数据量优化后操作

# ...

end_time = time.time()

print(f'After Optimization: {end_time - start_time} seconds')

```

根据时间统计结果,可以直观地看到优化带来的性能提升。

## 总结

通过上述的案例和分析,可以看出在不同场景下针对线性表的性能优化方式是多样的。优化工作不仅需要理论知识的积累,还需要深入理解具体的应用需求和数据特性,结合实际情况进行灵活运用。下一章节将着重讨论在实际项目中如何利用性能监控工具来指导我们的优化工作。

0

0