Kafka事务性消息处理:确保消息原子性的5大策略

发布时间: 2024-12-14 12:23:55 阅读量: 1 订阅数: 3

Springboot整合kafka做消息通信_20200410.docx

参考资源链接:[Kafka权威指南:从入门到部署详解](https://wenku.csdn.net/doc/6412b6c8be7fbd1778d47f68?spm=1055.2635.3001.10343)

# 1. Kafka事务性消息处理概述

Apache Kafka,一个分布式的流处理平台,已经成为现代大数据架构中不可或缺的组成部分。近年来,Kafka的事务性消息处理功能更是引起了广泛关注。它允许开发者构建健壮、可靠的消息系统,确保数据的一致性和可靠性。在处理关键业务流程时,如订单处理、库存管理等,事务性消息可以保证操作的原子性,这对于保持数据完整性至关重要。Kafka事务性消息处理不仅简化了开发者的代码,也提升了系统的稳定性和可维护性。然而,如何正确使用Kafka的事务性消息处理功能,仍然是一门艺术和科学。本文将深入探讨Kafka事务性消息处理的理论和实践,并展望其未来的发展。

# 2. Kafka事务的基本理论

## 2.1 事务性消息的概念和重要性

### 2.1.1 事务的定义

事务是数据库管理系统执行过程中的一个逻辑单位,由一个有限的操作序列组成,这些操作要么全部成功,要么全部失败,保证了数据的一致性和完整性。在Kafka中,事务同样保证了消息生产和消费的一致性。事务性消息不仅需要保证消息不丢失、不重复,还需要确保消息的生产和消费的原子性。

在分布式系统中,事务性消息处理尤为复杂。一方面,需要保证消息的顺序性和一致性;另一方面,还需要面对分布式系统中网络分区、延迟等带来的挑战。Kafka通过事务机制,为这种复杂性提供了解决方案。

### 2.1.2 消息原子性的重要性

在消息队列系统中,原子性是确保消息处理可靠性的关键。如果系统中某一操作失败,那么必须保证该操作产生的所有影响都能被撤销,这就是事务的回滚机制。对于消费者来说,原子性意味着要么接收到并处理完消息之后才确认消息,要么在处理过程中出现异常时,能够保证消息不被消费并可被重新处理。

在高并发场景下,消息原子性的保证尤为重要。例如,在电商系统中,订单创建和库存扣减这两个操作需要同时成功或失败,否则会导致数据不一致,影响业务的正确性。

## 2.2 Kafka的事务机制

### 2.2.1 Kafka事务的核心组件

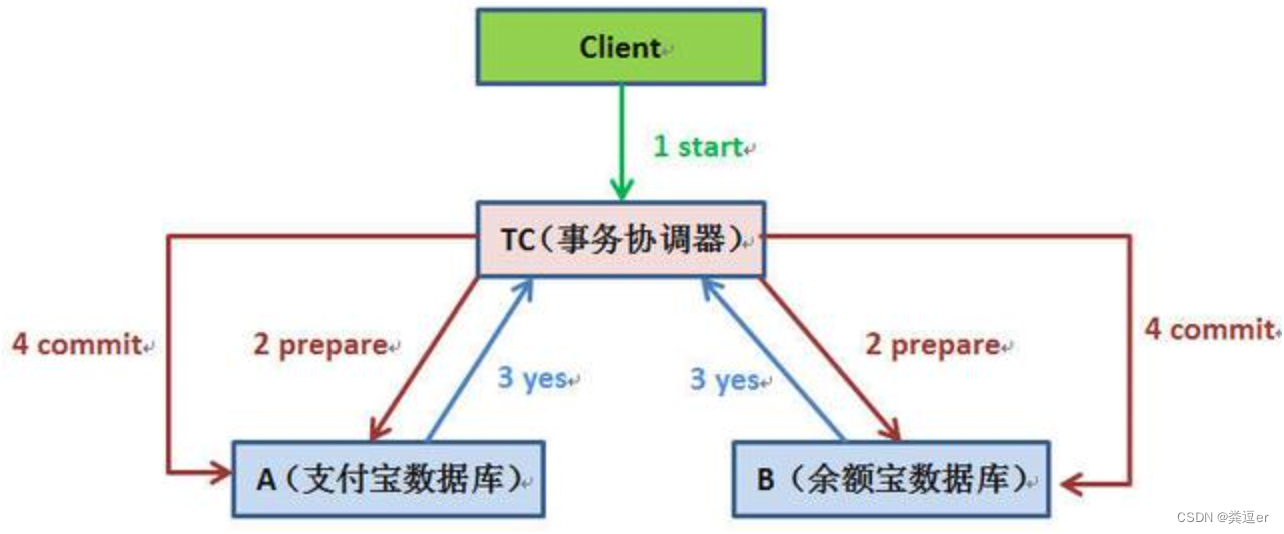

Kafka的事务机制主要包含三个核心组件:事务协调器、事务ID和事务日志。事务协调器负责管理事务状态,而每个事务都有一个唯一的事务ID标识。事务日志记录了事务过程中的所有操作,保证了事务的持久性和一致性。

- **事务协调器(Transaction Coordinator)**:负责管理事务状态,处理事务开始、提交和终止请求。

- **事务ID**:标识事务的唯一性,由生产者或消费者在事务开始时生成,并在整个事务过程中使用。

- **事务日志**:记录了事务过程中的所有操作,包括消息的发送、接收和确认等。

### 2.2.2 事务控制消息类型

Kafka为了支持事务性消息,引入了几种特殊的控制消息类型,它们是事务性消息处理的关键。这些消息类型包括:

- **事务开始消息(Transaction Start Record)**:标记一个新事务的开始。

- **事务提交消息(Transaction Commit Record)**:标记事务成功完成,并确保所有消息被持久化。

- **事务终止消息(Transaction Abort Record)**:表示事务被终止,事务中的所有消息将被丢弃。

## 2.3 事务性消息的理论模型

### 2.3.1 CAP定理与Kafka事务

CAP定理指出,一个分布式系统不可能同时满足一致性(Consistency)、可用性(Availability)和分区容错性(Partition Tolerance)这三个基本需求。在Kafka事务性消息处理中,主要考虑的是保证数据的一致性和分区容错性,因此可用性可能会受到影响。

由于网络分区是不可避免的,Kafka的事务处理更多地关注于一致性和分区容错性。在遇到网络分区时,Kafka会牺牲一些可用性,确保在分区修复后,消息的一致性和完整性能够得到保证。

### 2.3.2 基于日志的事务模型

Kafka的事务模型基于日志来实现,这一点和传统关系型数据库有相似之处。Kafka中每个分区的副本都保存了分区日志,事务操作就是对这些日志的修改。事务的日志记录操作保证了在发生故障时,可以通过日志恢复到事务的某个一致状态。

Kafka的事务模型遵循ACID原则,即原子性(Atomicity)、一致性(Consistency)、隔离性(Isolation)和持久性(Durability)。这些原则确保了即使在系统故障的情况下,数据的完整性和一致性也能得到保证。

下面是本章内容的总结:

在本章中,我们探讨了Kafka事务性消息处理的基础理论。首先介绍了事务的概念和重要性,强调了在消息队列中实现消息原子性的重要性。随后,我们深入了解了Kafka的事务机制,包括事务的核心组件以及控制消息类型。最后,我们分析了事务性消息的理论模型,重点讨论了CAP定理对Kafka事务的影响,以及基于日志的事务模型的工作方式。通过这些理论基础,我们可以更好地理解Kafka在处理消息事务时所采用的策略和方法。在下一章节中,我们将介绍Kafka事务性消息处理的实践策略,包括如何在生产者和消费者中实现事务性消息的处理。

# 3. ```

# 第三章:Kafka事务性消息处理的实践策略

在深入理解Kafka事务理论后,接下来将探索这些理论在实际应用中的具体实现。本章节将详细介绍如何在Kafka中实现生产者和消费者的事务性消息处理,并探讨事务协调器的作用及配置最佳实践。

## 3.1 生产者事务的实现

### 3.1.1 生产者事务API的使用

在Kafka中,生产者可以使用事务API来确保消息的一致性。事务API的引入,使得生产者可以将消息发送与事务控制相结合,以确保在出现系统崩溃或错误时,消息的发送能够被安全地回滚或提交。

```java

Producer<String, String> producer = new KafkaProducer<>(props);

producer.initTransactions();

try {

producer.beginTransaction();

producer.send(record1);

producer.send(re

0

0