Kafka集群监控与管理:专家级别的最佳实践

发布时间: 2024-12-14 11:41:51 阅读量: 3 订阅数: 3

Kafka集群负载均衡:策略、实践与性能优化

参考资源链接:[Kafka权威指南:从入门到部署详解](https://wenku.csdn.net/doc/6412b6c8be7fbd1778d47f68?spm=1055.2635.3001.10343)

# 1. Kafka集群监控与管理概览

## Kafka集群监控与管理的重要性

Apache Kafka是一个高性能、可扩展的分布式流处理平台,广泛应用于大数据处理、日志聚合、事件源等场景。随着数据量的增加,Kafka集群的监控与管理变得尤为重要。良好的监控策略不仅可以帮助我们实时了解集群的运行状态,还能提前发现并解决潜在问题,从而保障业务的连续性。

## 监控与管理的基本要求

对于Kafka集群的监控与管理,基本要求包括但不限于:

- 实时性和准确性:监控数据需要实时采集和准确反映集群的状态。

- 可视化:监控信息应通过图形界面直观展示,简化运维工作。

- 预警机制:系统应具备预警功能,对异常情况进行实时报警。

- 易于管理:管理操作需要简单直观,避免复杂配置和操作带来的风险。

## 监控与管理的演进路径

随着企业对数据处理要求的提升,监控与管理方法也在不断发展。从早期的简单脚本报警,到现在的AI智能监控,Kafka集群的监控与管理正在向自动化、智能化、精细化方向演进,以满足不断增长的数据处理需求和用户体验要求。

以上为第一章的内容概览,接下来各章节将从不同角度深入探讨Kafka集群的监控与管理,包括其理论基础、内部机制、监控策略、管理技巧、高级操作和案例分析。

# 2. Kafka理论基础与架构解析

在深入探讨Kafka集群监控与管理之前,了解Kafka的基础理论与架构是至关重要的。Kafka不仅仅是一个消息队列系统,它是一个高性能的分布式流处理平台,广泛应用于构建实时数据管道和流式应用。本章将逐步揭开Kafka的核心概念和内部机制的面纱,为后续的监控与管理奠定坚实的理论基础。

### 2.1 Kafka的核心概念

#### 2.1.1 主题、分区、副本的定义与作用

在Kafka中,消息被组织在“主题(Topics)”中,这些主题可以被分割成多个“分区(Partitions)”,而分区是Kafka高吞吐量和可伸缩性的关键。每个分区在不同的服务器上可以拥有一个或多个副本,这些副本之间保持数据的一致性,是Kafka高可用性的保障。

- **主题(Topics)**:是消息的分类名或标签,每个主题可以有一个或多个分区。

- **分区(Partitions)**:每个分区都是有序的消息序列,分区保证了消息的顺序。对于每个主题,Kafka会自动将分区分布在集群中的多个服务器上。

- **副本(Replicas)**:分区的副本分布在不同的服务器上,副本之间通过主从复制来保持一致性。领导者副本处理读写请求,而追随者副本则从领导者那里同步消息。

#### 2.1.2 生产者和消费者的通信模型

Kafka的通信模型涉及到两个关键角色:生产者(Producers)和消费者(Consumers)。

- **生产者(Producers)**:负责将消息发送到Kafka集群。生产者在发送消息时可以选择要写入哪个主题,以及消息要发送到主题的哪个分区。

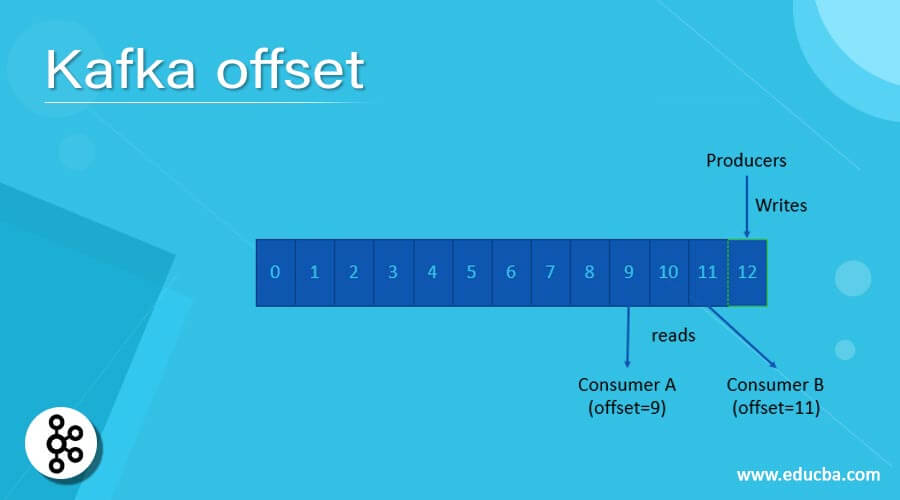

- **消费者(Consumers)**:从Kafka集群读取消息。消费者订阅一个或多个主题,并通过分区来并行处理消息。消费者通过偏移量(Offset)来跟踪已经读取的消息,确保消息被正确处理且不会丢失。

### 2.2 Kafka集群的架构设计

#### 2.2.1 集群组件与数据流向

Kafka集群由多个服务器节点组成,每个节点称为“代理(Broker)”。一个Kafka集群至少有一个代理,生产者和消费者则通过代理节点来进行通信。

- **代理(Brokers)**:代理是Kafka集群中的一个运行实例,负责接收生产者的生产请求,处理消费者的消费请求,以及维护存储的消息数据。

- **数据流向**:当生产者将消息发送到主题时,消息首先被写入到主题的指定分区中。消费者通过分区来订阅主题的消息,并按顺序拉取消息。

#### 2.2.2 高可用性与扩展性的考量

Kafka的高可用性和扩展性设计是其核心优势之一。

- **高可用性**:通过在多个代理之间复制分区的副本,并在副本之间进行同步,Kafka可以在一个或多个代理出现故障时继续提供服务。

- **扩展性**:Kafka集群易于扩展,可以添加新的代理节点来增加存储和处理能力。当一个主题的分区增加时,这些新分区可以均匀地分布在集群中,从而实现负载均衡。

### 2.3 Kafka的内部机制

#### 2.3.1 日志结构与段文件管理

Kafka使用日志结构存储,它将消息追加到日志文件的末尾,这种设计既简单又高效。

- **日志结构**:消息按到达的顺序追加到日志文件中。每个分区都有自己的日志,分区中的消息会连续存储。

- **段文件管理**:由于消息会不断写入,日志文件会变得很大,Kafka采用段文件的管理方式来维护日志。当日志文件达到一定大小后,它会被分割成段文件,从而便于管理和维护。

#### 2.3.2 集群的协调与同步机制

Kafka集群的协调和同步主要依赖于“领导者”和“追随者”机制。

- **领导者选举**:每个分区都有一个领导者副本和若干个追随者副本。生产者和消费者只与领导者副本交互。

- **副本同步**:追随者副本会从领导者那里同步消息,保持与领导者副本的数据一致性。

通过这些核心概念、架构设计和内部机制的介绍,我们对Kafka有了一个基本且全面的认识。这些知识为我们后续深入了解Kafka的集群监控与管理策略打下了坚实的基础。接下来的章节中,我们将探讨Kafka集群监控策略的具体实施。

# 3. Kafka集群监控策略

在构建和维护一个高效稳定的Kafka集群时,监控策略是不可或缺的环节。正确的监控策略可以帮助我们了解集群的运行状态,及时发现并处理性能瓶颈和故障。本章节将从监控指标的选择与重要性、监控工具与实践以及常见问题的监控与报警三个方面深入探讨Kafka集群监控策略。

## 3.1 监控指标的选择与重要性

监控指标是理解和评估Kafka集群健康状况的关键。一个全面的监控策略包括多个层面的指标,这些指标既需要覆盖基础性能,也需要考虑到集群的健康与稳定性。

### 3.1.1 基础性能指标

基础性能指标是监控集群性能的基石,它们涵盖了集群最核心的运行数据。以下是一些核心的基础性能指标:

- **消息吞吐量**:衡量生产者发送消息和消费者接收消息的速率,是衡量Kafka集群性能的重要指标。

- **延迟**:从消息进入Kafka到消息被消费者读取的时间差,是评估实时处理能力的直接体现。

- **资源使用率**:CPU、内存、磁盘I/O等资源的使用情况,对集群性能有着直接影响。

### 3.1.2 集群健康与稳定性指标

集群健康与稳定性指标反映了集群运行的稳健程度,是确保Kafka稳定运行的关键。这些指标包括:

- **副本同步状态**:副本之间的同步情况,对于保证数据的可靠性至关重要。

- **主题分区状态**:包括分区的领导者选举情况、ISR列表的变动等,直接关系到消息的可用性。

- **消费者群组状态**:消费者群组的活跃度、滞后情况,有助于判断消费者端的健康状态。

## 3.2 监控工具与实践

监控工具的正确选择与实践对有效管理Kafka集群至关重要。本部分将介绍一些流行的开源监控工具,并探讨如何收集与展示监控数据。

### 3.2.1 开源监控工具介绍

当前市场上的Kafka监控工具有很多种,以下是一些广泛使用的工具:

- **Prometheus + Grafana**:Prometheus是一个开源的监控解决方案,它支持Kafka的 exporter 用于数据收集,而 Grafana 则提供优雅的图形界面展示监控数据。

- **Apache Flink + Kafka**:通过Apache Flink的Kafka消费者监控指标,可以实时分析和监控Kafka集群的性能。

- **Confluent Control Center**:Confluent提供的Kafka管理平台,自带监控功能,可以直观展示集群状态和性能指标。

### 3.2.2 监控数据的收集与展示

收集和展示监控数据的实践步骤:

1. **数据采集**:在Kafka集群的每个节点上部署监控代理,并配置好采集Kafka相关的性能和状态指标。

2. **数据聚合**:将采集的数据发送到中心化的监控系统中,进行聚合处理。

3. **数据展示**:通过图形化的仪表板展示监控数据,支持实时警报机制,及时通知管理员。

## 3.3 常见问题的监控与报警

监控策略的最后一个关键点是针对常见问题的监控与报警设置。这包括性能瓶颈的识别与报警设置,以及故障排查流程与工具的介绍。

### 3.3.1 性能瓶颈的识别与报警设置

识别性能瓶颈需要关注以下几点:

- **消息堆积**:如果消费者的消费速率低于生产者的生产速率,会导致消息堆积,需要立即关注。

- **资源限制**:当集群的资源使用接近或达到限制时,需要设置报警。

- **网络延迟**:如果网络延迟突然增加,可能导致客户端的性能下降。

报警设置步骤:

1. **定义阈值**:根据监控指标定义触发报警的阈值。

2. **选择报警机制**:可以使用邮件、短信、即时通讯工具等多种方式。

3. **测试报警流程**:定期测试报警流程是否正常工作。

### 3.3.2 故障排查流程与工具

在遇到问题时,一个有效的故障排查流程至关重要。以下是一些故障排查的通用步骤:

1. **收集日志**:首先收集所有相关的日志文件,这些文件记录了集群运行中的详细信息。

2. **使用诊断命令**:运行一些诊断命令来获得集群的状态,比如kafka-consumer-groups.sh, kafka-topics.sh等。

3. **使用专用工具**:利用一些专用的故障排查工具,如Kafka Manager、Burrow等来帮助分析问题。

工具介绍:

- **Kafka Manager**:一个开源的Web界面工具,可以用来管理Kafka集群,包括创建主题、管理分区和消费者群组等。

- **Burrow**:LinkedIn开发的一个开源的Kafka消费者监控系统,支持Kafka 0.8及以上版本,并支持多种报警方式。

通过上述的监控策略,管理员可以有效地控制Kafka集群的运行状态,及时发现并处理问题,保证集群的高可用性与稳定性。在下一章节中,我们将深入探讨如何对Kafka集群进行高效管理。

# 4. Kafka集群管理技巧

## 4.1 分区与副本管理

### 4.1.1 分区的扩展与缩容策略

在Kafka中,分区是数据并行处理的基本单位,增加分区数量可以提高集群的吞吐量,但同时也可能导致更高的开销和管理复杂性。因此,合理地管理分区数量是Kafka集群管理中的一个重要方面。

#### 扩展分区

扩增分区数量可以提高消息吞吐量,并允许更多的消费者并行消费消息。扩分区的方法包括:

1. 使用`kafka-topics.sh`命令行工具:

```bash

kafka-topics.sh --bootstrap-server <broker-list> --alter --topic <topic-name> --partitions <new-partition-count>

```

参数说明:

- `--bootstrap-server`:指定Kafka集群的broker地址。

- `--alter`:表示要修改主题。

- `--topic`:指定要修改的主题名称。

- `--partitions`:指定新的分区数量。

执行逻辑说明:

修改分区后,需要重新平衡集群,以确保数据均匀分布。新的分区将在重新平衡过程中逐渐填充数据。

2. 使用Kafka管理界面或API进行动态分区管理。

#### 缩减分区

减少分区数量较为复杂,通常不推荐。如果必须缩减分区,需先迁移数据到其他分区,然后删除旧分区。需要注意的是,这一过程可能会造成服务中断。

缩减分区的步骤大致如下:

1. 创建一个新的主题,其分区数少于原主题,确保数据能迁移到新的主题。

2. 使用消费者程序读取旧主题数据,然后将数据写入新主题。

3. 确认新主题数据完整且一致后,删除旧主题。

#### 分区策略建议

- 在创建主题时就合理预估分区数,避免频繁变动。

- 扩展分区时,考虑资源可用性和系统负载。

- 缩减分区应谨慎操作,事先做好充分的备份与测试。

### 4.1.2 副本的同步与故障恢复

Kafka副本机制用于保证数据的持久性和系统的高可用性。副本同步和故障恢复是副本管理的核心部分。

#### 副本同步

副本同步是指将leader副本的数据复制到其他follower副本的过程。Kafka通过以下机制保证副本间数据的一致性:

- 副本同步状态监控。

- 副本落后阈值检查。

- 异步IO写操作以提高效率。

#### 故障恢复

当leader副本或某个follower副本出现故障时,Kafka会自动进行故障恢复,步骤包括:

1. 重新选举新的leader副本。

2. 如果是分区leader故障,会从其他副本中选举出新的leader。

3. 如果是broker节点故障,会根据配置进行副本迁移和数据复制。

```mermaid

sequenceDiagram

participant C as Controller

participant L as Leader

participant F as Follower

participant B as Broker

C->>L: elect

L->>F: sync

C->>F: fetch

C->>B: replica -> replica sync

B->>C: status report

C->>L: new Leader election

Note over C,L: Partition Recovery

```

#### 副本管理注意事项

- 副本数量应该大于等于2,以支持高可用性。

- 监控副本延迟和同步状态,确保数据的一致性。

- 定期进行故障切换演练,确保故障恢复的可靠性和快速性。

通过本章节的介绍,我们了解了Kafka集群中分区与副本的扩展与缩容,副本的同步和故障恢复等关键管理操作。这些管理技巧对于保证数据的可靠性和系统的稳定性至关重要。下一节,我们将探讨Kafka集群的安全性与权限控制管理,进一步加强集群的安全性和数据保护。

# 5. Kafka集群高级管理操作

## 5.1 批量管理任务的自动化

### 5.1.1 自动化脚本的编写与执行

在管理大规模的Kafka集群时,重复的手动任务不仅消耗时间,还容易出错。自动化脚本可以有效地解决这些问题。我们可以使用Shell脚本或Python脚本结合Kafka自带的命令行工具来实现自动化任务。例如,创建主题、调整分区数量、清理过期数据等操作都可以通过脚本来执行。

```bash

# 示例:使用kafka-topics.sh创建新主题

kafka-topics.sh --create --topic new_topic \

--partitions 5 --replication-factor 3 \

--zookeeper zookeeper_host:2181

```

### 5.1.2 批量操作的错误处理与日志记录

自动化脚本需要能够处理错误,并记录执行过程中的日志。这通常意味着脚本要能够捕获异常、记录日志信息,并在出现问题时能够给出清晰的错误提示。使用日志管理工具如log4j,可以将脚本执行过程中的关键信息记录下来,便于后续的问题追踪。

```bash

# 示例:错误处理和日志记录

{

kafka-topics.sh --create ... # 执行任务

} || {

echo "创建主题失败,日志记录:$(date)" >> /var/log/kafka_operations.log

exit 1

}

```

## 5.2 多集群管理与维护

### 5.2.1 多集群架构的设计与管理

在多集群架构下,每个集群可能负责不同的业务或数据流。集群之间的独立性和互不干扰是设计的关键。为了简化管理,我们可能需要统一集群的配置模板、部署方案和监控策略。统一的管理策略可以避免因配置差异导致的维护成本增加。

### 5.2.2 跨集群的数据同步与迁移策略

在多集群架构下,数据同步和迁移是不可避免的任务。这可以通过Kafka自带的MirrorMaker工具来实现,也可以通过自定义的消费者和生产者程序来完成。数据迁移策略需要考虑数据一致性、迁移效率和对源集群的影响。

```bash

# 示例:使用MirrorMaker进行数据同步

kafka-mirror-maker.sh --consumer.config consumer.properties \

--producer.config producer.properties --whitelist topics.list

```

## 5.3 灾难恢复与备份

### 5.3.1 备份策略与实现

Kafka提供了命令行工具`kafka-verifiable-producer`和`kafka-verifiable-consumer`来验证数据的备份和恢复。备份策略通常包括定期快照备份、增量备份和在线备份。备份时需要考虑备份的频率、备份数据的保留周期等因素。

```bash

# 示例:使用kafka-dump-log.sh导出分区数据

kafka-dump-log.sh --files /var/lib/kafka/logs/__consumer_offsets-*.log \

--print-data-log

```

### 5.3.2 灾难恢复计划与演练

制定灾难恢复计划是避免数据丢失的关键步骤。该计划需要明确灾难发生时的应对流程、角色职责和联系方式。定期进行灾难恢复演练,可以检验计划的可操作性并找出潜在的问题。

```markdown

| 角色 | 责任 | 联系方式 |

| ------------- | ------------------- | --------------- |

| 管理员 | 启动恢复流程 | 邮箱/电话 |

| 开发者 | 验证数据和服务 | 邮箱/即时通讯工具 |

| 支持团队 | 提供技术支持 | 邮箱/电话 |

| 第三方供应商 | 提供硬件/软件支持 | 邮箱/电话 |

```

通过本章节的介绍,我们了解了Kafka集群在高级管理操作上的自动化、多集群管理和灾难恢复的策略和实现方式。这些高级操作对于保证大规模部署Kafka集群的稳定性和数据安全性至关重要。随着业务的增长和数据量的增加,这些管理策略和技术将帮助我们有效地扩展和维护Kafka集群。

接下来,我们将探讨Kafka集群监控与管理的实际案例,分析在不同业务场景下监控应用的策略与效果,并分享管理策略的优化与创新点。同时,也会对Kafka社区的最新动态和技术未来的发展趋势进行展望。

# 6. Kafka集群监控与管理案例分析

Kafka集群的监控与管理不仅仅是一套理论或者一组工具,它更多地体现在实际业务场景中的应用效果。本章节将深入分析Kafka集群监控与管理在实际业务中的应用,分享成功案例,探讨管理策略的优化与创新,并对社区的最新动态和技术的未来发展趋势进行展望。

## 6.1 实际业务场景下的监控应用

在实际的业务场景中,监控系统能够帮助我们更好地了解集群的状态,识别和解决潜在的问题。本小节将着重分析监控系统在不同业务场景中的应用以及成功案例。

### 6.1.1 监控在不同业务场景中的应用分析

监控系统在不同业务场景中的应用有着各自的特点和需求:

- **实时数据处理场景:** 对于需要实时处理数据的业务,如在线推荐系统,监控系统可以用来追踪消息的延迟时间和吞吐量,确保数据能够实时到达处理端。

- **高可靠性业务场景:** 在金融交易系统中,监控不仅要实时追踪数据流,还要对集群的健康状态和数据一致性进行严格监控。

- **大数据分析场景:** 在大数据分析和存储业务中,监控系统可以用来分析数据的写入速度、存储容量和读取效率等,帮助优化存储方案。

### 6.1.2 成功案例与经验分享

**案例一:**

在一家大型电商平台,通过监控Kafka集群,发现某些时间段内消息处理延迟严重。经过分析,原因在于消费者的消费速度跟不上生产者发送消息的速度。解决方案是引入Kafka Connect进行数据同步,并对消费者进行性能优化。通过这一系列的监控和优化措施,最终将消息处理的延迟时间降低了30%。

**案例二:**

另一家社交平台在数据迁移的过程中遇到了数据丢失的风险。他们通过引入Kafka的复制机制,并且对备份和恢复流程进行了优化,实现了零数据丢失的数据迁移。此外,他们还利用监控系统来实时检测数据复制的状态,确保数据的一致性和可靠性。

## 6.2 管理策略的优化与创新

管理Kafka集群的策略也需要不断地优化和创新,以适应不断变化的业务需求和技术发展。

### 6.2.1 管理实践中的创新策略

- **动态扩缩容:** 在负载不断变化的业务中,动态扩缩容策略可以有效提高资源利用率。通过编写脚本自动化扩缩容流程,实现对集群资源的动态管理。

- **智能负载均衡:** 结合监控数据,开发智能负载均衡策略,自动调整分区与副本的分配,以保持集群的负载均衡。

### 6.2.2 面临的挑战与应对措施

在实施创新策略时,我们也会遇到诸如网络稳定性、系统安全性等挑战。应对这些挑战,需要采取以下措施:

- **建立预测模型:** 利用历史数据建立系统负载和网络状况的预测模型,以提前做出调整。

- **强化安全措施:** 通过强化Kafka集群的安全措施,如引入SASL/SSL等认证和加密机制,确保数据传输的安全性。

## 6.3 未来趋势与技术展望

随着Kafka社区的不断发展和监控技术的进步,我们可以预见未来Kafka集群的监控与管理将会有更多新的趋势和技术。

### 6.3.1 Kafka社区的最新动态

社区持续推出新版本,例如Kafka 3.x中引入的KRaft模式,简化了集群的管理复杂性。此外,社区还在探索与容器化平台(如Kubernetes)更好的集成方式。

### 6.3.2 监控与管理技术的未来发展方向

- **AI与机器学习:** 将AI和机器学习技术引入监控系统,可以更智能地预测和诊断问题,提供决策支持。

- **无代理监控:** 未来可能会有更多基于无代理技术的监控解决方案出现,以降低监控系统对集群性能的影响。

监控与管理Kafka集群是一个持续进化的过程,它不仅需要深入了解Kafka的内部机制,还需要不断地学习和应用最新的技术,以适应业务需求的变化。通过本章节的案例分析,我们可以获得宝贵的经验和灵感,从而在未来的监控与管理工作中取得更好的成绩。

0

0