Python并发算法锁优化:减少竞争,实现高性能并发处理

发布时间: 2024-09-01 03:21:51 阅读量: 161 订阅数: 108

# 1. Python并发基础与锁机制介绍

随着计算机技术的不断进步,多核处理器变得越来越普遍,Python程序设计中并发编程已经成为提升程序性能的重要手段。而锁机制,作为并发控制的关键技术之一,在同步多个进程或线程对共享资源的访问时起到了至关重要的作用。本章将对Python中的并发编程及其锁机制的基本概念进行介绍,为读者打下坚实的理论基础,并引导至更高级的并发编程实践。

在Python中,无论是通过全局解释器锁(GIL)实现的线程级并发,还是利用多进程实现的进程级并发,都离不开锁的应用。GIL保证了同一时刻只有一个线程可以执行Python字节码,但这样的设计也限制了CPU密集型任务的并行处理。为了克服GIL的限制,开发者通常使用多进程的方式,但进程间通信的成本较高,且锁的使用也变得更加复杂。

下面将首先探讨Python并发编程中锁的基础知识,包括锁的概念、类型、以及如何正确使用锁来保证数据的一致性和程序的稳定性。

```python

import threading

def print_numbers():

for i in range(1, 6):

print(i)

def print_letters():

for letter in 'abcde':

print(letter)

# 创建线程

thread1 = threading.Thread(target=print_numbers)

thread2 = threading.Thread(target=print_letters)

# 启动线程

thread1.start()

thread2.start()

# 等待线程完成

thread1.join()

thread2.join()

```

在上述示例中,我们创建了两个线程,分别打印数字和字母。在没有锁的情况下,由于线程调度的不确定性,输出结果可能不是我们预期的顺序。但在Python中,由于GIL的存在,`print_numbers` 和 `print_letters` 函数不会并行执行,因此即使没有使用锁,也不会出现竞态条件。若是在多进程环境下,这种输出的不确定性则会显现出来。接下来的章节,我们将深入探讨并发编程中的锁机制。

# 2. 并发锁机制的理论基础

### 2.1 并发编程中的锁概念

#### 2.1.1 锁的类型与作用

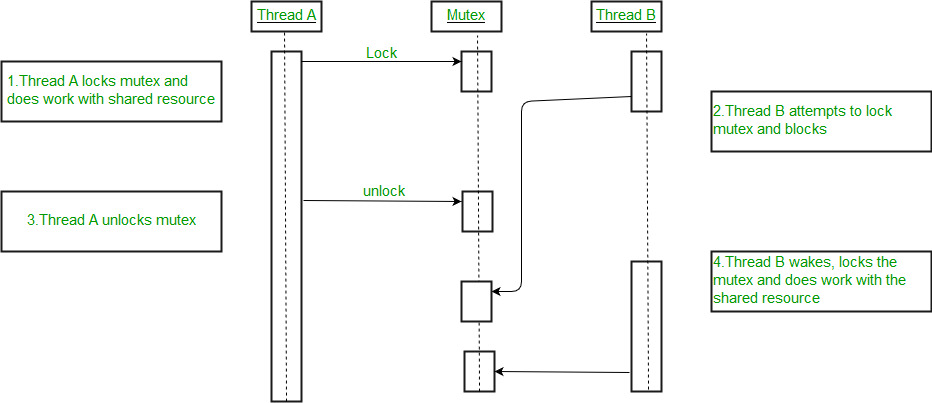

在并发编程中,锁是一种同步机制,用于控制多个线程对共享资源的访问,防止出现数据不一致或者竞态条件的问题。锁可以基于不同的标准进行分类,最常见的类型包括互斥锁(Mutexes)、读写锁(Read-Write Locks)和自旋锁(Spinlocks)。

互斥锁是最基本的锁类型,它保证了一个时间点只有一个线程可以访问资源。读写锁则更加精细,允许多个线程同时读取数据,但写入时必须独占访问。自旋锁是一种简单的锁,当尝试获取一个已上锁的资源时,线程会持续检查锁状态而不是被阻塞,这在锁很快被释放的情况下效率较高,但在等待时间较长时会浪费CPU资源。

#### 2.1.2 锁的正确使用与风险

正确使用锁能够保证并发程序的正确性,但不当使用锁可能导致资源死锁、优先级反转和性能瓶颈等风险。死锁是指两个或多个线程相互等待对方释放锁,导致所有线程都无法继续执行。优先级反转是指高优先级线程的执行依赖于低优先级线程持有的资源,而低优先级线程又因高优先级线程的请求而无法执行。性能瓶颈则是在于锁的使用过多或锁的粒度过大,这会导致过多的线程竞争同一个资源,从而降低程序的并发性能。

### 2.2 锁竞争及其影响

#### 2.2.1 何为锁竞争

锁竞争是指多个线程试图同时获取同一个资源上的锁,由于资源的锁定状态,只有一部分线程能够成功,其他线程则必须等待,这在高并发的系统中非常常见。锁竞争程度越高,系统的吞吐量通常会越低,因为线程在等待获取锁时是无法做任何有用工作的。

#### 2.2.2 锁竞争对性能的影响

锁竞争对于程序性能的影响非常大。它不仅增加了线程等待获取锁的时间,还会导致线程上下文切换的增加。频繁的上下文切换会消耗大量的CPU时间,从而降低了CPU的有效计算时间。此外,过度的锁竞争还可能导致缓存失效,因为线程在锁竞争中频繁进入和退出临界区,使得缓存行的同步变得更加频繁,增加了内存访问的延迟。

### 2.3 锁的粒度与性能权衡

#### 2.3.1 锁粒度的定义

锁的粒度是指锁控制的资源范围大小。按照粒度的粗细,锁可以分为细粒度锁和粗粒度锁。细粒度锁控制的资源较少,能有效降低锁竞争的程度,提高程序的并发性能。粗粒度锁则控制的资源更多,实现简单,但在高并发环境下可能会成为性能瓶颈。

#### 2.3.2 不同锁粒度的性能影响

选择合适的锁粒度对于优化并发性能至关重要。细粒度锁虽然可以减少线程间对于共享资源的等待,但过度细化可能会导致锁的数量增多,增加了管理锁的复杂度和开销。粗粒度锁虽然简化了管理,但可能由于过多线程的等待而降低程序性能。通常,开发者需要在锁的粒度上做出权衡,考虑实际应用场景,实现最优的并发性能。

在下一章节中,我们会具体探讨如何在实践中优化锁的使用,包括减少锁的使用范围,使用读写锁提升性能,以及考虑锁的优先级和公平性。通过这些策略,可以在保证程序正确性的同时,有效提升并发程序的性能。

# 3. 锁优化的实践技巧

在现代的多线程并发编程中,合理地使用锁是保证数据一致性和线程安全的基础。然而,锁的不当使用往往会引入性能瓶颈。为了提高并发程序的效率,本章将探讨如何在实践中优化锁的使用,通过减少锁的使用范围、引入读写锁以及考虑锁的优先级与公平性等策略来提升性能。

## 3.1 减少锁的使用范围

在多线程编程中,减少临界区的大小是优化锁性能的关键策略之一。临界区是指需要保护的共享资源,确保任何时候只有一个线程可以访问。减少临界区意味着减少了线程等待锁的时间,从而提高程序的并发性能。

### 3.1.1 代码临界区的最小化

锁的使用应限制在最小的必要范围内,这样可以减少线程竞争锁的时间。下面是一个示例代码,展示了如何最小化代码临界区:

```python

import threading

# 共享资源

shared_resource = 0

# 锁对象

lock = threading.Lock()

def critical_section(value):

global shared_resource

with lock: # 进入临界区

# 保证修改操作的原子性

shared_resource = value

# 临界区外的操作

print(f"Updated shared_resource to {shared_resource}")

# 创建线程

threads = []

for _ in range(10):

t = threading.Thread(target=critical_section, args=(1,))

threads.append(t)

t.start()

# 等待所有线程完成

for t in threads:

t.join()

```

在这个例子中,我们使用`with lock`语句来确保只有更新`shared_resource`的部分在临界区内,从而最小化了临界区的范围。

### 3.1.2 锁分解技术的应用

锁分解是减少锁竞争的另一种技术,它指的是将大锁

0

0