Python并发编程性能调优:监控工具与优化策略

发布时间: 2024-09-01 03:43:30 阅读量: 400 订阅数: 110

# 1. Python并发编程基础与挑战

## Python并发编程简介

Python凭借其简洁的语法和强大的标准库,在开发高性能应用时也支持并发编程。并发编程可以让程序同时执行多个任务,提高效率,特别是在I/O密集型或者CPU密集型任务中表现显著。然而,与之伴随的挑战也不容忽视,比如线程安全、死锁等问题。

## 并发模型

在Python中,常用的并发模型包括多线程和多进程。由于全局解释器锁(GIL)的存在,Python的多线程在CPU密集型任务上的表现并不理想,但是多线程在I/O密集型任务上有着天然的优势。而多进程不受GIL限制,可以充分利用多核CPU的优势。

## 面临的挑战

Python并发编程面临的挑战主要包括线程管理和同步、进程间的通信和数据一致性问题。在多线程程序中,如果多个线程同时修改同一数据,不恰当的处理可能会导致数据不一致,甚至程序崩溃。而在多进程场景下,进程间的通信会变得更为复杂。

掌握并发编程基础是构建高效Python应用程序的第一步。接下来的章节中,我们将深入探讨Python并发编程中的监控工具、优化策略以及实战案例。

# 2. 并发编程监控工具详解

在多线程和多进程的并发编程中,性能监控和故障诊断是提高系统稳定性和性能的重要手段。本章节旨在深入剖析并发编程中的性能指标,以及如何选择和应用常见的监控工具来诊断性能问题,并通过实战案例展示监控工具的实际应用价值。

## 2.1 理解并发编程中的性能指标

在监控并发程序的性能时,需要关注多个关键指标,包括但不限于CPU和内存的使用率,以及线程或进程的状态。这些指标为开发者提供了系统运行时状态的快照,并帮助他们发现并解决问题。

### 2.1.1 CPU和内存使用率分析

CPU使用率是衡量并发程序性能的一个核心指标。高CPU使用率可能意味着程序在某个环节上有密集的计算任务,而低CPU使用率可能表明系统存在I/O等待或其他瓶颈。而内存使用率则反映了程序对系统内存资源的需求,高内存使用率可能会导致系统交换(swap)活动增加,从而影响程序性能。

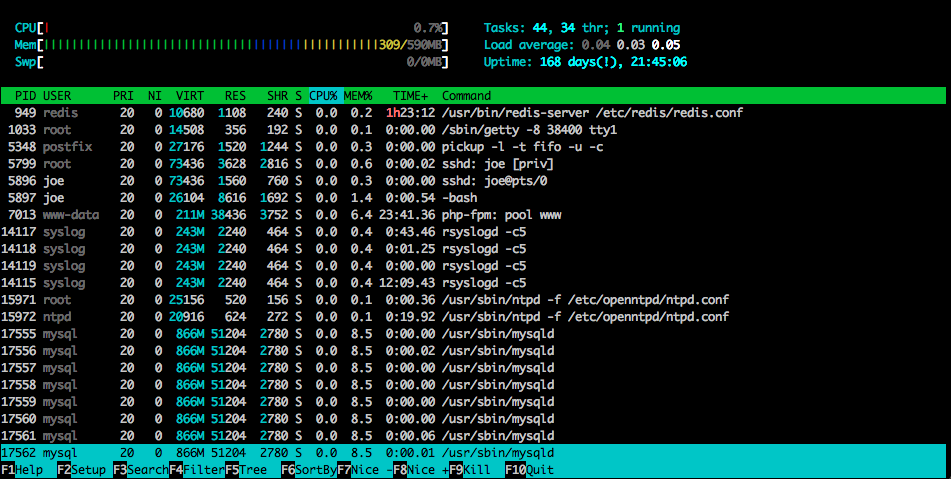

监控CPU和内存使用率,开发者可以使用操作系统自带的工具如`top`, `htop`, `vmstat`, 或者通过编写脚本利用Python的`psutil`库来实现持续监控。

### 2.1.2 线程/进程状态监控

并发程序中线程和进程的状态监控,对于诊断性能问题至关重要。需要监控的状态通常包括运行、阻塞、等待和终止等。通过了解各线程或进程的状态,可以分析系统的并发行为,并据此进行优化。

在Python中,可以使用`threading`或`multiprocessing`模块提供的功能来监控线程和进程的状态。例如,`threading.enumerate()`可以列出所有活跃线程,而`psutil`可以用来获取进程状态和资源使用信息。

## 2.2 常用的并发编程监控工具

选择合适的监控工具对于高效地调试和优化并发程序至关重要。本小节将详细介绍几个广泛使用的性能监控工具,它们各有特点,适用于不同场景。

### 2.2.1 cProfile与性能分析

cProfile是Python内置的性能分析工具,可以统计程序中各个函数的调用次数和耗时。它非常适合用于查找程序中的性能瓶颈。

使用cProfile进行性能分析的基本命令是:

```python

import cProfile

cProfile.run('your_program()')

```

上述命令会对`your_program()`函数执行的程序进行分析,并在结束后打印出每个函数的调用次数和总耗时。它还包括一些参数,比如输出到文件或控制输出细节。

### 2.2.2 Gprofiler与多线程应用监控

Gprofiler是一个跨平台的性能分析工具,它可以提供更详细的性能数据,特别是在多线程应用中。它能够对应用程序的CPU使用进行采样,并能分辨出各个线程的执行时间。

Gprofiler的使用示例代码如下:

```python

import gprofiler

def thread_function():

# some time-consuming operations

pass

threads = [threading.Thread(target=thread_function) for _ in range(4)]

for thread in threads:

thread.start()

for thread in threads:

thread.join()

```

在上述代码中,Gprofiler可用于监控每个线程的性能数据。

### 2.2.3 Pyflame和火焰图的生成与解读

Pyflame结合了火焰图的可视化技术,提供了一种直观的方式来展示程序的性能瓶颈。Pyflame能够捕获正在运行中的Python进程的快照,并生成一个用于创建火焰图的堆栈追踪文件。

生成火焰图的步骤通常包括:

1. 使用Pyflame捕获性能数据。

2. 使用FlameGraph工具生成可视化图形。

## 2.3 实践案例分析:监控工具的实际应用

监控工具的实际应用对开发人员来说是一个挑战,本小节将介绍如何选择合适的监控工具,以及如何应用这些工具来解决并发程序中的实际问题。

### 2.3.1 选择合适的监控工具

在选择监控工具时,需要考虑程序的具体需求、运行环境以及性能瓶颈的特点。例如,对于多进程程序,Gprofiler可能是一个更好的选择;而对于单线程应用,cProfile可能更简单直接。此外,还需要考虑监控工具的易用性、集成度以及社区支持等因素。

### 2.3.2 解决并发程序中的实际问题

在实际开发过程中,监控工具的使用要结合具体的性能问题。例如,如果发现某个线程长时间处于等待状态,可以使用Gprofiler查看该线程的详细调用堆栈,找出锁的等待点,并进一步使用锁分析工具来诊断死锁。而如果遇到程序响应缓慢,可以使用Pyflame生成火焰图,定位到具体是哪个函数或模块占用了大多数CPU时间。

以上就是关于并发编程监控工具的详细解析,下一章我们将进入并发编程优化策略的探讨。

# 3. Python并发编程优化策略

在并发编程的世界里,优化不仅仅是提高程序性能的手段,更是确保程序能够稳定运行和扩展的关键。在本章节中,我们将深入探讨Python并发编程中的优化策略,具体包括线程和进程优化技巧、异步编程与I/O多路复用,以及编程模式的选择与实践。

## 3.1 线程和进程优化技巧

优化并发程序的一个关键点是合理地管理线程和进程。Python中的线程由于全局解释器锁(GIL)的存在,在CPU密集型任务中受限,但仍然适用于I/O密集型任务。进程则是独立的执行单元,不受GIL限制,但创建和销毁进程的成本较高。因此,合理使用线程池和进程池可以大幅提升程序的性能和资源利用率。

### 3.1.1 线程池的使用与优势

线程池是一种资源池化技术,它预先创建一定数量的线程,避免了频繁创建和销毁线程的开销。在Python中,`concurrent.futures`模块提供了线程池的功能。使用线程池可以更有效地利用系统资源,提高程序性能。

```python

from concurrent.futures import ThreadPoolExecutor

def thread_function(name):

print(f'Thread {name}: starting')

# 模拟任务执行过程

return f'Thread {name}: finishing'

# 创建一个有3个线程的线程池

with ThreadPoolExecutor(max_workers=3) as executor:

results = [executor.submit(thread_function, i) for i in range(5)]

for f in concurrent.futures.as_completed(results):

print(f.result())

```

在上面的代码示例中,`ThreadPoolExecutor`创建了一个线程池,并通过`submit`方法提交任务。`as_completed`函数用于获取完成的任务结果。线程池会自动管理线程的复用和任务的分配。

使用线程池的优势在于:

- **资源复用**:线程池中的线程可以被重复利用,减少了线程创建和销毁的开销。

- **任务管理**:线程池提供了方便的任务管理机制,例如任务的提交、执行和结果的获取。

- **并发控制**:通过限制线程池的大小,可以控制程序的并发程度,避免过多线程造成资源竞争。

### 3.1.2 进程间通信与同步机制

在使用多进程模型时,进程间通信(IPC)是确保数据一致性和正确性的重要手段。Python的`multiprocessing`模块提供了丰富的IPC机制,如管道(Pipe)、队列(Queue)和共享内存(Value和Array)。

```python

from multiprocessing import Process, Queue

def worker(num, queue):

"""线程执行的函数"""

queue.put(f'任务 {num} 的结果')

if __name__ == '__main__':

queue = Queue()

processes = [

```

0

0