Hadoop DataNode版本兼容性挑战应对:升级不再烦恼的解决方案

发布时间: 2024-10-26 12:48:49 阅读量: 33 订阅数: 21

vb图书馆管理系统(源代码+论文)(20245j).7z

# 1. Hadoop DataNode概述

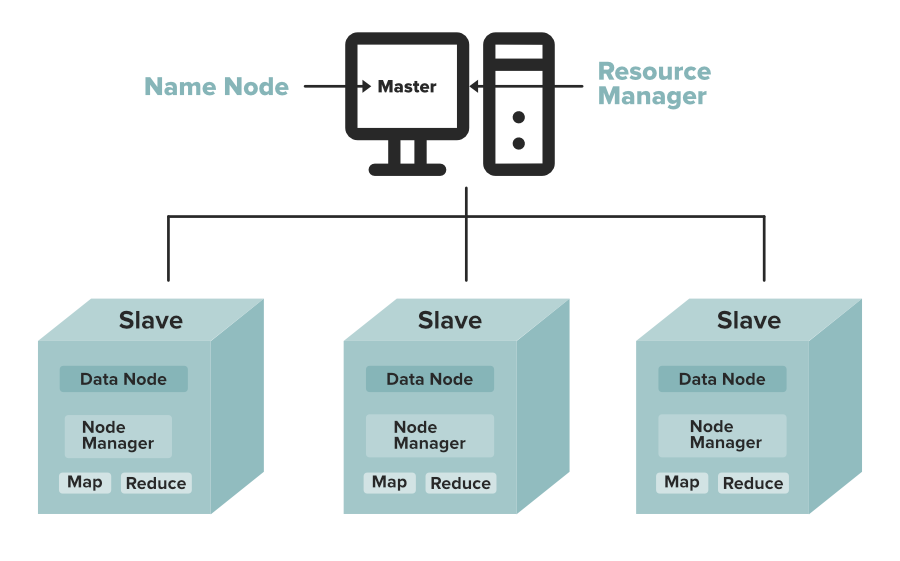

Hadoop DataNode是Hadoop分布式文件系统(HDFS)的重要组成部分,负责存储实际的数据块。作为Hadoop架构中数据存储的关键,DataNode保证了数据的可靠性和高可用性。它在Hadoop的生态系统中承担着数据持久化存储的角色,对于数据的读写操作起着至关重要的作用。

## 2.1 Hadoop生态系统中的DataNode组件

### 2.1.1 DataNode的角色和功能

DataNode是一个托管在普通机器上的守护进程,它在Hadoop集群中负责存储数据块。它接收来自客户端或NameNode的命令,进行数据的读写操作,并定期向NameNode报告自己的状态,以便NameNode进行资源管理和调度。

### 2.1.2 DataNode与NameNode的关系

DataNode与NameNode的通信是HDFS中数据管理的核心机制。NameNode负责管理文件系统的命名空间,维护文件系统树及整个文件系统元数据,而DataNode则负责处理文件系统客户端的读写请求。在文件存储方面,DataNode之间通过数据复制来保证数据的容错性和冗余。

通过以上内容,我们可以看到DataNode在Hadoop生态中的重要地位,以及它与NameNode之间的紧密关系。接下来,我们将深入探讨版本兼容性问题的原因及其解决方案。

# 2. Hadoop版本兼容性基础

### 2.1 Hadoop生态系统中的DataNode组件

#### 2.1.1 DataNode的角色和功能

Hadoop DataNode是分布式存储系统HDFS的核心组件之一,它主要负责存储数据块(block)并提供数据的读写服务。每个Hadoop集群都会部署多个DataNode,以实现数据的高可用性和容错能力。DataNode不仅响应来自客户端的读写请求,还定期向NameNode发送心跳信号,报告其健康状态以及处理的数据块信息。

在Hadoop 2.x及更高版本中,DataNode的职责被进一步细化,支持更多种类的数据存储形式,并且能够与YARN结合,提供资源管理和作业调度的服务。DataNode的性能和稳定性对整个Hadoop集群的运行效率有着决定性的影响。

#### 2.1.2 DataNode与NameNode的关系

DataNode与NameNode之间的关系是HDFS体系结构中最为关键的组成部分。NameNode是中心元数据管理节点,负责管理文件系统的命名空间和客户端对文件的访问。DataNode和NameNode之间通过心跳和块报告机制进行通信。DataNode定期向NameNode发送心跳,表明其存活状态,同时也报告数据块的存储信息。

当客户端发起文件读写请求时,NameNode根据文件元数据信息,指导客户端与特定的DataNode交互。在写操作中,NameNode决定数据块的放置位置,并通知客户端去相应的DataNode进行写入。读操作时,NameNode告诉客户端数据块所在的DataNode地址。这种设计模式,使得NameNode成为整个系统的瓶颈,而DataNode的设计目的是为了实现水平扩展,即通过增加更多的DataNode来提高存储容量和I/O吞吐量。

### 2.2 版本兼容性问题的原因分析

#### 2.2.1 Hadoop版本更新带来的变化

Hadoop版本的更新通常会包含新特性的引入、性能改进以及安全修复等。这些变化有时会导致新的版本与旧版本之间存在不兼容的问题。新的特性可能会改变原有的API,引入新的配置项,或者改变数据文件的存储格式。性能改进可能会优化数据处理流程,从而影响数据块的存储和读写效率。安全修复则可能会更新认证机制或加密算法,影响集群间的安全通信。

为了适应大数据生态的发展,Hadoop社区不断推进功能的扩展和更新,这就要求用户在升级到新版本时,仔细评估这些变化可能带来的影响,以确保集群的稳定运行。

#### 2.2.2 兼容性问题的常见类型和影响

兼容性问题通常可以分为以下几类:

- **API兼容性问题**:新的Hadoop版本可能会引入新的API或弃用旧的API。如果用户程序直接调用这些API,则需要对代码进行相应的修改,以适应API的变化。

- **数据格式兼容性问题**:新版本的Hadoop可能会采用新的数据格式存储信息,导致旧版本的Hadoop无法读取或正确解析这些数据。

- **配置项兼容性问题**:随着版本更新,可能会增加新的配置项或修改旧的配置项默认值。这要求用户在升级前仔细检查配置文件,确保它们的设置在新版本中依然有效。

- **运行时兼容性问题**:新版本的Hadoop可能对操作系统的依赖版本、Java版本或其他组件有特殊要求,这可能会要求用户对运行环境进行调整。

这些兼容性问题如果不进行适当处理,可能会导致集群升级失败,甚至数据丢失和业务中断。

### 2.3 理论上的兼容性解决方案探讨

#### 2.3.1 数据格式的转换方法

在面对数据格式变更导致的兼容性问题时,可以通过数据格式转换的方式来解决。具体步骤如下:

1. **备份数据**:在转换之前,首先对旧格式的数据进行备份,以防转换过程中出现问题。

2. **转换工具选择**:选择或开发合适的转换工具,该工具应能处理旧格式的数据,并将其转换为新格式。

3. **数据迁移**:利用转换工具对数据进行批量转换,并将转换后的数据迁移到新的存储位置。

4. **验证转换结果**:转换后需要对数据进行校验,确保转换的正确性和完整性。

5. **配置更新**:更新Hadoop集群配置,使其能够识别和使用新格式的数据。

数据格式转换工具的使用,能确保数据的一致性和完整性,同时降低因格式变更带来的风险。

#### 2.3.2 配置调整和参数优化

针对配置项的兼容性问题,解决的思路可以分为以下几个步骤:

1. **兼容性检查**:在升级前,使用兼容性检查工具或脚本来评估当前集群配置与新版本Hadoop的兼容性。

2. **配置文件备份**:备份现有的配置文件,以便在升级后出现问题时能够恢复到原始状态。

3. **参数调整**:根据新版本的要求,对配置文件中的参数进行调整。对于新增的配置项,按照推荐或默认值进行设置。

4. **测试验证**:修改配置后,启动集群进行测试,确保所有服务正常运行,系统性能没有下降。

5. **文档记录**:记录所有修改过的配置项及其原因,便于未来的维护和升级工作。

合理地调整和优化配置参数,可以最小化升级带来的影

0

0