Hadoop DataNode存储空间管理艺术:科学规划存储资源的方案

发布时间: 2024-10-26 12:45:36 阅读量: 37 订阅数: 34

# 1. Hadoop DataNode存储空间概述

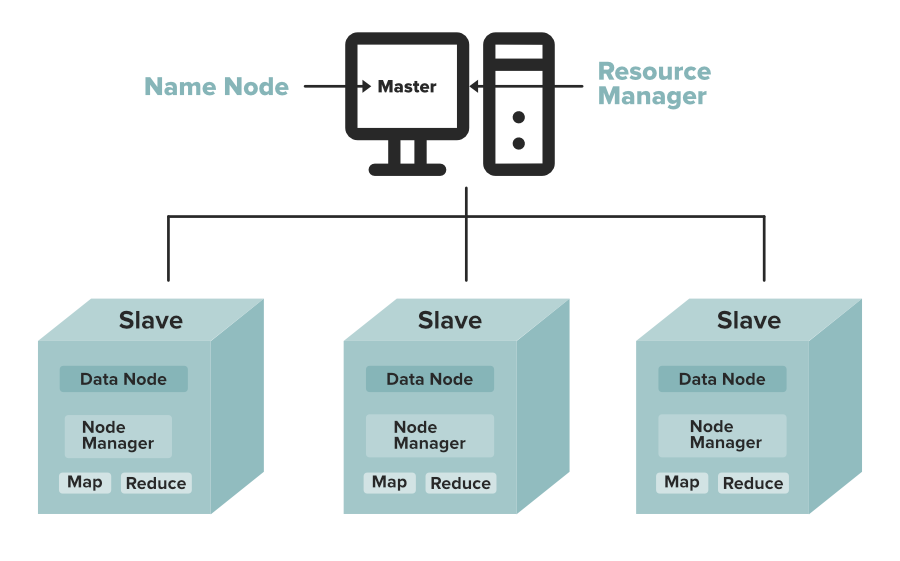

在现代数据中心,Hadoop作为一个成熟的分布式存储与处理框架,其DataNode节点扮演着存储数据的关键角色。为了优化存储效率和系统性能,理解DataNode的存储空间管理变得至关重要。本章旨在概述Hadoop DataNode的基本存储结构和空间概念,为深入探讨存储管理理论和实践操作打下基础。

在Hadoop的分布式文件系统(HDFS)架构中,DataNode负责存储实际的数据块,并与NameNode协调,以管理文件命名空间。DataNode节点的工作涉及数据块的读写、数据存储和节点间的通信。因此,DataNode的存储空间管理包括了数据块的创建、删除和复制,也涉及到磁盘容量的监控、空间配额设置以及故障恢复机制。

随着数据量的激增,传统的手动管理方式已不再适应大数据环境。对存储空间的有效管理不仅可以提升存储效率,还能保证系统的可靠性和性能。因此,探讨和实施自动化、智能化的存储空间管理策略,对于大数据运维工作来说,变得越来越必要。接下来的章节将进一步探讨存储空间管理的理论基础和具体的实践操作。

# 2. 存储空间管理的理论基础

### 2.1 Hadoop存储架构简析

#### 2.1.1 HDFS的数据存储模型

Hadoop分布式文件系统(HDFS)是大数据存储的核心,其数据存储模型是Hadoop生态系统的基础。HDFS将大数据集分散存储在由多个物理机器组成的集群上。数据被分成一系列的块(block),这些块默认大小为128MB(在Hadoop 2.x之前为64MB),并且会根据配置进行副本复制,以保证数据的可靠性。

在HDFS中,文件被分割成块,每个块的副本被存储在不同的DataNode上,而NameNode负责维护文件系统树及整个HDFS的元数据。DataNode则负责处理文件系统客户端的读写请求,并在NameNode的调度下进行数据的复制。

HDFS的数据存储模型通过块的划分和副本策略实现了负载均衡,也提高了系统的容错性。为了保证数据的安全性,通常会设置三个副本,即使某台DataNode发生故障,系统仍然可以从其它副本中恢复数据,从而实现高可用性。

#### 2.1.2 DataNode的角色和功能

DataNode是HDFS中负责实际数据存储的节点。在Hadoop集群中,DataNode通常运行在集群中的每台工作节点上。每个DataNode负责维护其上存储的数据块,并向NameNode提供块状态报告。它们执行读写操作,接收来自NameNode的指令,如复制数据块、删除数据块或进行数据块的移动。

DataNode还负责处理客户端的请求,这些请求包括数据读写操作。它们直接与客户端进行数据传输,一旦DataNode出现故障,NameNode会检测到并复制丢失的数据块,从而保证数据的高可用性。

总的来说,DataNode是Hadoop存储架构中不可或缺的一环,它负责数据的存储与传输,同时保证数据的可恢复性和可靠性。

### 2.2 存储空间管理的重要性

#### 2.2.1 提高存储效率的必要性

随着数据量的爆炸性增长,如何高效地管理存储空间成为了一个关键问题。提高存储效率能够确保系统以最低的资源使用提供最大的数据存储容量,这对于降低成本、提高整体系统性能至关重要。

存储效率的提升可以减少数据冗余,避免不必要的存储资源浪费,使存储资源得以充分利用。有效率的存储空间管理还可以减少数据迁移和副本同步的时间,提高数据处理速度,增强系统的响应能力。

#### 2.2.2 存储空间管理对性能的影响

存储空间管理的优劣直接影响了Hadoop集群的性能。良好的存储空间管理能够保证数据均匀分布于集群的各个节点,减少节点间的负载不均衡问题。避免热节点(即存储和处理数据量过大的节点)的产生,可以减少节点故障的概率,延长集群的稳定运行时间。

空间管理还直接影响了数据的访问速度和存储的可靠性。如果管理不当,数据可能会过于集中,导致部分节点的I/O负载过高,影响整体集群的性能。同时,如果存储空间的分配不够合理,可能会导致数据的读写速度下降,影响应用的响应时间。

### 2.3 空间管理的基本策略

#### 2.3.1 空间配额管理

空间配额管理是指在HDFS中为不同的用户或应用设置存储空间的上限。通过配额管理,可以限制特定用户或应用消耗过多存储资源,同时保证集群整体的高效运行。

配额管理通常由系统管理员进行设置。一旦达到设置的配额限制,相关的用户或应用将无法继续写入数据。管理员可以根据业务需求、预算和存储资源的状况,调整配额大小。

#### 2.3.2 自动负载均衡技术

负载均衡是Hadoop集群管理中的一项关键技术,它通过在各个DataNode之间合理分配数据块,使得集群内的存储和计算负载尽可能平均,避免某些节点负载过重,影响集群性能。

Hadoop提供了自动化的负载均衡工具,如Hadoop的Balancer工具。Balancer在检测到集群中的负载不均衡时,自动移动数据块以达到负载均衡。管理员也可以设定触发Balancer的条件,比如负载差异的百分比,从而实现更加精细的控制。

#### 2.3.3 垃圾回收机制

在Hadoop中,垃圾回收机制指的是删除无效或者不再被引用的数据块。随着数据的不断更新和删除,一些数据块可能变成了孤立的,不再有任何引用,这些数据块占据了宝贵的存储空间,因此需要被清理。

HDFS通过维护一个名为“回收站”(Trash)的功能,允许用户从回收站中恢复误删除的文件,增加了灵活性。但是,一旦回收站中的文件超过了用户设置的时间或容量限制,系统将会自动清理这些文件,释放存储空间。

```mermaid

graph LR

A[开始] --> B[检查DataNode负载]

B --> C{是否存在负载不均}

C --> |是| D[迁移数据块]

C --> |否| E[保持现状]

D --> F[更新NameNode元数据]

F --> G[负载均衡完成]

```

通过上述流程图,我们可以清晰地看到Hadoop负载均衡的大致执行流程。在这个过程中,HDFS通过维护和更新NameNode的元数据来实现负载均衡,确保数据在集群内的合理分配。

至此,我们已经探讨了存储空间管理的基础知识。在后续的章节中,我们将深入探讨存储空间管理的具体实践操作,包括监控工具的使用、存储空间的扩展与优化以及故障排查与空间恢复等策略。这些高级操作能够让读者更深入地理解如何在实际环境中对Hadoop存储空间进行管理与优化。

# 3. Hadoop DataNode存储空间实践操作

在Hadoop生态系统中,DataNode作为分布式文件系统HDFS的核心组件,负责存储实际的数据块。DataNode的存储空间管理是保证集群高效运行的关键环节。在本章节中,我们将深入探讨存储空间的监控分析、扩展优化以及故障排查与数据恢复的技术实践。

## 3.1 空间监控与分析工具使用

### 3.1.1 Hadoop自带的监控工具

Hadoop自带了丰富的监控工具,例如NameNode的Web UI界面,DataNode自带的JMX接口以及命令行工具hdfs dfsadmin。使用`hdfs dfsadmin -report`可以查看DataNode的健康状态、存储容量利用率以及读写情况。

```shell

hdfs dfsadmin -report

```

执行上述命令后,会得到如下格式的报告:

```

Configured Capacity: *** (111.07 TB)

Present Capacity: *** (109.27 TB)

DFS Remaining: *** (100.27 TB)

DFS Used: *** (9.0 GB)

DFS Used%: 8.32%

Under replicated blocks: 5555

Blocks with corrupt replicas: 0

Missing blocks: 0

Name: ***.***.*.*:50010 (node-1)

Hostname: node-1

Decommission Status : Normal

Configured Capacity: *** (91.86 TB)

Present Capacity: *** (90.96 TB)

DFS Remaining: *** (81.96 TB)

DFS Used: *** (9.0 GB)

DFS Used%: 9.09%

Block pool used bytes: *** (8.1 GB)

Under replicated blocks: 1111

Blocks with corrupt replicas: 0

Missing blocks: 0

Number of data-nodes: 1

Number of racks: 1

```

### 3.1.2 第三方监控工具的应用

除了Hadoop自带的监控工具,还有许多第三方工具可以在集群层面提供更加丰富的监控数据。如Ganglia、Nagios、Prometheus等。这些工具通常提供了更为直观的图形界面和报警机制。

以Prometheus为例,通过部署在集群中的exporters收集到DataNode的各种性能指标,再通过Grafana进行可视化展示。

### 3.1.3 操作示例

这里提供一个使用Prometheus和Grafana监控Hadoop集群的简要步骤:

1. 在每个DataNode上部署Node Exporter,收集CPU、内存、磁盘等硬件信息。

2. 在NameNode上部署Hadoop Exporter,收集HDFS相关的性能指标。

3. 配置Prometheus的scrape配置文件,添加上述exporters。

4. 启动Prometheus服务,设置合适的抓取频率。

5. 部署Grafana,创建Hadoop相关的仪表板,导入Prometheus作为数据源。

6. 在Grafana中,创建图表和仪表,展示所需监控的数据。

## 3.2 存储空间的扩展与优化

### 3.2.1 磁盘容量的在线扩展技术

当集群中的存储空间不足时,可以采取在线扩展磁盘容量的方法。对于Hadoop来说,可以通过增加DataNode上的磁盘数量或者替换更大容量的磁盘来实现。

需要注意的是,在扩展存储空间时,应当合理规划和执行,以避免数据丢失或者服务中断。以下是一个使用LVM进行磁盘扩展的基本步骤:

1. 将新的磁盘设备添加到DataNode服务器上。

2. 使用fdisk或其它工具进行分区。

3. 使用pvcreate命令创建物理卷。

4. 使用vgcreate命令创建卷组。

5. 使用lvextend命令扩展逻辑卷。

6. 调整文件系统的大小,例如使用resize2fs对ext系列文件系统进

0

0