Hadoop DataNode故障预防手册:建立监控和预警的完美机制

发布时间: 2024-10-26 12:19:43 阅读量: 4 订阅数: 6

# 1. Hadoop DataNode基础

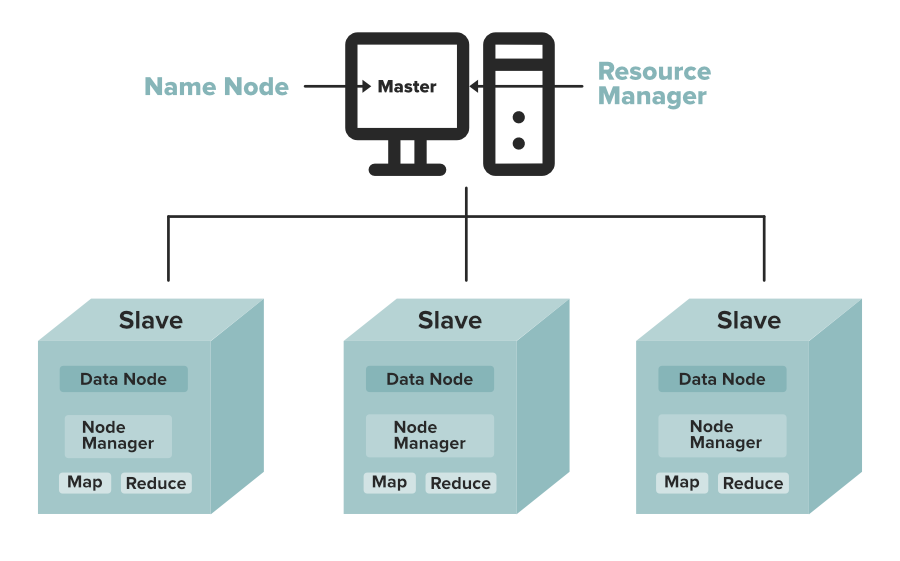

## 1.1 DataNode在Hadoop生态系统中的角色

Hadoop DataNode作为Hadoop分布式文件系统(HDFS)的一部分,主要负责存储和管理数据块。DataNode节点运行在集群的多个工作节点上,提供数据的物理存储,并与NameNode协同工作,确保数据的可靠性和高可用性。理解DataNode的工作机制对于维护大型分布式系统的稳定运行至关重要。

## 1.2 DataNode的核心功能

DataNode的核心功能包括但不限于:

- **数据存储**:将数据分为块存储在本地文件系统中。

- **数据复制**:根据配置和需求,自动复制数据块以提供冗余。

- **数据恢复**:在检测到数据错误时,通过与其他DataNode的通信来恢复数据。

- **心跳检测**:定期向NameNode报告状态,确保整个系统的健康运行。

## 1.3 DataNode与NameNode的交互

DataNode与NameNode之间的通信对整个HDFS的运行至关重要。DataNode通过发送心跳消息和块报告给NameNode,保持节点状态的更新。而NameNode则监控DataNode节点,分配数据存储任务,并在发生错误时进行恢复操作。这种机制保证了Hadoop集群能够高效、稳定地运行。

# 2. DataNode故障理论分析

在大数据环境的生态系统中,Hadoop作为一个核心框架,其稳定性对于数据存储和处理有着至关重要的作用。DataNode作为Hadoop分布式文件系统(HDFS)中的工作节点,承载着数据的存储任务。然而,在实际运行中,DataNode可能会面临各类故障,这些故障可能来自于硬件层面,也可能来自于软件配置或设计。深入分析故障类型和原因,评估故障的影响,并制定有效的预防策略,是确保Hadoop系统稳定运行的关键。

## 2.1 故障类型与原因

### 2.1.1 硬件故障及其影响

硬件故障是DataNode遇到的最直接和常见的问题,主要涉及硬盘、内存、网络接口等关键部件的损坏或性能下降。硬盘故障会导致存储在上面的数据丢失,影响数据的完整性和可用性。内存问题可能导致DataNode进程异常,造成服务中断或性能下降。网络问题则影响DataNode与其他节点的数据同步,可能导致数据复制延迟或失败。

当DataNode发生硬件故障时,会触发HDFS内部的容错机制,通过副本来重建丢失的数据。但在极端情况下,如果多个副本同时损坏,或整个DataNode无法恢复,那么将直接影响整个HDFS的可用性。

为了减少硬件故障带来的影响,应定期对硬件进行健康检查,及时更换或维修损坏的部件。同时,部署硬件级别的冗余策略,如RAID技术,可以进一步保障数据的安全性。

### 2.1.2 软件缺陷和配置错误

软件缺陷可能来源于Hadoop本身的bug、第三方库的不兼容问题或是自定义代码的错误。这些软件层面的问题可能导致DataNode运行不稳定,甚至崩溃。配置错误往往由于管理员对系统理解不足或者配置不当造成,比如设置的内存大小不符合实际需求,可能造成内存溢出或浪费。

在处理软件缺陷时,及时更新到最新的稳定版本,并进行充分的测试是预防软件问题的有效方式。而对于配置错误,则需要定期进行配置审核和性能监控,以确保配置的合理性。

## 2.2 故障影响评估

### 2.2.1 故障对数据完整性和性能的影响

故障的直接影响是数据的丢失或损坏。在分布式系统中,数据的副本策略能够在一定程度上恢复数据的完整性。但如果故障节点上的数据副本数量不足,会导致系统无法恢复数据,进而影响整个Hadoop集群的稳定运行。

性能影响主要体现在故障节点上数据读写速度的下降。由于DataNode是数据读写的主体,一旦某个节点发生故障,相关的读写任务需要转移到其他节点上,这无疑会加重其他节点的负担,可能导致整个集群性能的下降。

### 2.2.2 集群健康度的评估方法

集群健康度的评估依赖于多个关键指标,包括节点的可用性、数据副本的健康状况、网络的响应时间和CPU及内存的使用率。通过定期的健康检查,可以及时发现潜在的故障节点,并对整个集群进行评估。

为了更直观地监控集群状态,可以利用各种监控工具,如Ganglia、Nagios或Ambari等,它们可以帮助管理员实时监控集群的关键指标,并通过图表或告警的形式直观地展示出来。

## 2.3 故障预防策略

### 2.3.1 硬件冗余和负载均衡

为了降低硬件故障带来的风险,必须实施硬件层面的冗余策略。除了单个节点的RAID技术,还可以通过增加DataNode的数量,来实现整个集群的冗余。负载均衡则可以保障数据在集群中均匀分布,避免因个别节点过载而造成单点故障。

在硬件层面,可以使用HDFS的自动故障转移机制,例如在主从架构中配置Secondary NameNode来处理数据备份。在软件层面,还可以采用DataNode跨机架的数据分布策略,以减少单点故障的风险。

### 2.3.2 软件更新和安全最佳实践

定期更新Hadoop集群到最新版本,是预防软件缺陷的主要手段。同时,及时更新和打补丁也是保障系统安全的重要措施。在配置管理方面,应该遵循最小权限原则,减少配置错误的风险。此外,进行定期的代码审查和测试,可以确保新功能的引入不会对现有系统造成不良影响。

在安全性方面,加强网络安全管理和限制不必要的端口访问也是必要的措施。通过这些最佳实践,可以显著提高Hadoop集群的安全性和稳定性。

# 3. Hadoop监控系统构建

构建一个高效的监控系统是保障Hadoop集群稳定运行的关键。一个良好的监控系统可以及时发现集群中的问题,并提供足够的信息帮助管理员进行故障诊断和性能调优。

## 3.1 监控指标和工具选择

### 3.1.1 选择关键性能指标

监控Hadoop集群的性能时,需要关注以下几个关键指标:

- **CPU和内存利用率**:查看集群中节点的CPU和内存是否得到合理利用,以及是否存在资源瓶颈。

- **磁盘I/O性能**:监控磁盘读写速度和吞吐量,了解磁盘是否成为性能瓶颈。

- **网络带宽和延迟**:网络传输的速度和延迟会影响数据处理的效率。

- **DataNode存储利用率**:监控各个DataNode的磁盘空间使用情况,避免数据存储不足。

- **任务运行情况**:包括任务队列长度、任务运行时间、任务状态等,有助于分析集群负载和任务调度效率。

### 3.1.2 评估和选择监控工具

选择合适的监控工具对于构建一个高效的监控系统至关重要。当前市场上存在多种开源和商业监控工具,例如Ganglia、Nagios、Zabbix以及基于Prometheus和Grafana的解决方案。

监控工具的选择需要考虑以下因素:

- **可扩展性**:工具应该能够支持集群规模的扩大而无需大量额外配置。

- **易用性**:监控界面应该直观且易于操作,有助于快速定位问题。

- **集成能力**:需要能够和其他系统(如告警系统)集成。

- **自定义**:监控规则和报警策略应该可以方便地进行定制。

## 3.2 监控系统部署实践

### 3.2.1 配置监控代理和服务

部署监控系统的第一步通常是安装和配置监控代理。以Prometheus为例,它采用pull方式从目标节点收集指标信息。一个典型的监控代理配置可能如下:

```yaml

global:

scrape_interval: 30s

scrape_configs:

- job_name: 'prometheus'

static_configs:

- targets: ['localhost:9090']

labels:

instance: 'prometheus'

- job_name: 'data-node'

static_configs:

- targets: ['node1:9100', 'node2:9100']

labels:

instance: 'data-node'

```

### 3.2.2 监控系统的数据收集和展示

在Prometheus配置完成后,它会定期从配置的`targets`收集数据。Grafana则作为一个强大的可视化工具,可以将这些数据绘制成图表,进行实时监控。

一个典型的Grafana仪表板展示DataNode存储利用率的图表配置可能如下:

```json

{

"targets": [

{

"refId": "A",

"query": "prometheus_data_node_storage",

"datasource": "Prometheus"

}

],

"title": "DataNode Storage Utilization",

"panels": [

{

"title": "S

```

0

0