【批归一化指南】:在CNN中实现最佳性能的最佳实践

发布时间: 2024-09-03 06:59:47 阅读量: 72 订阅数: 48

基于Python的机器学习实践指南

# 1. 批归一化的理论基础

批归一化(Batch Normalization)是深度学习领域中用于优化网络训练过程的一种技术。其核心思想在于,通过标准化层输入的均值和方差来实现输入的稳定性,降低内部协变量偏移(Internal Covariate Shift),从而加速网络的训练速度,提升模型的泛化能力。

## 1.1 批归一化概念解析

批归一化由Sergey Ioffe和Christian Szegedy在2015年提出,首次在训练中动态地调整了各层的输入分布,使得每一层的激活函数输入都尽可能保持在稳定的分布状态。这种方法帮助缓解了深层网络训练中梯度消失或爆炸的问题,并在一定程度上充当了正则化的效果,减少了对Dropout等正则化技术的依赖。

## 1.2 批归一化的数学原理和作用

在数学上,批归一化通过对一个minibatch的数据进行操作,计算每个特征的均值和方差,然后将每个特征标准化到均值为0,方差为1的分布。数学公式如下:

```math

\mu_B \leftarrow \frac{1}{m}\sum_{i=1}^{m} x_i

\quad \quad \quad \quad \sigma_B^2 \leftarrow \frac{1}{m}\sum_{i=1}^{m}(x_i - \mu_B)^2

\quad \quad \quad \quad \hat{x}_i \leftarrow \frac{x_i - \mu_B}{\sqrt{\sigma_B^2 + \epsilon}}

```

其中,\(x_i\) 是输入特征,\(\mu_B\) 和 \(\sigma_B^2\) 分别为minibatch的均值和方差,\(\hat{x}_i\) 是标准化后的值,\(\epsilon\) 是为了避免除以零而加入的平滑项。通过这种方式,批归一化使网络层的输入分布更加稳定,进而提升模型训练的效率和性能。

# 2. 批归一化技术在CNN中的实现

## 2.1 批归一化的数学原理

### 2.1.1 标准化与批归一化

标准化(Standardization)是数据预处理中的一个常见步骤,它的目的是将输入数据的均值变为0,标准差变为1,使数据具有相同的尺度,这样可以加快梯度下降的过程,并在一定程度上避免梯度消失或者爆炸的问题。而批归一化(Batch Normalization)是一种在深度学习中用于加速训练的技巧,其思想是在网络的每一层输入上进行标准化处理,不过是在每个小批量(batch)数据上执行。

### 2.1.2 批归一化的数学公式和作用

批归一化的公式可以表述为:

\[ \mu_{\mathcal{B}} \leftarrow \frac{1}{m}\sum_{i=1}^{m} x_i \]

\[ \sigma_{\mathcal{B}}^2 \leftarrow \frac{1}{m}\sum_{i=1}^{m} (x_i - \mu_{\mathcal{B}})^2 \]

\[ \hat{x}_i \leftarrow \frac{x_i - \mu_{\mathcal{B}}}{\sqrt{\sigma_{\mathcal{B}}^2 + \epsilon}} \]

\[ y_i \leftarrow \gamma \hat{x}_i + \beta \]

在这里,\(\mu_{\mathcal{B}}\) 和 \(\sigma_{\mathcal{B}}^2\) 分别表示在每个小批量数据上计算出的均值和方差。\(x_i\) 是原始数据,\(\hat{x}_i\) 是归一化后的数据。参数 \(\gamma\) 和 \(\beta\) 用于调整归一化后的数据分布,它们是学习得到的,使得模型有足够的灵活性来选择是否使用批归一化。常数 \(\epsilon\) 是为了避免除以零的数值问题,通常取一个很小的值,如1e-5。

批归一化的关键作用在于它减少了内部协变量偏移(Internal Covariate Shift),即每一层输入数据分布的变化。由于网络中每层的权重更新,下层的输出分布会不断变化,导致上层的输入分布也在不断变化,批归一化能够缓解这种变化,从而使网络更加稳定,训练速度加快。

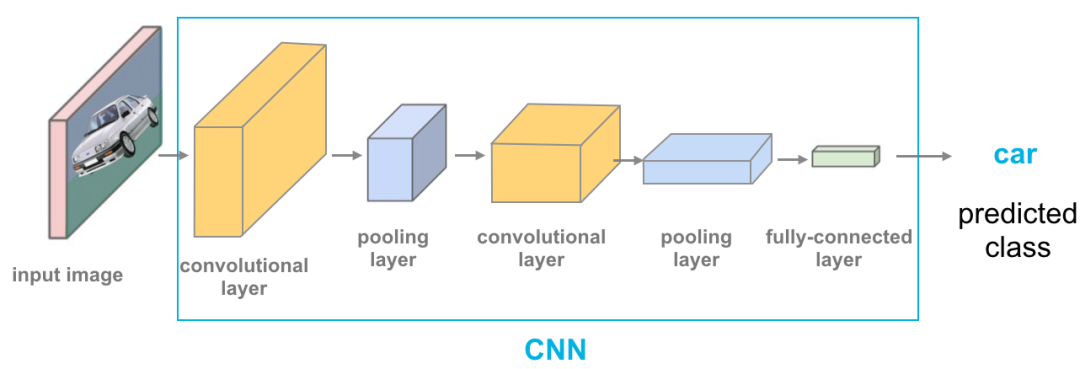

## 2.2 批归一化在卷积神经网络中的位置

### 2.2.1 批归一化的放置策略

在卷积神经网络(CNN)中,批归一化层通常放置在卷积层和激活层之间,具体来说,对于每一个卷积层(或者全连接层),我们通常紧跟一个批归一化层,然后再通过一个非线性激活函数(如ReLU)。这样做的目的不仅是为了归一化卷积层的输出,而且还可以为激活函数“清理”输入数据。

### 2.2.2 批归一化与卷积层、池化层的交互

批归一化层与卷积层、池化层的交互可以大大提升网络的性能。卷积层负责提取特征,而批归一化层则保证了这些特征的分布更加稳定,这有利于激活函数更好地执行其非线性变换。池化层通常用在相邻的卷积层之间,批归一化层并不会干扰池化层的功能,但批归一化层保证了池化层处理的数据分布更加一致,这有助于网络学习到更加鲁棒的特征。

## 2.3 批归一化与模型训练的关系

### 2.3.1 加速收敛和防止过拟合

批归一化有助于加速模型的收敛。由于减少了输入分布的漂移,模型更不容易在训练过程中陷入梯度消失或梯度爆炸的问题,因此可以在更高的学习率下训练模型,从而加快收敛速度。

同时,批归一化也被观察到具有一定的正则化效果,它能够轻微地减少过拟合的风险。然而,这种效果相较于传统的正则化方法(如Dropout或权重衰减)通常较小,因此在实践中如果发现过拟合,仍需考虑添加其他正则化技巧。

### 2.3.2 学习率调整与批归一化

在使用批归一化时,由于网络的稳定性得到了提升,可以使用更高的学习率来加速模型的收敛。但高学习率同时可能带来训练过程中的不稳定,因此调整学习率时需要考虑到批归一化的影响。经验上,当引入批归一化后,可以将学习率提升一个数量级,例如从0.001提升到0.01,然后根据模型训练的效果逐步调整。

### 2.3.3 代码示例与逻辑分析

以下是使用PyTorch实现卷积神经网络中的批归一化层的一个简单示例:

```python

import torch

import torch.nn as nn

class ConvBNReLU(nn.Module):

def __init__(self, in_channels, out_channels, kernel_size, stride, padding):

super(ConvBNReLU, self).__init__()

self.conv = nn.Conv2d(in_channels, out_channels, kernel_size, stride, padding, bias=False)

self.bn = nn.BatchNorm2d(out_channels)

self.relu = nn.ReLU(inplace=True)

def forward(self, x):

x = self.conv(x)

x = self.bn(x)

x = self.relu(x)

return x

# 使用示例

model = ConvBNReLU(in_channels=3, out_channels=64, kernel_size=3, stride=1, padding=1)

```

在这个例子中,`ConvBNReLU`类实现了卷积层后接批归一化层和ReLU激活函数的组合。在`forward`方法中,输入数据`x`首先经过卷积操作,然后传递给`BatchNorm2d`进行归一化处理,最后应用ReLU激活函数。这种方法确保了模型在每个卷积层后都能获得稳定的数据分布。

批归一化层中的`bias`参数被设置为`False`,因为批归一化层会计算输入数据的均值和方差,从而实现数据的归一化。如果`conv`层包含偏置项,那么在批归一化中就不需要额外的偏置,因此设置`bias=False`避免重复添加偏置参数。在每个小批量数据上,批归一化会计算归一化的均值(mean)和方差(variance),然后将输入数据标准化,之后根据学习到的参数\(\gamma\)和\(\beta\)调整归一化后的数据,以保持网络的表达能力。

需要注意的是,在PyTorch中,`BatchNorm2d`的输入数据期望的形状是`[batch_size, channels, height, width]`,因此在准备数据时,需要保证数据的维度顺序符合这一要求。此外,为了配合使用GPU进行加速,所有模型参数和输入数据都应转移到相应的设备上(如`model.to(device)`和`data.to(device)`),其中`device`可以是CPU或GPU。

# 3. 批归一化的实践技巧

## 3.1 不同深度学习框架下的批归一化实现

### 3.1.1 TensorFlow中的批归一化

TensorFlow是目前

0

0