【激活函数深度解析】:CNN中的非线性转换与性能提升秘籍

发布时间: 2024-09-03 06:46:04 阅读量: 91 订阅数: 48

深度学习CNN算法原理 深度学习原理.pdf

# 1. 激活函数在CNN中的角色

在深度学习中,卷积神经网络(CNN)已经成为图像识别和处理领域的核心技术之一。激活函数作为CNN中最重要的组成部分之一,担负着引入非线性的关键作用,确保模型能够学习并表达复杂的特征。随着网络深度的增加,激活函数的性能直接影响到模型的表达能力和训练效率。在接下来的内容中,我们将深入探讨激活函数在CNN中的角色、基础理论,以及如何在实践中选择和应用适合的激活函数。我们将从激活函数的基本概念开始,逐步深入到具体的应用案例,分析和比较不同激活函数的性能,以及它们在未来研究中的潜在发展方向。

# 2. 基础激活函数理论

## 2.1 激活函数的定义和功能

### 2.1.1 非线性的必要性

在神经网络中,非线性是区别于传统线性模型的关键特性。线性模型,如线性回归,只能解决线性关系问题。然而,现实世界的大多数问题都是非线性的,这意味着数据点之间的关系不可能通过简单的线性模型捕捉。

激活函数引入非线性,使得神经网络能够学习和模拟更复杂的函数关系。如果没有非线性激活函数,无论神经网络有多少层,最终输出也只是输入的线性组合,这极大地限制了模型的表达能力。

### 2.1.2 激活函数的历史演变

从早期的人工神经网络研究开始,激活函数已经历了多次变革。早期的神经网络主要使用线性激活函数,这种模型结构相对简单,但由于其表达能力有限,导致模型在解决复杂问题时效果不佳。

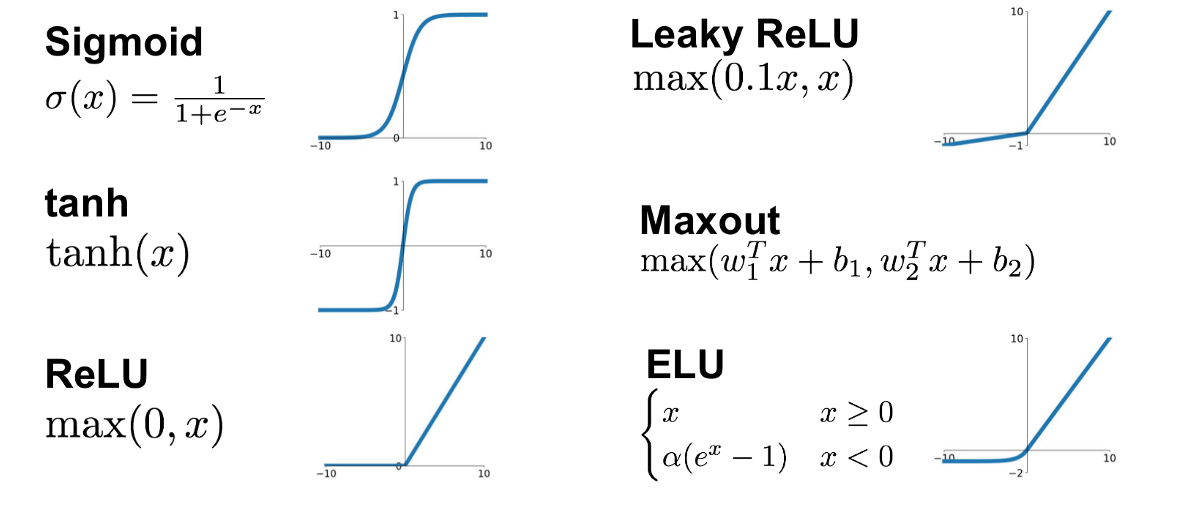

随着研究的深入,非线性激活函数如Sigmoid和Tanh开始流行,它们给模型带来了更强的学习能力。然而,这些函数存在梯度消失的问题,尤其是在深层网络中,这限制了网络的深度和性能。

ReLU(Rectified Linear Unit)函数的出现,因其计算简单和具有稀疏性质,极大地缓解了梯度消失的问题,并且加速了训练过程。因此,ReLU和它的变体成为了深度学习模型中最常用的激活函数之一。

## 2.2 常见激活函数详解

### 2.2.1 Sigmoid函数

Sigmoid函数是一个在生物学中用于模拟神经元活动的函数。它在输入为0时有0.5的输出,在正负无穷大的输入下分别趋向于1和0。数学表达式如下:

```python

def sigmoid(x):

return 1 / (1 + np.exp(-x))

```

Sigmoid函数具有平滑且连续的导数,这在优化过程中有利于梯度的传播。然而,由于其在两端的输出趋近于饱和,导致梯度接近于0,这会导致梯度消失问题。

### 2.2.2 Tanh函数

Tanh函数是Sigmoid函数的变形,输出范围在-1到1之间,中心点为0。它的数学表达式如下:

```python

def tanh(x):

return np.tanh(x)

```

Tanh函数相对于Sigmoid函数具有零中心化的特性,这有助于加速收敛过程。不过,Tanh函数同样在两端存在梯度消失的问题,且输出值的范围虽然比Sigmoid更广,但仍然有限。

### 2.2.3 ReLU函数

ReLU函数是目前最流行的激活函数之一,其表达式为:

```python

def relu(x):

return np.maximum(0, x)

```

ReLU函数将负值置为0,正值保持不变。它解决了Sigmoid和Tanh函数的梯度消失问题,并且由于其非饱和性质,使得训练深层网络时更快。但ReLU存在“死亡ReLU”问题,即部分神经元可能永远不会激活,导致它们无法学习任何东西。

## 2.3 激活函数的选择标准

### 2.3.1 导数和梯度消失问题

选择激活函数时,导数的性质是一个重要考虑因素。导数不仅影响梯度的传播,而且决定着学习过程中权重的更新效率。

对于深层网络而言,激活函数的导数不应该在输入数据的合理范围内接近于零。例如,Sigmoid和Tanh函数由于在远离原点时导数趋于零,容易导致梯度消失。而ReLU在正值范围内导数为1,有效缓解了这个问题。

### 2.3.2 函数值的范围和分布

激活函数的输出值的范围和分布对于网络的性能也有影响。例如,Tanh函数输出值的范围是-1到1,这使得它的均值更接近于0,有助于后续层的输入分布保持均值为0。相反,ReLU的输出是非负的,可能导致数据分布偏向正数,这可能需要后续层使用特定的策略来调整。

### 2.3.3 计算效率对比

除了理论性能外,激活函数的计算效率也是选择的重要标准。一些激活函数(比如ReLU)计算简单,耗时少,适合大规模深度学习模型使用。而Sigmoid和Tanh等函数由于涉及指数运算,计算上更加昂贵。

为了权衡性能和效率,研究人员和工程师会根据实际应用场景的需要,在模型设计时选择合适的激活函数。

# 3. 激活函数在CNN中的实践应用

## 3.1 激活函数在卷积层的作用

在卷积神经网络(CNN)中,激活函数不仅是简单地引入非线性因素,它们还在卷积层中起到了至关重要的作用,以增强模型的特征提取能力。

### 3.1.1 增强特征提取能力

激活函数在卷积层的一个核心作用是引入非线性,这对于提升网络提取复杂特征的能力是必不可少的。如果没有非线性激活函数,无论网络有多少层,最终输出都只是输入的线性组合,这将大大限制网络的表达能力。以ReLU函数为例,它通过设定负值部分为0,有效地引入了非线性,使得网络能够学习和表示更加复杂的模式。

```python

def relu(x):

return np.maximum(0, x)

# 示例输入

input_signal = np.array([-3, -2, -1, 0, 1, 2, 3])

# 激活处理

output_signal = relu(input_signal)

print("ReLU激活后的信号:", output_signal)

```

### 3.1.2 与卷积操作的结合效应

卷积操作在CNN中负责提取输入数据的空间特征,而激活函数则处理这些特征,赋予其非线性变换。结合效应体现在卷积层通过滤波器提取特征后,激活函数进一步强化这些特征的显著性。比如,在使用ReLU时,正值部分可以被放大,而负值则被抑制,这种机制有助于强化对目标识别有贡

0

0