GBM梯度提升机在分布式计算中的应用:大规模数据处理与模型训练,突破计算瓶颈

发布时间: 2024-08-21 19:09:11 阅读量: 54 订阅数: 23

# 1. GBM梯度提升机的理论基础**

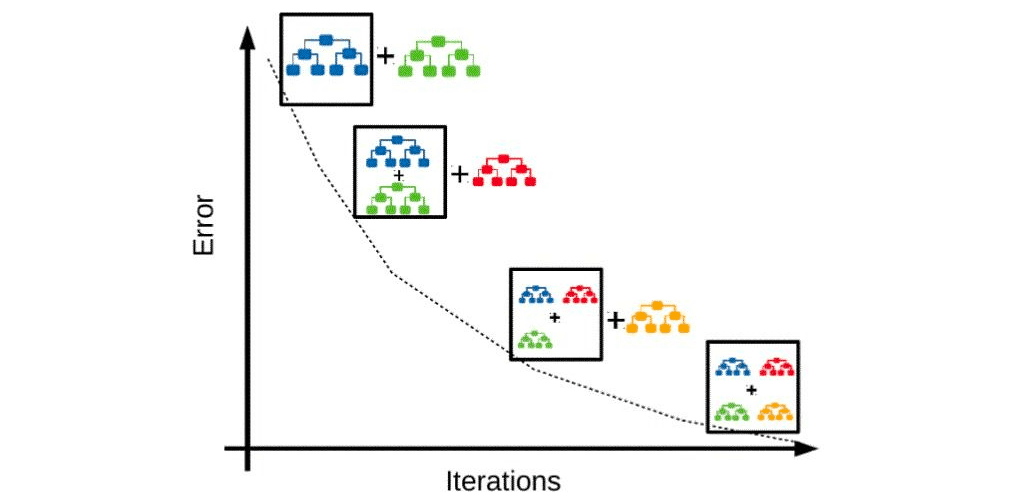

GBM(梯度提升机)是一种强大的机器学习算法,它通过组合多个弱学习器(例如决策树)来构建一个强学习器。其基本原理是:

1. **初始化:**从一个常数预测开始,表示模型的初始预测。

2. **迭代:**在每个迭代中,根据当前模型的预测误差,构建一个新的弱学习器。该弱学习器旨在纠正前一个弱学习器的错误。

3. **加权:**将新弱学习器添加到模型中,并为其分配一个权重。权重根据弱学习器的性能(例如准确率)确定。

4. **更新预测:**使用所有弱学习器的加权预测更新模型的预测。

5. **重复:**重复步骤 2-4,直到达到预定义的迭代次数或满足停止条件。

# 2. GBM梯度提升机在分布式计算中的应用

### 2.1 分布式计算架构

**2.1.1 Hadoop MapReduce框架**

Hadoop MapReduce是一种分布式计算框架,用于处理大规模数据集。它将计算任务分解为较小的子任务,并在集群中的多个节点上并行执行。MapReduce框架由两个主要阶段组成:

- **Map阶段:**将输入数据集映射到键值对,其中键是唯一标识符,值是与键关联的数据。

- **Reduce阶段:**将具有相同键的值分组在一起,并应用reduce函数来聚合或处理数据。

**2.1.2 Spark分布式计算引擎**

Spark是一种统一的分布式计算引擎,用于大规模数据处理和分析。它提供了比MapReduce更高级别的抽象,并支持多种数据处理操作,包括:

- **弹性分布式数据集(RDD):**一种分布式内存抽象,用于表示数据,并支持并行操作。

- **转换:**对RDD执行操作,例如过滤、映射和连接。

- **动作:**触发RDD上的计算,例如收集数据或将其写入文件。

### 2.2 GBM梯度提升机的并行化实现

GBM梯度提升机是一种并行化友好的算法,可以利用分布式计算框架来提高其性能。有三种主要的并行化实现方式:

**2.2.1 数据并行**

数据并行将训练数据分布在集群中的多个节点上。每个节点负责训练模型的一个副本,并使用本地数据进行更新。最终,将各个节点上的模型聚合起来形成最终模型。

**2.2.2 模型并行**

模型并行将模型拆分为多个子模型,并在不同的节点上训练。每个节点负责训练模型的一个子部分,并与其他节点交换梯度信息以更新模型。

**2.2.3 混合并行**

混合并行结合了数据并行和模型并行。它将训练数据分布在多个节点上,并同时将模型拆分为多个子模型。每个节点负责训练模型的一个子部分,并使用本地数据进行更新。

### 代码示例:Spark中的GBM梯度提升机并行训练

```python

i

```

0

0