GBM梯度提升机与XGBoost:性能与场景,全面分析

发布时间: 2024-08-21 18:40:17 阅读量: 40 订阅数: 33

# 1. 机器学习中的梯度提升方法**

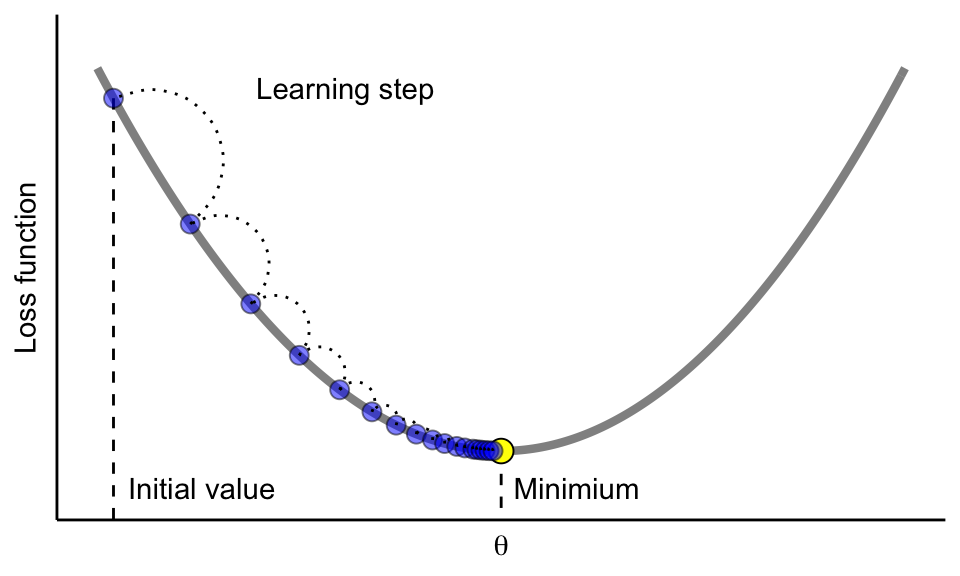

梯度提升方法(Gradient Boosting)是一种强大的机器学习算法,它通过组合多个弱学习器来构建一个强大的预测模型。梯度提升方法的核心思想是迭代地添加新的学习器,每个学习器都专注于纠正前一个学习器的错误。

梯度提升方法的优点包括:

* 能够处理高维和非线性数据

* 鲁棒性强,不易过拟合

* 可以通过调整超参数来优化模型性能

# 2.1 GBM算法原理

GBM(Gradient Boosting Machine)梯度提升机是一种机器学习算法,它通过集成多个弱学习器(如决策树)来构建一个强大的预测模型。GBM算法的基本原理如下:

1. **初始化:**

- 初始化一个常数预测值作为初始模型。

2. **迭代:**

- 对于每个迭代t:

- 计算当前模型的负梯度(残差),即真实值与预测值之间的差值。

- 拟合一个弱学习器(如决策树)来预测负梯度。

- 将弱学习器的预测值添加到当前模型中,得到更新的模型。

3. **结束:**

- 重复迭代,直到达到预定义的迭代次数或其他停止条件。

GBM算法的优点包括:

- **鲁棒性:**GBM对异常值和噪声数据具有鲁棒性。

- **可解释性:**GBM模型可以分解为一系列决策树,这使得它们易于解释。

- **泛化能力:**GBM算法通过集成多个弱学习器来减少过拟合,从而提高模型的泛化能力。

### GBM算法流程

GBM算法的流程可以用以下伪代码表示:

```python

# 初始化

model = 0

# 迭代

for t in range(1, T):

# 计算负梯度

gradient = y - model(X)

# 拟合弱学习器

weak_learner = fit(X, gradient)

# 更新模型

model += weak_learner(X)

```

其中:

- `T` 是迭代次数。

- `y` 是真实值。

- `X` 是特征矩阵。

- `model` 是当前模型。

- `weak_learner` 是弱学习器。

# 3. XGBoost梯度提升机

### 3.1 XGBoost算法原理

XGBoost(Extreme Gradient Boosting)是一种先进的梯度提升算法,它对GBM算法进行了改进,提升了模型的准确性和泛化能力。XGBoost算法的核心思想与GBM类似,都是通过迭代地训练多个弱学习器,并通过加权组合的方式得到最终的强学习器。

与GBM不同的是,XGBoost在训练过程中引入了正则化项,以防止过拟合。正则化项包括L1正则化和L2正则化,其中L1正则化可以使模型更稀疏,L2正则化可以使模型更平滑。

此外,XGBoost还采用了树剪枝技术,以控制树的复杂度。树剪枝是指在训练过程中,对树进行修剪,移除不重要的分支或节点,以防止过拟合。

### 3.2 XGBoost超参数调优

XGBoost算法的超参数包括学习率、树的最大深度、树的最小样本数、正则化参数等。超参数的调优对于模型的性能至关重要。

常用的超参数调优方法包括网格搜索、随机搜索和贝叶斯优化。其中,网格搜索是一种穷举搜索的方法,它遍历所有可能的超参数组合,找到最优的组合。随机搜索是一种随机采样方法,它随机选择超参数组合,并通过多次迭代找到最优的组合。贝叶斯优化是一种基于贝叶斯定理的优化方法,它通过构建超参数的概率分布,并迭代更新分布,找到最优的超参数组合

0

0