GBM梯度提升机在回归任务中的预测秘籍:探索其强大能力

发布时间: 2024-08-21 18:37:55 阅读量: 32 订阅数: 33

# 1. GBM梯度提升机简介

GBM(Gradient Boosting Machine)梯度提升机是一种强大的机器学习算法,广泛应用于回归和分类任务。它是一种集成学习算法,通过组合多个弱学习器来创建一个强学习器。GBM梯度提升机使用梯度提升算法,在每次迭代中拟合一个新的弱学习器来减少前一个弱学习器的残差。通过这种方式,GBM梯度提升机可以逐步逼近目标函数,并获得更好的预测性能。

# 2. GBM梯度提升机理论基础

### 2.1 梯度提升算法原理

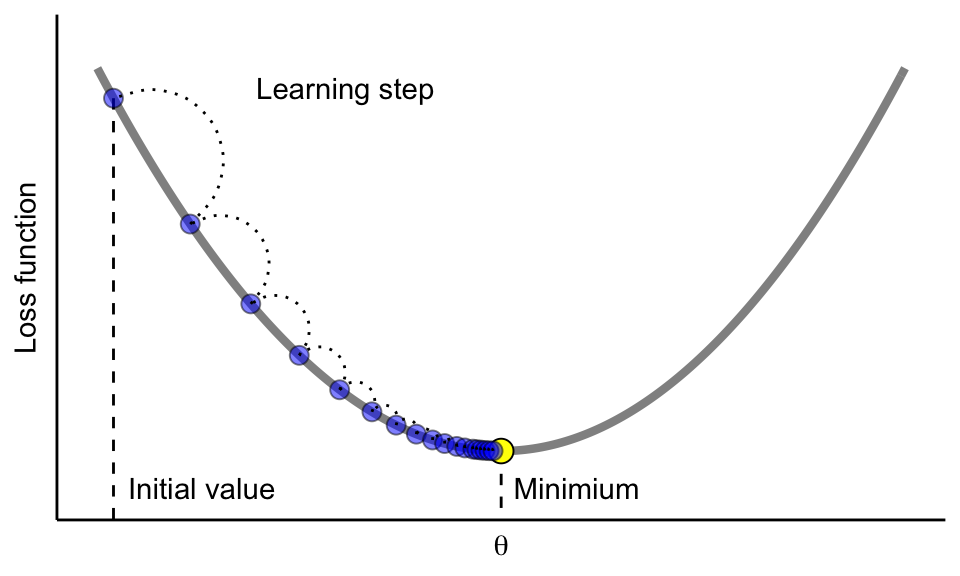

梯度提升算法是一种迭代算法,通过逐步添加弱学习器来构建强学习器。弱学习器可以是决策树、线性回归或其他简单的模型。

算法从一个初始模型开始,该模型通常是一个常数预测。然后,它迭代地添加弱学习器,每个弱学习器都专注于纠正前一轮预测中的错误。

在每一步中,算法计算当前模型的梯度(即损失函数对模型参数的导数)。然后,它训练一个新的弱学习器来拟合梯度。新的弱学习器与当前模型相结合,形成新的模型。

这个过程重复进行,直到达到预定的迭代次数或满足某个停止准则。最终模型是所有弱学习器的加权和。

### 2.2 GBM梯度提升机模型

GBM(Gradient Boosting Machine)梯度提升机是一种特定的梯度提升算法,它使用决策树作为弱学习器。GBM模型由一系列决策树组成,每个决策树都基于前一棵树的残差进行训练。

残差是真实值和当前模型预测值之间的差值。通过专注于纠正残差,GBM模型可以逐步提高模型的准确性。

### 2.3 GBM梯度提升机参数优化

GBM梯度提升机模型的性能受多种参数影响,包括:

- **学习率:**学习率控制每个弱学习器对最终模型的影响程度。较小的学习率会导致更平滑的模型,而较大的学习率会导致更复杂、更容易过拟合的模型。

- **树的深度:**树的深度控制决策树的复杂性。较深的树可以拟合更复杂的数据,但更容易过拟合。

- **叶子节点最小样本数:**叶子节点最小样本数控制每个叶子节点中允许的最小样本数。较小的值会导致更复杂的树,而较大的值会导致更简单的树。

- **最大树数:**最大树数控制模型中允许的最大树数。较大的值会导致更复杂的模型,而较小的值会导致更简单的模型。

这些参数可以通过交叉验证或网格搜索进行优化,以找到最佳的模型性能。

#### 代码示例

```python

import xgboost as xgb

# 创建 GBM 模型

model = xgb.XGBClassifier()

# 设置参数

model.set_params(

learning_rate=0.1,

max_depth=5,

min_child_weight=1,

n_estimators=100,

)

# 训练模型

model.fit(X_train, y_train)

```

#### 代码逻辑分析

0

0