【Python外部排序】:大规模数据排序的策略与技巧

发布时间: 2024-09-01 00:49:18 阅读量: 131 订阅数: 64

排序算法可以分为内部排序和外部排序,内部排序是数据记录在内存中进行排序,而外部排序是因排序的数据很大,一次不能容纳全部的排序记录

# 1. Python外部排序概述

## 1.1 外部排序的定义与重要性

外部排序是解决大数据排序问题的一种重要技术,它突破了内存大小的限制,通过将数据分批加载到内存中进行排序,再将排序好的数据写回存储设备,有效处理超出物理内存限制的大型数据集。对于数据科学家、数据库管理员以及需要处理大量数据的IT专业人士来说,掌握外部排序技术是必不可少的。

## 1.2 应用场景举例

一个常见的应用场景是日志分析。网站或应用服务器会记录大量的用户操作日志,这些日志数据量巨大,无法一次性载入内存进行分析,因此需要使用外部排序来处理。通过外部排序,系统能够高效地对这些日志进行排序、分类和检索,以支撑后续的数据分析和决策支持。

## 1.3 Python语言的优势

Python由于其简洁的语法和强大的库支持,成为处理外部排序问题的首选语言之一。它不仅拥有丰富的数据处理库,如pandas和numpy,还能够快速实现各种数据结构和算法,使得编写外部排序算法变得更为简单高效。下一章,我们将详细讨论外部排序的基本原理。

# 2. 外部排序的基本原理

## 2.1 排序算法基础

### 2.1.1 内部排序与外部排序的区别

在了解外部排序之前,首先区分内部排序和外部排序的差异至关重要。内部排序指的是所有数据可以加载到内存中进行处理的排序算法,常见于较小的数据集。相比之下,外部排序是用于数据量大到无法一次性装入内存的情况,它将数据存储在外部存储设备上,如硬盘,并通过一系列读写操作来完成排序。

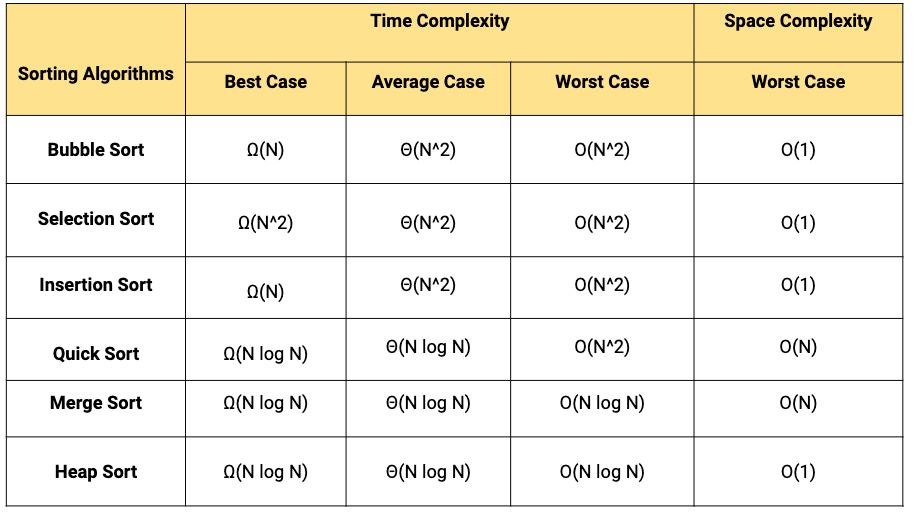

外部排序与内部排序的区别不仅仅是数据规模,还包括使用的算法和实现的复杂性。内部排序算法比如快速排序、归并排序等,依赖于对数据的直接操作。而外部排序则需要考虑磁盘I/O操作的开销,因此设计更加复杂。

### 2.1.2 外部排序中的关键术语和概念

理解外部排序之前,需要熟悉几个关键概念:

- **块(Block)**:在外部排序中,数据通常是按块读写的。一个块可以看作是一个数据项的集合,它在内存中的大小与操作系统和文件系统有关。

- **缓冲区(Buffer)**:为了减少磁盘I/O次数,会使用内存作为临时存储空间来缓冲数据。缓冲区的大小和管理策略直接影响排序效率。

- **多路归并(Multi-way Merge)**:在归并排序过程中,从多个已排序的数据块中挑选最小(或最大)元素,逐步归并到最终排序结果中。

- **磁盘I/O(Disk Input/Output)**:指计算机与外部存储设备之间的数据交换。磁盘I/O操作相比内存操作来说,速度较慢,因此优化I/O是外部排序的重点。

## 2.2 外部排序的算法模型

### 2.2.1 多路归并排序

多路归并排序是外部排序中最常用的算法之一。基本思想是先将数据分割成若干个可以加载到内存中的部分,各自独立排序,然后逐步归并这些已排序的部分。

该算法的关键步骤包括:

1. 分割:将整个待排序文件分割为若干个小文件,每个小文件的大小应保证可以被一次性读入内存。

2. 排序:对每个小文件进行独立的内部排序。

3. 归并:利用多路归并算法,将所有小文件逐步合并为一个大的有序文件。

### 2.2.2 替补选择排序

替补选择排序是另一种适合外部排序的算法,它利用了优先队列(最小堆)来选择每个数据块中的最小元素,以便进行归并排序。

该算法的步骤可以概括为:

1. 构建最小堆:从所有数据块中,读取第一个元素构建最小堆。

2. 选择最小元素:从堆中选择最小的元素,并将其写入输出文件。

3. 堆调整:将最小元素所在数据块的下一个元素读入堆中,保持堆的性质。

4. 重复操作:重复步骤2和3,直到所有元素都被写入输出文件。

### 2.2.3 整个排序过程的步骤详解

外部排序过程可以分为以下步骤:

1. **分割阶段**:将原始大文件分割成多个小文件。

2. **局部排序阶段**:对每个小文件进行局部排序。

3. **归并排序阶段**:逐步将所有局部有序的小文件归并成一个完全有序的大文件。

在进行归并排序时,可以使用多路归并排序算法,每次从多个已排序的小文件中读取一定数量的数据块到缓冲区,排序这些数据块,然后将排序后的数据输出到最终的文件中。

## 2.3 磁盘I/O优化

### 2.3.1 缓冲区管理策略

为了减少磁盘I/O操作,优化缓冲区的管理是关键。可以采用“预取”(Prefetching)和“缓存”(Caching)策略来提高I/O效率。

预取策略预先加载可能即将需要的数据块,从而减少等待时间。而缓存策略则是将频繁访问的数据暂时保存在内存中,当后续需要时直接从内存读取。

### 2.3.2 减少磁盘I/O次数的方法

减少磁盘I/O次数可以从以下几个方面来实现:

- **合并小文件**:尽量减少待排序文件的数量,这可以通过合并小文件为大文件的方式实现。

- **合理设置缓冲区大小**:缓冲区过大或过小都会影响效率。过大会导致内存不足,过小则无法有效减少I/O次数。

- **批量读写操作**:将多个小的I/O操作合并为一个较大的I/O操作,可以显著提高效率。

减少磁盘I/O次数不仅能够加速外部排序,还可以优化整个数据处理流程。

# 3. Python实现外部排序

## 3.1 Python中的文件操作

### 3.1.1 文件读写和内存管理

在处理大量数据时,文件操作是不可或缺的一个步骤。Python 提供了丰富且直观的文件操作接口。文件的读写操作对于内存的管理提出了特别的要求。针对大数据量的文件操作,我们通常需要采用分批读取(chunk by chunk)的方式来避免内存溢出。

使用 `open` 函数以读模式打开文件,可以对文件进行逐行读取。例如:

```python

with open('large_file.txt', 'r') as ***

***

***

```

其中 `process(line)` 是对读取的每一行进行处理的函数。需要注意的是,对于大文件,逐行读取(尤其是在文本文件中)可以有效减少内存的占用。

写入文件时,可以将数据分批写入缓冲区,然后一次性写入文件,这样可以减少磁盘的I/O操作次数。示例如下:

```python

buffer_size = 1024 # 定义缓冲区大小

buffer = []

with open('output_file.txt', 'w') as ***

***

*** 将数据块添加到缓冲区

if len(buffer) == buffer_size:

file.writelines(buffer) # 将缓冲区内容写入文件

buffer.clear() # 清空缓冲区

if buffer: # 处理剩余的数据

file.writelines(buffer)

```

上述代码片段中,`read_large_file()` 表示读取大文件的函数,`buffer` 是用于暂存数据的缓冲区。

### 3.1.2 大文件处理技巧

在处理大文件时,我们需要特别注意内存和性能的问题。以下是一些高效处理大文件的技巧:

- 使用生成器避免一次性加载整个文件到内存中。

- 对于文本文件,可以使用 `mmap` 模块来实现高效的文件读取操作。

- 对于二进制文件,合理地使用 `struct` 模块来解析文件内容可以提高性能。

- 利用 Python 的 `contextlib.closing` 上下文管理器确保文件在操作完成后被正确关闭。

## 3.2 外部排序的Python代码实现

### 3.2.1 划分与排序子文件

在外部排序的第一阶段,需要将大文件划分为多个较小的子文件,并在内存中对每个子文件进行排序。这个过程可以使用 Python 的 `heapq` 模块来实现优先队列,从而有效地控制内存使用。

以下是一个简单的示例代码,展示如何读取大文件,对数据进行排序,并将排好序的数据块存储到子文件中:

```python

import heapq

def read_and_sort(input_file, output_file_prefix):

with open(input_file, 'r') as in***

*** 读取所有行到列表中

# 使用heapq模块对数据进行排序

heapq.heapify(lines) # 转换为最小堆结构

with open(output_file_prefix + 'part_0', 'w') as out***

* 写入排序后的前100行到第一个子文件

for _ in range(100):

outfile.write(heapq.heappop(lines))

# 假设有一个大文件 'large_file.txt'

read_and_sort('large_file.txt', 'sorted_part_')

```

在本段代码中,我们首先使用 `heapq.heapify` 将整个文件的内容转换成堆结构,然后使用 `heapq.heappop` 方法循环弹出最小元素,并写入到子文件中。这里假设每部分有100行,实际情况需要根据内存容量来调整这个值。

### 3.2.2 归并子文件

在第二阶段,所有排序好的子文件需要被合并成一个完全排序的大文件。这部分需要使用多路归并算法,Python 的 `heapq` 模块同样可以提供帮助:

```python

import heapq

import os

def merge_sorted_files(files, output_file):

# 创建一个最小堆,初始包含所有文件的行

min_heap = [(open(file, 'r'), index) for index, file in enumerate(files)]

heapq.heapify(min_heap)

# 读取最小堆中的行,写入到输出文件中

with open(output_file, 'w') as out***

***

***

***

***

***

***

* 假设 'sorted_part_*' 是分割好的子文件列表

sorted_files = ['sort

```

0

0