【SVM分类算法的终极指南】:从入门到精通

发布时间: 2024-08-20 04:10:17 阅读量: 37 订阅数: 28

4.SVM分类算法_分类算法_SVM_

# 1. SVM分类算法基础**

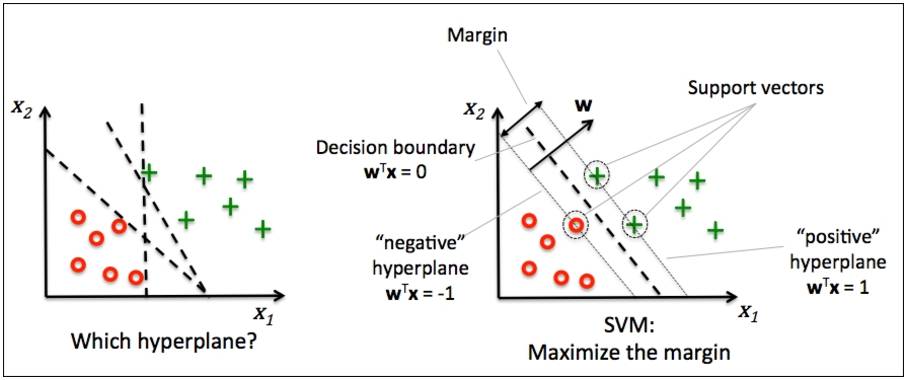

SVM(支持向量机)分类算法是一种强大的机器学习算法,用于对数据进行分类。它是一种监督学习算法,这意味着它需要标记的数据进行训练。SVM算法通过在数据点之间找到一个最佳超平面来工作,该超平面可以将不同的类分开。

超平面是一个决策边界,它将数据点分成不同的类。SVM算法通过最大化超平面和数据点的距离来找到最佳超平面。这称为最大化边距。最大化边距有助于提高分类器的泛化性能,使其能够更好地处理新数据。

# 2.1 SVM算法的数学基础

### 2.1.1 线性可分和线性不可分问题

**线性可分问题**

线性可分问题是指存在一个超平面,可以将数据点完全分开,即所有数据点都在超平面的不同侧。如下图所示:

[Image of a linearly separable dataset]

**线性不可分问题**

线性不可分问题是指不存在一个超平面可以完全分开数据点,即总有一些数据点落在超平面的同侧。如下图所示:

[Image of a linearly inseparable dataset]

### 2.1.2 超平面和支持向量

**超平面**

超平面是将数据点分开的线或平面。对于二维数据,超平面是一条直线;对于三维数据,超平面是一个平面。超平面的方程可以表示为:

```

w^T x + b = 0

```

其中:

* w 是超平面的法向量

* x 是数据点

* b 是超平面的截距

**支持向量**

支持向量是位于超平面两侧距离最近的数据点。这些数据点对超平面的位置和方向至关重要。如下图所示:

[Image of a hyperplane and support vectors]

支持向量决定了超平面的最大化间隔,即超平面与数据点的最小距离。最大化间隔可以提高分类器的鲁棒性和泛化能力。

# 3. SVM分类算法实践应用

### 3.1 SVM分类算法的实现

#### 3.1.1 Python中SVM分类算法的实现

```python

from sklearn.svm import SVC

# 创建SVM分类器

clf = SVC()

# 训练SVM分类器

clf.fit(X_train, y_train)

# 预测测试集

y_pred = clf.predict(X_test)

```

**代码逻辑逐行解读:**

1. 从`sklearn.svm`模块导入`SVC`类,用于创建SVM分类器。

2. 创建一个`SVC`实例`clf`,该实例包含SVM分类器的默认参数。

3. 使用训练数据`X_train`和标签`y_train`调用`fit()`方法训练SVM分类器。

4. 使用测试数据`X_test`调用`predict()`方法预测标签,并将其存储在`y_pred`中。

**参数说明:**

* `C`:惩罚参数,用于控制模型的复杂度。

* `kernel`:核函数类型,用于将数据映射到更高维度的特征空间。

* `degree`:多项式核函数的度。

* `gamma`:RBF核函数的系数。

#### 3.1.2 R中SVM分类算法的实现

```r

library(e1071)

# 创建SVM分类器

svm_model <- svm(Species ~ ., data = iris)

# 预测测试集

y_pred <- predict(svm_model, iris[-5])

```

**代码逻辑逐行解读:**

1. 加载`e1071`包,该包包含SVM分类算法的实现。

2. 使用`svm()`函数创建SVM分类器`svm_model`,其中`Species`是目标变量,`iris`是数据集。

3. 使用`predict()`函数预测测试集`iris[-5]`的标签,并将其存储在`y_pred`中。

**参数说明:**

* `kernel`:核函数类型。

* `cost`:惩罚参数。

* `gamma`:RBF核函数的系数。

* `degree`:多项式核函数的度。

### 3.2 SVM分类算法的超参数优化

#### 3.2.1 网格搜索和交叉验证

网格搜索是一种超参数优化技术,它通过尝试参数的各种组合来找到最佳参数设置。交叉验证是一种评估模型性能的方法,它将数据集划分为多个子集,并使用其中一个子集进行训练,而其他子集用于验证。

**代码示例:**

```python

from sklearn.model_selection import GridSearchCV

# 定义参数网格

param_grid = {'C': [0.1, 1, 10], 'kernel': ['linear', 'rbf'], 'gamma': [0.1, 1, 10]}

# 创建网格搜索对象

grid_search = GridSearchCV(SVC(), param_grid, cv=5)

# 训练网格搜索

grid_search.fit(X_train, y_train)

# 获取最佳参数

best_params = grid_search.best_params_

```

**代码逻辑逐行解读:**

1. 从`sklearn.model_selection`模块导入`GridSearchCV`类。

2. 定义参数网格`param_grid`,其中包含要优化的参数及其值范围。

3. 创建`GridSearchCV`对象`grid_search`,指定SVM分类器、参数网格和交叉验证折数。

4. 调用`fit()`方法训练网格搜索,同时使用训练数据`X_train`和标签`y_train`。

5. 从`grid_search`中获取最佳参数`best_params`。

#### 3.2.2 调参策略和技巧

调参策略和技巧可以帮助提高SVM分类算法的性能。一些常见的策略包括:

* **交叉验证:**使用交叉验证来评估模型性能,并选择在所有折数上表现最佳的参数设置。

* **特征缩放:**对特征进行缩放,使它们具有相似的范围,可以提高模型的稳定性和性能。

* **特征选择:**选择对预测目标变量最重要的特征,可以减少模型的复杂度并提高性能。

* **核函数选择:**选择最适合数据的核函数类型,可以显著影响模型的性能。

* **惩罚参数调整:**调整惩罚参数`C`可以控制模型的复杂度和泛化能力。

# 4. SVM分类算法进阶应用**

**4.1 多分类SVM算法**

多分类问题是指将数据点分类到多个类别的情况。SVM算法最初是为二分类问题设计的,但它可以通过以下两种方法扩展到多分类问题:

**4.1.1 一对一和一对多的方法**

* **一对一(One-vs-One)方法:**将多分类问题分解为多个二分类问题。对于K个类别,它将训练K*(K-1)/2个SVM分类器,每个分类器负责区分两个不同的类别。在预测时,将输入数据点提交给所有分类器,并选择获得最多票数的类别。

* **一对多(One-vs-Many)方法:**将多分类问题分解为K个二分类问题,其中每个问题将一个类别与其他所有类别区分开来。在预测时,将输入数据点提交给所有分类器,并选择具有最高置信度的分类器对应的类别。

**4.1.2 多类SVM算法的实现**

在Python中,可以使用scikit-learn库实现多类SVM算法:

```python

from sklearn.svm import SVC

# 一对一方法

clf = SVC(kernel='linear', decision_function_shape='ovo')

# 一对多方法

clf = SVC(kernel='linear', decision_function_shape='ovr')

```

**4.2 非线性SVM算法**

线性SVM算法只能处理线性可分的数据。对于非线性可分的数据,可以使用非线性SVM算法,它将数据映射到更高维度的特征空间,使其在该空间中线性可分。

**4.2.1 核函数的类型和选择**

核函数是将数据映射到特征空间的函数。常用的核函数包括:

* **线性核:** `K(x, y) = x^T y`

* **多项式核:** `K(x, y) = (x^T y + c)^d`

* **径向基核(RBF):** `K(x, y) = exp(-gamma * ||x - y||^2)`

核函数的选择取决于数据的性质和问题。

**4.2.2 非线性SVM算法的应用**

在Python中,可以使用scikit-learn库实现非线性SVM算法:

```python

from sklearn.svm import SVC

# 使用RBF核函数

clf = SVC(kernel='rbf', gamma=0.1)

```

**代码逻辑逐行解读:**

* `clf = SVC(kernel='rbf', gamma=0.1)`:创建一个SVM分类器,指定核函数为RBF,并设置gamma参数为0.1。

# 5. SVM分类算法的评估与调优

### 5.1 SVM分类算法的评估指标

评估SVM分类算法的性能至关重要,因为它可以帮助我们了解模型的有效性并指导进一步的调优。常用的评估指标包括:

- **准确率(Accuracy)**:预测正确的样本数量与总样本数量的比率。

- **召回率(Recall)**:预测为正类的正样本数量与实际正样本数量的比率。

- **F1值(F1-score)**:准确率和召回率的加权调和平均值,综合考虑了准确性和召回率。

### 5.2 SVM分类算法的调优策略

为了提高SVM分类算法的性能,我们可以通过调优超参数和优化数据来进行调优。

#### 5.2.1 超参数调优

SVM分类算法的超参数包括核函数、惩罚参数(C)和核函数参数(γ)。通过网格搜索和交叉验证等技术,我们可以找到这些超参数的最佳组合。

**网格搜索**:在给定的超参数范围内,系统地尝试所有可能的超参数组合,并选择性能最佳的组合。

**交叉验证**:将数据集划分为训练集和测试集,多次重复训练和评估模型,以获得更可靠的性能评估。

#### 5.2.2 特征选择和数据预处理

特征选择和数据预处理可以提高SVM分类算法的性能。

**特征选择**:从原始特征集中选择最具信息量和区分度的特征,以减少模型的复杂性和提高准确性。

**数据预处理**:对数据进行归一化、标准化或降维等处理,可以改善数据的分布和提高模型的收敛速度。

### 5.3 调优示例

以下是一个SVM分类算法调优的示例:

```python

# 导入必要的库

import numpy as np

import pandas as pd

from sklearn.svm import SVC

from sklearn.model_selection import GridSearchCV

# 加载数据

data = pd.read_csv('data.csv')

X = data.drop('label', axis=1)

y = data['label']

# 定义超参数网格

param_grid = {'C': [0.1, 1, 10], 'kernel': ['linear', 'rbf'], 'gamma': [0.1, 1, 10]}

# 网格搜索

grid_search = GridSearchCV(SVC(), param_grid, cv=5)

grid_search.fit(X, y)

# 打印最佳超参数和性能

print('最佳超参数:', grid_search.best_params_)

print('最佳性能:', grid_search.best_score_)

```

通过调优超参数和优化数据,我们可以显著提高SVM分类算法的性能,使其在实际应用中更有效。

# 6. SVM分类算法的应用案例**

**6.1 文本分类**

**6.1.1 文本特征提取**

文本分类中,文本特征提取是至关重要的步骤。常用的文本特征提取方法包括:

* **词袋模型(Bag-of-Words):**将文本表示为词频向量,忽略词序和语法。

* **TF-IDF(Term Frequency-Inverse Document Frequency):**基于词频和逆文档频率对词语进行加权,突出重要词语。

* **N-gram:**将文本切分为连续的n个词语的序列,形成新的特征。

**6.1.2 SVM分类算法在文本分类中的应用**

SVM分类算法在文本分类中应用广泛。其步骤如下:

1. **数据预处理:**对文本数据进行分词、去停用词和归一化等处理。

2. **特征提取:**使用上述方法提取文本特征。

3. **模型训练:**使用SVM分类算法训练模型,选择合适的核函数和超参数。

4. **模型评估:**使用准确率、召回率和F1值等指标评估模型性能。

**6.2 图像分类**

**6.2.1 图像特征提取**

图像分类中,图像特征提取同样重要。常用的图像特征提取方法包括:

* **直方图:**统计图像中像素值在不同范围内的分布。

* **局部二值模式(LBP):**描述图像局部区域的纹理信息。

* **深度学习特征:**使用卷积神经网络(CNN)提取图像的高级特征。

**6.2.2 SVM分类算法在图像分类中的应用**

SVM分类算法在图像分类中也得到广泛应用。其步骤与文本分类类似:

1. **数据预处理:**对图像数据进行尺寸调整、归一化和增强等处理。

2. **特征提取:**使用上述方法提取图像特征。

3. **模型训练:**使用SVM分类算法训练模型,选择合适的核函数和超参数。

4. **模型评估:**使用准确率、召回率和F1值等指标评估模型性能。

0

0