全面解码:Pandas库安装与配置指南(新手必学,专家必看)

发布时间: 2024-12-07 08:29:31 阅读量: 48 订阅数: 16

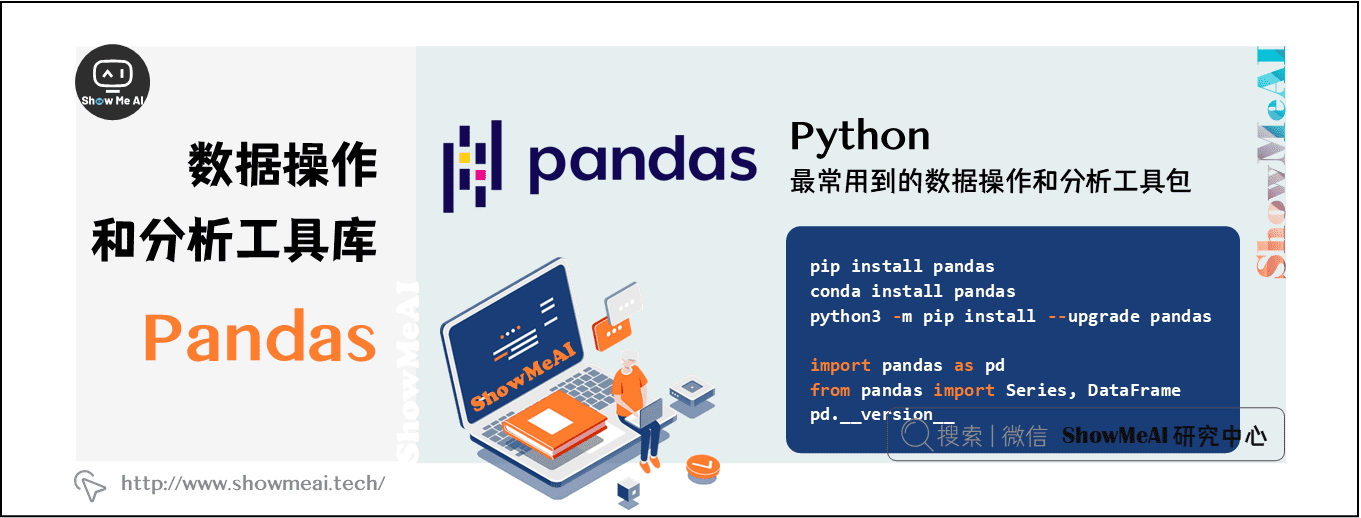

Python数据分析的核心:Pandas库详解与应用

# 1. Pandas库概述

## 1.1 为什么选择Pandas库

Pandas是一个功能强大的Python数据分析库,它提供了快速、灵活和表达式丰富的数据结构,旨在使“关系”或“标签”数据的操作变得简单。Pandas的名称来自于“panel data”(面板数据),这是多维结构化数据集在经济学中的术语。Pandas常用于金融数据分析,但其功能远远不止于此,它同样适用于各种行业领域中的数据科学任务。

## 1.2 Pandas的核心优势

Pandas的核心优势在于其提供的两个主要数据结构:Series和DataFrame。Series是类似一维数组的对象,可以存储各种数据类型。DataFrame是二维的、表格型的数据结构,具备行列标签,可以看作是一个Series对象的容器。正是这两个数据结构,让Pandas能够轻松地执行复杂的数据操作,包括索引、切片、筛选、聚合等。

## 1.3 Pandas与Python数据分析生态

Pandas是Python数据科学生态系统中不可或缺的一部分,它与NumPy、SciPy等数学计算库,以及Matplotlib、Seaborn等数据可视化工具紧密集成,为处理和分析数据提供了完整的工作流程。此外,Pandas的广泛使用和活跃的社区支持意味着你可以轻松地找到学习资源和解决在使用过程中遇到的问题。

以上内容为第一章的内容,为了遵循由浅入深的递进式阅读节奏,我们将Pandas库的概述作为起点,为读者揭示为什么选择Pandas,强调其核心优势,并将其置于更广泛的Python数据分析生态系统中。在下一章节,我们将深入探讨如何准备安装Pandas的环境以及具体安装步骤。

# 2. ```

# 第二章:Pandas安装前的准备工作

## 2.1 环境需求分析

### 2.1.1 确认Python版本

为了在系统上安装和使用Pandas库,您首先需要确保安装了正确版本的Python。Pandas的兼容性依赖于Python的版本,建议使用Python 3.6或更高版本,因为它提供了更好的性能和更现代的语言特性。

在终端或命令提示符中运行以下命令,以确认您的Python版本:

```bash

python --version

```

或者对于使用conda环境的用户,可以使用:

```bash

conda list python

```

若您的Python版本不符合要求,请访问Python官网下载并安装适合的版本。

### 2.1.2 检查系统兼容性

安装Pandas之前,您还需要检查您的操作系统是否与Pandas及其依赖库兼容。大多数现代操作系统,包括Linux、Windows和macOS都是兼容的。然而,在一些特定的环境中,比如使用Python的虚拟环境或conda环境,可能需要特别的步骤。

检查系统兼容性主要涉及以下几点:

- 确认您的系统满足Pandas依赖库的最低要求。

- 确保您的包管理器(pip或conda)是最新的,以便能够安装最新版本的Pandas。

- 对于Windows用户,确认安装了Visual C++构建工具,因为某些依赖库在编译时需要这些工具。

使用下面的命令更新pip或conda:

```bash

pip install --upgrade pip

```

或者对于conda用户:

```bash

conda update conda

```

## 2.2 Pandas安装步骤详解

### 2.2.1 使用pip安装Pandas

安装Pandas最直接的方式是使用Python的包管理工具pip。在您的终端或命令提示符中运行以下命令来安装Pandas:

```bash

pip install pandas

```

如果在安装过程中遇到权限问题,您可以使用以下命令:

```bash

pip install --user pandas

```

### 2.2.2 使用conda安装Pandas

如果您使用的是Anaconda或Miniconda环境,推荐使用conda来安装Pandas,因为它会自动管理所有的依赖关系。

在conda环境激活的状态下,输入:

```bash

conda install pandas

```

这将从conda的默认仓库中安装Pandas及其依赖。

### 2.2.3 安装过程中的常见问题及解决方案

安装Pandas时可能会遇到一些问题,比如版本冲突或依赖缺失。解决这些问题的策略包括:

- 清除缓存。有时候pip或conda的缓存可能导致安装失败。您可以运行以下命令清除缓存:

```bash

pip cache purge

```

或者清除conda缓存:

```bash

conda clean --all

```

- 使用虚拟环境。为了避免影响到系统中的其他Python项目,建议在独立的虚拟环境中安装Pandas。

```bash

# 使用pip创建虚拟环境

python -m venv myenv

source myenv/bin/activate

# 使用conda创建虚拟环境

conda create --name myenv python=3.8

conda activate myenv

```

- 使用特定版本。如果某个版本的Pandas或其依赖库与您的系统不兼容,可以安装一个特定的版本:

```bash

pip install pandas==1.2.0

```

或者使用conda指定版本:

```bash

conda install pandas=1.2.0

```

## 2.3 Pandas配置与优化

### 2.3.1 配置Pandas以优化性能

Pandas库提供了一些配置选项,通过设置这些选项可以优化库的性能和内存使用。比如,启用块算法可以加速某些操作:

```python

import pandas as pd

pd.set_option('compute.use_bottleneck', True)

```

另一个重要的配置选项是内存使用。您可以通过设置块大小来控制Pandas处理数据时的内存占用:

```python

pd.set_option('chunksize', 1000)

```

### 2.3.2 高级配置选项的介绍与应用

Pandas还提供了许多高级配置选项,通过合理设置,可以进一步提升性能和改善用户体验。例如,`display.max_rows` 选项可以控制DataFrame在打印时显示的最大行数:

```python

pd.set_option('display.max_rows', 50)

```

另一个常用选项是`display.max_columns`,它控制在打印DataFrame时显示的最大列数:

```python

pd.set_option('display.max_columns', 20)

```

这些设置尤其在处理大型数据集时非常有用,可以避免在控制台输出时过于拥挤,影响阅读体验。通过掌握这些配置选项,您可以根据具体需求调整Pandas的行为,以获得最佳的使用体验。

```mermaid

graph LR

A[开始安装Pandas]

A --> B[确认Python版本]

B --> C[检查系统兼容性]

C --> D[选择安装方法]

D --> E[使用pip安装]

D --> F[使用conda安装]

E --> G[安装过程中遇到问题?]

F --> G

G --> H[常见问题及解决方案]

H --> I[配置Pandas以优化性能]

I --> J[高级配置选项的介绍与应用]

J --> K[安装完成]

```

在上面的mermaid流程图中,展示了Pandas安装前的准备工作流程,从确认Python版本和系统兼容性开始,到安装方法的选择,再到安装过程中可能遇到的问题及其解决方案,最终完成Pandas库的配置与优化。

```python

import sys

# 确认Python版本

python_version = sys.version_info

if python_version.major < 3 or (python_version.major == 3 and python_version.minor < 6):

print("请更新Python至3.6或更高版本以安装Pandas。")

else:

print("Python版本符合要求,可以安装Pandas。")

# 检查系统兼容性

import platform

if platform.system() in ['Windows', 'Linux', 'Darwin']:

print("系统兼容,支持安装Pandas。")

else:

print("当前系统可能与Pandas不兼容,请咨询相关文档。")

# 配置Pandas以优化性能

pd.set_option('compute.use_bottleneck', True)

print("已启用Pandas的块算法。")

# 高级配置选项的介绍与应用

pd.set_option('display.max_rows', 50)

print("已设置DataFrame最大显示行数为50行。")

```

上面的代码块演示了如何在Python中确认Python版本和系统兼容性,以及如何配置Pandas以优化性能,并应用了高级配置选项来限制DataFrame的最大显示行数。每一步都有相应的输出信息,以指示操作是否成功或给出提示。

```

以上章节内容展示了如何在安装Pandas之前做好准备工作,涵盖了环境需求分析、安装步骤以及配置与优化等关键步骤。在本章节中,介绍了通过一系列检查和操作,如何确保安装过程顺利进行,并对Pandas进行优化配置以适应不同需求。通过这些步骤,可以有效避免安装过程中可能遇到的问题,并确保Pandas库在各种环境中均能高效运行。

# 3. Pandas基础功能的理论与实践

## 3.1 数据结构概览

### 3.1.1 Series对象的理解与操作

在Pandas中,`Series`是一个一维数组结构,能够存储任何数据类型(整数、字符串、浮点数、Python对象等)。`Series`对象是具有轴标签的数组,这使得它能够将数据与其实际意义相关联。轴标签统称为索引(index),可以是任何不可变的数据类型,例如字符串或数字。

一个`Series`对象可以被创建如下:

```python

import pandas as pd

data = [1, 2, 3, 4, 5]

index = ['a', 'b', 'c', 'd', 'e']

series = pd.Series(data=data, index=index)

print(series)

```

该代码块创建了一个简单的`Series`对象,其中包含5个元素和对应的索引标签。使用`Series`对象时,你可以通过索引访问和修改数据,如下所示:

```python

# 访问第二个元素

print(series['b'])

# 修改第三个元素

series['c'] = 33

```

还可以进行向量化操作,比如对`Series`中的所有数据进行数学运算,如下所示:

```python

# 将Series中的每个元素乘以2

modified_series = series * 2

print(modified_series)

```

### 3.1.2 DataFrame对象的理解与操作

`DataFrame`是Pandas中最常用的二维数据结构,用于存储表格型数据。它由行和列组成,每一列可以看作是一个`Series`对象。`DataFrame`支持不同数据类型的列,使它非常适合存储结构化数据。

以下是创建`DataFrame`对象的示例:

```python

import pandas as pd

data = {

'Name': ['Alice', 'Bob', 'Charlie'],

'Age': [24, 27, 22],

'City': ['New York', 'Los Angeles', 'Chicago']

}

df = pd.DataFrame(data)

print(df)

```

该代码块创建了一个包含人员姓名、年龄和所在城市的`DataFrame`对象。你可以访问、修改和增加列,如下所示:

```python

# 访问'Age'列

print(df['Age'])

# 修改'City'列中的'Bob'为'New York'

df.loc[df['Name'] == 'Bob', 'City'] = 'New York'

# 新增'Gender'列

df['Gender'] = ['Female', 'Male', 'Male']

```

`DataFrame`还支持条件筛选、分组、排序等多种操作,为数据操作提供了强大的灵活性。

## 3.2 数据导入与导出

### 3.2.1 从不同数据源导入数据

Pandas库提供了非常丰富的数据导入工具。它能够轻松地从多种源读取数据,包括CSV、Excel、JSON、HTML、SQL数据库等。

读取CSV文件是一个非常常见的操作,可以通过以下代码实现:

```python

import pandas as pd

# 从CSV文件读取数据

df = pd.read_csv('data.csv')

# 查看前5行数据

print(df.head())

```

对于Excel文件,可以使用`pd.read_excel`函数进行读取:

```python

# 从Excel文件读取数据

df = pd.read_excel('data.xlsx')

# 查看前5行数据

print(df.head())

```

此外,Pandas还可以直接从SQL数据库读取数据,通过指定数据库连接字符串,执行SQL查询后,将结果加载到`DataFrame`中。

### 3.2.2 将数据导出至多种格式

数据导出也是数据处理的重要一环。Pandas支持将`DataFrame`导出为CSV、Excel、HTML、JSON等多种格式。

举个例子,将`DataFrame`导出为CSV文件:

```python

# 导出DataFrame到CSV文件

df.to_csv('output.csv', index=False)

```

`index=False`参数表示在导出时不包含行索引。同样地,要导出到Excel,可以使用:

```python

# 导出DataFrame到Excel文件

df.to_excel('output.xlsx', index=False)

```

此外,还可以将数据导出为HTML格式,这对于将数据分析结果整合到网页中非常有用。

## 3.3 数据清洗与预处理

### 3.3.1 缺失数据的处理

数据清洗是数据分析前的重要步骤。在数据集中,经常会遇到缺失值问题。Pandas提供了许多函数来处理这些缺失值,例如`isnull()`, `notnull()`, `dropna()`, 和 `fillna()`。

识别并处理缺失值的示例如下:

```python

import pandas as pd

# 假设df是一个已经存在的DataFrame

df = pd.DataFrame({

'A': [1, 2, None, 4],

'B': [5, None, 7, 8],

})

# 检测缺失值

print(df.isnull())

# 删除包含缺失值的行

df_cleaned = df.dropna()

# 用特定值填充缺失值

df_filled = df.fillna(0)

```

### 3.3.2 数据类型转换与规整化

在进行数据分析之前,通常需要将数据转换成合适的数据类型,并进行规整化以确保数据一致性。Pandas提供了`astype()`函数来实现数据类型的转换。

数据类型转换的示例如下:

```python

# 将某一列的数据类型转换为浮点数

df['column'] = df['column'].astype(float)

# 将某列的数据转换为日期类型

df['date'] = pd.to_datetime(df['date'])

```

规整化数据的一个常见需求是统一字符串格式,可以使用`str`访问器来实现:

```python

# 去除字符串两端的空白字符

df['Name'] = df['Name'].str.strip()

# 将所有字符串转换为小写

df['Name'] = df['Name'].str.lower()

```

### 3.3.3 数据的分组、合并和重塑

数据分组是将数据集拆分成多个小部分,以便进行更详细的分析。Pandas中的`groupby`方法非常适用于此目的。

分组操作的一个例子:

```python

# 按'A'列的值分组,并计算'B'列的平均值

grouped = df.groupby('A').mean()

print(grouped)

```

数据合并通常指的是在多个数据源之间建立关系,这可以通过`merge()`函数来完成。

例如,合并两个`DataFrame`对象:

```python

# 基于'A'列合并两个DataFrame

merged_df = pd.merge(df1, df2, on='A')

```

数据重塑则是将数据从一种形式转换成另一种形式,通常使用`pivot_table()`方法或`melt()`函数。

以`pivot_table()`方法为例:

```python

# 创建一个透视表,将'A'列的值转换为列头,计算'B'列的平均值

pivot = df.pivot_table(values='B', index='C', columns='A', aggfunc='mean')

print(pivot)

```

通过上述步骤,可以实现对数据的基本清洗和预处理,为后续的分析工作打下坚实的基础。

# 4. Pandas进阶功能的理论与实践

## 4.1 高级索引与筛选技巧

### 4.1.1 多级索引的创建与使用

在Pandas中,多级索引(也称为分层索引)是创建具有多个(两个以上)索引级别的数据结构的过程。这在处理具有多个分类变量的数据时非常有用。创建多级索引可以使用`pd.MultiIndex`类或从简单的DataFrame构造。

```python

import pandas as pd

import numpy as np

# 创建一个简单的多级索引

index = pd.MultiIndex.from_tuples([('a', 'x'), ('a', 'y'), ('b', 'x'), ('b', 'y')],

names=['first', 'second'])

s = pd.Series(np.random.randn(4), index=index)

print(s)

```

这段代码创建了一个`Series`对象`s`,其中包含了一个多级索引。第一个级别标记为'first',第二个级别标记为'second'。索引的名称和层级结构在许多Pandas操作中都非常重要,它们可以提高数据操作的效率。

在多级索引中进行数据筛选时,可以使用`.loc[]`方法,该方法允许基于索引标签的高级选择:

```python

# 使用.loc[]根据多级索引选择数据

filtered_data = s.loc[('a', 'y')]

print(filtered_data)

```

### 4.1.2 数据的条件筛选与布尔索引

Pandas中的条件筛选通常使用布尔索引实现。布尔索引涉及使用布尔值数组(True或False)来选择数据。这种技术非常强大,因为它允许根据复杂的标准来过滤数据。

```python

# 创建一个DataFrame用于条件筛选

df = pd.DataFrame({'A': [1, 2, 3, 4],

'B': [True, False, True, False]},

index=['a', 'b', 'c', 'd'])

# 根据列B的布尔值进行筛选

filtered_df = df[df.B]

print(filtered_df)

```

在这段代码中,`df.B`创建了一个布尔序列,该序列被用作`.loc[]`方法的条件来过滤DataFrame。结果是只包含列B值为True的行。

布尔索引和条件筛选不仅可以单独使用,还可以组合使用,以执行更复杂的查询和数据处理。

## 4.2 数据合并与转换

### 4.2.1 数据的合并与连接

数据合并是指将两个或多个数据源组合在一起,Pandas提供了多种方法来合并数据,包括`merge()`、`join()`和`concat()`。其中,`merge()`函数是最灵活的,可以指定按哪个列或索引来合并,类似于SQL中的JOIN操作。

```python

# 创建两个简单的DataFrame进行合并

df1 = pd.DataFrame({'key': ['b', 'b', 'a', 'c', 'a', 'a', 'b'],

'data1': range(7)})

df2 = pd.DataFrame({'key': ['a', 'b', 'd'],

'data2': range(3)})

# 使用merge()函数根据'key'列合并两个DataFrame

merged_df = pd.merge(df1, df2, on='key', how='inner')

print(merged_df)

```

这段代码演示了内连接(inner join)操作,`merge()`函数根据'key'列将两个DataFrame合并在一起。在合并过程中,`on`参数指定了用于连接的列名,而`how`参数指定了连接的类型。

### 4.2.2 数据透视表与交叉表

数据透视表(pivot table)是数据分析中的一项强大工具,它可以将行转换为列,并进行聚合计算。它通常用于对数据进行汇总和交叉分析。Pandas通过`pivot_table()`函数提供了这一功能。

```python

# 使用pivot_table()创建数据透视表

pivot_df = pd.pivot_table(df, index='key', columns='B', values='A', aggfunc=np.sum)

print(pivot_df)

```

在这个例子中,我们使用`pivot_table()`函数创建了一个数据透视表,它以'key'为索引,'B'列为列头,'A'列的值按'SUM'聚合。

交叉表(cross-tabulation)是另一种形式的数据汇总,它可以快速得到分类数据的频数统计。Pandas的`crosstab()`函数用于创建交叉表。

```python

# 使用crosstab()创建交叉表

cross_tab = pd.crosstab(df.A, df.B)

print(cross_tab)

```

交叉表`cross_tab`显示了列'A'和列'B'不同组合的频数统计。

## 4.3 统计分析与计算

### 4.3.1 常用统计函数与方法

Pandas提供了丰富的统计函数和方法,可以轻松进行数据摘要、描述性统计分析等。例如,`mean()`, `median()`, `sum()`, `min()`, `max()`等。

```python

# 计算DataFrame的统计摘要

summary_stats = df.describe()

print(summary_stats)

```

通过`describe()`方法,可以快速获取DataFrame中的数值列的统计摘要,包括计数、均值、标准差、最小值、四分位数和最大值。

### 4.3.2 时间序列数据的处理

时间序列分析是Pandas中一个非常重要的部分。Pandas的时间序列功能包括时间戳、时间增量、时间范围和日期范围等。

```python

# 创建一个时间序列的DataFrame

dates = pd.date_range('20210101', periods=6)

ts_df = pd.DataFrame(np.random.randn(6, 4), index=dates, columns=list('ABCD'))

print(ts_df)

```

在这个例子中,`date_range()`函数用于生成一个连续的日期范围,然后这些日期被用作DataFrame的索引,形成一个时间序列。

对于时间序列数据的处理,Pandas还提供了诸如`resample()`, `shift()`, `rolling()`等高级方法,这些方法对于进行时间序列分析和处理非常有用。

```python

# 以月为单位重采样并计算月平均值

monthly_avg = ts_df.resample('M').mean()

print(monthly_avg)

```

`resample()`方法允许用户按照不同的时间频率重新采样时间序列数据,这里是按照月度('M')进行重采样。这是时间序列分析中的一个常见操作,用于进行周期性分析或季节性调整。

以上是对Pandas进阶功能的理论与实践的一些介绍,下一章节将继续探索Pandas在实际项目中的应用案例。

# 5. Pandas在实际项目中的应用案例

## 5.1 数据分析项目规划

### 5.1.1 理解项目需求

在开始任何数据分析项目之前,首要任务是彻底理解项目需求。这包括与项目相关的关键业务问题、数据集的预期规模、项目目标以及交付成果的格式。为了深入理解项目需求,需要与项目发起者和相关利益相关者密切沟通,确保数据分析师对所面临的挑战有清晰的认识。

具体步骤可能包括但不限于:

- **需求调研**:收集和分析业务需求,可能需要进行问卷调查、访谈或研讨会。

- **需求文档**:将理解的需求整理成文档,并让所有利益相关者确认。

- **目标设定**:根据需求文档,制定可衡量的数据分析目标。

- **时间规划**:制定时间表,明确各个阶段的开始和结束时间。

### 5.1.2 设计数据分析流程

一旦项目需求明确,下一步是设计数据分析流程。这涉及到规划如何从原始数据到最终的分析结果的过程。设计流程时,要考虑数据收集、清洗、整合、分析和报告等步骤。

流程设计的步骤可能包括:

- **数据收集**:确定数据来源,包括数据库、API、文件系统等。

- **数据处理**:制定数据预处理策略,如数据清洗、缺失值处理等。

- **探索性数据分析(EDA)**:初步分析数据,了解数据分布、发现异常值、建立假设等。

- **分析模型选择**:根据项目目标选择合适的统计模型和算法。

- **结果展示**:确定如何展示分析结果,选择图表、表格或报告形式。

## 5.2 Pandas在数据分析中的关键角色

### 5.2.1 数据探索与可视化

在数据分析的早期阶段,Pandas能够快速加载数据并提供初步的数据探索功能。Pandas提供的数据筛选、统计摘要和分组聚合等功能,都是数据探索的重要组成部分。

使用Pandas进行数据探索时,常用的方法包括:

- **描述性统计**:使用`describe()`方法获取数据集的快速概述。

- **数据排序**:使用`sort_values()`方法对数据进行排序。

- **条件筛选**:使用布尔索引过滤数据。

```python

# 示例代码:使用Pandas进行数据探索

import pandas as pd

# 加载数据集

df = pd.read_csv('data.csv')

# 描述性统计

print(df.describe())

# 数据排序

sorted_df = df.sort_values(by='Revenue', ascending=False)

# 条件筛选

filtered_df = df[df['Revenue'] > 10000]

```

### 5.2.2 结果解释与报告编写

数据分析的结果需要被转化成可理解的报告。使用Pandas,数据分析师可以对数据进行摘要并提取出关键信息,然后利用可视化工具,比如Matplotlib或Seaborn,进一步将结果可视化。

编写报告的步骤可能包括:

- **数据摘要**:从Pandas得到的统计结果中提取关键数据。

- **可视化展示**:用图表展示数据趋势和模式。

- **报告撰写**:撰写数据分析报告,并根据需要提出建议和结论。

## 5.3 案例研究:Pandas在行业分析中的应用

### 5.3.1 案例背景与数据集介绍

为了演示Pandas在实际项目中的应用,我们将通过一个行业分析案例进行说明。例如,我们可能需要分析零售行业中的销售数据,来优化库存管理和增加销售额。数据集可能包含产品的ID、名称、销售量、价格、时间和地区等信息。

```python

# 示例代码:加载案例数据集

df = pd.read_csv('retail_sales_data.csv')

print(df.head())

```

### 5.3.2 数据分析演示与关键代码解析

通过Pandas,我们可以执行数据清洗和预处理操作,例如处理缺失值、转换数据类型、创建新的数据列等。然后,可以进行探索性数据分析,比如计算销售总额、分析销售趋势、识别不同地区销售业绩的差异等。

```python

# 示例代码:数据预处理与分析

# 处理缺失值

df['Sales'] = df['Sales'].fillna(0)

# 数据类型转换

df['Date'] = pd.to_datetime(df['Date'])

# 计算总销售额

total_sales = df['Sales'].sum()

# 识别销售趋势

sales_trend = df.groupby('Date')['Sales'].sum()

# 分析不同地区的销售业绩

sales_by_region = df.groupby('Region')['Sales'].sum()

```

通过上述步骤,Pandas帮助我们完成了复杂的数据分析任务,使得从原始数据到洞察的过程既高效又准确。在接下来的章节中,我们将深入探讨Pandas在代码编写、性能优化以及问题调试方面的最佳实践。

# 6. Pandas最佳实践与性能优化

## 6.1 Pandas代码的最佳编写方式

在使用Pandas进行数据处理时,代码的最佳编写方式对于保持代码的可读性、可维护性以及执行效率至关重要。以下是几个关键的最佳编写实践:

### 6.1.1 代码风格与规范

确保你的代码风格一致,使用一致的命名约定和代码格式。这包括变量命名、缩进、注释等。遵循PEP 8,这是Python官方的代码风格指南,有助于提高代码的清晰度。

```python

# 使用有意义的变量名

# 使用4个空格缩进

# 在适当的地方添加注释来解释代码的目的

# 示例代码片段

def filter_data(data_frame, column_name, value):

"""根据列值筛选DataFrame"""

return data_frame[data_frame[column_name] == value]

```

### 6.1.2 代码优化技巧

- 避免在循环中使用Pandas操作,尽可能使用向量化操作以减少运行时间。

- 当处理大型数据集时,考虑使用`chunksize`参数将数据分块读取,以避免内存溢出。

- 使用`df.loc`代替`df[df.column == value]`进行条件筛选,以提高效率。

- 减少不必要的数据类型转换,这会降低性能并增加内存占用。

```python

# 使用loc进行高效筛选

filtered_data = df.loc[df['column_name'] == value]

```

## 6.2 性能优化策略

为了确保Pandas应用保持最佳性能,有必要深入分析并解决性能瓶颈问题。

### 6.2.1 分析性能瓶颈

分析性能瓶颈的一种方法是使用`%timeit`魔法命令在IPython环境中测量代码块的执行时间。

```python

# 使用%timeit测量性能

%timeit df['new_column'] = df['existing_column'].apply(complex_function)

```

### 6.2.2 优化Pandas操作的实用技巧

- 使用`.apply()`时,考虑是否可以使用向量化函数来替代,比如`numpy`函数。

- 在涉及字符串处理时,尽可能使用向量化的字符串方法,而不是Python内建的字符串方法。

- 使用`category`数据类型来优化内存使用和提升某些操作的速度,特别是当面对有限且固定的字符串集合时。

```python

# 使用category数据类型优化

df['column'] = df['column'].astype('category')

```

## 6.3 遇到问题时的调试与解决

在使用Pandas进行数据分析时,难免会遇到问题。正确地调试和解决问题是提高效率的关键。

### 6.3.1 常见错误的识别与处理

- 当遇到错误时,首先查看错误消息,它通常会告诉你问题出在哪里。

- 使用`try-except`块来捕获可能的异常,并提供有用的调试信息。

```python

try:

# 尝试执行可能会失败的代码

except Exception as e:

# 打印错误信息

print(f"An error occurred: {e}")

```

### 6.3.2 调试Pandas代码的高级方法

- 使用`df.head()`和`df.tail()`来检查数据的前几行和后几行,以确认数据的形状和内容。

- 使用`df.describe()`和`df.info()`来获取数据的统计摘要和内存使用信息。

- 使用`pd.set_option('max.rows', None)`来查看整个DataFrame的内容。

```python

# 检查DataFrame的统计信息

df.describe()

```

以上步骤能帮助你构建高效、可读性强且易于维护的Pandas代码,确保在数据分析项目中取得最佳性能。

0

0