LDA主题建模与自然语言处理:文本分析新利器,赋能NLP应用

发布时间: 2024-08-20 14:28:17 阅读量: 38 订阅数: 40

# 1. LDA主题建模概述**

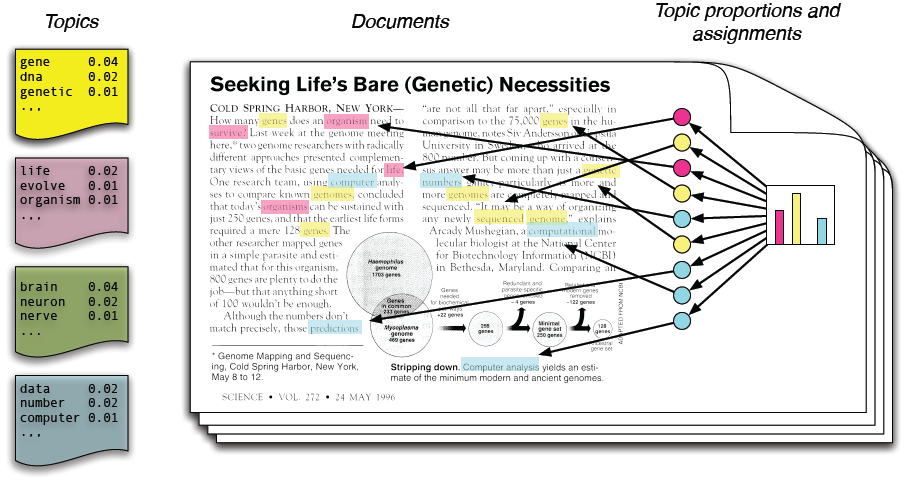

主题建模是一种无监督机器学习技术,用于从文本数据中发现潜在的主题或模式。LDA(潜在狄利克雷分配)是主题建模中最流行的算法之一,它将文档视为由一系列主题概率分布生成的单词集合。

LDA模型假设每个文档都由一组主题组成,每个主题由一组单词概率分布表示。通过迭代采样算法,LDA可以估计文档中每个单词属于每个主题的概率。这些概率可以用来识别文档中的主要主题,并对文档进行分类或聚类。

# 2. LDA主题建模理论基础

### 2.1 概率生成模型

LDA模型是一种概率生成模型,它假设文本是由一系列潜在主题组成的。这些主题是隐藏的变量,无法直接观测到。文本中的每个单词都是由一个主题生成,并且每个单词都有一个概率分布在不同的主题上。

### 2.2 LDA模型的数学原理

#### 2.2.1 狄利克雷分布

狄利克雷分布是一种多变量概率分布,它用于描述多项式分布的超参数。在LDA模型中,狄利克雷分布用于描述主题的分布。

```

P(θ) = Dir(α) = \frac{1}{B(α)} \prod_{k=1}^K θ_k^{\alpha_k - 1}

```

其中:

* θ是主题分布参数

* α是狄利克雷分布的超参数

* B(α)是狄利克雷分布的归一化常数

#### 2.2.2 多项式分布

多项式分布是一种离散概率分布,它用于描述从有限个类别中选择一个类别的概率。在LDA模型中,多项式分布用于描述单词在不同主题上的分布。

```

P(w_i | z_i) = Mult(β) = \frac{1}{B(β)} \prod_{k=1}^K (β_k)^{w_{ik}}

```

其中:

* w_i是第i个单词

* z_i是第i个单词的主题

* β是多项式分布的参数

* B(β)是多项式分布的归一化常数

### 2.3 模型参数估计

LDA模型的参数可以通过吉布斯采样算法或变分推断算法进行估计。

#### 2.3.1 吉布斯采样算法

吉布斯采样算法是一种马尔可夫链蒙特卡罗(MCMC)算法,它通过迭代采样来估计模型参数。在LDA模型中,吉布斯采样算法通过以下步骤进行:

1. 对于每个单词w_i:

* 从主题分布P(z_i | z_{-i}, w_i, α)中采样一个主题z_i

2. 对于每个主题k:

* 从多项式分布P(w_i | z_i, β)中采样一个单词w_i

#### 2.3.2 变分推断算法

变分推断算法是一种近似推理算法,它通过优化一个变分下界来估计模型参数。在LDA模型中,变分推断算法通过以下步骤进行:

1. 初始化变分分布Q(z, θ, β)

2. 迭代优化变分下界:

```

L(Q) = E_Q[log P(w, z, θ, β)] - E_Q[log Q(z, θ, β)]

```

3. 更新变分分布Q(z, θ, β)

# 3. LDA主题建模实践

### 3.1 模型训练与参数设置

**模型训练**

LDA模型的训练通常采用吉布斯采样算法或变分推断算法。其中,吉布斯采样算法是一种基于马尔可夫链蒙特卡罗(MCMC)的采样方法,通过迭代地更新模型参数来估计模型的联合概率分布。

**参数设置**

LDA模型训练需要设置以下参数:

- **主题数(K):**指定模型中主题的数量。

- **迭代次数(n_i

0

0