揭秘LDA主题建模:理论基础与实战应用,助你快速掌握文本分析利器

发布时间: 2024-08-20 14:11:38 阅读量: 41 订阅数: 40

# 1. LDA主题建模概述

**1.1 LDA主题建模简介**

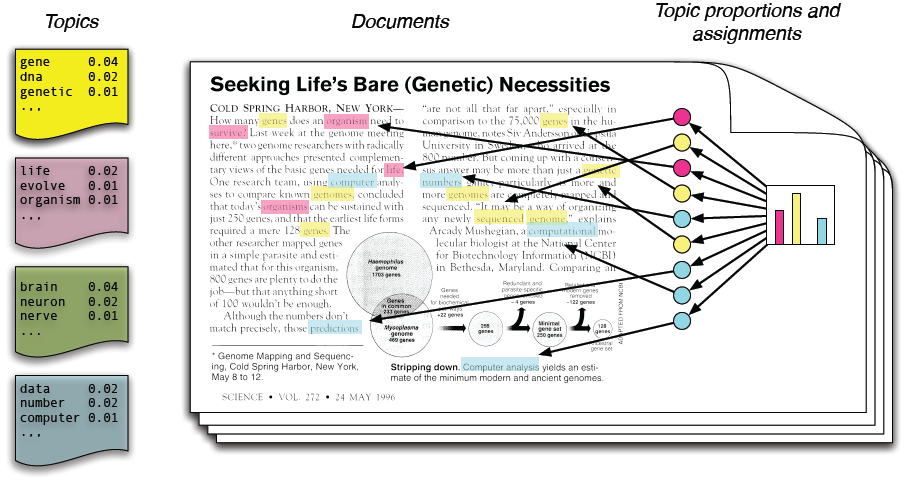

LDA(潜在狄利克雷分配)主题建模是一种无监督机器学习技术,用于从文本数据中发现潜在主题。它将文本文档表示为主题的概率分布,每个主题由一组相关的单词组成。

**1.2 LDA主题建模的应用**

LDA主题建模广泛应用于文本挖掘和自然语言处理领域,包括:

- 文本分类和聚类

- 情感分析和舆情监测

- 文本摘要和生成

- 推荐系统和个性化搜索

# 2. LDA主题建模理论基础

### 2.1 概率生成模型

**2.1.1 贝叶斯定理**

贝叶斯定理是概率论中一个重要的定理,它描述了在已知条件下事件发生的概率。在主题建模中,贝叶斯定理用于推断文档中单词出现的概率。

**2.1.2 隐含狄利克雷分配(LDA)**

LDA是一种概率生成模型,它假设文档中的单词是由一组潜在主题生成的。每个主题由一组单词组成,每个单词在主题中出现的概率由狄利克雷分布控制。

### 2.2 主题模型的数学推导

**2.2.1 吉布斯采样**

吉布斯采样是一种马尔可夫链蒙特卡罗(MCMC)算法,用于从LDA模型中采样主题分配。它通过迭代地为每个单词重新分配主题,逐步逼近主题分配的真实分布。

**代码块:**

```python

def gibbs_sampling(corpus, num_topics, num_iterations):

# 初始化主题分配

topic_assignments = np.random.randint(num_topics, size=len(corpus))

# 迭代采样

for iteration in range(num_iterations):

for doc_index, doc in enumerate(corpus):

for word_index, word in enumerate(doc):

# 计算每个主题下单词出现的概率

word_probs = np.zeros(num_topics)

for topic in range(num_topics):

word_probs[topic] = (

(corpus.count(word, topic) + alpha)

/ (corpus.count(topic) + num_words * alpha)

* (topic_assignments[doc_index].count(topic) + beta)

/ (len(corpus[doc_index]) + num_topics * beta)

)

# 根据概率重新分配主题

topic_assignments[doc_index][word_index] = np.random.choice(num_topics, p=word_probs)

return topic_assignments

```

**逻辑分析:**

该代码块实现了吉布斯采样算法。它首先初始化主题分配,然后迭代地为每个单词重新分配主题。在每次迭代中,它计算每个主题下单词出现的概率,并根据概率重新分配主题。

**参数说明:**

* `corpus`:文档集合,每个文档是一个单词列表。

* `num_topics`:主题数量。

* `num_iterations`:迭代次数。

* `alpha`:狄利克雷先验参数,控制主题分布。

* `beta`:狄利克雷先验参数,控制单词在主题中出现的分布。

**2.2.2 变分推断**

变分推断是一种近似推理算法,用于从LDA模型中推断主题分配。它通过优化一个变分下界来逼近主题分配的真实分布。

**代码块:**

```python

def variational_inference(corpus, num_topics, max_iterations):

# 初始化主题分布和单词在主题中出现的分布

phi = np.random.dirichlet(np.ones(num_topics), num_topics)

theta = np.random.dirichlet(np.ones(num_topics), len(corpus))

# 迭代优化

for iteration in range(max_iterations):

# 更新主题分布

for topic in range(num_topics):

phi[topic] = np.sum(theta * corpus.count(topic), axis=0) / np.sum(theta)

# 更新单词在主题中出现的分布

for doc_index, doc in enumerate(corpus):

for word_index, word in enumerate(doc):

theta[doc_index][topic] = (

(corpus.count(word, topic) + alpha)

/ (corpus.count(topic) + num_words * alpha)

* (phi[topic] + beta)

/ (np.sum(phi) + num_topics * beta)

)

return phi, theta

```

**逻辑分析:**

该代码块实现了变分推断算法。它首先初始化主题分布和单词在主题中出现的分布,然后迭代地优化这两个分布。在每次迭代中,它更新主题分布和单词在主题中出现的分布,直到收敛。

**参数说明:**

* `corpus`:文档集合,每个文档是一个单词列表。

* `num_topics`:主题数量。

* `max_iterations`:最大迭代次数。

* `alpha`:狄利克雷先验参数,控制主题分布。

* `beta`:狄利克雷先验参数,控制单词在主题中出现的分布。

# 3. LDA主题建模实践应用

### 3.1 文本预处理

文本预处理是LDA主题建模的重要步骤,旨在将文本数据转换为模型可接受的格式,以提高建模效率和准确性。

#### 3.1.1 分词和词性标注

分词是将文本中的句子拆分为单词或词组的过程。词性标注是为每个单词或词组分配词性标签,例如名词、动词、形容词等。分词和词性标注有助于模型识别文本中的重要特征,并减少噪声和冗余。

#### 3.1.2 去停用词和归一化

停用词是常见且无意义的单词,例如“the”、“of”、“and”等。去停用词可以去除这些单词,减少模型的维度和计算量。归一化是将单词转换为小写并去除标点符号和特殊字符的过程,以消除拼写差异对建模的影响。

### 3.2 LDA模型构建

#### 3.2.1 参数设置和模型训练

LDA模型的参数包括主题数量(K)、文档-主题分布的先验参数(α)和主题-单词分布的先验参数(β)。这些参数需要根据具体任务和数据特点进行设置。模型训练是指根据给定的参数,使用吉布斯采样或变分推断等算法估计模型参数的过程。

#### 3.2.2 模型评估和优化

模型评估是判断LDA模型性能的重要步骤。常用的评估指标包括困惑度、主题连贯性和主题多样性。困惑度衡量模型对新数据的预测能力。主题连贯性衡量主题中单词的语义相关性。主题多样性衡量主题之间的差异程度。根据评估结果,可以调整模型参数或优化预处理过程,以提高模型性能。

**代码块:LDA模型训练和评估**

```python

import gensim

from gensim.corpora import Dictionary

from gensim.models import LdaModel

# 加载预处理后的文本数据

corpus = gensim.corpora.MmCorpus('corpus.mm')

# 创建LDA模型

lda = LdaModel(corpus, num_topics=10, id2word=dictionary, alpha='auto', eta='auto')

# 评估模型

coherence_model = gensim.models.CoherenceModel(model=lda, texts=texts, dictionary=dictionary, coherence='c_v')

coherence = coherence_model.get_coherence()

```

**代码逻辑解读:**

* `gensim.corpora.MmCorpus('corpus.mm')`:加载预处理后的语料库。

* `LdaModel(corpus, num_topics=10, id2word=dictionary, alpha='auto', eta='auto')`:创建LDA模型,设置主题数量为10,使用自动推断的先验参数。

* `coherence_model = gensim.models.CoherenceModel(model=lda, texts=texts, dictionary=dictionary, coherence='c_v')`:创建主题连贯性模型。

* `coherence = coherence_model.get_coherence()`:计算主题连贯性。

**参数说明:**

* `num_topics`:主题数量。

* `id2word`:单词到整数的映射。

* `alpha`:文档-主题分布的先验参数。

* `eta`:主题-单词分布的先验参数。

* `texts`:原始文本数据。

* `coherence`:主题连贯性指标。

# 4. LDA主题建模进阶应用

### 4.1 主题分析和可视化

#### 4.1.1 主题词云和主题树

主题词云是一种可视化主题分布的方法,它根据每个主题中单词的频率和重要性生成一个词云。单词的大小和颜色反映了它们在主题中的重要性。主题树是一种分层可视化,它展示了主题之间的关系。它可以帮助用户理解主题的层次结构和它们如何相互关联。

```python

# 导入必要的库

import gensim

import pyLDAvis

import pyLDAvis.sklearn

# 加载 LDA 模型

lda_model = gensim.models.LdaModel.load('lda_model.gensim')

# 创建主题词云

pyLDAvis.enable_notebook()

vis = pyLDAvis.gensim_models.prepare(lda_model, corpus, dictionary)

pyLDAvis.show(vis)

# 创建主题树

pyLDAvis.sklearn.prepare(lda_model, corpus, dictionary)

pyLDAvis.show(vis)

```

#### 4.1.2 文档-主题矩阵和主题-主题相似度

文档-主题矩阵是一个二维矩阵,其中行表示文档,列表示主题。矩阵中的每个元素表示该文档与该主题的相关性。主题-主题相似度矩阵是一个对称矩阵,其中每个元素表示两个主题之间的相似度。

```python

# 获取文档-主题矩阵

doc_topic_matrix = lda_model.get_document_topics(corpus)

# 获取主题-主题相似度矩阵

topic_similarity_matrix = lda_model.get_topic_coherence()

# 打印文档-主题矩阵

print(doc_topic_matrix)

# 打印主题-主题相似度矩阵

print(topic_similarity_matrix)

```

### 4.2 主题建模在文本挖掘中的应用

#### 4.2.1 文本分类和聚类

LDA主题建模可以用于文本分类和聚类任务。通过将文本表示为主题分布,我们可以使用分类算法(如支持向量机或逻辑回归)或聚类算法(如k均值或层次聚类)对文本进行分类或聚类。

```python

# 导入必要的库

from sklearn.svm import SVC

from sklearn.cluster import KMeans

# 构建分类器

classifier = SVC()

# 训练分类器

classifier.fit(doc_topic_matrix, labels)

# 预测文本类别

predictions = classifier.predict(doc_topic_matrix)

# 构建聚类器

clusterer = KMeans(n_clusters=5)

# 训练聚类器

clusterer.fit(doc_topic_matrix)

# 预测文本聚类

clusters = clusterer.predict(doc_topic_matrix)

```

#### 4.2.2 情感分析和舆情监测

LDA主题建模可以用于情感分析和舆情监测任务。通过分析主题分布,我们可以识别文本中的情感倾向或舆论趋势。

```python

# 导入必要的库

from sklearn.linear_model import LogisticRegression

# 构建情感分析模型

sentiment_model = LogisticRegression()

# 训练情感分析模型

sentiment_model.fit(doc_topic_matrix, sentiments)

# 预测文本情感

sentiments_predictions = sentiment_model.predict(doc_topic_matrix)

# 构建舆情监测模型

opinion_model = LogisticRegression()

# 训练舆情监测模型

opinion_model.fit(doc_topic_matrix, opinions)

# 预测文本舆论

opinions_predictions = opinion_model.predict(doc_topic_matrix)

```

# 5. LDA主题建模案例实战

### 5.1 新闻文本主题建模

#### 5.1.1 数据获取和预处理

1. **数据获取:**从新闻网站或新闻聚合平台收集新闻文本数据,确保数据来源可靠且具有代表性。

2. **文本预处理:**对收集到的文本数据进行预处理,包括:

- 分词和词性标注:使用自然语言处理工具对文本进行分词,并标注词性。

- 去停用词和归一化:去除常见的停用词,如“的”、“了”、“是”等,并对文本进行归一化,如小写化、去除标点符号等。

#### 5.1.2 模型构建和主题分析

1. **模型构建:**使用LDA模型对预处理后的文本数据进行建模。设置模型参数,如主题数量、迭代次数等。

2. **模型训练:**使用吉布斯采样或变分推断算法对模型进行训练,直到模型收敛。

3. **主题分析:**分析训练好的LDA模型,提取主题词和主题分布。

- 主题词:每个主题提取出具有代表性的词语,形成主题词云或主题树。

- 主题分布:计算每篇新闻文本中各主题的分布,形成文档-主题矩阵。

```python

# 导入必要的库

import gensim

from gensim import corpora

# 加载预处理后的新闻文本数据

texts = gensim.corpora.TextCorpus('preprocessed_news.txt')

# 创建LDA模型

lda_model = gensim.models.ldamodel.LdaModel(texts, num_topics=10, id2word=dictionary, passes=10)

# 打印主题词

for topic in lda_model.print_topics():

print(topic)

```

0

0