声纹识别技术:深度学习在语音识别中的应用

发布时间: 2024-09-03 23:17:16 阅读量: 184 订阅数: 48

# 1. 声纹识别技术概述

声纹识别作为生物特征识别的一种,正日益受到广泛关注。该技术的核心是通过声音来识别个人身份,它依托于个体独特的语音特征,比如音调、音色、发音习惯等。与传统的密码或生物识别技术(如指纹、虹膜识别)相比,声纹识别具有非接触性、方便、成本低等优势,同时,在信息安全方面还存在潜在的挑战。随着人工智能和机器学习技术的进步,特别是深度学习的应用,声纹识别技术的准确度和可靠性正在不断提高,从而推动了它在金融服务、智能安防、个性化服务等领域的广泛应用。本章将详细介绍声纹识别技术的基础概念、发展历程以及在实际应用中面临的挑战和机遇。

# 2. 深度学习基础

深度学习是声纹识别技术发展和应用的基石之一,它让机器能够像人类一样从数据中学习。通过神经网络的多层次抽象,深度学习模型可以从原始数据中提取复杂的特征,从而提高声纹识别的准确性和可靠性。

## 2.1 深度学习的概念与发展

### 2.1.1 神经网络简介

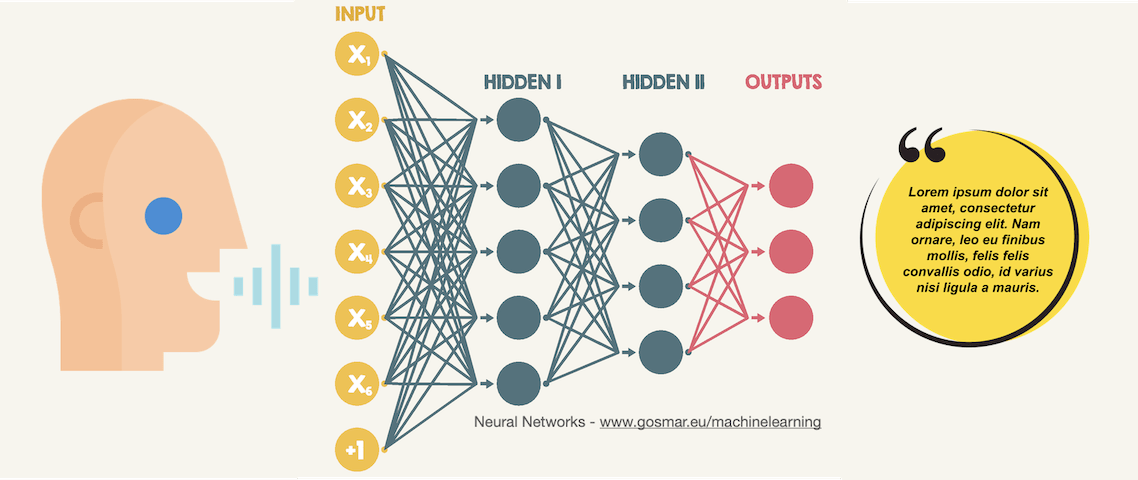

神经网络是一种模拟人脑神经元工作方式的计算模型,它由大量简单的、相互连接的处理单元(神经元)组成。这些单元通过连接传递信息,并通过调整连接权重实现学习和适应。神经网络的基本构成包括输入层、隐藏层和输出层。每一层都包含多个神经元,它们之间存在权重和偏置,这些参数在训练过程中不断被调整,以最小化误差。

### 2.1.2 深度学习的历史和进展

深度学习的起源可以追溯到1940年代的人工神经网络研究,但其真正的发展是在21世纪初,随着计算能力的提升和大数据的出现。2012年,AlexNet在ImageNet图像识别挑战赛中大放异彩,标志着深度学习时代的到来。此后,深度学习技术迅速发展,并在语音识别、自然语言处理、计算机视觉等领域取得了突破性的成果。

## 2.2 深度学习的关键技术和算法

### 2.2.1 卷积神经网络(CNN)

卷积神经网络是一种特殊的神经网络,它使用卷积层来提取输入数据的空间特征。CNN在图像和视频分析中表现出色,同样也可以应用于声纹识别。通过局部感受野和权值共享,CNN能够提取到与位置相关的特征,这对于声音信号的处理尤为重要。

### 2.2.2 循环神经网络(RNN)

循环神经网络专为处理序列数据而设计,它能够利用内部状态来处理不同长度的序列。在声纹识别中,声音信号可以被视为一个时间序列,RNN能够捕捉到声音随时间变化的动态特征。LSTM(长短期记忆网络)作为RNN的一种,通过引入门控机制解决了传统RNN训练过程中的梯度消失问题。

### 2.2.3 生成对抗网络(GAN)

生成对抗网络由生成器和判别器组成,它们互相竞争:生成器产生尽可能真实的样本,而判别器则试图区分真实和生成的样本。在声纹识别中,GAN可用于生成增强的训练样本,提高模型的泛化能力。

## 2.3 深度学习在声纹识别中的作用

### 2.3.1 特征提取与表示学习

深度学习在声纹识别中的主要作用之一是特征提取。通过深度神经网络,可以自动学习到能够代表声音特征的高级表示。与传统手工设计的特征不同,深度学习模型能够从原始声音信号中提取更加丰富和抽象的特征,这些特征对于区分不同的声纹至关重要。

### 2.3.2 模型训练与优化策略

训练深度学习模型是一个复杂的过程,需要精心设计和调整多个超参数,如学习率、批大小、优化器类型等。在声纹识别中,通常采用交叉验证来评估模型性能,并使用正则化技术(如dropout)来防止过拟合。此外,迁移学习也是一种常见的优化策略,通过在大型数据集上预训练模型,然后在特定的声纹识别任务上进行微调。

以下是使用Keras框架构建CNN模型的示例代码,用于声纹特征提取:

```python

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential()

model.add(Conv2D(filters=32, kernel_size=(3, 3), activation='relu', input_shape=(64, 64, 1)))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Flatten())

model.add(Dense(128, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

***pile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

```

在上述代码块中,构建了一个简单的CNN模型。模型首先通过一个带有ReLU激活函数的卷积层提取特征,随后进行最大池化操作以减少特征维度。接着,将特征展平并通过两个全连接层进行进一步学习。这样的结构有助于从声纹信号中提取出有效的特征表示。在实际应用中,需要根据声纹数据集的特性对模型结构进行调整和优化,以达到最佳的识别效果。

模型训练和优化是一个迭代的过程,需要不断评估和调整模型参数,以找到最优的模型结构和超参数设置。这一过程对于提升声纹识别系统的整体性能至关重要。

在深度学习的实践应用中,神经网络模型通常需要大量的数据进行训练。但是,真实世界的声纹数据往往存在多样性,这使得模型在不同的声音样本上表现不一致。针对这一问题,数据增强技术可以被用来生成额外的训练样本,增加数据的多样性,从而提高模型的泛化能力。而迁移学习则允许我们将预训练模型的权重作为起点,对这些权重进行微调,以适应特定的声纹识别任务,这样做可以在有限的声纹数据上取得更好的效果。

# 3. 声纹识别技术实践

## 3.1 声纹数据的预处理与特征工程

声纹识别系统的第一步就是对声音信号进行预处理,包括数据清洗与增强,以及特征提取。这一过程至关重要,因为其决定了后续识别模型的准确性和鲁棒性。

### 3.1.1 数据清洗与增强

数据清洗的目的是排除或纠正数据集中存在的噪声和不一致性问题,为后续的数据处理打下良好的基础。数据增强则是一个创建额外训练样本的过程,这些样本通过模拟各种现实世界的变化来提高模型的泛化能力。

在实际操作中,数据清洗可以包括去除无声音区域、消除背景噪声、标准化音量等步骤。例如,使用Python的`librosa`库,可以轻松地加载音频文件,并进行上述预处理:

```python

import librosa

# 加载音频文件

y, sr = librosa.load('audio.wav', sr=None) # 参数sr=None表示不改变原始采样率

# 去除静音

y_silence_reduced, index = librosa.effects.trim(y)

# 标准化音量

y_normalized = librosa.util.normalize(y_silence_reduced)

```

数据增强可以通过调整音高、添加不同的噪声类型、改变播放速度等方式来实现。`noisereduce`包可以用来降低背景噪声:

```python

import noisereduce as nr

# 降低背景噪声

reduced_noise = nr.reduce_noise(y=y_normalized, sr=sr)

```

在实际开发中,可以采用多种数据增强方法来创建更多的训练数据集,如使用`torchaudio`、`nltk`、`pydub`等库来实现。

### 3.1.2 特征提取方法

特征提取是将原始声音信号转换为声纹识别模型能够处理的数值型表示的过程。最常用的声纹特征包括梅尔频率倒谱系数(MFCCs)、线性预测编码(LPC)、以及音高周期(Pitch Period)等。

以MFCC为例,这一特征反映了人耳对声音频率的感知特性,通常用于语音识别。在Python中,可以使用`librosa`库提取MFCC特征:

```python

mfcc = librosa.feature.mfcc(y=reduced_noise, sr=sr)

```

对于深度学习模型而言,MFCC特征经常被当作输入层的输入。表格1详细说明了不同特征类型及其用途:

表1:声纹识别中使用的特征及其用途

| 特征类型 | 描述 | 用途 |

|--------------|--------------------------------------------------------------|--------------------------------------------------------------|

| MFCCs | 反映人耳对声音频率的

0

0