语音识别的深度学习算法革命:从RNN到Transformer

发布时间: 2024-09-03 23:03:04 阅读量: 91 订阅数: 55

语音识别wangdeliang.asr_ppt.zip

# 1. 语音识别技术概述

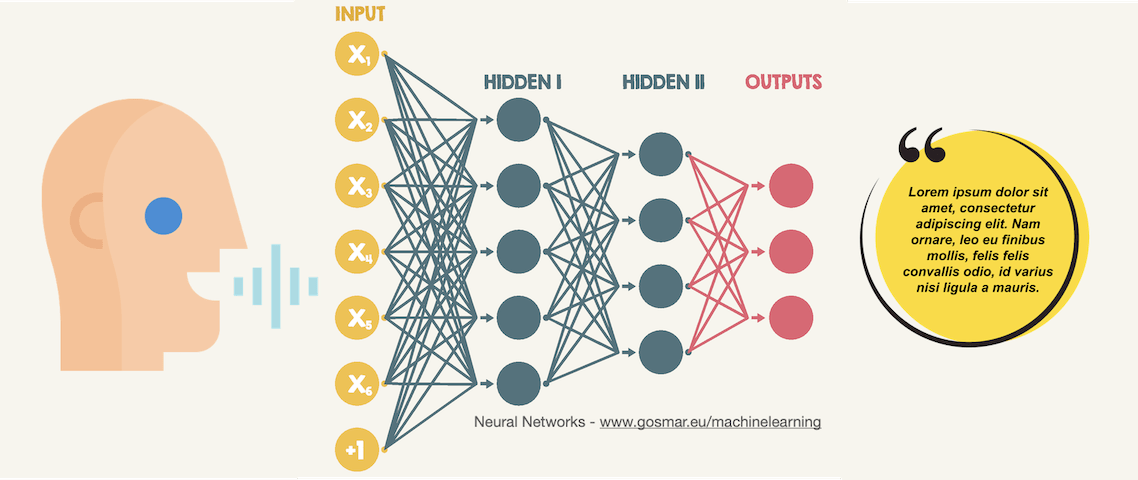

语音识别技术作为人工智能领域的一项核心技术,近年来得到了广泛的关注和飞速的发展。它使得机器能够通过人的语音进行交互,为人们提供了更为自然和便捷的操作方式。从最初的简单命令识别到现在复杂的连续语音识别,语音识别技术已经深入到日常生活的方方面面,如智能手机、智能家居、语音助手等。

本章首先简要介绍语音识别技术的基本概念,包括其历史发展、主要应用以及所面临的挑战。我们将会探讨语音信号处理的基础知识,以及它如何被转换成可理解的机器语言。通过这些基础知识的铺垫,读者能够对语音识别技术有一个全面的认识,为后续深入了解其在深度学习中的应用奠定坚实的基础。

# 2. 循环神经网络(RNN)在语音识别中的应用

## 2.1 RNN的基本概念与架构

### 2.1.1 RNN的工作原理

循环神经网络(RNN)是深度学习中处理序列数据的网络架构。与传统神经网络不同,RNN具有记忆能力,能够使用其内部状态(即隐藏层状态)对序列信息进行建模。这种内部状态使得RNN能够捕捉到序列数据中的时间动态特性。RNN的核心在于其隐藏层的反馈连接,允许信息从一个时间步流向下一个时间步,形成一个“循环”。

工作流程通常如下:

1. 初始隐藏状态被设置为零或基于先前输入的某些计算。

2. 每个时间步接受输入数据和前一个时间步的隐藏状态。

3. 计算当前时间步的隐藏状态。

4. 最后,使用当前隐藏状态产生输出,可能是序列中的下一个元素预测或最终分类。

```python

import tensorflow as tf

# 假设我们有一个简单的RNN模型,使用TensorFlow框架构建

# 构建RNN层的代码示例

rnn_layer = tf.keras.layers.SimpleRNN(units=128)

# 假设输入序列的形状为[batch_size, time_steps, features]

input_sequence = tf.random.normal([1, 10, 5])

# 将输入序列通过RNN层

output_sequence = rnn_layer(input_sequence)

```

### 2.1.2 RNN的主要类型及其特点

RNN家族中包含了多种变体,主要类型包括:

- SimpleRNN

- LSTM(长短期记忆网络)

- GRU(门控循环单元)

每种类型的RNN针对序列建模的长期依赖问题有不同的处理策略:

- SimpleRNN由于其简单性容易实现,但在处理长序列时容易出现梯度消失或梯度爆炸的问题,这限制了它捕捉长期依赖的能力。

- LSTM在设计上引入了记忆单元和三个门(输入门、遗忘门和输出门)来解决梯度问题,使得模型可以捕捉长距离的依赖关系。

- GRU是LSTM的一个变种,其结构更加简化,仅包含两个门(重置门和更新门),在某些情况下,其性能与LSTM相当,但计算开销更小。

```python

# LSTM层的代码示例

lstm_layer = tf.keras.layers.LSTM(units=128)

# GRU层的代码示例

gru_layer = tf.keras.layers.GRU(units=128)

# LSTM和GRU层的使用方式与SimpleRNN类似

```

## 2.2 RNN在语音识别中的优势与局限

### 2.2.1 RNN处理序列数据的优势

在语音识别任务中,语音信号表现为时间序列数据。RNN的优势在于它能够通过隐藏状态维护序列中的时间依赖性,这对于理解语音信号至关重要。RNN能够利用其记忆单元对时间序列中的短语、单词甚至是句子结构进行建模,捕捉到语音中的时序特征。例如,在语音信号的预处理中,RNN可以有效地识别出语音段落中的重要特征,这对于后续的识别过程是非常有利的。

### 2.2.2 RNN在语音识别中的挑战

尽管RNN在序列处理方面拥有天然优势,但它们也面临着一些挑战:

- 长期依赖问题:虽然LSTM和GRU可以缓解梯度消失或爆炸的问题,但它们仍然难以捕捉非常长距离的依赖关系。

- 计算复杂度:RNN由于其内部循环结构,处理序列数据时的计算复杂度相对较高,尤其是当序列长度增加时。

- 并行化困难:由于RNN的序列依赖性,其训练和推理过程很难并行化,这限制了其在大规模数据集上的应用。

## 2.3 RNN的实践案例分析

### 2.3.1 传统语音识别系统中的RNN应用

在传统的语音识别系统中,RNN被广泛地用于从音频信号中提取语音特征。具体来说,RNN首先接收经过预处理的语音信号,比如梅尔频率倒谱系数(MFCCs),然后通过其隐藏层动态建模时间序列数据,输出每个时间步的概率分布,最终通过解码算法将这些概率分布转化为文字输出。

### 2.3.2 RNN优化策略及其效果评估

为了克服RNN在语音识别任务中的挑战,研究者提出了一些优化策略:

- 使用BiLSTM(双向长短期记忆网络)来同时考虑过去和未来的上下文信息,增强模型对当前时间步的理解。

- 利用序列到序列(Seq2Seq)模型,将RNN结合注意力机制,以更好地捕捉长距离依赖关系。

- 采用知识蒸馏技术,将复杂的大模型的知识转移到轻量级的模型中,提高模型的推理速度,而不牺牲太多的性能。

```python

# 双向LSTM的代码示例

bilstm_layer = tf.keras.layers.Bidirectional(

layer=tf.keras.layers.LSTM(units=128, return_sequences=True)

)

```

### 实验结果与评估

针对优化策略的效果评估通常依赖于标准的语音识别基准测试集,比如TIMIT或LibriSpeech。通过对比优化前后的错误率(WER)、词错误率(CER)等指标,我们可以量化地评估优化策略的有效性。此外,模型的运行时间、模型大小、内存占用等也是重要的考量因素。

通过这些指标的综合评估,可以发现,虽然BiLSTM与Seq2Seq模型通常能达到更低的错误率,但它们需要更高的计算资源。而知识蒸馏技术能够在维持可接受性能的同时显著提升模型的运行效率。

# 3. 注意力机制与Transformer模型

## 3.1 注意力机制的原理与演变

### 3.1.1 注意力机制的基本概念

注意力机制是一种模仿人类视觉注意力的机制,它允许模型在处理信息时有所侧重,从而更

0

0