【时间序列分析在文本挖掘中的应用】:预测与分析文本趋势

发布时间: 2024-09-07 20:41:45 阅读量: 55 订阅数: 40

亚马逊产品评价与预测:文本挖掘和时间序列模型应用

# 1. 时间序列分析基础与文本挖掘概述

## 时间序列分析基础

时间序列分析是研究数据随时间变化规律的一门科学,它在经济预测、金融分析、气象观测等众多领域有着广泛的应用。时间序列数据的特性,如趋势、季节性和循环性,是分析中的关键要素,它们影响着数据模型的选择和预测的准确性。

## 文本挖掘概述

文本挖掘是从大量非结构化文本数据中提取有价值信息的过程。其核心在于从自然语言文本中识别模式、关系和趋势。文本挖掘在信息检索、知识发现、舆情分析等领域发挥着重要作用。此领域涉及的技术包括文本预处理、特征提取、分类、聚类等。

## 时间序列与文本挖掘的结合

将时间序列分析应用于文本挖掘,可以揭示文本内容随时间的变化趋势。通过时间序列建模,我们可以对文本数据进行时间维度的深度分析,如情绪分析的时间序列变化、主题趋势的预测等。这种结合为文本分析带来了新的视角和方法。

# 2. 时间序列分析理论框架

## 2.1 时间序列数据的特征和模型

### 2.1.1 平稳性与非平稳性

时间序列数据通常展示出随时间变化的特性。分析这些数据时,了解其平稳性至关重要。平稳时间序列是指其统计特性(如均值、方差)不随时间变化,而非平稳时间序列则表现出随时间变化的均值或方差。平稳性是许多时间序列模型的前提条件,例如ARIMA模型。如果数据是非平稳的,通常需要通过差分、变换等方法将其转化为平稳序列。

```python

# Python 示例代码:检查序列的平稳性

import pandas as pd

from statsmodels.tsa.stattools import adfuller

# 假设我们有一个时间序列数据集df,其中包含时间戳和相应的值

data = pd.read_csv('timeseries_data.csv')

ts = data['value']

result = adfuller(ts)

print('ADF Statistic: %f' % result[0])

print('p-value: %f' % result[1])

```

在上述代码中,我们使用ADF检验(Augmented Dickey-Fuller test)来评估时间序列的平稳性。ADF检验统计值和对应的p值会告诉我们序列是否平稳。如果p值小于显著性水平(通常是0.05),则拒绝单位根假设,认为序列是平稳的。

### 2.1.2 常用的时间序列模型简介

在时间序列分析中,有几个重要的模型被广泛使用:

- AR(AutoRegressive) 模型,即自回归模型,它假设当前值是过去的值的线性组合。

- MA(Moving Average) 模型,即移动平均模型,它考虑了历史数据中的波动性。

- ARMA(AR and MA combination) 模型,即自回归移动平均模型,它结合了AR和MA模型。

- ARIMA(AR Integrated MA) 模型,即差分自回归移动平均模型,它适用于非平稳时间序列数据的分析。

```python

# Python 示例代码:拟合ARIMA模型

from statsmodels.tsa.arima.model import ARIMA

# 使用ARIMA模型对平稳时间序列进行拟合

model = ARIMA(ts, order=(1, 1, 1))

results = model.fit()

print(results.summary())

```

在上面的代码段中,我们使用`statsmodels`库中的`ARIMA`类来拟合时间序列数据。通过指定ARIMA模型的参数(p,d,q),我们能够构建出适合数据的模型,并通过打印模型摘要来查看模型的结果和诊断信息。

## 2.2 时间序列的分解方法

### 2.2.1 趋势和周期性分析

时间序列的趋势分析旨在识别序列中的长期上升或下降模式。这可以通过各种方法实现,比如移动平均法和指数平滑法。周期性分析则关注数据中的重复模式,通常是通过将时间序列拆分为不同周期的组成部分来实现。

```python

# Python 示例代码:时间序列趋势和周期性分解

from statsmodels.tsa.seasonal import seasonal_decompose

result = seasonal_decompose(ts, model='additive')

result.plot()

```

使用`statsmodels`库的`seasonal_decompose`函数,我们可以将时间序列分解为趋势、季节性和残差三个部分。上述代码展示了如何对时间序列进行分解,并绘制出其趋势和周期性变化的图表。

### 2.2.2 季节性分解

季节性是时间序列分析中的一个重要概念,指的是数据随季节变化而出现的规律性波动。时间序列的季节性分解可以通过移动平均法和X-11法等多种方法完成。识别季节性有助于我们理解数据的基本结构并进行更准确的预测。

```python

# Python 示例代码:时间序列的季节性分解

result = seasonal_decompose(ts, model='additive', period=12)

result.seasonal.plot()

```

上述代码中,我们对时间序列进行了季节性分解,并将季节性成分绘制成图表,从而可以直观地观察到季节性波动的模式。

## 2.3 预测方法和评估

### 2.3.1 预测方法对比

在时间序列预测中,常用的预测方法包括:

- 自回归模型(AR)

- 移动平均模型(MA)

- 自回归移动平均模型(ARMA)

- 差分自回归移动平均模型(ARIMA)

每种方法在特定情况下都有其优势,通常会根据数据的特性(如是否平稳、季节性等)选择合适的模型。

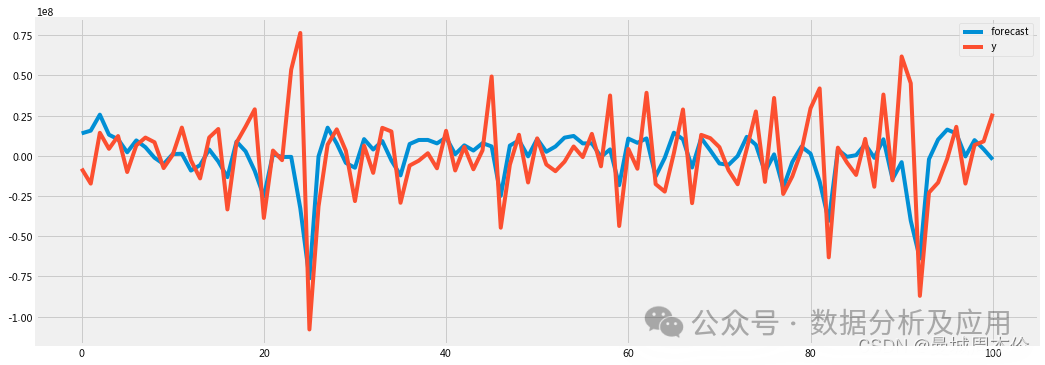

### 2.3.2 预测准确性的评估指标

对于时间序列预测模型,评估指标对于衡量模型的预测效果至关重要。常见的评估指标包括均方误差(MSE)、均方根误差(RMSE)和平均绝对误差(MAE)等。这些指标帮助我们量化模型的预测准确性和偏差。

```python

# Python 示例代码:计算预测的评估指标

from sklearn.metrics import mean_squared_error, mean_absolute_error

# 假设y_true是真实的值,y_pred是预测的值

y_true = ts

y_pred = results.predict(start=..., end=...) # 用训练好的模型进行预测

mse = mean_squared_error(y_true, y_pred)

rmse = mean_squared_error(y_true, y_pred, squared=False)

mae = mean_absolute_error(y_true, y_pred)

print('MSE: %f' % mse)

print('RMSE: %f' % rmse)

print('MAE: %f' % mae)

```

在上述代码中,我们使用`sklearn`库来计算模型预测的MSE、RMSE和MAE。这些指标可以帮助我们量化预测结果与真实数据之间的差距,从而评估模型的性能。

通过对时间序列分析理论框架的介绍,我们可以看到,深入理解数据的特征是进行有效预测的前提。而模型的选择和评估方法的合理应用,则是确保预测准确性的重要保证。这些基本理论和方法将为我们在时间序列分析中提供坚实的理论基础,也为后续实践应用打下基础。

# 3. 文本挖掘技术与工具

在本章中,我们将深入探讨文本挖掘的核心技术和工具,这些技术与工具为从原始文本数据中提取有价值的信息提供了可能。本章将从文本预处理和特征提取开始,讨论如何从复杂的文本中清理和分词,进而转换为机器学习算法可以处理的特征。接着,我们将介绍几种常用的文本挖掘算法,重点介绍主题模型和情感分析,这些算法在理解文本主题和情感倾向方面具有重要作用。最后,本章将对目前流行的文本挖掘工具和框架进行分析,比较它们的优劣,并给出使用建议。

## 3.1 文本预处理和特征提取

### 3.1.1 文本清洗与分词

在开始文本挖掘之前,文本数据必须经过清洗,去除无关字符、标点、停用词等,保留有意义的文本内容。清洗之后,文本将被分解为更小的单元,通常称为“词”或“词元”。这一过程称为分词。分词是文本挖掘中的关键步骤,尤其是对中文等没有明显分隔符的语言。

以Python为例,我们可以使用`jieba`库对中文文本进行分词处理。以下是一个简单的示例代码,展示如何进行中文分词:

```python

import jieba

# 原始文本数据

text = "我爱北京天安门,天安门上太阳升。"

# 使用jieba进行中文分词

words = jieba.cut(text)

# 输出分词结果

print(list(words))

```

执行上述代码后,我们将得到一个分词后的列表。这个列表可以被用来进一步进行文本分析或特征提取。`jieba`作为一个成熟的中文分词工具,支持多种模式的分词,并且拥有足够的灵活性来适应不同的文本挖掘需求。

### 3.1.2 特征选择和表示

文本数据的特征选择和表示是将文本数据转换为数值向量的过程,这些向量可以被机器学习模型所理解和处理。常见的表示方法有词袋模型、TF-IDF(词频-逆文档频率)以及Word2Vec等。

以TF-IDF方法为例,其核心思想是降低常见词汇的重要性,同时提升稀有词汇的权重,这有助于捕捉到文本中的关键信息。以下是一个基于Python的scikit-learn库来实现TF-IDF的示例代码:

```python

from sklearn.feature_extraction.text import TfidfVectorizer

import jieba

# 假设我们有以下文本数据

texts = [

"我爱北京天安门",

"天安门上太阳升",

"太阳升起照耀着我"

]

# 初始化TF-IDF向量化器

tfidf_vectorizer = TfidfVectorizer(tokenizer=jieba.cut)

# 应用TF-IDF转换

tfidf_matrix = tfidf_vectorizer.fit_transform(texts)

# 输出TF-IDF矩阵

print(tfidf_matrix.toarray())

```

在上述代码中,我们首先导入`TfidfVectorizer`类,然后创建一个TF-IDF向量化器实例,并通过`fit_transform`方法对文本数据进行转换。转换后的TF-IDF矩阵能够反映出不同文本中词汇的重要性和特征分布。

## 3.2 文本挖掘常用算法

### 3.2.1 主题模型

主题模型是一种统计模型,用于发现文本集中的主题分布,每篇

0

0