【词频分析的秘密】:发现文本数据背后的模式与趋势

发布时间: 2024-09-07 20:28:25 阅读量: 129 订阅数: 47

# 1. 词频分析的核心概念与应用场景

词频分析是一种文本挖掘技术,用于计算和分析文本数据中词汇的出现频率,从而揭示文本内容的结构和主题。它是自然语言处理和数据分析领域中的一个基础而又重要的工具。词频分析的核心目的在于通过统计词的出现次数来发现文本中的关键词汇,从而能够更好地理解文本信息和语境。

词频分析的应用场景极其广泛,从简单的搜索引擎排名优化到复杂的情感分析和文本主题分类,都可以看到它的身影。例如,它可以用于搜索引擎中的关键词索引优化,提高检索的准确性和效率;在市场调研中,通过分析客户评论来挖掘消费者对产品的反馈和态度;在舆情监控中,快速定位热点话题,预测趋势;甚至在文学研究中,对文学作品中的语言使用模式进行深入研究。

在实际应用中,词频分析不但要依靠强大的算法和高效的数据处理能力,还需要结合语义理解等更高级的自然语言处理技术,才能实现对文本深层次的解读和应用。了解和掌握词频分析的核心概念及其应用场景,对于IT行业及数据分析领域的从业者来说,是一个必备的技能。

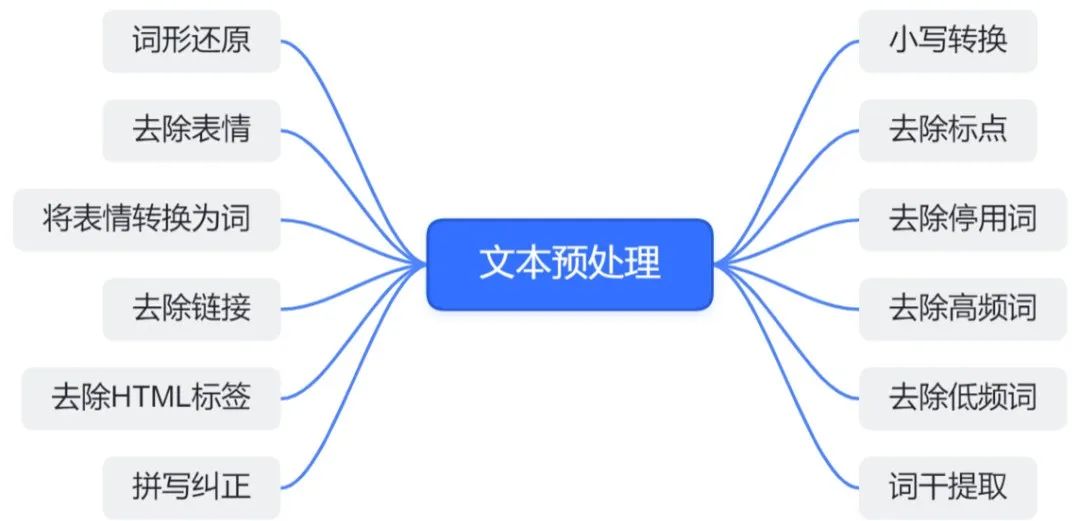

# 2. 文本预处理与数据清洗

在着手进行词频分析之前,获取干净、格式统一的文本数据是至关重要的。文本数据通常包含着丰富的信息,但同时也充斥着各种噪声和无关信息。本章将详细探讨如何有效地进行文本预处理与数据清洗,为后续的分析工作奠定坚实基础。

### 2.1 文本数据的采集与导入

#### 2.1.1 从不同来源获取文本数据

从不同的数据源获取文本数据是预处理的第一步。数据源可能包括社交媒体平台、新闻网站、公开的文档库、API接口,以及个人收集的资料。例如,Python的`requests`库可以用来从网络API中获取数据,`BeautifulSoup`和`lxml`库则能解析HTML或XML文档,提取所需文本内容。

```python

import requests

from bs4 import BeautifulSoup

# 使用requests库获取网页内容

url = "***"

response = requests.get(url)

response.encoding = response.apparent_encoding

# 使用BeautifulSoup解析网页内容

soup = BeautifulSoup(response.text, 'html.parser')

articles = soup.find_all('article') # 假设文章包裹在<article>标签内

# 提取文本

texts = [article.get_text() for article in articles]

```

参数说明:

- `response.apparent_encoding`:自动检测网页的编码方式,确保文本正确解码。

- `soup.find_all('article')`:查找所有包含文章的HTML标签,这一步可能需要根据实际页面结构调整。

#### 2.1.2 文本数据的格式化与标准化

获取文本数据后,通常需要对其进行格式化和标准化处理,以便于后续分析。格式化包括去除HTML标签、转换为统一的文本格式等;标准化则包括转换为小写、去除标点符号和数字、以及统一日期和时间格式等。

```python

import re

# 去除HTML标签

cleaned_texts = [re.sub(r'<[^>]+>', '', text) for text in texts]

# 转换为小写

lowercase_texts = [text.lower() for text in cleaned_texts]

# 去除标点和数字

punctuation_pattern = r"[^\w\s]"

clean_texts = [re.sub(punctuation_pattern, '', text) for text in lowercase_texts]

# 转换日期时间格式

# 示例代码略,具体转换依赖于原始数据的日期时间格式

```

参数说明:

- `re.sub`函数用于替换字符串中的特定模式。例如`re.sub(r'<[^>]+>', '', text)`用于移除所有HTML标签。

- 正则表达式`[^>]+`匹配任何不是`>`的字符,直到遇到`>`。

### 2.2 文本清洗的技巧和方法

#### 2.2.1 去除噪声与无关信息

文本数据中往往包含大量与分析目标无关的噪声。这些噪声可能来自无意义的停用词、特定的广告信息、错误的编码字符等。去除这些噪声能有效提升分析的准确度。

```python

# 停用词列表示例

stopwords = set(["the", "and", "is", "in", "of", "to", "a", ...])

# 去除停用词

filtered_texts = [[word for word in text.split() if word not in stopwords] for text in clean_texts]

```

参数说明:

- `stopwords`集合中包含了常见的停用词,这些词在自然语言处理中通常被认为不具备实际意义。

#### 2.2.2 文本分词与词性标注

在许多自然语言处理任务中,将文本拆分成单词(分词)是基础步骤。此外,词性标注(POS tagging)能为每个单词添加词性信息(如名词、动词),有助于提高文本分析的精确度。

```python

import nltk

nltk.download('punkt')

nltk.download('averaged_perceptron_tagger')

# 使用NLTK进行分词和词性标注

tokens_and_tags = [nltk.word_tokenize(text) for text in clean_texts]

pos_tagged = [nltk.pos_tag(tokens) for tokens in tokens_and_tags]

```

参数说明:

- `nltk.word_tokenize`:用于分词。

- `nltk.pos_tag`:用于词性标注。

### 2.3 高级文本清洗技术

#### 2.3.1 去除停用词和特定模式匹配

除了常见的停用词外,还可能需要根据特定项目的需求去除一些特定模式的词或短语,如URL、电话号码等。

```python

# 匹配URL模式并去除

url_pattern = ***pile(r'http\S+|www.\S+')

# 匹配电话号码模式并去除(示例)

phone_pattern = ***pile(r'\b\d{3}[-.\s]?\d{3}[-.\s]?\d{4}\b')

cleaned_texts = [

url_pattern.sub('', text)

for text in [phone_pattern.sub('', text) for text in filtered_texts]

]

```

参数说明:

- `***pile`用于编译正则表达式模式。

- `url_pattern`正则表达式用于匹配常见的URL模式。

#### 2.3.2 词干提取和词形还原

为了减少词汇的多样性,并使相同含义的词归并为同一形式,词干提取(stemming)和词形还原(lemmatization)是文本预处理中经常使用的技术。前者通过去除后缀得到词根,后者则返回词汇的基本形式。

```python

nltk.download('wordnet')

nltk.download('omw-1.4')

from nltk.stem import WordNetLemmatizer

lemmatizer = WordNetLemmatizer()

lemmatized_texts = [

[lemmatizer.lemmatize(word) for word in tokens]

for tokens in pos_tagged

]

```

参数说明:

- `WordNetLemmatizer`:一个基于WordNet的词形还原工具。

- `lemmatize`方法需要输入词的词性信息,这通常是POS标注得到的结果。

在这一章节中,我们逐步深入讨论了文本预处理和数据清洗的各个层面。通过从不同来源采集文本数据,并进行格式化与标准化处理,我们为文本分析准备了高质量的输入数据。接着,我们学习了基本的文本清洗技巧,如去除噪声与无关信息,以及进行文本分词和词性标注。在高级文本清洗技术部分,我们深入了解了去除特定模式、词干提取和词形还原的具体方法。这些步骤和技巧为接下来的词频统计与分析打下了坚实的基础。

# 3. 词频统计与分析方法

词频统计是自然语言处理和文本分析的核心组成部分,它涉及到从文本数据中提取单词并计算其出现频率的过程。准确且高效地执行这一过程是理解文本内容、挖掘主题和模式的前提。在本章节中,我们将深入探讨词频统计的各种技术、数据结构的应用以及如何通过可视化手段有效地展现分析结果。

## 3.1 统计词频的基本技术

### 3.1.1 使用哈希表进行词频统计

哈希表是一种广泛应用于词频统计的数据结构,它通过一个键值对存储数据,其中键通常是单词本身,而值则是该单词出现的次数。哈希表的平均时间复杂度为O(1),因此可以快速地查找、插入和删除数据。

以下是使用Python语言和内置的字典类型(基于哈希表实现)来进行词频统计的示例代码:

```python

def count_word_frequency(text):

words = text.split() # 将文本按空格分割成单词列表

frequency = {} # 初始化空字典用于存储单词及其频率

for word in words:

word = word.lower().strip('.,!?:;()[]') # 转换为小写并去除标点符号

if word in frequency:

frequency[word] += 1 # 如果单词已存在,则增加其计数

else:

frequency[word] = 1 # 如果单词不存在,则初始化计数为1

return fre

```

0

0