【文本摘要技术】:精炼信息的艺术与科学

发布时间: 2024-09-07 20:58:25 阅读量: 70 订阅数: 37

# 1. 文本摘要技术概述

文本摘要技术是自然语言处理(NLP)领域的一项核心任务,旨在通过分析文本内容,自动生成简短、凝练的摘要。这种技术在现代信息技术中扮演着重要角色,广泛应用于新闻、学术论文和社交媒体等多种场景中。随着机器学习和深度学习的进步,文本摘要技术已经从简单的关键词提取发展到了能够理解文本深层语义的复杂模型,提高了摘要的准确性和可读性。文本摘要不仅能够提升信息的获取效率,还能辅助人类进行知识管理和决策。在本章中,我们将概述文本摘要技术的基本概念、发展历程以及在实际应用中的重要性。

# 2. 文本摘要的基本理论

## 2.1 文本摘要的定义和重要性

### 2.1.1 摘要的定义

文本摘要是一种从原始文本中提取关键信息并以精炼的形式呈现的过程。它旨在为读者提供原始文本的核心内容,而不必阅读整个文档。在信息过载的时代,文本摘要扮演了关键角色,它通过节省时间、提高信息检索效率以及提供内容概览等功能,帮助读者快速把握文档的主要信息。

### 2.1.2 摘要的目的和作用

文本摘要是信息处理和自然语言处理中的一个重要分支,它使得大量文档的管理成为可能。有效的摘要不仅能够压缩信息,还能保留原始文档的语义内容和语境信息。在新闻报道、学术研究、报告制作等多个领域,文本摘要技术提供了实质性的帮助。它可以帮助用户快速了解文档的主要论点,辅助决策过程,甚至用于生成摘要式新闻、报告和学术文章的概要部分。

## 2.2 文本摘要的类型和方法

### 2.2.1 抽象式摘要

抽象式摘要是一种复杂的文本摘要形式,它不是简单地从原文中挑选出几个句子,而是理解原文的内容和含义,然后生成一个全新的句子来表达原文的核心内容。这种方式类似于人类专家在理解了文章内容后撰写摘要。抽象式摘要的优点在于它可以生成连贯且信息密集的文本,但其缺点在于开发和训练摘要系统需要大量的数据和复杂的算法。

### 2.2.2 摘要式摘要

摘要式摘要则是从原文中直接提取关键句子或短语,通过连接这些内容生成摘要。这种方法通常被称作抽取式摘要。相比于抽象式摘要,抽取式摘要在实现上更简单,因为它不需要理解原文的含义就能完成工作,但生成的摘要可能缺乏连贯性,并且在面对长篇内容时可能会丢失关键信息。

### 2.2.3 混合式摘要

混合式摘要结合了抽象式和抽取式摘要的方法,既考虑了从原文中抽取关键信息,同时也尝试构建连贯的摘要文本。它通常利用机器学习模型来分析文档结构,抽取重要的句子,并且通过一定的算法来重新组合这些句子,生成既包含关键信息又具有较高连贯性的摘要。混合式方法的挑战在于如何平衡抽取和构建摘要内容的质量。

## 2.3 文本摘要的质量评估

### 2.3.1 客观评估方法

客观评估方法通常基于某种标准,如ROUGE (Recall-Oriented Understudy for Gisting Evaluation) 评分,来衡量摘要的性能。ROUGE是一种广泛使用的评估指标,它比较自动摘要与一组人工摘要之间的重叠度,常用的是ROUGE-N,其中N代表n-gram的长度。尽管客观评估提供了一种可以量化的评估方式,但它们也有局限性,比如无法全面反映摘要的可读性、准确性和连贯性。

### 2.3.2 主观评估方法

主观评估方法依赖于人工评估者来评价摘要的质量。这通常涉及对摘要的可读性、相关性、信息覆盖度和语言流畅性的综合评价。虽然主观评估方法较为耗时且成本高昂,但它能够更全面地衡量摘要的质量,特别是在评估连贯性和一致性等更抽象的文本属性方面。

```mermaid

graph TD

A[文本摘要方法]

A --> B[抽象式摘要]

A --> C[摘要式摘要]

A --> D[混合式摘要]

B --> E[理解原文并生成]

C --> F[直接提取关键句]

D --> G[抽取+构建连贯文本]

```

在表格1中,我们对不同文本摘要方法进行了一个简要的对比,以便于读者更直观地理解各种方法的异同。

| 方法分类 | 操作方式 | 连贯性 | 信息密度 | 实现复杂度 | 应用场景 |

|----------|----------|---------|------------|-------------|----------|

| 抽象式摘要 | 生成新句子 | 高 | 高 | 高 | 需要高质量和连贯性的摘要 |

| 摘要式摘要 | 提取关键句 | 低 | 低 | 低 | 信息覆盖需求优先的场景 |

| 混合式摘要 | 结合前两者 | 中等 | 中等 | 中等 | 综合应用场景 |

在本文中,我们将继续深入探讨文本摘要技术的算法与模型,探索其背后的科学原理及其在实际应用中的表现。

# 3. 文本摘要技术的算法与模型

文本摘要技术是信息抽取与理解领域的核心问题之一,是自然语言处理(NLP)的重要分支。为了实现从大量的文本信息中提取关键信息,诞生了多种不同的算法与模型。本章将深入探讨文本摘要技术所涉及的关键算法与模型,从经典算法概述,到机器学习方法,最后深入至当前最先进的深度学习模型。

## 3.1 经典算法概述

### 3.1.1 基于频率的算法

基于频率的算法是一种简单的文本摘要生成方法,通过统计文本中词、短语或句子的频率,来确定文本的重要性和相关性。这种方法的代表性算法有TF-IDF(Term Frequency-Inverse Document Frequency,词频-逆文档频率)。

```python

import numpy as np

from sklearn.feature_extraction.text import TfidfVectorizer

# 示例文档

documents = [

'The sky is blue.',

'The sun is bright.',

'The sun in the sky is bright.',

'We can see the shining sun, the bright sun.'

]

# 初始化TF-IDF向量化器

tfidf_vectorizer = TfidfVectorizer()

# 计算TF-IDF值

tfidf_matrix = tfidf_vectorizer.fit_transform(documents)

feature_names = tfidf_vectorizer.get_feature_names_out()

# 输出每个词在每个文档中的TF-IDF值

print(tfidf_matrix.toarray())

print(feature_names)

```

代码逻辑分析:上述代码使用了`sklearn`库中的`TfidfVectorizer`类来计算示例文档集中每个词的TF-IDF值。首先,初始化`TfidfVectorizer`对象,然后使用`fit_transform`方法来转换文档数据集,最后输出每个文档中每个词的TF-IDF值。TF-IDF值越高,表示该词对于文档的重要性越大。

参数说明:`fit_transform`方法通过拟合和转换输入的文档数据来训练`TfidfVectorizer`并返回TF-IDF矩阵。`get_feature_names_out()`方法返回转换后矩阵中的特征名,即词汇表。

基于频率的算法由于其实现简单、效率高,常被用于初步的文本摘要任务。但是,它也有局限性,比如对于一些虽然出现频率不高,但是对于理解全文非常重要的关键词,可能会被忽略。

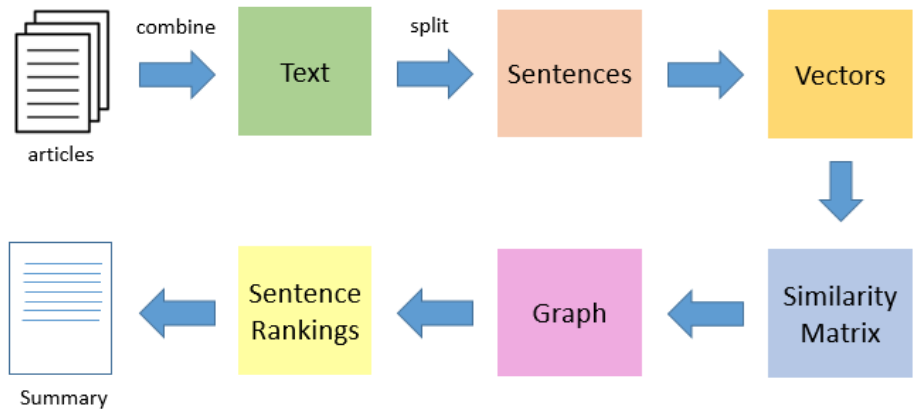

### 3.1.2 基于图论的算法

基于图论的算法将文本抽象为图结构,其中节点代表词或句子,边代表节点间的某种关系。通过分析图的属性,如节点的中心性(centrality),来决定哪些部分更具有代表性,从而提取关键信息。

```mermaid

graph TD;

A[文档] --> B[构建词共现图];

B --> C[计算节点中心性];

C --> D[生成文本摘要];

```

mermaid流程图说明:流程图展示了基于图论的算法如何工作。首先从文档构建一个词共现图,然后计算图中每个节点的中心性,最后根据中心性来生成文本摘要。节点中心性高表示该词或句子在文档中的中心地位更为重要。

基于图论的算法能够提供比频率算法更深层次的信息抽取,但构建和处理图的过程相对复杂,且计算成本较高。

## 3.2 机器学习方法

### 3.2.1 有监督学习方法

有监督学习方法通常依赖于大量标注好的训练数据,通过对文本特征和对应的摘要进行学习,建立起模型来预测新文本的摘要。有监督学习方法的挑战在于数据标注成本高,且很难覆盖所有类型的文本。

```python

from sklearn.naive_bayes import MultinomialNB

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.pipeline import make_pipeline

# 假设我们有一组已经标注好的文档和摘要

documents = [...] # 训练文档集

summaries = [...] # 训练摘要集

# 将文档和摘要文本转换为特征向量

vectorizer = CountVectorizer()

clf = MultinomialNB()

# 创建处理文档并训练分类器的管道

model = make_pipeline(vectorizer, clf)

# 训练模型

model.fit(documents, summaries)

# 使用训练好的模型对新文档生成摘要

new_documents = [...]

predicted_summaries = model.predict(new_documents)

```

代码逻辑分析:此代码段演示了如何使用`sklearn`的`CountVectorizer`和`MultinomialNB`来建立一个简单的有监督学习模型。`CountVectorizer`将文档转换为词频特征向量,`MultinomialNB`是一个朴素贝叶斯分类

0

0