深度学习中学习率的优化策略与实践

需积分: 1 176 浏览量

更新于2024-09-10

收藏 1.29MB PDF 举报

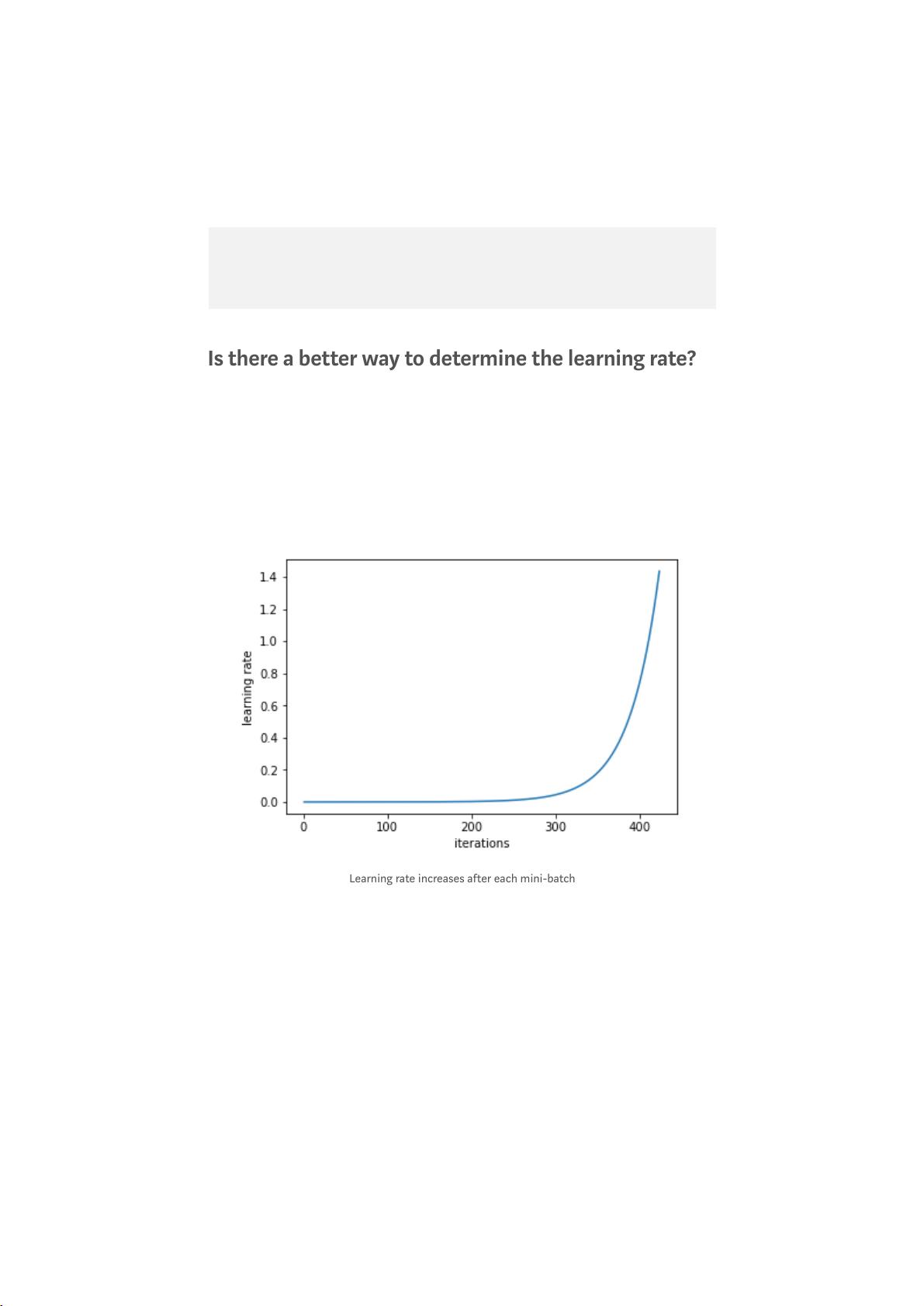

在深度学习中,学习率是一个至关重要的超参数,它控制着我们根据损失梯度调整网络权重的程度。理解学习率的本质、其重要性以及如何有效地选择和调整学习率,对于提高模型性能至关重要。本文将深入探讨以下几个关键点:

1. **学习率定义**:

学习率决定了每次迭代中优化器更新权重的步长。较低的学习率意味着每次更新的幅度较小,有助于避免过早地陷入局部最优解,但可能会导致训练速度变慢。较高的学习率则可能导致模型在收敛过程中跳过局部最小值,快速达到全局最优,但也可能增加不稳定性。

2. **学习率的重要性**:

学习率的选择直接影响模型训练的效果和效率。合适的学习率可以帮助模型快速找到最优解,而过小或过大的学习率则可能导致训练停滞或者不稳定。因此,理解如何调整学习率是优化模型性能的关键。

3. **确定好的学习率**:

- **经验法则**:通常采用如0.1、0.01、0.001等常见的初始学习率,然后通过学习曲线观察模型的收敛情况,逐步调整。

- **学习率调度**:可以采用学习率衰减策略,如固定衰减(每一定步数减小),指数衰减,余弦退火等,使学习率在训练过程中逐渐降低。

- **动态调整**:使用自适应学习率算法,如Adagrad、RMSprop、Adam等,这些方法会自动调整每个参数的学习率,适应训练过程中的不同部分。

4. **训练过程中的学习率变化**:

- **防止过拟合**:随着训练的进行,学习率的减小可以帮助模型更好地在泛化和复杂度之间找到平衡,减少过拟合的风险。

- **适应不同阶段**:在训练初期使用较大的学习率以便快速收敛,随着模型结构的优化,逐渐降低学习率以精细化调整。

5. **使用预训练模型时的学习率处理**:

当使用预训练模型时,由于模型已经具备了一定的初始化权重,可能需要一个较低的学习率来微调这些权重,以防止破坏预训练的结构。此外,也可以使用不同的学习率策略针对预训练层和新添加的层进行区分调整。

了解学习率的概念及其对模型性能的影响是深度学习实践中的基础。通过合理选择和调整学习率,以及在不同阶段和模型上下文中应用适当的策略,可以显著提升深度学习模型的训练效果和效率。务必密切关注学习率与模型收敛速度、稳定性和最终性能的关系,这是实现高效深度学习的关键。阅读参考资料[1][2][5][3]以获取更详细的信息和实践经验。

164 浏览量

1348 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

leez888

- 粉丝: 0

最新资源

- 昆仑通态MCGS嵌入版_XMTJ温度巡检仪软件包解压教程

- MultiBaC:掌握单次与多次组批处理校正技术

- 俄罗斯方块C/C++源代码及开发环境文件分享

- 打造Android跳动频谱显示应用

- VC++实现图片处理的小波变换方法

- 商城产品图片放大镜效果的实现与用户体验提升

- 全新发布:jQuery EasyUI 1.5.5中文API及开发工具包

- MATLAB卡尔曼滤波运动目标检测源代码及数据集

- DoxiePHP:一个PHP开发者的辅助工具

- 200mW 6MHz小功率调幅发射机设计与仿真

- SSD7课程练习10答案解析

- 机器人原理的MATLAB仿真实现

- Chromium 80.0.3958.0版本发布,Chrome工程版新功能体验

- Python实现的贵金属追踪工具Goldbug介绍

- Silverlight开源文件上传工具应用与介绍

- 简化瀑布流组件实现与应用示例