【HAR文件使用秘籍】:揭开正确解读和利用HAR数据的面纱

发布时间: 2024-10-27 19:33:53 阅读量: 17 订阅数: 12

# 1. HAR文件简介与基本结构

## 1.1 HAR文件概述

HAR文件(HTTP Archive)是一种用于记录浏览器会话历史的标准格式。它记录了网页加载过程中涉及的所有HTTP请求和响应的详细信息,包括请求时间、大小、响应代码等,广泛应用于网站性能分析和故障排查。

## 1.2 HAR文件的基本结构

HAR文件由JSON格式构成,通常包含以下主要部分:

- **log**: 包含HAR文件的元数据,如浏览器信息、页面加载时间等。

- **entries**: 列表形式,每个对象代表一个HTTP请求/响应对。

- **creator**: 创建HAR文件的软件信息。

- **browser**: 浏览器信息。

HAR文件中,`entries` 部分是核心,其中每一个对象记录了单个HTTP交互的详细信息,如时间戳、请求和响应头部、内容大小、压缩信息等。

理解HAR文件的结构和内容是进行进一步数据分析和应用的基础。在接下来的章节中,我们将深入探讨HAR文件在不同场景下的应用和分析方法。

# 2. HAR文件的数据分析

HAR文件是一个记录网页浏览器和服务器之间交互的JSON格式文件,包含了丰富的网络性能数据。在深入挖掘HAR文件的潜能之前,我们首先需要理解其中记录的数据结构和细节。

## 2.1 HAR文件中的HTTP请求细节分析

### 2.1.1 请求方法与URL结构

HAR文件中的每一个HTTP请求都有详细的方法和URL记录,这对于分析网络请求的类型和资源的加载方式至关重要。

#### *.*.*.* 分析方法

- 分析请求方法(如GET或POST),它们决定了浏览器与服务器交互的行为。

- 检查URL的构成,包括协议、域名、路径、查询参数等,以了解资源的位置和访问方式。

#### *.*.*.* 代码块分析

```json

{

"method": "GET",

"url": "***"

}

```

在此JSON对象中,`method`字段标识了HTTP请求的类型,`url`字段则标识了请求的完整路径。

### 2.1.2 请求头和响应头的解析

了解请求头和响应头是深入理解浏览器和服务器之间通信的关键。

#### *.*.*.* 代码块分析

```json

{

"request": {

"headers": [

{"name": "Host", "value": "***"},

{"name": "Accept", "value": "*/*"}

]

},

"response": {

"headers": [

{"name": "Content-Type", "value": "text/html"},

{"name": "Date", "value": "Thu, 01 Jan 1970 00:00:01 GMT"}

]

}

}

```

请求头和响应头都是键值对的集合,用于交换有关请求、响应和客户端、服务器的元数据。

### 2.1.3 HTTP状态码的意义和解读

HTTP状态码为每个响应定义了一个状态,帮助开发者理解请求是否成功,或者是否发生了错误。

#### *.*.*.* 表格展示

| 状态码 | 类别 | 含义 |

| --- | --- | --- |

| 200 | 成功 | 请求已成功处理 |

| 404 | 客户端错误 | 请求的资源未找到 |

| 500 | 服务器错误 | 服务器内部错误,无法完成请求 |

### 2.2 HAR文件中的性能指标解析

性能指标是评估网络请求效率和页面加载时间的关键数据。

#### 2.2.1 时间戳和加载时间计算

时间戳记录了请求开始和结束的时间,是计算加载时间的基础。

#### *.*.*.* 代码块分析

```json

{

"time": 200, // 加载时间,单位毫秒

"startedDateTime": "2023-03-16T14:16:26.787+08:00"

}

```

在此JSON对象中,`time`字段记录了请求从开始到结束的耗时,`startedDateTime`字段记录了请求发起的具体时间。

#### 2.2.2 带宽和内容大小的评估

带宽和内容大小数据帮助我们了解资源传输效率和压缩情况。

#### *.*.*.* 代码块分析

```json

{

"content": {

"size": 1234, // 内容大小,单位字节

"compression": 1000 // 压缩后大小,单位字节

},

"connection": "keep-alive"

}

```

`content`字段下的`size`记录了资源的大小,`compression`记录了压缩后大小,`connection`字段表明了连接的类型。

#### 2.2.3 请求和响应时间序列分析

请求和响应时间序列分析帮助我们理解不同请求对页面加载时间的贡献。

#### *.*.*.* mermaid格式流程图展示

```mermaid

sequenceDiagram

participant B as 浏览器

participant S as 服务器

B->>S: 请求资源

Note right of S: 服务器处理时间

S-->>B: 响应资源

Note left of B: 浏览器渲染时间

```

此流程图展示了浏览器和服务器之间的交互过程,强调了请求和响应的时间点。

### 2.3 HAR数据的可视化展示

通过可视化,复杂的数据变得更加容易理解和沟通。

#### 2.3.1 常见的可视化工具介绍

数据可视化工具如HAR Analyzer、HAR Viewer等,都可以将HAR文件中的数据转换成图表。

#### 2.3.2 制作交互式性能图表

交互式图表能够让用户通过点击和滚动等操作深入了解数据细节。

#### 2.3.3 实例:从HAR数据到可视化报告

在此实例中,我们将HAR数据导入可视化工具,通过一系列步骤,生成交互式性能报告。

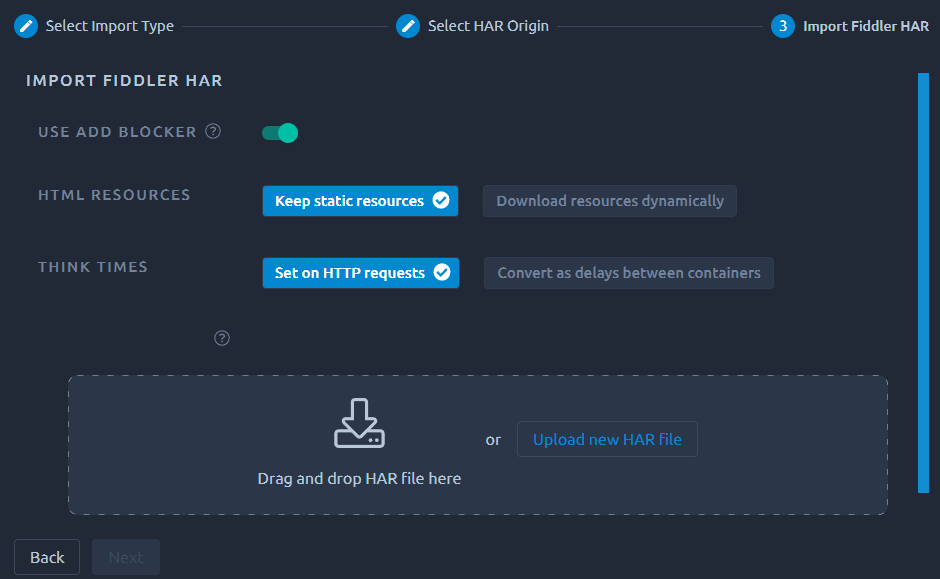

#### *.*.*.* 操作步骤

1. 选择一个HAR可视化工具。

2. 导入HAR文件。

3. 调整图表设置,选择需要展示的数据维度。

4. 查看并分析报告,确定性能瓶颈。

5. 根据报告生成优化建议。

通过以上步骤,我们可以将HAR数据转化为有价值的性能报告,辅助我们进行性能优化和故障排查。

# 3. HAR数据的实践应用案例

### 3.1 网站性能分析与优化

在Web开发和运维中,网站性能分析是确保用户获得快速、可靠体验的关键环节。HAR文件作为一种记录浏览器与服务器间HTTP交互的详细日志格式,为性能分析提供了丰富的数据源。

#### 3.1.1 加载性能分析与瓶颈定位

加载性能分析需要关注页面加载的整体时间和各个组件加载的时间。通过HAR文件,我们可以得到页面中每一个请求的详细记录,包括该请求的发起时间、接收时间、内容大小等信息。这为我们提供了在时间线上的数据点,帮助我们识别加载过程中的瓶颈。

```json

{

"log": {

"version": "1.2",

"creator": {

"name": "浏览器X",

"version": "版本号"

},

"browser": {

"name": "浏览器X",

"version": "版本号"

},

"pages": [

{

"startedDateTime": "2023-01-01T00:00:00.000+08:00",

"id": "page_1",

"title": "首页",

"pageTimings": {

"onContentLoad": 1234,

"onLoad": 5678

}

}

],

"entries": [

{

"pageref": "page_1",

"startedDateTime": "2023-01-01T00:00:00.100+08:00",

"time": 250,

"request": {

"method": "GET",

"url": "***"

},

"response": {

"status": 200,

"statusText": "OK",

"content": {

"size": 3825,

"compression": 0

}

},

"cache": {},

"timings": {

"blocked": 0.1,

"dns": 0,

"connect": 5,

"send": 0,

"wait": 100,

"receive": 145

}

}

]

}

}

```

在上面的HAR数据示例中,`entries`数组中的每一个对象代表一个网络请求,其中包括了加载时间 (`time`)、请求方法 (`method`)、URL (`url`)、状态码 (`status`),以及时间相关的细分 (`timings`)。通过分析这些数据,我们可以识别出加载最慢的资源,例如上面的 `styles.css` 文件在接收阶段耗时145毫秒,可能需要优化。

#### 3.1.2 优化建议的提取和实施

针对识别出的瓶颈,我们可以提取出优化建议。比如对于大型图片和脚本,可以考虑压缩和延迟加载;对于第三方资源,可以尝试预加载或者寻找性能更好的替代服务;对于服务器响应时间长的问题,可以进行服务器性能优化或数据库查询优化。

#### 3.1.3 优化效果的跟踪和验证

通过实施优化措施后,需要跟踪优化效果以确保改进达到预期目标。可以再次生成HAR文件,对比优化前后的加载时间和各个资源的性能指标,确认瓶颈是否已经消除。

### 3.2 故障排查与调试

#### 3.2.1 常见HTTP问题的识别

在网站运营过程中,难免会遇到各种HTTP相关的问题,例如500内部服务器错误、404页面不存在错误、301/302重定向问题等。通过HAR文件的详细记录,我们可以快速定位到问题发生的具体时间点以及请求的上下文,这对于快速解决问题非常有帮助。

#### 3.2.2 使用HAR数据进行故障定位

HAR文件记录了每个HTTP请求和响应的详细信息,包括状态码、时间和内容大小等。这些数据可以帮助我们重现问题并找出问题的根本原因。例如,通过对比正常和异常情况下的HAR文件,我们可以发现响应时间变长或状态码错误等关键信息,进而精确定位问题。

#### 3.2.3 调试流程的自动化和优化

随着运维自动化和DevOps文化的发展,将HAR分析整合到持续集成/持续部署(CI/CD)流程中,实现故障排查和性能优化的自动化是一个非常有价值的实践。例如,使用脚本自动分析HAR文件,当发现性能指标低于预设阈值时,自动触发邮件通知或告警。

### 3.3 API测试与监控

#### 3.3.1 利用HAR文件进行API测试

API测试是确保服务质量和一致性的关键环节。HAR文件记录了API接口的请求和响应信息,我们可以利用这些信息对API进行测试,验证接口的功能、性能和稳定性是否符合预期。

#### 3.3.2 监控API响应时间与一致性

API的响应时间是影响用户体验的重要因素之一。通过定期生成HAR文件并监控API的响应时间,我们可以确保API性能的稳定性。同时,通过检查HAR中的请求和响应内容,我们可以验证API的数据一致性。

#### 3.3.3 实施持续集成中的API性能监控

在持续集成流程中,可以集成HAR文件分析来作为API性能监控的一部分。每次代码提交后,自动化脚本会运行API测试,并生成HAR文件。如果发现性能指标不符合预期,则立即通知相关开发人员或运维团队进行处理。

通过上述实践案例,我们可以看到HAR数据在真实场景中的应用价值,无论是性能优化、故障排查还是API测试与监控,HAR文件都提供了强大的数据支持。这也为HAR文件的未来应用提供了更广阔的前景。

# 4. 高级HAR数据处理技术

在当今IT环境中,处理和分析HAR文件数据的高级技术不仅能提高效率,还能帮助我们深入理解网络交互的性能。本章将探讨如何利用编程接口自动化分析HAR数据,运用机器学习进行模式识别和性能预测,以及在安全审计和合规性检查中利用HAR文件。

#### 4.1 编程接口与自动化分析

自动化处理HAR数据能够在大量数据中快速识别模式,生成报告,并且可以集成到持续集成和持续部署(CI/CD)流程中,以监控应用性能。

##### 4.1.1 HAR文件的解析器和编程库

为了有效地处理HAR文件,我们可以使用诸如Node.js的`har-to-json`或者Python的`pyHar`这样的库,这些库能够将HAR格式转换为JSON对象,便于进一步分析。

```javascript

const harParser = require('har-to-json');

const harFile = './example.har';

const harData = await harParser(harFile);

console.log(harData);

```

在上述示例代码中,我们使用了`har-to-json`库将`.har`文件解析成JavaScript对象。每个请求和响应都变成了可访问的属性,这为后续的数据处理和分析提供了基础。

##### 4.1.2 编程实现HAR数据的批量处理

自动化批量处理HAR文件的一个基本任务是提取关键性能指标(KPIs),并将其保存到数据库或者生成报告。这可以通过脚本自动化实现,例如使用Python脚本遍历HAR文件夹,解析每个文件,并将关键数据写入到CSV文件中。

```python

import json

import csv

import os

def extract_kpis_from_har(har_file):

# 伪代码逻辑,省略了具体的解析细节

pass

har_folder = '/path/to/har/files'

kpi_csv = 'kpi_data.csv'

with open(kpi_csv, 'w', newline='') as csv***

*** ['url', 'load_time', 'response_code']

writer = csv.DictWriter(csvfile, fieldnames=fieldnames)

writer.writeheader()

for filename in os.listdir(har_folder):

if filename.endswith('.har'):

file_path = os.path.join(har_folder, filename)

kpi_data = extract_kpis_from_har(file_path)

writer.writerow(kpi_data)

```

此段Python脚本通过遍历HAR文件夹来收集每个HAR文件中的加载时间和响应代码等数据,并将其保存为CSV格式。

##### 4.1.3 实例:自动化生成性能报告

通过上述编程技术,我们可以构建一个自动化脚本来生成性能报告。该脚本会处理存储在服务器上的多个HAR文件,并使用数据可视化库(如matplotlib或seaborn)生成图表,以直观展示性能趋势和瓶颈。

```python

import matplotlib.pyplot as plt

def plot_performance_trends(csv_data):

# 此处省略数据读取和处理细节

plt.plot(csv_data['load_time'])

plt.title('Performance Trend')

plt.xlabel('Time')

plt.ylabel('Load Time (s)')

plt.show()

csv_data = read_kpi_data('kpi_data.csv')

plot_performance_trends(csv_data)

```

上述代码段使用Python的matplotlib库根据CSV文件中的性能数据绘制了一个趋势图,让开发者和运维人员能够快速识别性能问题。

#### 4.2 机器学习在HAR分析中的应用

机器学习技术可以用于从大量HAR数据中提取模式,并识别性能问题。通过这些技术,我们可以构建预测模型,预测未来的性能问题,并提前采取措施。

##### 4.2.1 特征提取与模式识别

首先,我们需要从HAR文件中提取特征,这可能包括请求的大小、响应时间、以及各种性能指标。这些特征可以用于训练机器学习模型,以识别可能导致性能问题的模式。

```python

from sklearn.feature_extraction import FeatureExtractor

def extract_features_from_har(har_data):

# 提取HAR文件中的特征

features = {

'average_response_time': average(har_data['response_times']),

'total_requests': len(har_data['requests']),

# 其他特征...

}

return features

har_data = extract_kpis_from_har('example.har')

features = extract_features_from_har(har_data)

```

在上述代码片段中,我们定义了一个函数`extract_features_from_har`来从HAR数据中提取特征,这些特征可以用于后续的机器学习分析。

##### 4.2.2 预测模型的构建与评估

一旦有了特征数据,我们就可以使用诸如scikit-learn这样的机器学习库来构建预测模型。可以使用监督学习方法,如决策树或随机森林来预测性能问题。

```python

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import classification_report

X = [features for _, features in feature_data]

y = [label for label in labels]

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

model = RandomForestClassifier()

model.fit(X_train, y_train)

predictions = model.predict(X_test)

print(classification_report(y_test, predictions))

```

此代码展示了如何将特征与标签分离,进行模型训练,以及对测试数据进行预测并评估模型的性能。

##### 4.2.3 案例研究:基于机器学习的性能优化

在真实世界的案例中,机器学习模型能够帮助我们识别出导致延迟增加的因素,甚至在问题实际发生之前预测出它们。这种预测能力对于保持应用的高性能至关重要。

```python

# 假设我们已经建立了一个模型,并且在实时数据流上进行测试

realtime_har_data = collect_har_data_stream()

features_stream = extract_features_from_har(realtime_har_data)

performance_prediction = model.predict([features_stream])[0]

if performance_prediction == 'issue_detected':

alert_performance_team()

```

这里演示了一个虚构的案例,其中模型被部署为在实时数据流中工作,并在检测到性能问题时发出警报。

#### 4.3 安全审计与合规性检查

HAR文件不仅包含了性能相关的数据,还可能包含敏感信息。因此,它们可以用于执行安全审计和确保网站遵守相关的合规性标准。

##### 4.3.1 利用HAR数据进行安全审计

HAR文件可以帮助我们分析网站是否遭受了恶意攻击,比如重复的请求或异常的请求头。通过编写自动化脚本,我们可以检测这些模式。

```python

import re

def audit_har_for_security(har_data):

# 检查异常请求模式

threats = []

for entry in har_data['log']['entries']:

request_url = entry['request']['url']

if re.search('malicious_pattern', request_url):

threats.append(request_url)

return threats

har_data = collect_har_data('example.har')

threats_detected = audit_har_for_security(har_data)

```

在上述代码中,我们定义了一个函数`audit_har_for_security`来检查HAR数据中可能的威胁模式。

##### 4.3.2 合规性指标的HAR分析

在某些行业,比如金融和医疗保健,合规性检查是必不可少的。HAR文件中包含的详细时间戳和请求信息可以帮助审计人员验证服务提供商是否遵守了特定的服务水平协议(SLA)。

```python

from datetime import datetime

def check_compliance(har_data, sla_threshold):

# 检查服务时间是否超过合规性阈值

compliance_status = {

'requests_within_sla': [],

'requests超出_sla': []

}

for entry in har_data['log']['entries']:

if datetime.fromisoformat(entry['startedDateTime']) < sla_threshold:

compliance_status['requests_within_sla'].append(entry)

else:

compliance_status['requests超出_sla'].append(entry)

return compliance_status

har_data = collect_har_data('example.har')

current_time = datetime.now()

compliance_status = check_compliance(har_data, current_time - sla_threshold)

```

在上面的代码中,我们检查了每个请求是否在服务协议允许的时间范围内。

##### 4.3.3 隐私保护与数据脱敏的最佳实践

在处理包含敏感信息的HAR文件时,脱敏处理是必要的步骤。通过编写脚本,我们可以自动移除或替换掉个人信息,以确保数据的安全。

```python

def anonymize_har_data(har_data):

# 脱敏处理HAR数据中的敏感信息

anonymized_entries = []

for entry in har_data['log']['entries']:

entry['request']['url'] = anonymize_url(entry['request']['url'])

anonymized_entries.append(entry)

return anonymized_entries

def anonymize_url(url):

# 伪代码:脱敏URL中的敏感信息

pass

har_data = collect_har_data('example.har')

anonymized_har_data = anonymize_har_data(har_data)

```

上述代码展示了如何对HAR数据中的URL进行脱敏处理,以确保敏感信息不被泄露。

# 5. HAR文件工具与资源

HAR文件不仅在数据分析上有其独特优势,在工具与资源方面也同样有着丰富的生态系统。本章我们将深入探讨HAR分析工具、培训资源及社区贡献,并对未来发展趋势做以展望。

## 5.1 开源HAR分析工具比较

在处理HAR文件时,有一系列的开源工具可供选择,它们各自具有不同的特点和适用场景。

### 5.1.1 功能概览与适用场景

- **HAR Analyzer**: 一款简单易用的Web界面工具,适合快速查看HAR文件的内容,但可能不支持复杂的数据分析任务。

- **Wireshark**: 虽然主要用于网络协议分析,但也能打开HAR文件,适用于网络专家深入研究每个网络请求和响应的细节。

- **Requestly**: 一个浏览器扩展,允许用户在本地编辑HAR文件,非常适合进行模拟故障和修改请求的场景。

### 5.1.2 用户体验与社区支持

选择合适的工具时,用户体验和社区支持也是重要的考量因素。比如:

- **HAR Viewer**: 由谷歌开发者支持,界面直观,更新频繁,社区活跃。

- **Fiddler**: 除了强大的HAR文件查看能力,它还提供了强大的社区论坛和插件系统。

### 5.1.3 高级功能和插件系统

一些工具提供了高级功能和插件系统,以扩展其核心功能:

- **Postman**: 原本是一个API开发工具,但支持导入HAR文件进行API测试,还提供了丰富的插件来增强其功能。

- **HAR Exporter**: 作为浏览器扩展存在,可以将浏览器网络请求直接转换成HAR文件,并提供一些基本分析功能。

## 5.2 培训资源与社区贡献

HAR文件的使用和分析并非一蹴而就,通过丰富的培训资源和社区贡献,可以使更多人受益。

### 5.2.1 在线教程与学习路径

- **MDN Web Docs**: 为HAR文件提供了基本概念和结构的教程,适合初学者。

- **Udemy**: 有专门的课程教授如何使用HAR文件进行网络性能分析。

### 5.2.2 参与HAR分析工具的开发与维护

贡献开源项目是IT专业人士提升自身技能和扩大影响力的好方法。例如:

- **参与HAR Analyzer**: 通过GitHub提交代码改进,或者参与其文档的撰写。

- **Fiddler开源版贡献**: 通过修复bug或增加新功能来提升工具体验。

### 5.2.3 分享案例和实践经验

分享是学习的重要组成部分,通过分享自己的经验,不仅可以帮助他人,也有助于巩固自己的知识:

- **博客文章**: 在个人博客或技术社区上撰写关于HAR文件分析的文章和案例。

- **会议演讲**: 在行业会议上分享如何有效使用HAR文件进行性能优化和故障排查。

## 5.3 未来发展趋势与展望

HAR文件作为一种数据交换格式,其未来的发展趋势和标准化工作备受业界关注。

### 5.3.1 HAR格式的演变与标准化

随着Web技术的发展,HAR格式也在不断地进化和标准化。

- **标准化工作**: 通过W3C等组织来推动HAR格式的国际化和标准化,确保不同厂商和工具之间的兼容性。

- **格式扩展**: 预计HAR格式会增加更多关于性能、安全以及隐私的数据字段。

### 5.3.2 Hacks和工具的创新方向

创新是技术发展的驱动力。

- **人工智能结合**: 利用AI技术实现更智能的性能优化建议和故障排查。

- **自动化测试**: 随着CI/CD流程的普及,HAR文件在自动化测试中的作用会日益增强。

### 5.3.3 预测:HAR数据在未来分析中的作用

在未来,HAR数据将在Web开发和网络分析中扮演越来越重要的角色。

- **性能分析**: 成为性能分析的主要数据来源,为用户提供直观、详细的性能报告。

- **用户行为分析**: 结合前端监控,HAR文件中丰富的用户交互数据可以用于优化用户体验和界面设计。

通过本章节内容的介绍,我们可以看到HAR文件工具与资源的丰富多样,并对未来的发展有了一个大致的预测与展望。无论是个人学习、团队协作还是技术发展,HAR文件都是一个不可或缺的重要组件。

0

0