ResNet中的残差连接是如何起到作用的

发布时间: 2024-05-02 20:37:31 阅读量: 93 订阅数: 54

# 1. ResNet网络概述

ResNet(残差网络)是一种深度卷积神经网络,由何凯明等人于2015年提出。它在图像分类任务中取得了突破性的进展,并迅速成为计算机视觉领域的主流模型之一。ResNet的核心思想是使用残差连接来解决深度网络中的梯度消失问题,从而使网络能够更深、更准确。

# 2. 残差连接的理论基础

### 2.1 梯度消失问题与恒等映射

在深度神经网络中,随着网络层数的增加,梯度消失问题会变得越来越严重。这是因为在反向传播过程中,梯度会随着层数的增加而指数级衰减。这使得网络难以学习深层特征,从而限制了网络的性能。

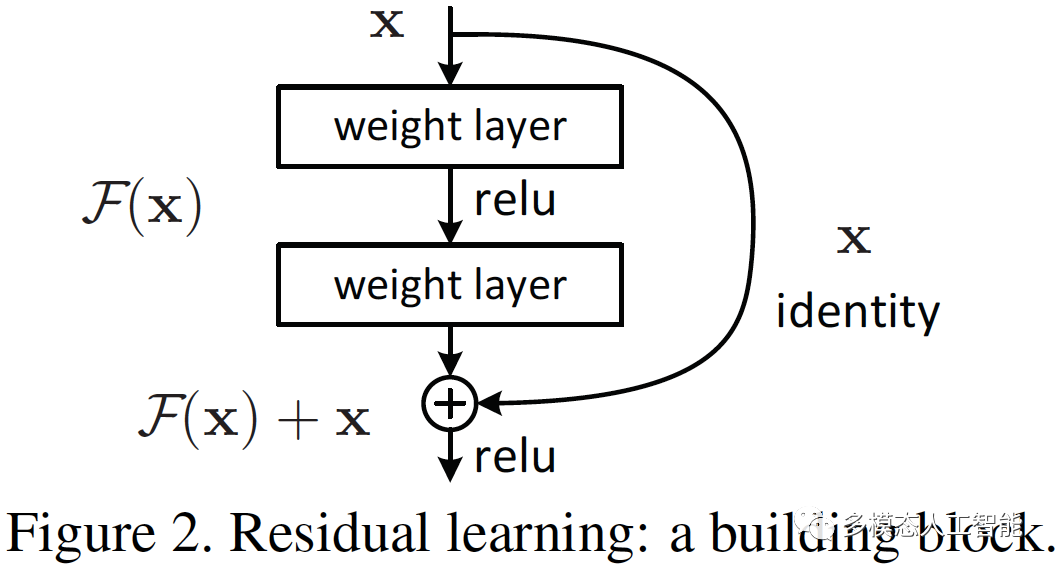

为了解决梯度消失问题,何恺明等人提出了残差连接的概念。残差连接是一种恒等映射,它将输入直接传递到输出,绕过中间的卷积层。通过这种方式,梯度可以不受阻碍地从输出层传递到输入层,从而缓解了梯度消失问题。

### 2.2 残差连接的数学推导

残差连接的数学推导如下:

```python

def residual_block(x):

"""

残差块的实现。

参数:

x: 输入特征图。

返回:

输出特征图。

"""

identity = x

# 卷积层1

x = Conv2D(64, (3, 3), padding='same')(x)

x = BatchNormalization()(x)

x = Activation('relu')(x)

# 卷积层2

x = Conv2D(64, (3, 3), padding='same')(x)

x = BatchNormalization()(x)

# 残差连接

x = Add()([x, identity])

# 激活函数

x = Activation('relu')(x)

return x

```

在上面的代码中,`identity`变量存储了输入特征图。残差块由两个卷积层组成,每个卷积层后面都跟着一个批归一化层和一个激活函数。残差连接通过将输入特征图与卷积层的输出相加来实现。

残差连接的数学推导可以表示为:

```

y = x + F(x)

```

其中:

* `y`是输出特征图

* `x`是输入特征图

* `F(x)`是卷积层的输出

通过残差连接,网络可以学习残差,即输入和输出之间的差异。这使得网络能够专注于学习新的特征,而不是重新学习恒等映射。

**代码逻辑逐行解读:**

1. `identity = x`:将输入特征图 `x` 赋值给 `identity` 变量,以便在残差连接中使用。

2. `x = Conv2D(64, (3, 3), padding='same')(x)`:使用 3x3 卷积核和相同的填充对输入特征图进行卷积,输出 64 个通道的特征图。

3. `x = BatchNormalization()(x)`:对卷积输出进行批归一化,以减少内部协变量偏移。

4. `x = Activation('relu')(x)`:对批归一化输出应用 ReLU 激活函数,引入非线性。

5. `x = Conv2D(64, (3, 3), padding='same')(x)`:再次使用 3x3 卷积核和相同的填充进行卷积,输出 64 个通道的特征图。

6. `x = BatchNormalization()(x)`:再次对卷积输出进行批归一化。

7. `x = Add()([x, identity])`:将卷积输出与输入特征图相加,实现残差连接。

8. `x = Activation('relu')(x)`:对残差连接输出应用 ReLU 激活函数。

**参数说明:**

* `x`: 输入特征图,形状为 `(batch_size, height, width, channels)`。

* `filters`: 卷积核的输出通道数,即输出特征图的通道数。

* `kernel_size`: 卷积核的大小,是一个元组 `(height, width)`。

* `padding`: 卷积的填充方式,可以是 `"same"`(保持输入和输出形状相同)或 `"valid"`(不进行填充)。

# 3. ResNet模型的构建

### 3.1 ResNet模块的基本结构

ResNet模块是ResNet网络的基本组成单元,它由一个残差块(residual block)和一个恒等映射(identity mapping)组成。残差块负责学习输入和输出之间的残差,而恒等映射负责直接将输入传递到输出。

**残差块**

残差块的结构如下:

```

X -> Conv1 -> BN1 -> ReLU -> Conv2 -> BN2 -> ReLU -> X +

```

其中:

* X 是输入特征图

* Conv1 和 Conv2 是卷积层

* BN1 和 BN2 是批标准化层

* ReLU 是激活函数

* + 表示残差连接

残差块的目的是学习输入和输出之间的残差。通过将残差添加到输入中,可以获得更深的网络,而不会遇到梯度消失问题。

**恒等映射**

恒等映射是一个简单的跳过连接,它将输入直接传递到输出。它的作用是允许梯度在训练过程中直接从输出流回输入。

### 3.2 不同ResNet变体的比较

ResNet网络有多种变体,它们在残差块的结构和网络深度上有所不同。最常见的ResNet变体包括:

| 变体 | 残差块结构 | 网络深度 |

|---|---|---|

| ResNet-18 | 2层 | 18 |

| ResNet-34 | 3层 | 34 |

| ResNet-50 | 3层 | 50 |

| ResNet-101 | 3层 | 101 |

| ResNet-152 | 3层 | 152 |

网络深度越深,ResNet网络的性能越好。然而,深度越深的网络也越容易过拟合。因此,在选择ResNet变体时,需要权衡性能和过拟合风险。

# 4. 残差连接的实践应用

### 4.1 图像分类任务中的 ResNet

在图像分类任务中,ResNet 已成为最流行的架构之一。其出色的性能归功于残差连接的引入,它允许网络学习恒等映射,从而缓解了梯度消失问题。

**ImageNet 数据集上的表现:**

ResNet 在 ImageNet 数据集上取得了突破性的结果,该数据集包含超过 100 万张图像和 1000 个类别。ResNet-50 模型在 ImageNet 2015 分类挑战赛中获得了第一名,其 top-1 和 top-5 错误率分别为 23.6% 和 7.4%。

**代码示例:**

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

class ResNetBlock(nn.Module):

def __init__(self, in_channels, out_channels, stride=1):

super(ResNetBlock, self).__init__()

self.conv1 = nn.Conv2d(in_channels, out_channels, kernel_size=3, stride=stride, padding=1)

self.bn1 = nn.BatchNorm2d(out_channels)

self.conv2 = nn.Conv2d(out_channels, out_channels, kernel_size=3, stride=1, padding=1)

self.bn2 = nn.BatchNorm2d(out_channels)

if stride != 1 or in_channels != out_channels:

self.shortcut = nn.Sequential(

nn.Conv2d(in_channels, out_channels, kernel_size=1, stride=stride),

nn.BatchNorm2d(out_channels)

)

else:

self.shortcut = nn.Identity()

def forward(self, x):

out = F.relu(self.bn1(self.conv1(x)))

out = self.bn2(self.conv2(out))

out += self.shortcut(x)

out = F.relu(out)

return out

class ResNet(nn.Module):

def __init__(self, num_blocks, in_channels=3, num_classes=1000):

super(ResNet, self).__init__()

self.conv1 = nn.Conv2d(in_channels, 64, kernel_size=7, stride=2, padding=3)

self.bn1 = nn.BatchNorm2d(64)

self.maxpool = nn.MaxPool2d(kernel_size=3, stride=2, padding=1)

self.layer1 = self._make_layer(64, 128, num_blocks[0])

self.layer2 = self._make_layer(128, 256, num_blocks[1], stride=2)

self.layer3 = self._make_layer(256, 512, num_blocks[2], stride=2)

self.layer4 = self._make_layer(512, 1024, num_blocks[3], stride=2)

self.avgpool = nn.AdaptiveAvgPool2d((1, 1))

self.fc = nn.Linear(1024, num_classes)

def _make_layer(self, in_channels, out_channels, num_blocks, stride=1):

layers = []

layers.append(ResNetBlock(in_channels, out_channels, stride))

for _ in range(1, num_blocks):

layers.append(ResNetBlock(out_channels, out_channels))

return nn.Sequential(*layers)

def forward(self, x):

out = F.relu(self.bn1(self.conv1(x)))

out = self.maxpool(out)

out = self.layer1(out)

out = self.layer2(out)

out = self.layer3(out)

out = self.layer4(out)

out = self.avgpool(out)

out = out.view(out.size(0), -1)

out = self.fc(out)

return out

```

**逻辑分析:**

* `ResNetBlock` 类定义了 ResNet 中的基本构建块,它包含两个卷积层、两个批归一化层和一个可选的捷径连接。

* `ResNet` 类定义了 ResNet 模型,它包含一个初始卷积层、一个最大池化层和四个残差块组。

* `_make_layer` 方法用于构建残差块组,它重复使用 `ResNetBlock` 类来创建指定数量的残差块。

* `forward` 方法定义了模型的前向传播,它将输入图像通过一系列卷积层、批归一化层和残差块组,最后输出一个分类分数。

### 4.2 目标检测任务中的 ResNet

在目标检测任务中,ResNet 也被广泛用作特征提取器。其强大的特征表示能力使其能够有效地定位和分类图像中的对象。

**Faster R-CNN 中的应用:**

Faster R-CNN 是一个两阶段目标检测器,它使用 ResNet 作为其区域提议网络 (RPN) 和分类器网络。RPN 负责生成感兴趣的区域,而分类器网络负责对这些区域进行分类。

**代码示例:**

```python

import torch

import torchvision.models as models

class FasterRCNN(nn.Module):

def __init__(self, num_classes):

super(FasterRCNN, self).__init__()

self.resnet = models.resnet50(pretrained=True)

self.rpn = RPN(self.resnet.layer4)

self.roi_head = ROIHead(self.resnet.layer4, num_classes)

def forward(self, x):

features = self.resnet(x)

rpn_logits, rpn_deltas = self.rpn(features)

rois, roi_features = self.roi_head(features, rpn_logits, rpn_deltas)

class_logits, bbox_deltas = self.roi_head(roi_features)

return class_logits, bbox_deltas, rois

```

**逻辑分析:**

* `FasterRCNN` 类定义了 Faster R-CNN 模型,它包含一个 ResNet 骨干网络、一个 RPN 和一个 ROI 头。

* `RPN` 类定义了区域提议网络,它使用 ResNet 的最后一个卷积层来生成感兴趣的区域。

* `ROIHead` 类定义了 ROI 头,它使用 ResNet 的最后一个卷积层来提取感兴趣区域的特征,并对这些特征进行分类和回归。

* `forward` 方法定义了模型的前向传播,它将输入图像通过 ResNet 骨干网络、RPN 和 ROI 头,最后输出分类分数、边界框偏移量和感兴趣的区域。

### 4.3 语义分割任务中的 ResNet

在语义分割任务中,ResNet 也被用作编码器网络,其强大的特征提取能力使其能够有效地分割图像中的不同语义区域。

**U-Net 中的应用:**

U-Net 是一个流行的语义分割模型,它使用 ResNet 作为其编码器网络。编码器网络负责提取图像的特征,而解码器网络负责将这些特征上采样到原始图像的分辨率。

**代码示例:**

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

class UNet(nn.Module):

def __init__(self, num_classes):

super(UNet, self).__init__()

self.resnet = models.resnet50(pretrained=True)

self.encoder = nn.Sequential(*list(self.resnet.children())[:-2])

self.decoder = nn.Sequential(

nn.ConvTranspose2d(2048, 1024, kernel_size=3, stride=2, padding=1, output_padding=1),

nn.BatchNorm2d(1024),

nn.ReLU(),

nn.ConvTranspose2d(1024, 512, kernel_size=3, stride=2, padding=1, output_padding=1),

nn.BatchNorm2d(512),

nn.ReLU(),

nn.ConvTranspose2d(512, 256, kernel_size=3, stride=2, padding=1, output_padding=1),

nn.BatchNorm2d(256),

nn.ReLU(),

nn.ConvTranspose2d(256, num_classes, kernel_size=3, stride=2, padding=1, output_padding=1),

)

def forward(self, x):

features = self.encoder(x)

out =

# 5. ResNet的优化和改进

### 5.1 深度残差网络(ResNeXt)

ResNeXt是ResNet的一个变体,它通过增加网络的深度来提高模型的性能。与传统的ResNet不同,ResNeXt在每个残差块中使用多个分支,每个分支都执行不同的卷积操作。这些分支的输出然后连接在一起,形成残差块的输出。

ResNeXt的架构如下:

```mermaid

graph LR

subgraph ResNet

A[Conv2D] --> B[ReLU] --> C[Conv2D] --> D[ReLU] --> E[Conv2D] --> F[ReLU] --> G[Add]

end

subgraph ResNeXt

A[Conv2D] --> B[ReLU] --> C[Conv2D] --> D[ReLU] --> E[Conv2D] --> F[ReLU] --> G[Add]

A[Conv2D] --> H[ReLU] --> I[Conv2D] --> J[ReLU] --> K[Conv2D] --> L[ReLU] --> G[Add]

A[Conv2D] --> M[ReLU] --> N[Conv2D] --> O[ReLU] --> P[Conv2D] --> Q[ReLU] --> G[Add]

end

```

ResNeXt的优点包括:

* **更深的网络:**ResNeXt可以通过增加分支的数量来构建更深的网络,从而提高模型的容量。

* **更强的特征提取能力:**每个分支执行不同的卷积操作,可以提取更丰富的特征,从而提高模型的性能。

### 5.2 宽残差网络(Wide ResNet)

Wide ResNet是ResNet的另一个变体,它通过增加网络的宽度来提高模型的性能。与传统的ResNet不同,Wide ResNet在每个残差块中使用更多的卷积核。这增加了模型的容量,从而提高了模型的性能。

Wide ResNet的架构如下:

```mermaid

graph LR

subgraph ResNet

A[Conv2D] --> B[ReLU] --> C[Conv2D] --> D[ReLU] --> E[Conv2D] --> F[ReLU] --> G[Add]

end

subgraph Wide ResNet

A[Conv2D(32)] --> B[ReLU] --> C[Conv2D(64)] --> D[ReLU] --> E[Conv2D(128)] --> F[ReLU] --> G[Add]

end

```

Wide ResNet的优点包括:

* **更大的容量:**Wide ResNet通过增加卷积核的数量来增加网络的容量,从而提高模型的性能。

* **更强的特征表示能力:**更多的卷积核可以提取更丰富的特征,从而提高模型的性能。

### 5.3 金字塔残差网络(Pyramid ResNet)

金字塔残差网络(Pyramid ResNet)是ResNet的又一个变体,它通过使用不同大小的卷积核来提高模型的性能。与传统的ResNet不同,Pyramid ResNet在每个残差块中使用不同大小的卷积核。这允许模型提取不同尺度的特征,从而提高模型的性能。

Pyramid ResNet的架构如下:

```mermaid

graph LR

subgraph ResNet

A[Conv2D] --> B[ReLU] --> C[Conv2D] --> D[ReLU] --> E[Conv2D] --> F[ReLU] --> G[Add]

end

subgraph Pyramid ResNet

A[Conv2D(1x1)] --> B[ReLU] --> C[Conv2D(3x3)] --> D[ReLU] --> E[Conv2D(5x5)] --> F[ReLU] --> G[Add]

end

```

Pyramid ResNet的优点包括:

* **多尺度特征提取:**Pyramid ResNet使用不同大小的卷积核来提取不同尺度的特征,从而提高模型的性能。

* **更强的鲁棒性:**多尺度特征提取使模型对不同大小的对象更具鲁棒性。

0

0